Hive数据仓库工具安装

一.Hive介绍

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单SQL查询功能,SQL语句转换为MapReduce任务进行运行。 优点是可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。缺点是Hive不适合在大规模数据集上实现低延迟快速的查询。

二.安装Hive

环境:Docker(17.04.0-ce)、镜像Ubuntu(16.04.3)、JDK(1.8.0_144)、Hadoop(3.1.1)、Hive(3.1.0)

1.安装Hadoop

参考:Hadoop伪分布式模式安装

2.使用root安装MySQL

root@lab-bd:~# apt-get install -y mysql-server

root@lab-bd:~# /etc/init.d/mysql start

3.切换用户bigdata,解压Hive

root@lab-bd:~# su - bigdata

bigdata@lab-bd:~$ tar -xf apache-hive-3.1.-bin.tar.gz

4.Hive依赖Hadoop,编辑.bashrc文件,添加环境变量

export HADOOP_HOME=/home/bigdata/hadoop-3.1.

5.激活环境变量

bigdata@lab-bd:~$ source .bashrc

6.启动Hdfs服务

bigdata@lab-bd:~$ hadoop-3.1./sbin/start-dfs.sh

7.启动Yarn服务

bigdata@lab-bd:~$ hadoop-3.1./sbin/start-yarn.sh

8.创建Hive数据仓库存储目录(/tmp已存在则跳过创建)

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -mkdir -p /tmp

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -chmod g+w /tmp

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -mkdir -p /user/hive/warehouse

bigdata@lab-bd:~$ hadoop-3.1./bin/hdfs dfs -chmod g+w /user/hive/warehouse

9.新建conf/hive-site.xml文件,并增加如下配置项

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?useSSL=false&createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>password</value>

</property>

</configuration>

10.下载mysql-connector驱动包,并移动到lib目录下

bigdata@lab-bd:~$ mv mysql-connector-java-5.1..jar apache-hive-3.1.-bin/lib/

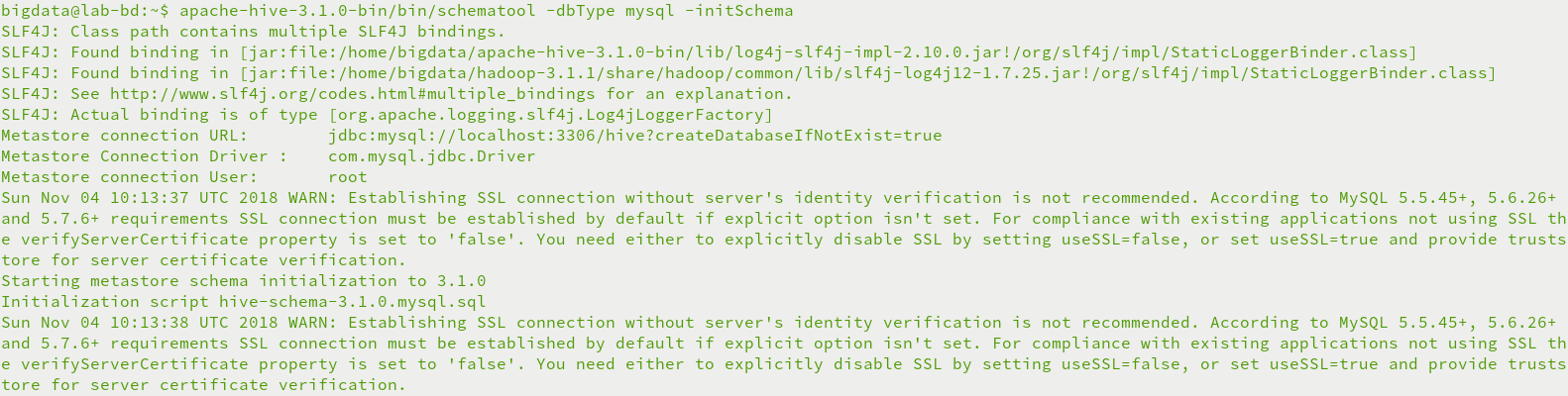

11.初始化metastore元数据库

bigdata@lab-bd:~$ apache-hive-3.1.-bin/bin/schematool -dbType mysql -initSchema

三.运行Hive

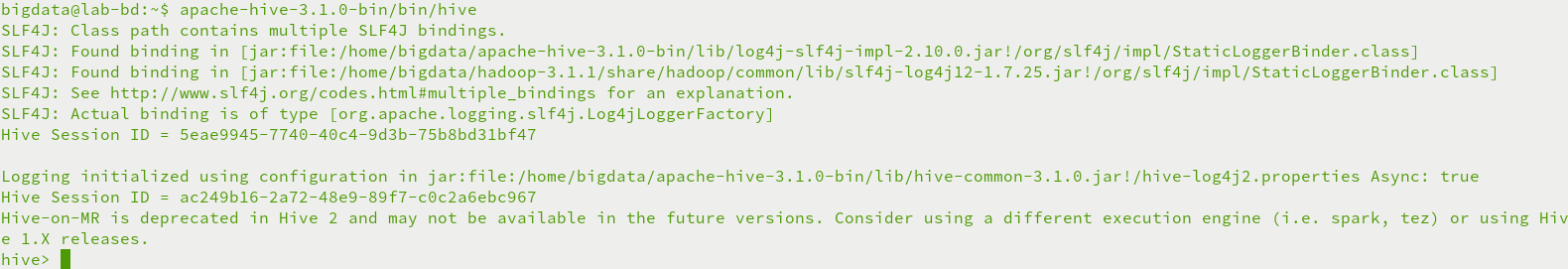

1.命令行运行Hive

bigdata@lab-bd:~$ apache-hive-3.1.-bin/bin/hive

2.Beeline运行Hive

修改etc/hadoop/core-site.xml文件,增加如下配置项

<property>

<name>hadoop.proxyuser.bigdata.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.bigdata.groups</name>

<value>*</value>

</property>

重启hadoop服务

bigdata@lab-bd:~$ hadoop-3.1./sbin/stop-dfs.sh

bigdata@lab-bd:~$ hadoop-3.1./sbin/start-dfs.sh

启动hiveserver2服务

bigdata@lab-bd:~$ nohup apache-hive-3.1.-bin/bin/hive --service hiveserver2 &

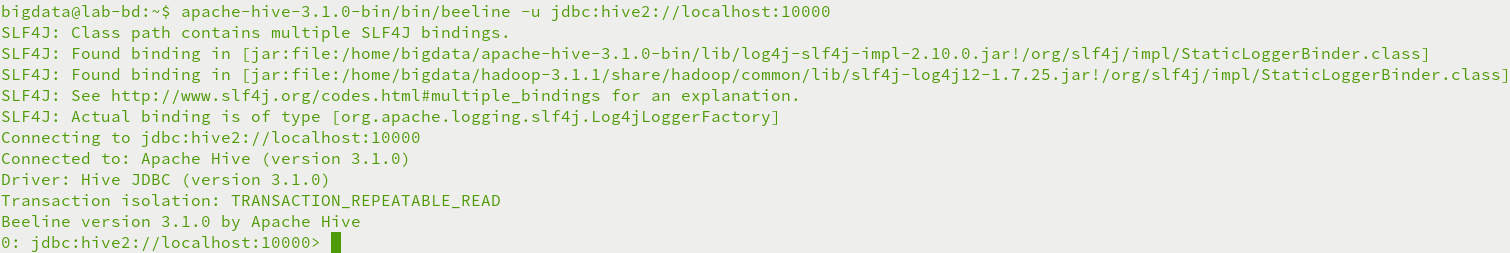

启动beeline连接hive

bigdata@lab-bd:~$ apache-hive-3.1.-bin/bin/beeline -u jdbc:hive2://localhost:10000

四.运行异常

1.运行Hive异常

异常FAILED: HiveException java.lang.RuntimeException: Unable to instantiate org.apache.hadoop.hive.ql.metadata.SessionHiveMetaStoreClient

原因是metastore元数据库没有初始化

使用schematool命令初始化metastore数据库

bigdata@lab-bd:~$ apache-hive-3.1.-bin/bin/schematool -dbType mysql -initSchema

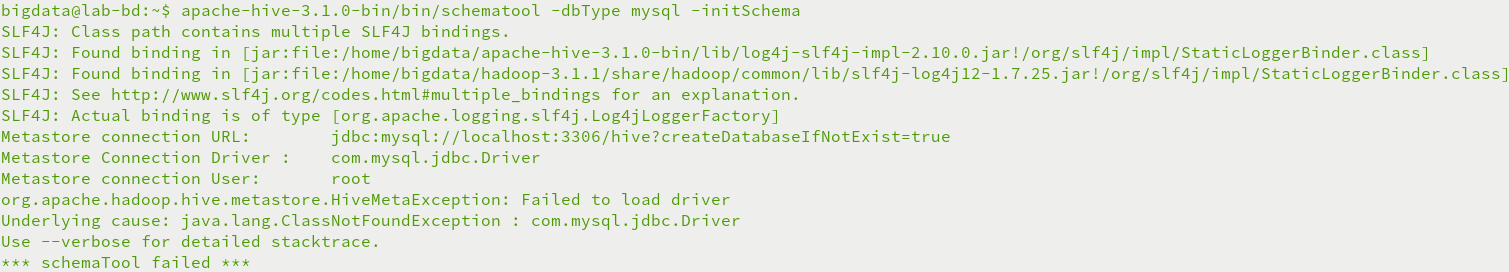

2.初始化metastore异常

异常org.apache.hadoop.hive.metastore.HiveMetaException: Failed to load driver

原因Hive的lib目录下无MySQL驱动包

下载mysql-connector驱动包,并移动到lib目录下

bigdata@lab-bd:~$ mv mysql-connector-java-5.1..jar apache-hive-3.1.-bin/lib/

3.beeline连接异常

异常User: bigdata is not allowed to impersonate anonymous (state=08S01,code=0)

原因不允许匿名用户访问,需要配置etc/hoaddop/core-site.xml文件,增加如下配置项,proxyuser后为代理用户(bigdata)

<property>

<name>hadoop.proxyuser.bigdata.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.bigdata.groups</name>

<value>*</value>

</property>

Hive数据仓库工具安装的更多相关文章

- Hive数据仓库工具基本架构和入门部署详解

@ 目录 概述 定义 本质 特点 Hive与Hadoop关系 Hive与关系型数据库区别 优缺点 其他说明 架构 组成部分 数据模型(Hive数据组织形式) Metastore(元数据) Compil ...

- 基于hadoop的数据仓库工具:Hive概述

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的sql查询功能,可以将sql语句转换为MapReduce任务进行运行.其优点是学习成本低,可以通过类 ...

- (第7篇)灵活易用易维护的hadoop数据仓库工具——Hive

摘要: Hive灵活易用且易于维护,十分适合数据仓库的统计分析,什么样的结构让它具备这些特性?我们如何才能灵活操作hive呢? 博主福利 给大家推荐一套hadoop视频课程 [百度hadoop核心架构 ...

- Hive和SparkSQL:基于 Hadoop 的数据仓库工具

Hive 前言 Hive 是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的 SQL 查询功能,将类 SQL 语句转换为 MapReduce 任务执行. ...

- Hive和SparkSQL: 基于 Hadoop 的数据仓库工具

Hive: 基于 Hadoop 的数据仓库工具 前言 Hive 是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的 SQL 查询功能,将类 SQL 语句转 ...

- Hive:数据仓库工具,由Facebook贡献。

Hadoop Common: 在0.20及以前的版本中,包含HDFS.MapReduce和其他项目公共内容,从0.21开始HDFS和MapReduce被分离为独立的子项目,其余内容为Hadoop Co ...

- 杂项:hive(数据仓库工具)

ylbtech-杂项:hive(数据仓库工具) hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的sql查询功能,可以将sql语句转换为MapRedu ...

- Hive介绍、安装(转)

1.Hive介绍 1.1 Hive介绍 Hive是一个基于Hadoop的开源数据仓库工具,用于存储和处理海量结构化数据.它是Facebook 2008年8月开源的一个数据仓库框架,提供了类似于SQL语 ...

- 【转】 hive简介,安装 配置常见问题和例子

原文来自: http://blog.csdn.net/zhumin726/article/details/8027802 1 HIVE概述 Hive是基于Hadoop的一个数据仓库工具,可以将结构化 ...

随机推荐

- 细说flush、ob_flush的区别

ob_flush/flush在手册中的描述, 都是刷新输出缓冲区, 并且还需要配套使用, 所以会导致很多人迷惑… 其实, 他们俩的操作对象不同, 有些情况下, flush根本不做什么事情.. ob_* ...

- redis实现高并发下的抢购/秒杀功能

之前写过一篇文章,高并发的解决思路(点此进入查看),今天再次抽空整理下实际场景中的具体代码逻辑实现吧:抢购/秒杀是如今很常见的一个应用场景,那么高并发竞争下如何解决超抢(或超卖库存不足为负数的问题)呢 ...

- JSJ——主数据类型和引用

变量有两种:primitive主数据类型和引用. Java注重类型.它不会让你做出把长颈鹿类型变量装进兔子类型变量中这种诡异又危险的举动——如果有人对长颈鹿调用“跳跃”这个方法会发生什么悲剧?并且它也 ...

- 提取Chrome插件为crx文件

在Chrome浏览器输入 chrome://extensions/,点开右上角开发者模式 记录上图中的ID:gidgenkbbabolejbgbpnhbimgjbffefm 在资源管理器中找到Chro ...

- 二进制安装 kubernetes 1.12(五) - 运行测试实例

检查集群状态 # 在 master 上 kubectl get node kubectl get cs 注册登录阿里云容器仓库 因国内无法获得 google 的 pause-amd64 镜像,我这里使 ...

- SQL Server: Datetime,Datetime2

select CONVERT(nvarchar(50), '2018-10-10 10:13:32.000', 126) select convert(nvarchar(MAX), '2018-10- ...

- 初见jQuery EasyUI

本文通过一个简单的小例子,简述jQuery EasyUI的使用方法,仅供学习分享使用,如有不足之处,还请指正. 什么是jQuery EasyUI ? 引用官网的一句话:jQuery EasyUI fr ...

- SpringBoot-学习笔记

启动方式 运行main方法 @SpringBootApplication public class BootApplication { public static void main(String[] ...

- 最近因为突然喜欢这方面的ui设计,所以搜刮了很多我试过可用性强的界面,又可爱又实用···分享给大家咯

最近因为突然喜欢这方面的ui设计,所以搜刮了很多我试过可用性强的界面,又可爱又实用···分享给大家咯 1.Side-Menu.Android 分类侧滑菜单,Yalantis 出品. 项目地址:http ...

- $.ajax({})方法中的回调函数beforeSend,success,complete,error使用示例

在与后台交互的时候,经常使用到jquery的$.ajax()方法来请求数据.回调函数用的比较多的是success,但是beforeSend.complete.error函数也是很有用的.下面是使用例子 ...