Deep Learning 学习笔记(8):自编码器( Autoencoders )

之前的笔记,算不上是 Deep Learning,

只是为理解Deep Learning 而需要学习的基础知识,

从下面开始,我会把我学习UFDL的笔记写出来

#主要是给自己用的,所以其他人不一定看得懂#

UFDL链接 : http://deeplearning.stanford.edu/wiki/index.php/UFLDL_Tutorial

自编码器( Autoencoders ):(概述)

自编码器是只有一层隐藏节点,输入和输出具有相同节点数的神经网络。

自编码器的目的是求的函数  . 也就是希望是的神经网络的输出与输入误差尽量少。

. 也就是希望是的神经网络的输出与输入误差尽量少。

由于隐藏节点数目小于输入节点,

这就表示神经网络需要学习到输入样本的特征,以便进行压缩表示。

如果输入样本是完全混乱的,这将会十分困难。

但是当输入样本具有一定相似性(比如都是汽车),神经网络将会学习到其中的共同特征(比如车窗,车轮)

这种学习是半监督的(样本无标签,但是经过了筛选)。

自编码器(autoencoder):

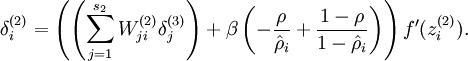

如图是一个自编码器(autoencoder),不算偏置节点的话,输入输出节点相同。

节点函数是sigmoid,用之前讲到的反向传播算法对其进行训练,

训练的结果,出来后,我们对W1进行可视化表示,便是数据的压缩特征。

(注意,由于输出节点是sigmoid,输入数据的范围必须在 [ 0, 1] 内)

(常用激活函数有:sigmoid、tanh、max(x,0))

稀疏性:(直接粘贴自UFDL)

如果隐藏节点比可视节点(输入、输出)少的话,由于被迫的降维,自编码器会自动习得训练样本的特征(变化最大,信息量最多的维度)。但是如果隐藏节点数目过多,甚至比可视节点数目还多的时候,自编码器不仅会丧失这种能力,更可能会习得一种“恒等函数”——直接把输入复制过去作为输出。这时候,我们需要对隐藏节点进行稀疏性限制。

所谓稀疏性,就是对一对输入图像,隐藏节点中被激活的节点数(输出接近1)远远小于被抑制的节点数目(输出接近0)。那么使得神经元大部分的时间都是被抑制的限制则被称作稀疏性限制。

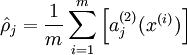

注意到  表示隐藏神经元

表示隐藏神经元  的激活度,但是这一表示方法中并未明确指出哪一个输入

的激活度,但是这一表示方法中并未明确指出哪一个输入  带来了这一激活度。所以我们将使用

带来了这一激活度。所以我们将使用  来表示在给定输入为

来表示在给定输入为  情况下,自编码神经网络隐藏神经元

情况下,自编码神经网络隐藏神经元  的激活度。 进一步,让

的激活度。 进一步,让

表示隐藏神经元  的平均活跃度(在训练集上取平均)。我们可以近似的加入一条限制

的平均活跃度(在训练集上取平均)。我们可以近似的加入一条限制

其中,  是稀疏性参数,通常是一个接近于0的较小的值(比如

是稀疏性参数,通常是一个接近于0的较小的值(比如  )。换句话说,我们想要让隐藏神经元

)。换句话说,我们想要让隐藏神经元  的平均活跃度接近0.05。为了满足这一条件,隐藏神经元的活跃度必须接近于0。

的平均活跃度接近0.05。为了满足这一条件,隐藏神经元的活跃度必须接近于0。

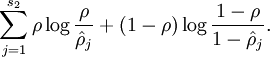

为了实现这一限制,我们将会在我们的优化目标函数中加入一个额外的惩罚因子,而这一惩罚因子将惩罚那些  和

和  有显著不同的情况从而使得隐藏神经元的平均活跃度保持在较小范围内。惩罚因子的具体形式有很多种合理的选择,我们将会选择以下这一种:

有显著不同的情况从而使得隐藏神经元的平均活跃度保持在较小范围内。惩罚因子的具体形式有很多种合理的选择,我们将会选择以下这一种:

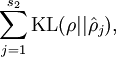

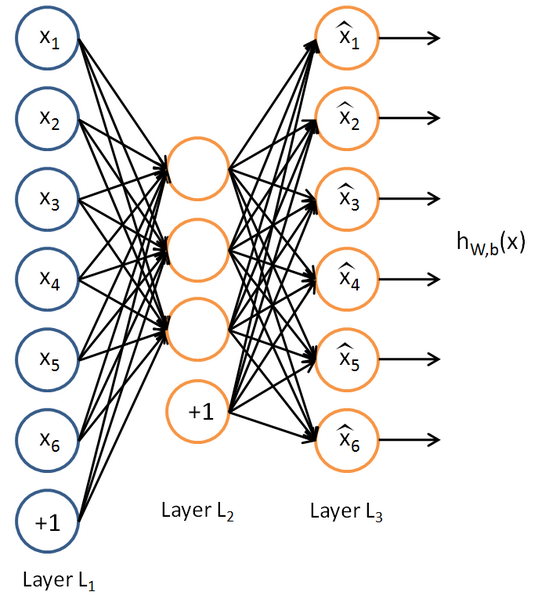

这里,  是隐藏层中隐藏神经元的数量,而索引

是隐藏层中隐藏神经元的数量,而索引  依次代表隐藏层中的每一个神经元。如果你对相对熵(KL divergence)比较熟悉,这一惩罚因子实际上是基于它的。于是惩罚因子也可以被表示为

依次代表隐藏层中的每一个神经元。如果你对相对熵(KL divergence)比较熟悉,这一惩罚因子实际上是基于它的。于是惩罚因子也可以被表示为

其中  是一个以

是一个以  为均值和一个以

为均值和一个以  为均值的两个伯努利随机变量之间的相对熵。相对熵是一种标准的用来测量两个分布之间差异的方法。(如果你没有见过相对熵,不用担心,所有你需要知道的内容都会被包含在这份笔记之中。)

为均值的两个伯努利随机变量之间的相对熵。相对熵是一种标准的用来测量两个分布之间差异的方法。(如果你没有见过相对熵,不用担心,所有你需要知道的内容都会被包含在这份笔记之中。)

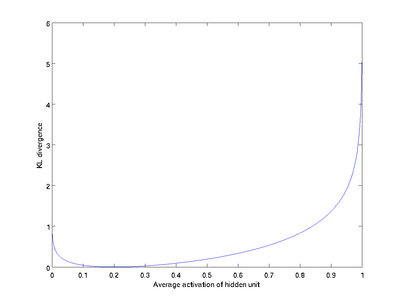

这一惩罚因子有如下性质,当  时

时  ,并且随着

,并且随着  与

与  之间的差异增大而单调递增。举例来说,在下图中,我们设定

之间的差异增大而单调递增。举例来说,在下图中,我们设定  并且画出了相对熵值

并且画出了相对熵值  随着

随着  变化的变化。

变化的变化。

我们可以看出,相对熵在  时达到它的最小值0,而当

时达到它的最小值0,而当  靠近0或者1的时候,相对熵则变得非常大(其实是趋向于

靠近0或者1的时候,相对熵则变得非常大(其实是趋向于 )。所以,最小化这一惩罚因子具有使得

)。所以,最小化这一惩罚因子具有使得  靠近

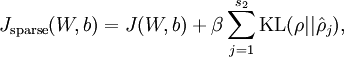

靠近  的效果。 现在,我们的总体代价函数可以表示为

的效果。 现在,我们的总体代价函数可以表示为

其中  如之前所定义,而

如之前所定义,而  控制稀疏性惩罚因子的权重。

控制稀疏性惩罚因子的权重。  项则也(间接地)取决于

项则也(间接地)取决于  ,因为它是隐藏神经元

,因为它是隐藏神经元  的平均激活度,而隐藏层神经元的激活度取决于

的平均激活度,而隐藏层神经元的激活度取决于  。

。

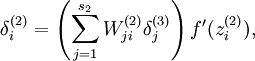

为了对相对熵进行导数计算,我们可以使用一个易于实现的技巧,这只需要在你的程序中稍作改动即可。具体来说,前面在后向传播算法中计算第二层(  )更新的时候我们已经计算了

)更新的时候我们已经计算了

现在我们将其换成

就可以了。

Deep Learning 学习笔记(8):自编码器( Autoencoders )的更多相关文章

- 【deep learning学习笔记】注释yusugomori的DA代码 --- dA.h

DA就是“Denoising Autoencoders”的缩写.继续给yusugomori做注释,边注释边学习.看了一些DA的材料,基本上都在前面“转载”了.学习中间总有个疑问:DA和RBM到底啥区别 ...

- 【Deep Learning学习笔记】Dynamic Auto-Encoders for Semantic Indexing_Mirowski_NIPS2010

发表于NIPS2010 workshop on deep learning的一篇文章,看得半懂. 主要内容: 是针对文本表示的一种方法.文本表示可以进一步应用在文本分类和信息检索上面.通常,一篇文章表 ...

- [置顶]

Deep Learning 学习笔记

一.文章来由 好久没写原创博客了,一直处于学习新知识的阶段.来新加坡也有一个星期,搞定签证.入学等杂事之后,今天上午与导师确定了接下来的研究任务,我平时基本也是把博客当作联机版的云笔记~~如果有写的不 ...

- 【deep learning学习笔记】Recommending music on Spotify with deep learning

主要内容: Spotify是个类似酷我音乐的音乐站点.做个性化音乐推荐和音乐消费.作者利用deep learning结合协同过滤来做音乐推荐. 详细内容: 1. 协同过滤 基本原理:某两个用户听的歌曲 ...

- 【deep learning学习笔记】注释yusugomori的RBM代码 --- 头文件

百度了半天yusugomori,也不知道他是谁.不过这位老兄写了deep learning的代码,包括RBM.逻辑回归.DBN.autoencoder等,实现语言包括c.c++.java.python ...

- Neural Networks and Deep Learning学习笔记ch1 - 神经网络

近期開始看一些深度学习的资料.想学习一下深度学习的基础知识.找到了一个比較好的tutorial,Neural Networks and Deep Learning,认真看完了之后觉得收获还是非常多的. ...

- paper 149:Deep Learning 学习笔记(一)

1. 直接上手篇 台湾李宏毅教授写的,<1天搞懂深度学习> slideshare的链接: http://www.slideshare.net/tw_dsconf/ss-62245351? ...

- Deep Learning 学习笔记——第9章

总览: 本章所讲的知识点包括>>>> 1.描述卷积操作 2.解释使用卷积的原因 3.描述pooling操作 4.卷积在实践应用中的变化形式 5.卷积如何适应输入数据 6.CNN ...

- 【deep learning学习笔记】最近读的几个ppt(四)

这几个ppt都是在微博上看到的,是百度的一个员工整理的. <Deep Belief Nets>,31页的一个ppt 1. 相关背景 还是在说deep learning好啦,如特征表示云云. ...

随机推荐

- 51nod-1385-贪心-构造

http://www.51nod.com/onlineJudge/questionCode.html#!problemId=1385 基准时间限制:1 秒 空间限制:131072 KB 分值: 80 ...

- 23-THREE.JS 光照材质

<!DOCTYPE html> <html> <head> <title></title> <script src="htt ...

- 【Java】方法的重载与重写

一.方法的重载 1.概念 方法重载是指在一个类中定义多个同名的方法,但要求每个方法具有不同的参数的类型或参数的个数. 调用重载方法时,Java编译器能通过检查调用的方法的参数类型和个数选择一个恰当的方 ...

- 013——VUE中多种方式使用VUE控制style样式属性

<!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <title> ...

- YYMMDD转YYYY-MM-DD

date.replace(/(\d{4})(\d{2})(\d{2})/g,'$1-$2-$3');

- request对象和response对象,什么时候用,具体用哪一个,没有感觉

request对象和response对象,什么时候用,具体用哪一个,没有感觉

- 【tensorflow:Google】四、深层神经网络

一.深度学习与深层神经网络 1.线性模型局限性 线性模型无论多少层,表达能力是一致的.可以通过激活函数实现非线性. 2.多层网络可以解决异或运算 二.损失函数定义 1.经典损失函数: 分类问题: 二分 ...

- redux源码阅读之compose,applyMiddleware

我的观点是,看别人的源码,不追求一定要能原样造轮子,单纯就是学习知识,对于程序员的提高就足够了.在阅读redux的compose源码之前,我们先学一些前置的知识. redux源码阅读之compose, ...

- Flask--信号 blinker

Flask--信号 blinker Flask框架中的信号基于blinker,可以让开发者在flask请求过程中 定制一些用户行为执行. 在请求前后,模板渲染前后,上下文前后,异常 的时候 安装: p ...

- 使用Python 2.7实现的垃圾短信识别器

最近参加比赛,写了一个垃圾短信识别器,在这里做一下记录. 官方提供的数据是csv文件,其中训练集有80万条数据,测试集有20万条数据,训练集的格式为:行号 标记(0为普通短信,1为垃圾短信) 短信内容 ...