用Fluent实现MySQL到ODPS数据集成

安装ruby

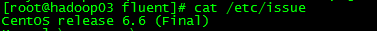

首先通过 /etc/issue 命令查看当前使用centos是哪个版本:

[hadoop@hadoop03 ~]$ cat /etc/issue

由于centos版本是6.6,安装ruby时就要选择在centos 6.X环境,具体安装步骤参考如下所示即可!

yum install gcc-c++ patch readline readline-devel zlib zlib-devel libyaml-devel libffi-devel openssl-devel make bzip2 autoconf automake libtool bison iconv-devel wget tar

wget https://ruby.taobao.org/mirrors/ruby/ruby-2.2.3.tar.gz

cd ruby-2.2.3

./configure

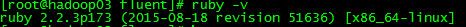

查看验证

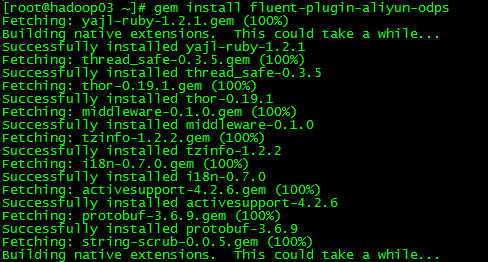

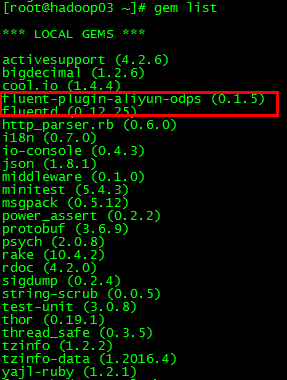

安装fluent-plugin-sql插件(输入源)

准备MySQL表及数据

其中id是主键,自增

备注:

grant ALL PRIVILEGES ON *.* to dong@"172.16.1.158" identified by "123456" WITH GRANT OPTION;

flush privileges;

准备ODPS测试表

编辑fluent.conf配置文件

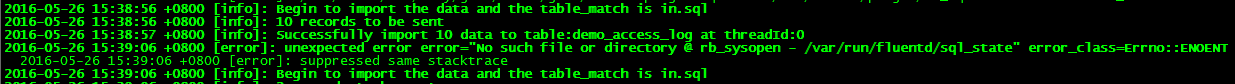

state_file /var/run/fluentd/sql_state 配置项 (path to a file to store last rows该文件默认不存在,需要提前创建好!)

state_file stores last selected rows to a file (named state_file) to not forget last row when Fluentd restarts.

[root@hadoop03 ~]# vi /etc/fluent/fluent.conf --编辑fluent.conf配置文件

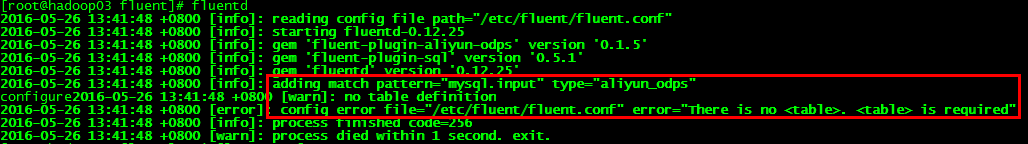

启动fluent

fluentd --启动命令

如果安装Fluentd 用的是Ruby Gem,可以创建一个配置文件运行下面命令。发出一个终止信号将会重新安装配置文件。(如果修改了配置文件—fluent.conf 文件,ctrl c 终止进程,然后在配置文件下重新启动)

$ ctrl c

$ fluentd -c fluent.conf

运行过程遇到异常及排查

(2)在fluent.conf配置正确基础上运行fluentd启动命令,又报以下异常:

这个问题是mysql插件需要用到mysql adapter适配器,需要安装mysql adapter适配器,执行以下命令:

[root@hadoop03 fluent]# yum install mysql-devel

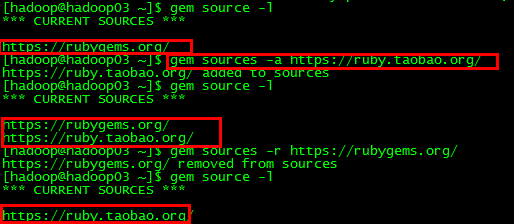

gem安装插件时遇到异常及排查

由于gem源引起,需要加上淘宝源后要把原来那个rubygems那个删掉

gem sources -r https://rubygems.org/

gem sources -a https://ruby.taobao.org/

没有写入执行权限

用Fluent实现MySQL到ODPS数据集成的更多相关文章

- 数据集成工具Kettle、Sqoop、DataX的比较

数据集成工具很多,下面是几个使用比较多的开源工具. 1.阿里开源软件:DataX DataX 是一个异构数据源离线同步工具,致力于实现包括关系型数据库(MySQL.Oracle等).H ...

- Spring 4 MVC+Hibernate 4+MySQL+Maven使用注解集成实例

Spring 4 MVC+Hibernate 4+MySQL+Maven使用注解集成实例 转自:通过注解的方式集成Spring 4 MVC+Hibernate 4+MySQL+Maven,开发项目样例 ...

- 【ODI】| 数据ETL:从零开始使用Oracle ODI完成数据集成(三)

资料库的创建.体系结构的创建.模型反向工程都已经完成了,下面就是创建以及执行接口来完成工作了. 浏览前两节请点击: [ODI]| 数据ETL:从零开始使用Oracle ODI完成数据集成(一) [OD ...

- 【ODI】| 数据ETL:从零开始使用Oracle ODI完成数据集成(一)

0. 环境说明及软件准备 ODI(Oracle Data Integrator)是Oracle公司提供的一种数据集成工具,能高效地实现批量数据的抽取.转换和加载.ODI可以实现当今大多数的主流关系型数 ...

- 打造实时数据集成平台——DataPipeline基于Kafka Connect的应用实践

导读:传统ETL方案让企业难以承受数据集成之重,基于Kafka Connect构建的新型实时数据集成平台被寄予厚望. 在4月21日的Kafka Beijing Meetup第四场活动上,DataPip ...

- DataPipeline CTO陈肃:从ETL到ELT,AI时代数据集成的问题与解决方案

引言:2018年7月25日,DataPipeline CTO陈肃在第一期公开课上作了题为<从ETL到ELT,AI时代数据集成的问题与解决方案>的分享,本文根据陈肃分享内容整理而成. 大家好 ...

- 资料:MVC框架+SQL Server 数据集成引擎

ylbtech-资料:MVC框架+SQL Server 数据集成引擎 1.返回顶部 1. 功能特点: MVC框架耦合性低视图层和业务层分离,这样就允许更改视图层代码而不用重新编译模型和控制器代码,同样 ...

- 数据集成工具:Teiid实践

数据集成是把不同来源.格式.特点性质的数据在逻辑上或物理上有机地集中,从而为企业提供全面的数据共享.数据集成的方式多种多样,这里介绍的 Teiid 是其中的一种:通过抽象和联邦技术,实现分布式数据源的 ...

- DataPipeline丨构建实时数据集成平台时,在技术选型上的考量点

文 | 陈肃 DataPipeline CTO 随着企业应用复杂性的上升和微服务架构的流行,数据正变得越来越以应用为中心. 服务之间仅在必要时以接口或者消息队列方式进行数据交互,从而避免了构建单一数 ...

随机推荐

- 用c#语言编写水仙花数

using System;using System.Collections.Generic;using System.Linq;using System.Text;using System.Threa ...

- vue webpack多页面构建

项目示例地址: https://github.com/ccyinghua/webpack-multipage 项目运行: 下载项目之后 # 下载依赖 npm install # 运行 npm run ...

- 复制功能 js

示例: <input class="herf" type="text" v-model="herfUrl" readonly=&quo ...

- SpringBoot非官方教程 | 第二篇:Spring Boot配置文件详解

转载请标明出处: 原文首发于:https://www.fangzhipeng.com/springboot/2017/07/11/springboot2-config-file/ 本文出自方志朋的博客 ...

- 菜鸟笔记 -- Chapter 6.4 面向对象的三大特性

6.4.1 三大特性概述 面向对象的三大特性是Java中一个很重要的基本理念. 封装是面向对象的核心思想.将对象的属性和行为封装起来,其载体就是类,类通常对客户隐藏其实现细节,这就是封装的意思.采用 ...

- JavaScript 基础(四) 循环

JavaScript的循环有两种,一种是for 循环,通过初始条件,结束条件和递增条件来循环执行语句块: var x = 0; var i; for(i=1; i <=10000; i++){ ...

- 【模板】概率dp

有n个投资事件,和一个成功概率最低接受值rate.每个投资的价值是c[i],成功概率是p[i](浮点数). 在保证成功概率≥rate的情况下,使价值最大化. #include<bits/stdc ...

- QString, Std::string, char *相互转换

Qt 库中对字符串类型进行了封装,QString 类提供了所有字符串操作方法,给开发带来了便利. 由于第三方库的类型基本上都是标准的类型,即使用std::string或char *来表示字符 (串) ...

- [JSOI2010]Group 部落划分 Group

Time Limit: 10 Sec Memory Limit: 64 MBSubmit: 3661 Solved: 1755[Submit][Status][Discuss] Descripti ...

- Struts2进阶学习4

Struts2进阶学习4 自定义拦截器的使用 核心配置文件 <?xml version="1.0" encoding="UTF-8"?> <! ...