Hadoop WordCount程序

一、把所有Hadoop的依赖jar包导入buildpath,不用一个一个调,都导一遍就可以,因为是一个工程,所以覆盖是没有问题的

二、写wordcount程序

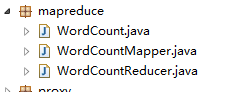

1.工程目录结构如下:

2.写mapper程序:

package mapreduce; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

/**

* LongWritable想当于long,这个是Hadoop特有的类型,因为是要网络间通信远程执行的,所以需要序列化,这个封装类型的序列化效果更好

* Text等于String

* @author Q

*

*/

public class WordCountMapper extends Mapper<LongWritable, Text, Text, LongWritable>{

@Override

protected void map(LongWritable key, Text value,

Mapper<LongWritable, Text, Text, LongWritable>.Context context)

throws IOException, InterruptedException {

// key为字符偏移量 value为一行的内容

String line = value.toString();

String[] words = line.split(" ");

//发送 <key,1>键值对到reducer

for(String word:words){

context.write(new Text(word), new LongWritable());

}

} }

2.写reducer程序

package mapreduce; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; public class WordCountReducer extends Reducer<Text, LongWritable, Text, LongWritable>{

@Override

protected void reduce(Text key, Iterable<LongWritable> values,

Reducer<Text, LongWritable, Text, LongWritable>.Context context)

throws IOException, InterruptedException {

long sub=;

//接收到<key,value>键值对,此时key为单词,value是一个迭代器,可以看成例如:<"hello",List{1,1,1,1,1}>

for(LongWritable value:values){

sub+=value.get();

}

context.write(key, new LongWritable(sub)); } }

3.写main函数

package mapreduce; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class WordCount {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

// 获取job对象,用来提交MapReduce任务

Job job = Job.getInstance(conf);

// 通过class路径设置jar

job.setJarByClass(WordCount.class);

// 设置mapper和reducer类

job.setMapperClass(WordCountMapper.class);

job.setReducerClass(WordCountReducer.class);

// 设置mapper的输出键值对的类型

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(LongWritable.class);

// 设置reducer的输出键值对

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class);

// 输入输出文件的路径

FileInputFormat.setInputPaths(job, new Path("hdfs://hadoop1:9000/wordcount/data/"));

FileOutputFormat.setOutputPath(job, new Path("hdfs://hadoop1:9000/wordcount/output1"));

//提交任务

job.waitForCompletion(true);

} }

4.将工程打包成jar文件传到Linux平台上

打包:鼠标放在工程上右键---》点击export--》java--》JAE File

Linux上运行jar包的命令是

hadoop jar wordcount.jar mapreduce.WordCount 有两个参数,第一个参数是你打包的jar的名字,第二个参数是你的main函数的全限定名

Hadoop WordCount程序的更多相关文章

- hadoop wordcount程序缺陷

在wordcount 程序的main函数中,没有读取运行环境中的各种参数的值,全靠hadoop系统的默认参数跑起来,这样做是有风险的,最突出的就是OOM错误. 自己在刚刚学习hadoop编程时,就是模 ...

- Hadoop入门程序WordCount的执行过程

首先编写WordCount.java源文件,分别通过map和reduce方法统计文本中每个单词出现的次数,然后按照字母的顺序排列输出, Map过程首先是多个map并行提取多个句子里面的单词然后分别列出 ...

- Hadoop入门实践之从WordCount程序说起

这段时间需要学习Hadoop了,以前一直听说Hadoop,但是从来没有研究过,这几天粗略看完了<Hadoop实战>这本书,对Hadoop编程有了大致的了解.接下来就是多看多写了.以Hado ...

- Hadoop下WordCount程序

一.前言 在之前我们已经在 CenOS6.5 下搭建好了 Hadoop2.x 的开发环境.既然环境已经搭建好了,那么现在我们就应该来干点正事嘛!比如来一个Hadoop世界的HelloWorld,也就是 ...

- Hadoop集群测试wordcount程序

一.集群环境搭好了,我们来测试一下吧 1.在java下创建一个wordcount文件夹:mkdir wordcount 2.在此文件夹下创建两个文件,比如file1.txt和file2.txt 在fi ...

- Hadoop环境搭建及wordcount程序

目的: 前期学习了一些机器学习基本算法,实际企业应用中算法是核心,运行的环境和数据处理的平台是基础. 手段: 搭建简易hadoop集群(由于机器限制在自己的笔记本上通过虚拟机搭建) 一.基础环境介绍 ...

- Hadoop学习笔记(1):WordCount程序的实现与总结

开篇语: 这几天开始学习Hadoop,花费了整整一天终于把伪分布式给搭好了,激动之情无法言表······ 搭好环境之后,按着书本的代码,实现了这个被誉为Hadoop中的HelloWorld的程序--W ...

- hadoop学习笔记——用python写wordcount程序

尝试着用3台虚拟机搭建了伪分布式系统,完整的搭建步骤等熟悉了整个分布式框架之后再写,今天写一下用python写wordcount程序(MapReduce任务)的具体步骤. MapReduce任务以来H ...

- 020_自己编写的wordcount程序在hadoop上面运行,不使用插件hadoop-eclipse-plugin-1.2.1.jar

1.Eclipse中无插件运行MP程序 1)在Eclipse中编写MapReduce程序 2)打包成jar包 3)使用FTP工具,上传jar到hadoop 集群环境 4)运行 2.具体步骤 说明:该程 ...

随机推荐

- Django框架-模板系统

来看一段代码 def current_datetime(request): now = datetime.datetime.now() html = "<html><bod ...

- DjangoDRF序列化组件使用

创建一个Django项目,名字:untitled1 创建三张表 from django.db import models class Publish(models.Model): nid = mode ...

- .tomcat 管理 给tomcat设置用户名和密码登录

如果点击红色框框 出现403以下错误 看这个帖子可以解决 tomcat访问管理页面出现:403 Access Denied 解决方法 tomca管理 测试功能,生产环境不要用. Tomcat管理功能用 ...

- Android_Kotlin 代码学习

https://github.com/ldm520/Android_Kotlin_Demo

- zookeer安装

解压:tar xf zookeeper-3.4.9.tar.gz进入目录cd /opt/zookeeper-3.4.9/ 编辑配置文件:vim zoo.cfg# The number of milli ...

- thinkphp使用阿里云OSS最新SDK,文件部署

这文章是建立在你已经注册号阿里云的OSS,和创建好Bucket前提下: 其实阿里云的帮助与文档写的很详细,这里只说一下源码方式 1.phpsdk下载地址(摘自阿里云OSS的帮助与文档)(也有我自己下载 ...

- Python之初识函数(Day11)

一.函数的定义与调用 总结一: 定义:def 关键词开头,空格之后接函数名称和圆括号(),最后还有一个":". def 是固定的,不能变,必须是连续的def三个字母,不能分开... ...

- loc、iloc、ix比较

使用pandas创建一个对象 In [1]: import pandas as pd In [2]: import numpy as np In [3]: df = pd.DataFrame(np.r ...

- C#前后端交互

后台接收 方式1: Request.Form[""] post Request.QueryString[""] get System.Web.HttpConte ...

- 微信小程序组件icon

基础内容icon:官方文档 Demo Code Page({ data: { iconSize: [20, 30, 40, 50, 60, 70], iconColor: [ 'red', 'oran ...