TFLearn 与 Tensorflow 一起使用

好用的不是一点点、、=-=、、

import tensorflow as tf

import tflearn

import tflearn.datasets.mnist as mnist

# Using MNIST Dataset

import tflearn.datasets.mnist as mnist

mnist_data = mnist.read_data_sets(one_hot=True)

# User defined placeholders

with tf.Graph().as_default():

# Placeholders for data and labels

X = tf.placeholder(shape=(None, 784), dtype=tf.float32)

Y = tf.placeholder(shape=(None, 10), dtype=tf.float32)

net = tf.reshape(X, [-1, 28, 28, 1])

# Using TFLearn wrappers for network building

net = tflearn.conv_2d(net, 32, 3, activation='relu')

net = tflearn.max_pool_2d(net, 2)

net = tflearn.local_response_normalization(net)

net = tflearn.dropout(net, 0.8)

net = tflearn.conv_2d(net, 64, 3, activation='relu')

net = tflearn.max_pool_2d(net, 2)

net = tflearn.local_response_normalization(net)

net = tflearn.dropout(net, 0.8)

net = tflearn.fully_connected(net, 128, activation='tanh')

net = tflearn.dropout(net, 0.8)

net = tflearn.fully_connected(net, 256, activation='tanh')

net = tflearn.dropout(net, 0.8)

net = tflearn.fully_connected(net, 10, activation='linear')

# Defining other ops using Tensorflow

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=net, labels=Y))

optimizer = tf.train.AdamOptimizer(learning_rate=0.01).minimize(loss)

# Initializing the variables

init = tf.initialize_all_variables()

# Launch the graph

with tf.Session() as sess:

sess.run(init)

batch_size = 128

for epoch in range(2): # 2 epochs

avg_cost = 0.

total_batch = int(mnist_data.train.num_examples/batch_size)

for i in range(total_batch):

batch_xs, batch_ys = mnist_data.train.next_batch(batch_size)

sess.run(optimizer, feed_dict={X: batch_xs, Y: batch_ys})

cost = sess.run(loss, feed_dict={X: batch_xs, Y: batch_ys})

avg_cost += cost/total_batch

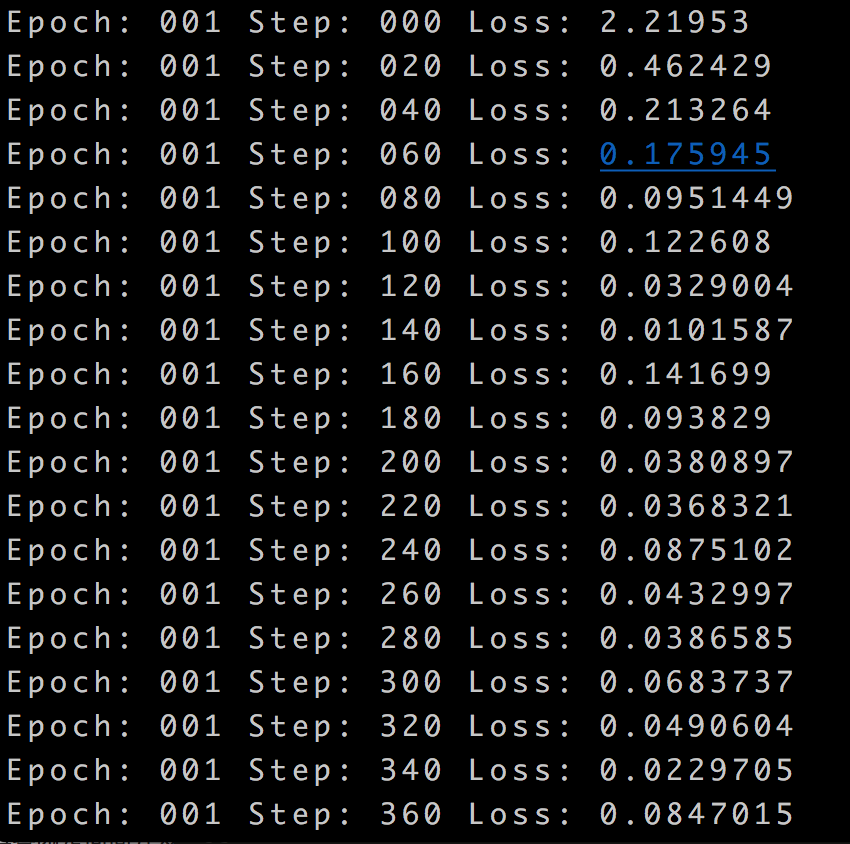

if i % 20 == 0:

print "Epoch:", '%03d' % (epoch+1), "Step:", '%03d' % i, "Loss:", str(cost)

结果:

TFLearn 与 Tensorflow 一起使用的更多相关文章

- NN tutorials:

确实“人话”解释清楚了 ^_^ 池化不只有减少参数的作用,还可以: 不变性,更关注是否存在某些特征而不是特征具体的位置.可以看作加了一个很强的先验,让学到的特征要能容忍一些的变化.防止过拟合,提高模型 ...

- Tensorflow tflearn 编写RCNN

两周多的努力总算写出了RCNN的代码,这段代码非常有意思,并且还顺带复习了几个Tensorflow应用方面的知识点,故特此总结下,带大家分享下经验.理论方面,RCNN的理论教程颇多,这里我不在做详尽说 ...

- tflearn tensorflow LSTM predict sin function

from __future__ import division, print_function, absolute_import import tflearn import numpy as np i ...

- TensorFlow 之 高层封装slim,tflearn,keras

tensorflow资源整合 使用原生态TensorFlow API来实现各种不同的神经网络结构.虽然原生态的TensorFlow API可以很灵活的支持不同的神经网络结构,但是其代码相对比较冗长,写 ...

- tflearn 中文汉字识别,训练后模型存为pb给TensorFlow使用——模型层次太深,或者太复杂训练时候都不会收敛

tflearn 中文汉字识别,训练后模型存为pb给TensorFlow使用. 数据目录在data,data下放了汉字识别图片: data$ ls0 1 10 11 12 13 14 15 ...

- anaconda tensorflow tflearn 自动安装脚本 anaconda使用-b可以非交互式安装

install_dir=/usr/local/anaconda3 DIR="$( cd "$( dirname "${BASH_SOURCE[0]}" )&qu ...

- 将tflearn的模型保存为pb,给TensorFlow使用

参考:https://github.com/tflearn/tflearn/issues/964 解决方法: """ Tensorflow graph freezer C ...

- TensorFlow实战笔记(17)---TFlearn

目录: 分布式Estimator 自定义模型 建立自己的机器学习Estimator 调节RunConfig运行时的参数 Experiment和LearnRunner 深度学习Estimator 深度神 ...

- 吴裕雄--天生自然TensorFlow高层封装:使用TFLearn处理MNIST数据集实现LeNet-5模型

# 1. 通过TFLearn的API定义卷机神经网络. import tflearn import tflearn.datasets.mnist as mnist from tflearn.layer ...

随机推荐

- snort安装使用教程(CentOS6.5)

官网:https://www.snort.org/ 官方文档:https://www.snort.org/documents 2.安装 2.1安装依赖 yum install flex bison - ...

- Linux升级内核教程(CentOS7)

1.查看当前内核版本 uname -r 2.通过yum升级内核 通过yum升级内核是最保险的升级方式,因为安装的是操作系统发行厂商验证过兼容性的rpm包,升级风险一般很小. yum install - ...

- CM+CDH安装教程(CentOS)

一.简单介绍 CM:Cloudera Manager,Cloudera公司编写的一个CDH的管理后台,类似各CMS的管理后台. CDH:Cloudera’s distribution,includin ...

- Oracle 如何循环查询结果集,进行新增或修改

Oracle的PL/SQL中怎样循环查询的结果集,然后根据查询结果进行判断,是新增或修改操作 loop循环例子 for item in (select a,b,c from table_a where ...

- lombok @Slf4j注解

背景知道有这么个东西,是因为项目中用到了@Slf4j注解. lombok库提供了一些注解来简化java代码 官网:http://projectlombok.org/ 查看lombok所有api:htt ...

- 异步socket处理

服务器端: #include <boost/thread.hpp> #include <boost/asio.hpp> #include <boost/date_time ...

- POJ 2243 Knight Moves(BFS)

POJ 2243 Knight Moves A friend of you is doing research on the Traveling Knight Problem (TKP) where ...

- SpringMVC中文乱码的解决办法

中文乱码分类: (1)按照请求分类: GET请求乱码 POST请求乱码 (2)按照乱码位置分类 从前台传到后台的数据乱码(存储到数据库中的数据乱码) 从后台传到前台的数据乱码(显示在页面的数据乱码) ...

- IIS设置上传文件大小限制

单位为字节. 500*1024*1024=524288000

- jdk8-stream的api

1.stream流的概念 1.流的创建 //1. 创建 Stream @Test public void test1(){ //1. Collection 提供了两个方法 stream() 与 par ...