tensorflowxun训练自己的数据集之从tfrecords读取数据

当训练数据量较小时,采用直接读取文件的方式,当训练数据量非常大时,直接读取文件的方式太耗内存,这时应采用高效的读取方法,读取tfrecords文件,这其实是一种二进制文件。tensorflow为其内置了各种存储和读取的函数,方便调用。

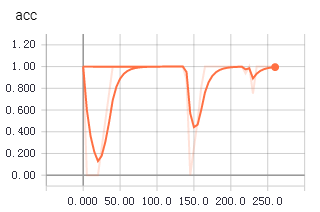

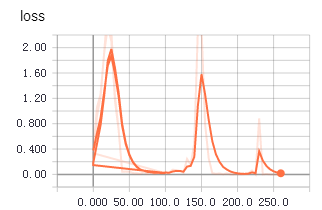

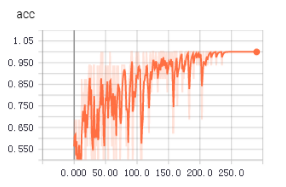

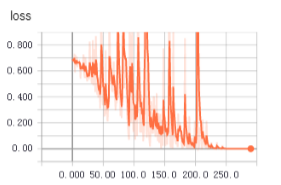

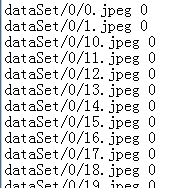

不知道为啥,从tfrecords中读取数据用于训练时,收敛得更快,更平稳。上面两个图是使用tfrecords的准确率和loss值变化,下面是直接读取文件的准确率和loss值变化。

1 生成记录样本的记录文件

root_dir = os.getcwd() def getTrianList():

with open("train.txt","w") as f:

for file in os.listdir(root_dir+'\\dataSet'):

for picFile in os.listdir(root_dir+"\\dataSet\\"+file):

f.write("dataSet/"+file+"/"+picFile+" "+file+"\n")

print(picFile)

if __name__=="__main__":

getTrianList()

将样本文件路径和标签统一记录到一个txt中,后面生成tfrecords文件就是通过读取这些信息。

注意文件路径和标签之间采用空格,不要使用制表符。

2 读取txt存于数组中

def load_file(example_list_file):

lines = np.genfromtxt(example_list_file,delimiter=" ",dtype=[('col1', 'S120'), ('col2', 'i8')])

examples = []

labels = []

for example,label in lines:

examples.append(example)

labels.append(label)

#convert to numpy array

return np.asarray(examples),np.asarray(labels),len(lines)

这段代码主要用来读取第1步生成的txt,将文件路径和标签存于数组中

3 读取图片

def extract_image(filename,height,width):

print(filename)

image = cv2.imread(filename)

image = cv2.resize(image,(height,width))

b,g,r = cv2.split(image)

rgb_image = cv2.merge([r,g,b])

return rgb_image

使用cv2读取图片文件

4 转化为tfrecords文件

def trans2tfRecord(trainFile,name,output_dir,height,width):

if not os.path.exists(output_dir) or os.path.isfile(output_dir):

os.makedirs(output_dir)

_examples,_labels,examples_num = load_file(train_file)

filename = name + '.tfrecords'

writer = tf.python_io.TFRecordWriter(filename)

for i,[example,label] in enumerate(zip(_examples,_labels)):

print("NO{}".format(i))

#need to convert the example(bytes) to utf-8

example = example.decode("UTF-8")

image = extract_image(example,height,width)

image_raw = image.tostring()

example = tf.train.Example(features=tf.train.Features(feature={

'image_raw':_bytes_feature(image_raw),

'height':_int64_feature(image.shape[0]),

'width': _int64_feature(32),

'depth': _int64_feature(32),

'label': _int64_feature(label)

}))

writer.write(example.SerializeToString())

writer.close()

def _int64_feature(value):

return tf.train.Feature(int64_list=tf.train.Int64List(value=[value])) def _bytes_feature(value):

return tf.train.Feature(bytes_list=tf.train.BytesList(value=[value]))

5 从tfrecords中读取训练数据

def read_tfRecord(file_tfRecord):

queue = tf.train.string_input_producer([file_tfRecord])

reader = tf.TFRecordReader()

_,serialized_example = reader.read(queue)

features = tf.parse_single_example(

serialized_example,

features={

'image_raw': tf.FixedLenFeature([], tf.string),

'height': tf.FixedLenFeature([], tf.int64),

'width':tf.FixedLenFeature([], tf.int64),

'depth': tf.FixedLenFeature([], tf.int64),

'label': tf.FixedLenFeature([], tf.int64)

}

)

image = tf.decode_raw(features['image_raw'],tf.uint8)

#height = tf.cast(features['height'], tf.int64)

#width = tf.cast(features['width'], tf.int64)

image = tf.reshape(image,[32,32,3])

image = tf.cast(image, tf.float32)

image = tf.image.per_image_standardization(image)

label = tf.cast(features['label'], tf.int64)

print(image,label)

return image,label

从tfrecords文件中读取image和label,训练的时候,直接使用tf.train.batch函数生成用于训练的batch即可。

image_batches,label_batches = tf.train.batch([image, label], batch_size=16, capacity=20)

其余的部分跟之前的训练步骤一样。

tensorflowxun训练自己的数据集之从tfrecords读取数据的更多相关文章

- TensorFlow学习笔记——LeNet-5(训练自己的数据集)

在之前的TensorFlow学习笔记——图像识别与卷积神经网络(链接:请点击我)中了解了一下经典的卷积神经网络模型LeNet模型.那其实之前学习了别人的代码实现了LeNet网络对MNIST数据集的训练 ...

- Fast RCNN 训练自己的数据集(3训练和检测)

转载请注明出处,楼燚(yì)航的blog,http://www.cnblogs.com/louyihang-loves-baiyan/ https://github.com/YihangLou/fas ...

- 【faster-rcnn】训练自己的数据集时的坑

既然faster-rcnn原版发表时候是matlab版代码,那就用matlab版代码吧!不过遇到的坑挺多的,不知道python版会不会好一点. ======= update ========= 总体上 ...

- 【Tensorflow系列】使用Inception_resnet_v2训练自己的数据集并用Tensorboard监控

[写在前面] 用Tensorflow(TF)已实现好的卷积神经网络(CNN)模型来训练自己的数据集,验证目前较成熟模型在不同数据集上的准确度,如Inception_V3, VGG16,Inceptio ...

- 目标检测算法SSD之训练自己的数据集

目标检测算法SSD之训练自己的数据集 prerequesties 预备知识/前提条件 下载和配置了最新SSD代码 git clone https://github.com/weiliu89/caffe ...

- 可变卷积Deforable ConvNet 迁移训练自己的数据集 MXNet框架 GPU版

[引言] 最近在用可变卷积的rfcn 模型迁移训练自己的数据集, MSRA官方使用的MXNet框架 环境搭建及配置:http://www.cnblogs.com/andre-ma/p/8867031. ...

- caffe训练自己的数据集

默认caffe已经编译好了,并且编译好了pycaffe 1 数据准备 首先准备训练和测试数据集,这里准备两类数据,分别放在文件夹0和文件夹1中(之所以使用0和1命名数据类别,是因为方便标注数据类别,直 ...

- 使用yolo3模型训练自己的数据集

使用yolo3模型训练自己的数据集 本项目地址:https://github.com/Cw-zero/Retrain-yolo3 一.运行环境 1. Ubuntu16.04. 2. TensorFlo ...

- 【tf.keras】在 cifar 上训练 AlexNet,数据集过大导致 OOM

cifar-10 每张图片的大小为 32×32,而 AlexNet 要求图片的输入是 224×224(也有说 227×227 的,这是 224×224 的图片进行大小为 2 的 zero paddin ...

随机推荐

- WebGL中图片多级处理(FrameBuffer)

在webgl的使用过程中,我们通常会想对texture进行多级处理并对其贴在表面显示 如对较精准的边缘检测,要先后使用灰度shader.模糊shader.边缘shader来进行处理,而每次的处理对象则 ...

- css+jq写的小小的移动端按钮的动画改变(三个很闲变成一个叉号)

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- Masonry介绍与使用实践 - iOS移动开发周报

本文转发至 http://www.tuicool.com/articles/MRbaEnB/ 原文 http://www.infoq.com/cn/news/2014/11/masonry-intr ...

- 【深入Java虚拟机】之二:Class类文件结构

平台无关性 Java是与平台无关的语言,这得益于Java源代码编译后生成的存储字节码的文件,即Class文件,以及Java虚拟机的实现.不仅使用Java编译器可以把Java代码编译成存储字节码的Cla ...

- CxGrid如何实现导出Excel 功能

ExportGrid4ToEXCEL 这个老的版本用的,新的版本引用 cxGridExportLink 这个单元 uses Windows, Messages, SysUtils, Variant ...

- jquery将具有相同名称的元素的值提取出来放到一个数组内

jquery将具有相同名称的元素的值提取出来放到一个数组内 var arrInputValues = new Array(); $("input[name='xxx']").ea ...

- LAMP集群项目

vi /etc/sysconfig/network 一.安装硬件环境(安装虚拟机) 1.安装VMware步骤 1.修改网卡配置 vi /etc/sysconfig/network-scripts/if ...

- 160321、ORACLE分页查询SQL语法——最高效的分页

--1:无ORDER BY排序的写法.(效率最高) --(经过测试,此方法成本最低,只嵌套一层,速度最快!即使查询的数据量再大,也几乎不受影响,速度依然!) SELECT * FROM (SELE ...

- ntpdate同步更新时间

Linux服务器运行久时,系统时间就会存在一定的误差,一般情况下可以使用date命令进行时间设置,但在做数据库集群分片等操作时对多台机器的时间差是有要求的,此时就需要使用ntpdate进行时间同步 1 ...

- Redis for Python开发手册

redis基本命令 String Set set(name, value, ex=None, px=None, nx=False, xx=False) 在Redis中设置值,默认,不存在则创建,存在则 ...