Storm编程入门API系列之Storm的Topology多个Executors数目控制实现

前期博客

Storm编程入门API系列之Storm的Topology默认Workers、默认executors和默认tasks数目

Storm编程入门API系列之Storm的Topology多个Workers数目控制实现

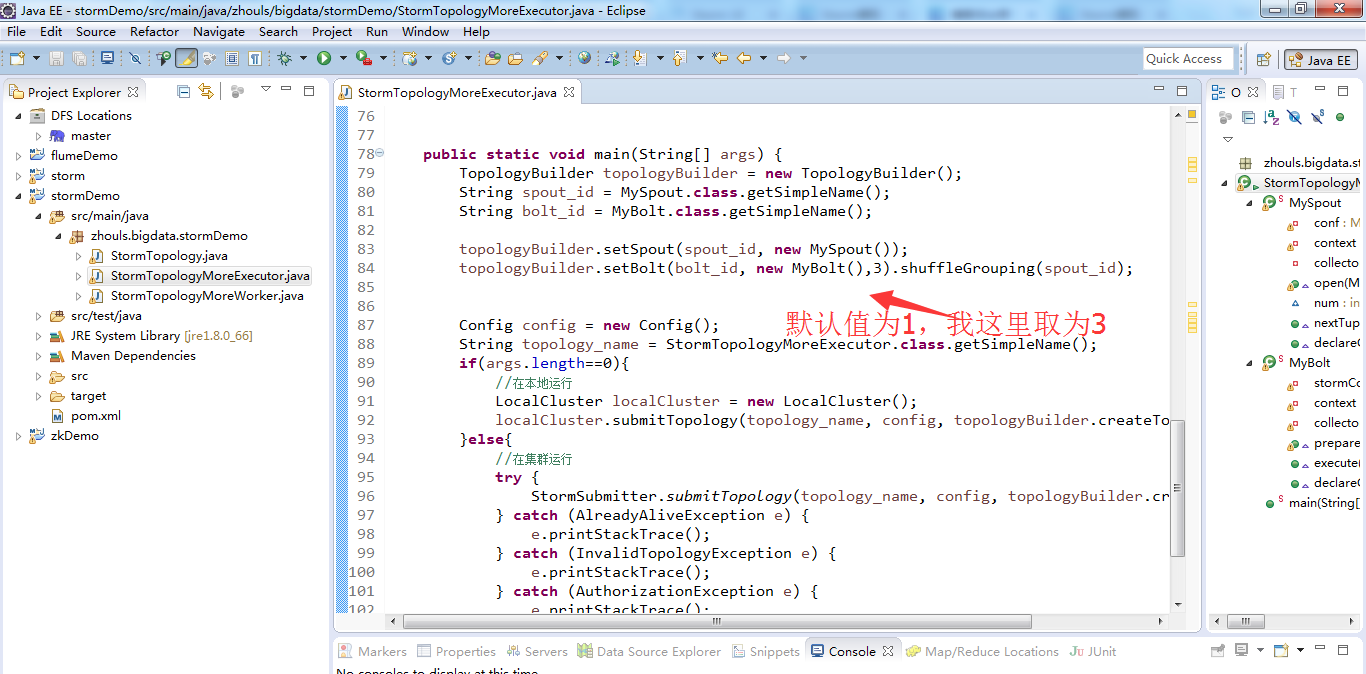

继续编写

StormTopologyMoreExecutor.java

package zhouls.bigdata.stormDemo; import java.util.Map; import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.StormSubmitter;

import org.apache.storm.generated.AlreadyAliveException;

import org.apache.storm.generated.AuthorizationException;

import org.apache.storm.generated.InvalidTopologyException;

import org.apache.storm.spout.SpoutOutputCollector;

import org.apache.storm.task.OutputCollector;

import org.apache.storm.task.TopologyContext;

import org.apache.storm.topology.OutputFieldsDeclarer;

import org.apache.storm.topology.TopologyBuilder;

import org.apache.storm.topology.base.BaseRichBolt;

import org.apache.storm.topology.base.BaseRichSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Tuple;

import org.apache.storm.tuple.Values;

import org.apache.storm.utils.Utils; public class StormTopologyMoreExecutor { public static class MySpout extends BaseRichSpout{

private Map conf;

private TopologyContext context;

private SpoutOutputCollector collector;

public void open(Map conf, TopologyContext context,

SpoutOutputCollector collector) {

this.conf = conf;

this.collector = collector;

this.context = context;

} int num = ;

public void nextTuple() {

num++;

System.out.println("spout:"+num);

this.collector.emit(new Values(num));

Utils.sleep();

} public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("num"));

} } public static class MyBolt extends BaseRichBolt{ private Map stormConf;

private TopologyContext context;

private OutputCollector collector;

public void prepare(Map stormConf, TopologyContext context,

OutputCollector collector) {

this.stormConf = stormConf;

this.context = context;

this.collector = collector;

} public void execute(Tuple input) {

Integer num = input.getIntegerByField("num");

System.out.println("线程id:"+Thread.currentThread().getId()+",接收的值为:"+num);

} public void declareOutputFields(OutputFieldsDeclarer declarer) { } } public static void main(String[] args) {

TopologyBuilder topologyBuilder = new TopologyBuilder();

String spout_id = MySpout.class.getSimpleName();

String bolt_id = MyBolt.class.getSimpleName(); topologyBuilder.setSpout(spout_id, new MySpout());

topologyBuilder.setBolt(bolt_id, new MyBolt(),).shuffleGrouping(spout_id); Config config = new Config();

String topology_name = StormTopologyMoreExecutor.class.getSimpleName();

if(args.length==){

//在本地运行

LocalCluster localCluster = new LocalCluster();

localCluster.submitTopology(topology_name, config, topologyBuilder.createTopology());

}else{

//在集群运行

try {

StormSubmitter.submitTopology(topology_name, config, topologyBuilder.createTopology());

} catch (AlreadyAliveException e) {

e.printStackTrace();

} catch (InvalidTopologyException e) {

e.printStackTrace();

} catch (AuthorizationException e) {

e.printStackTrace();

}

} } }

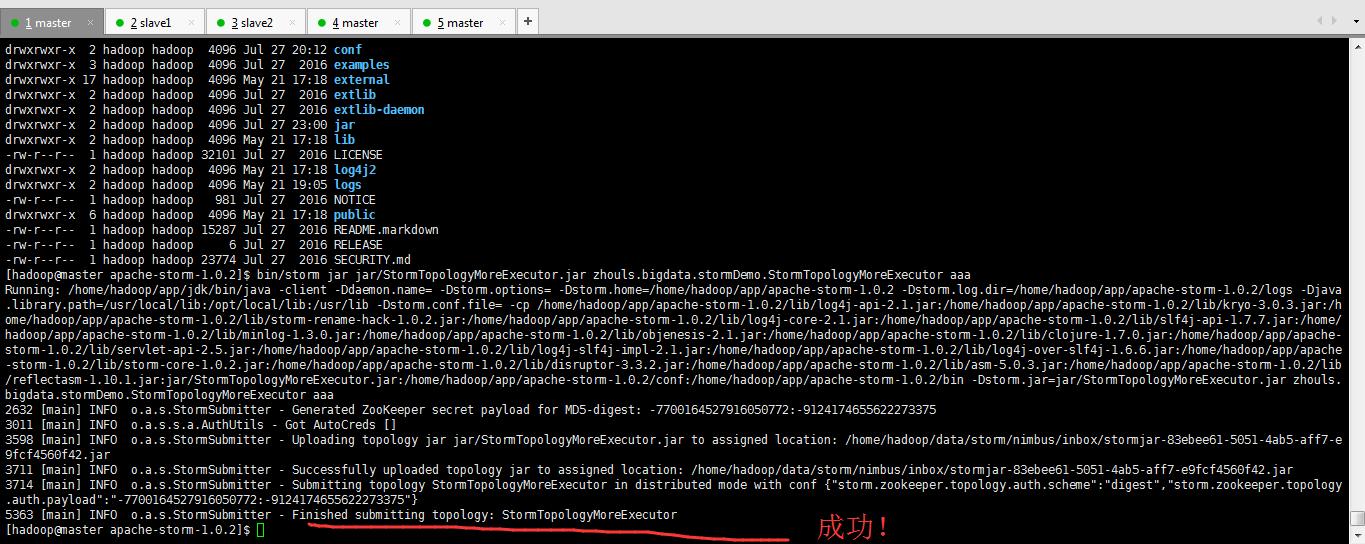

打jar包

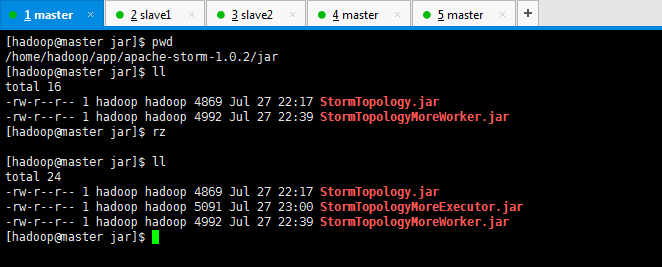

提交作业之前

[hadoop@master apache-storm-1.0.]$ pwd

/home/hadoop/app/apache-storm-1.0.

[hadoop@master apache-storm-1.0.]$ ll

total

drwxrwxr-x hadoop hadoop May : bin

-rw-r--r-- hadoop hadoop Jul CHANGELOG.md

drwxrwxr-x hadoop hadoop Jul : conf

drwxrwxr-x hadoop hadoop Jul examples

drwxrwxr-x hadoop hadoop May : external

drwxrwxr-x hadoop hadoop Jul extlib

drwxrwxr-x hadoop hadoop Jul extlib-daemon

drwxrwxr-x hadoop hadoop Jul : jar

drwxrwxr-x hadoop hadoop May : lib

-rw-r--r-- hadoop hadoop Jul LICENSE

drwxrwxr-x hadoop hadoop May : log4j2

drwxrwxr-x hadoop hadoop May : logs

-rw-r--r-- hadoop hadoop Jul NOTICE

drwxrwxr-x hadoop hadoop May : public

-rw-r--r-- hadoop hadoop Jul README.markdown

-rw-r--r-- hadoop hadoop Jul RELEASE

-rw-r--r-- hadoop hadoop Jul SECURITY.md

[hadoop@master apache-storm-1.0.]$ bin/storm jar jar/StormTopologyMoreExecutor.jar zhouls.bigdata.stormDemo.StormTopologyMoreExecutor aaa

Running: /home/hadoop/app/jdk/bin/java -client -Ddaemon.name= -Dstorm.options= -Dstorm.home=/home/hadoop/app/apache-storm-1.0. -Dstorm.log.dir=/home/hadoop/app/apache-storm-1.0./logs -Djava.library.path=/usr/local/lib:/opt/local/lib:/usr/lib -Dstorm.conf.file= -cp /home/hadoop/app/apache-storm-1.0./lib/log4j-api-2.1.jar:/home/hadoop/app/apache-storm-1.0./lib/kryo-3.0..jar:/home/hadoop/app/apache-storm-1.0./lib/storm-rename-hack-1.0..jar:/home/hadoop/app/apache-storm-1.0./lib/log4j-core-2.1.jar:/home/hadoop/app/apache-storm-1.0./lib/slf4j-api-1.7..jar:/home/hadoop/app/apache-storm-1.0./lib/minlog-1.3..jar:/home/hadoop/app/apache-storm-1.0./lib/objenesis-2.1.jar:/home/hadoop/app/apache-storm-1.0./lib/clojure-1.7..jar:/home/hadoop/app/apache-storm-1.0./lib/servlet-api-2.5.jar:/home/hadoop/app/apache-storm-1.0./lib/log4j-slf4j-impl-2.1.jar:/home/hadoop/app/apache-storm-1.0./lib/log4j-over-slf4j-1.6..jar:/home/hadoop/app/apache-storm-1.0./lib/storm-core-1.0..jar:/home/hadoop/app/apache-storm-1.0./lib/disruptor-3.3..jar:/home/hadoop/app/apache-storm-1.0./lib/asm-5.0..jar:/home/hadoop/app/apache-storm-1.0./lib/reflectasm-1.10..jar:jar/StormTopologyMoreExecutor.jar:/home/hadoop/app/apache-storm-1.0./conf:/home/hadoop/app/apache-storm-1.0./bin -Dstorm.jar=jar/StormTopologyMoreExecutor.jar zhouls.bigdata.stormDemo.StormTopologyMoreExecutor aaa

[main] INFO o.a.s.StormSubmitter - Generated ZooKeeper secret payload for MD5-digest: -:-

[main] INFO o.a.s.s.a.AuthUtils - Got AutoCreds []

[main] INFO o.a.s.StormSubmitter - Uploading topology jar jar/StormTopologyMoreExecutor.jar to assigned location: /home/hadoop/data/storm/nimbus/inbox/stormjar-83ebee61--4ab5-aff7-e9fcf4560f42.jar

[main] INFO o.a.s.StormSubmitter - Successfully uploaded topology jar to assigned location: /home/hadoop/data/storm/nimbus/inbox/stormjar-83ebee61--4ab5-aff7-e9fcf4560f42.jar

[main] INFO o.a.s.StormSubmitter - Submitting topology StormTopologyMoreExecutor in distributed mode with conf {"storm.zookeeper.topology.auth.scheme":"digest","storm.zookeeper.topology.auth.payload":"-7700164527916050772:-9124174655622273375"}

[main] INFO o.a.s.StormSubmitter - Finished submitting topology: StormTopologyMoreExecutor

[hadoop@master apache-storm-1.0.]$

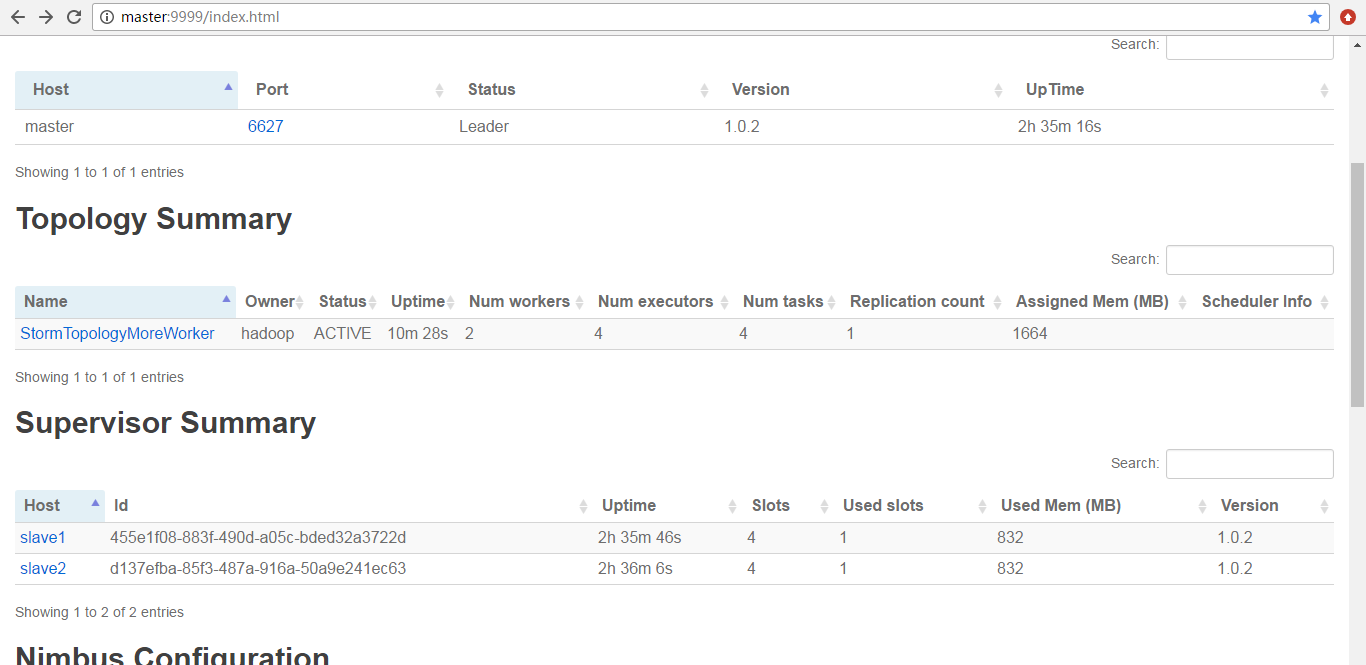

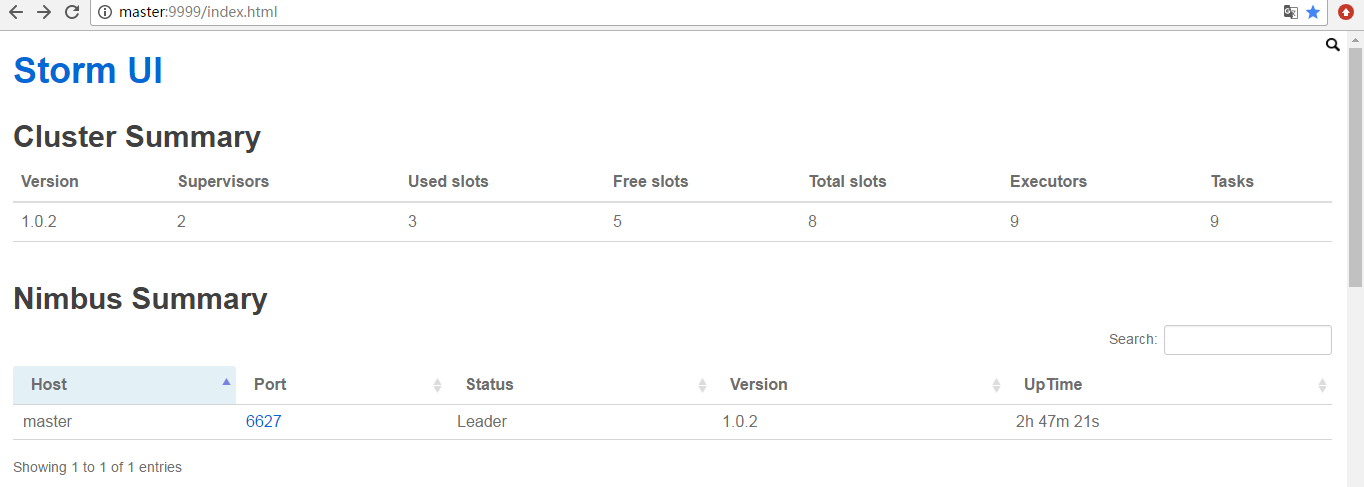

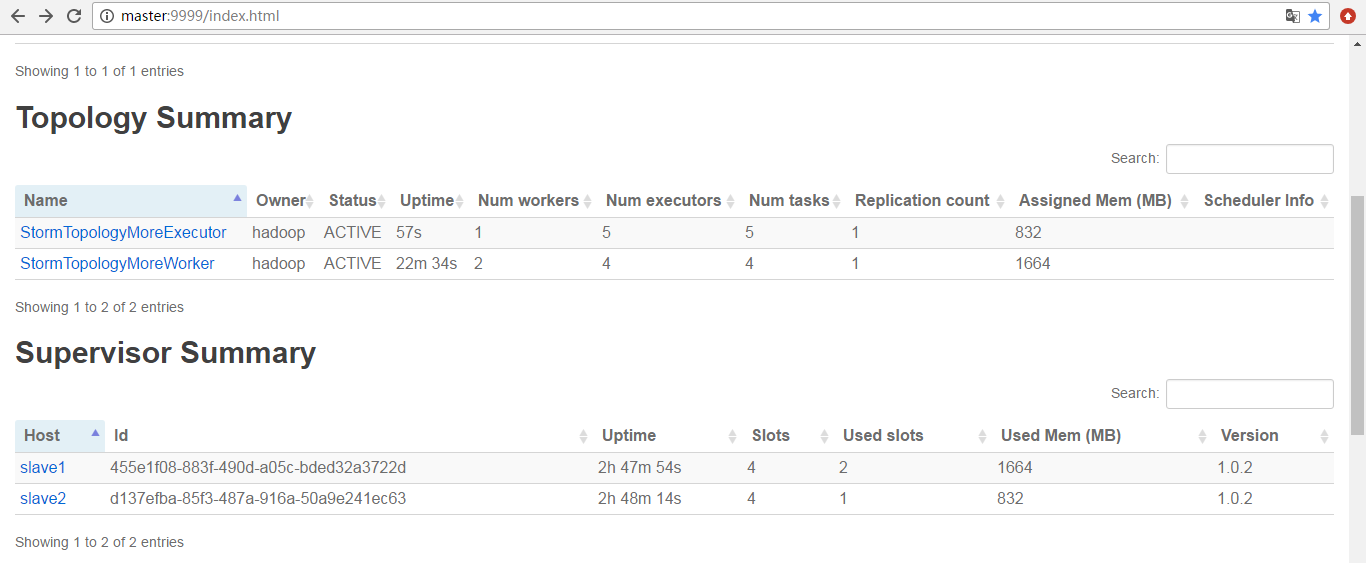

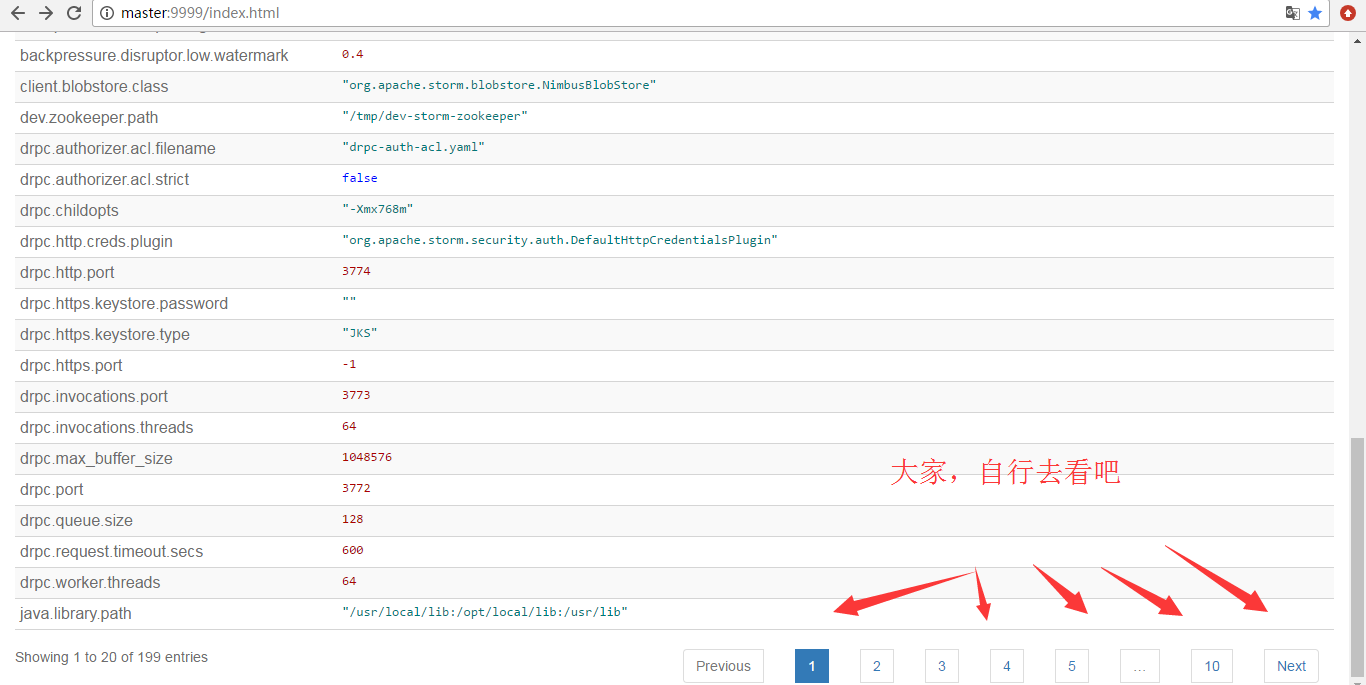

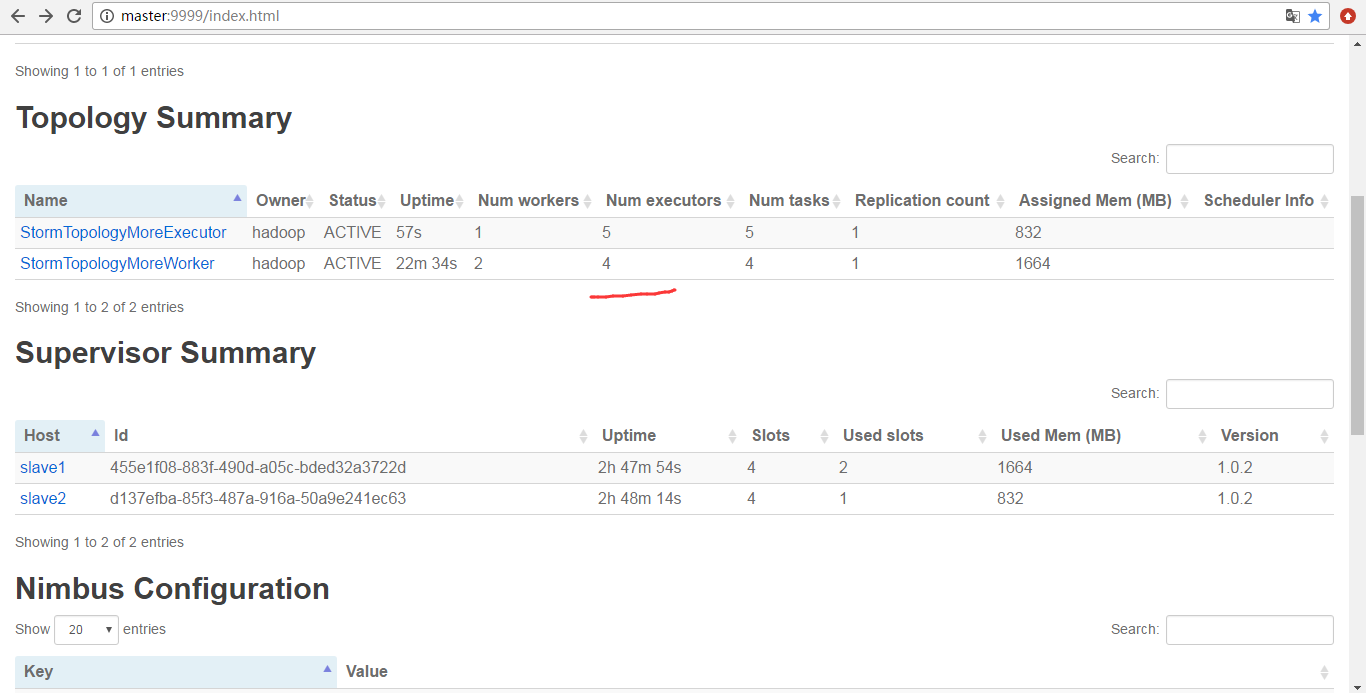

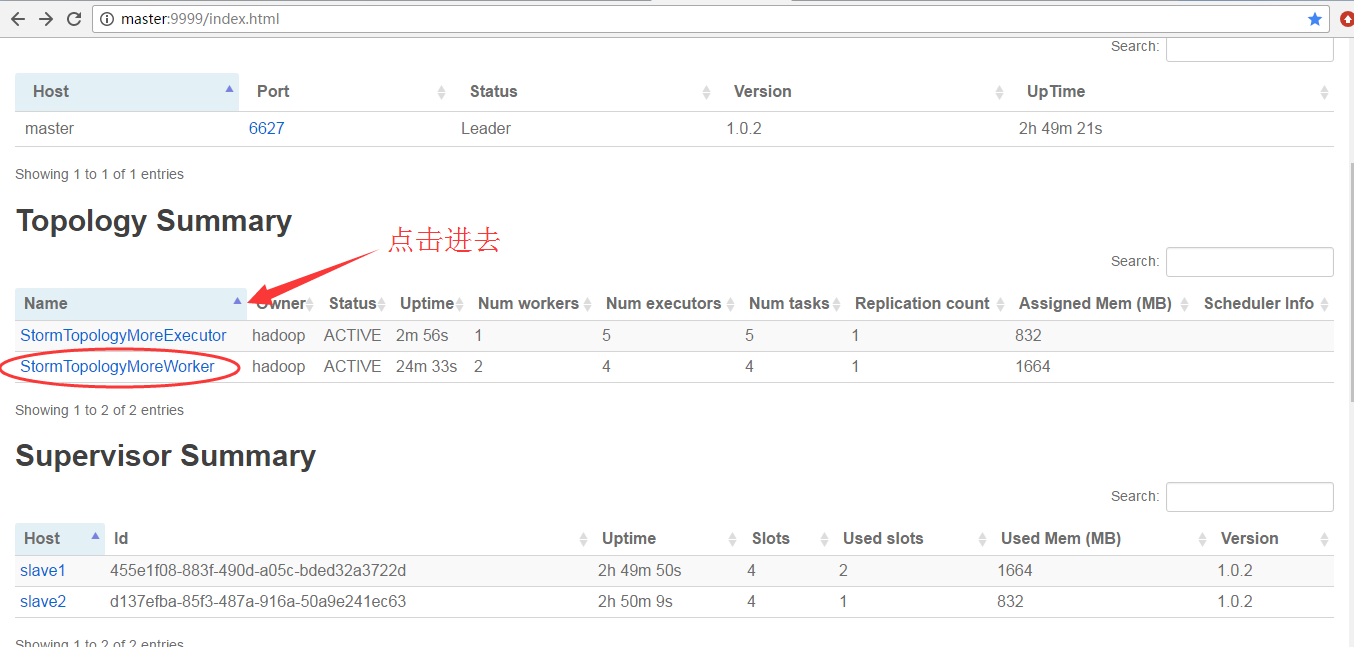

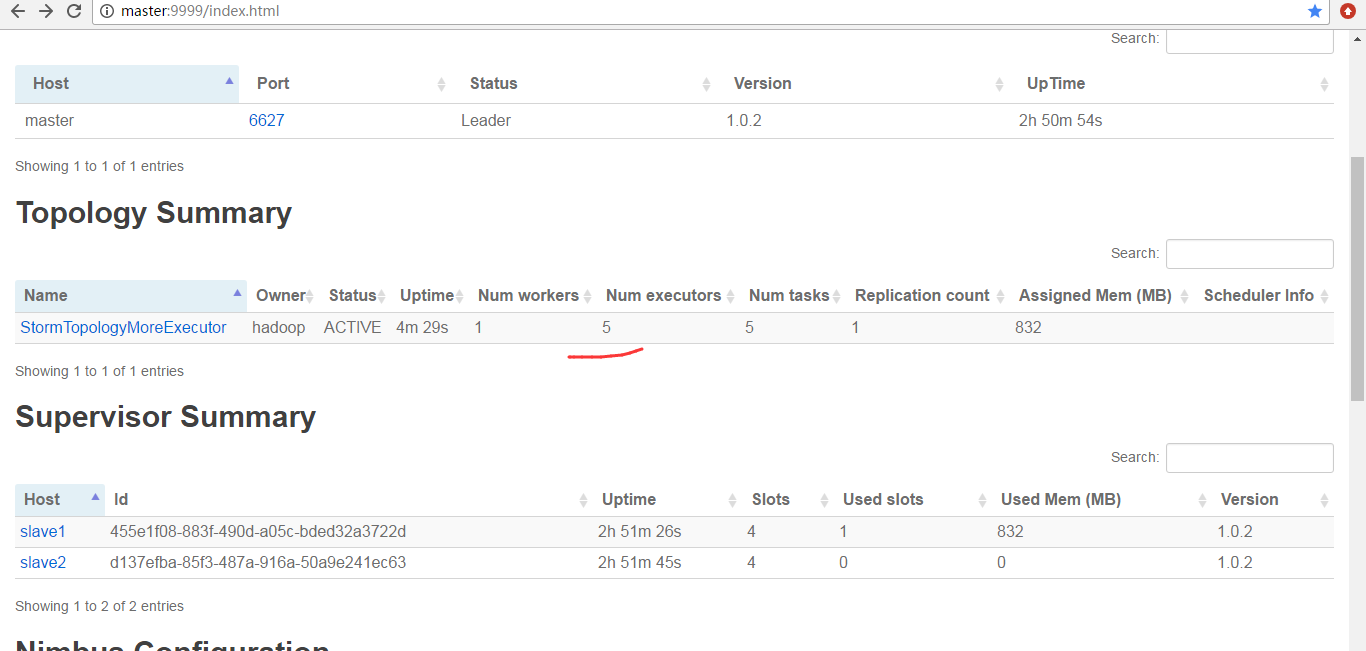

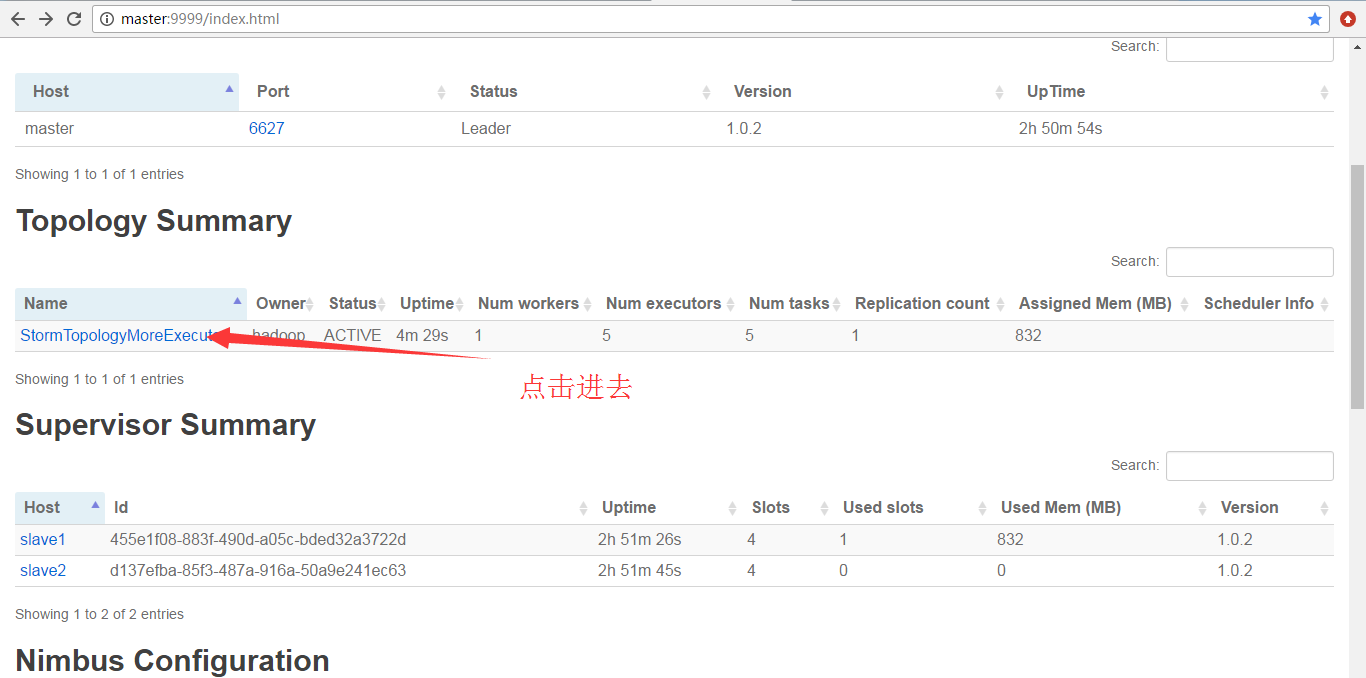

为什么,会是如上的数字呢?大家要学,就要深入去学和理解。

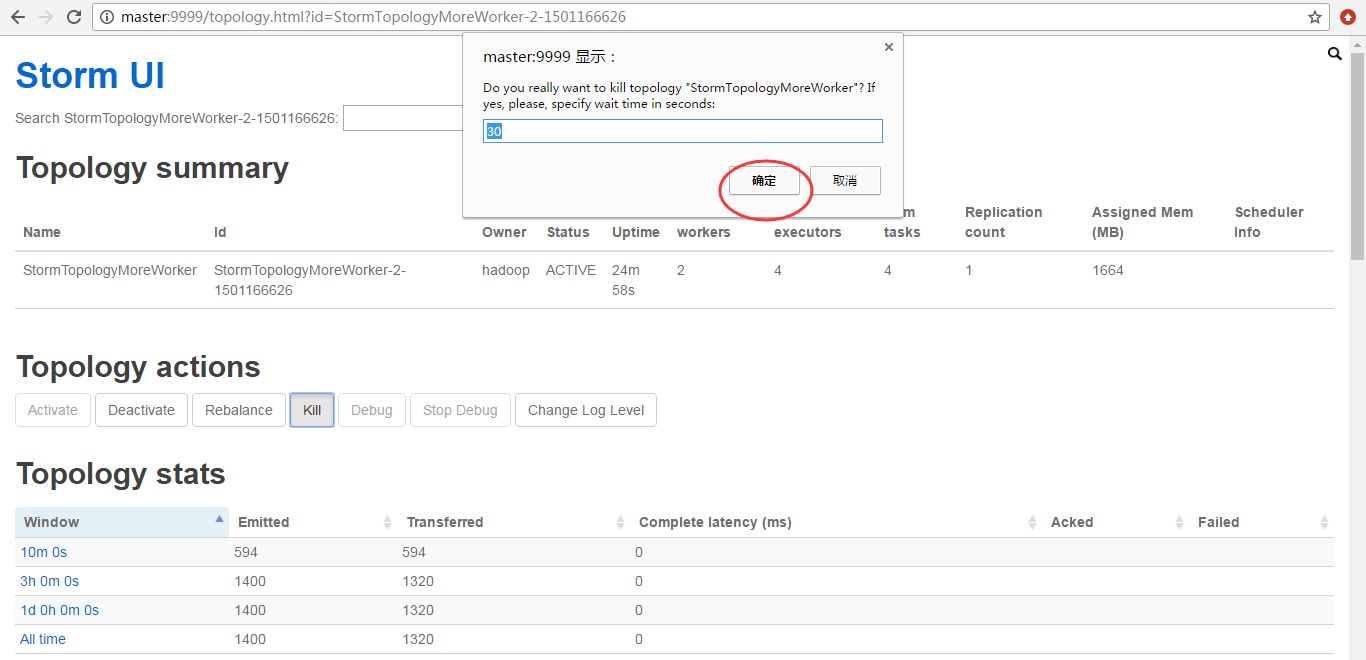

因为,我之前运行的StormTopologyMoreWorker没有停掉

为什么,会是如上的数字呢?大家要学,就要深入去学和理解。

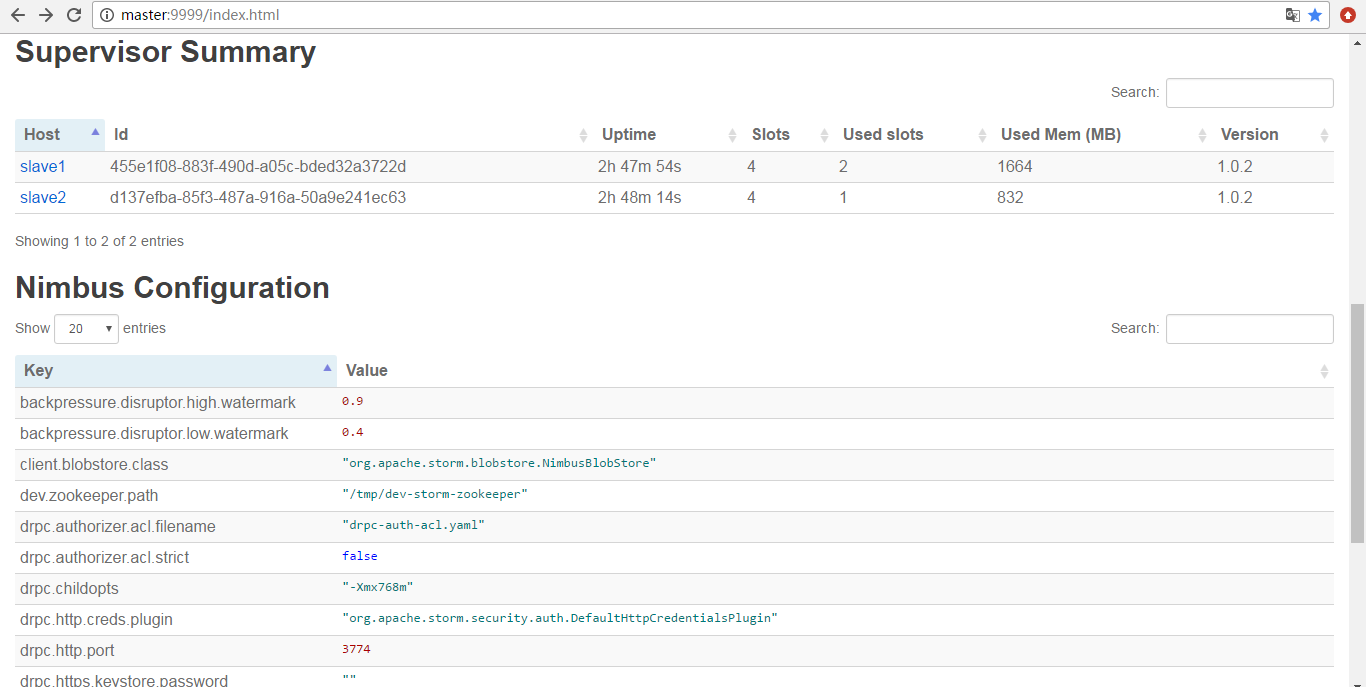

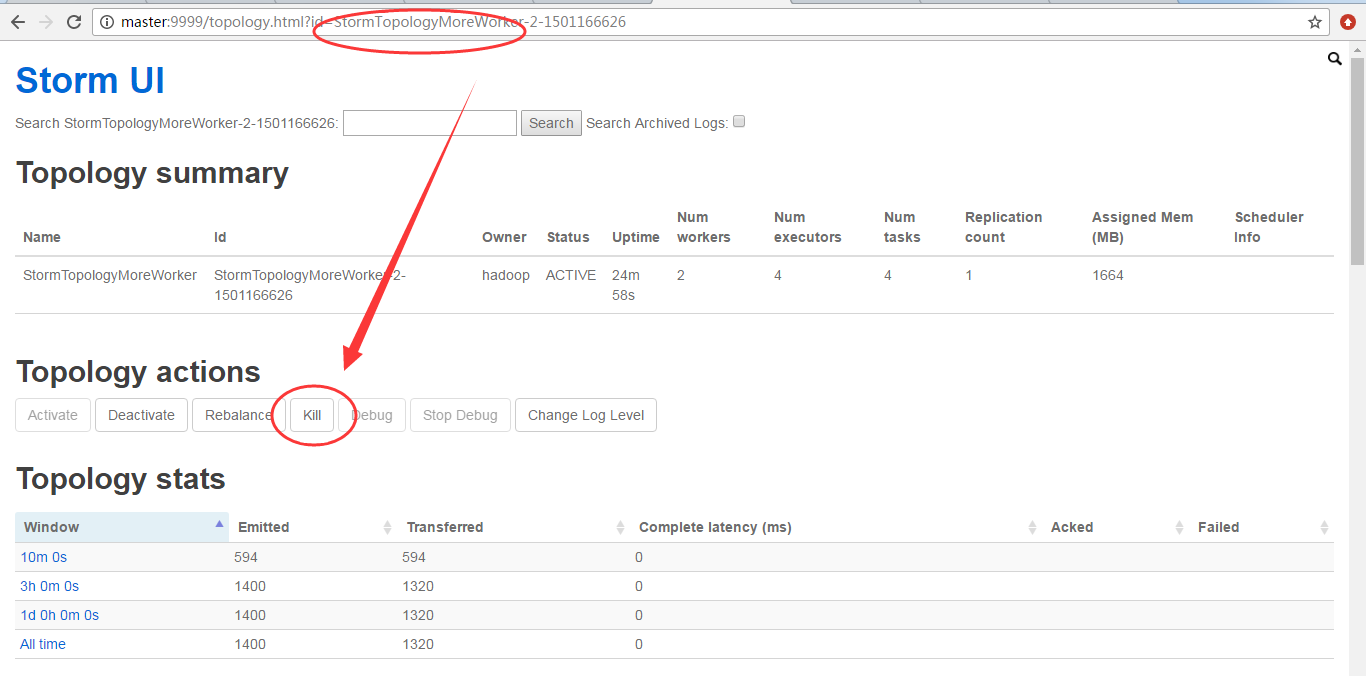

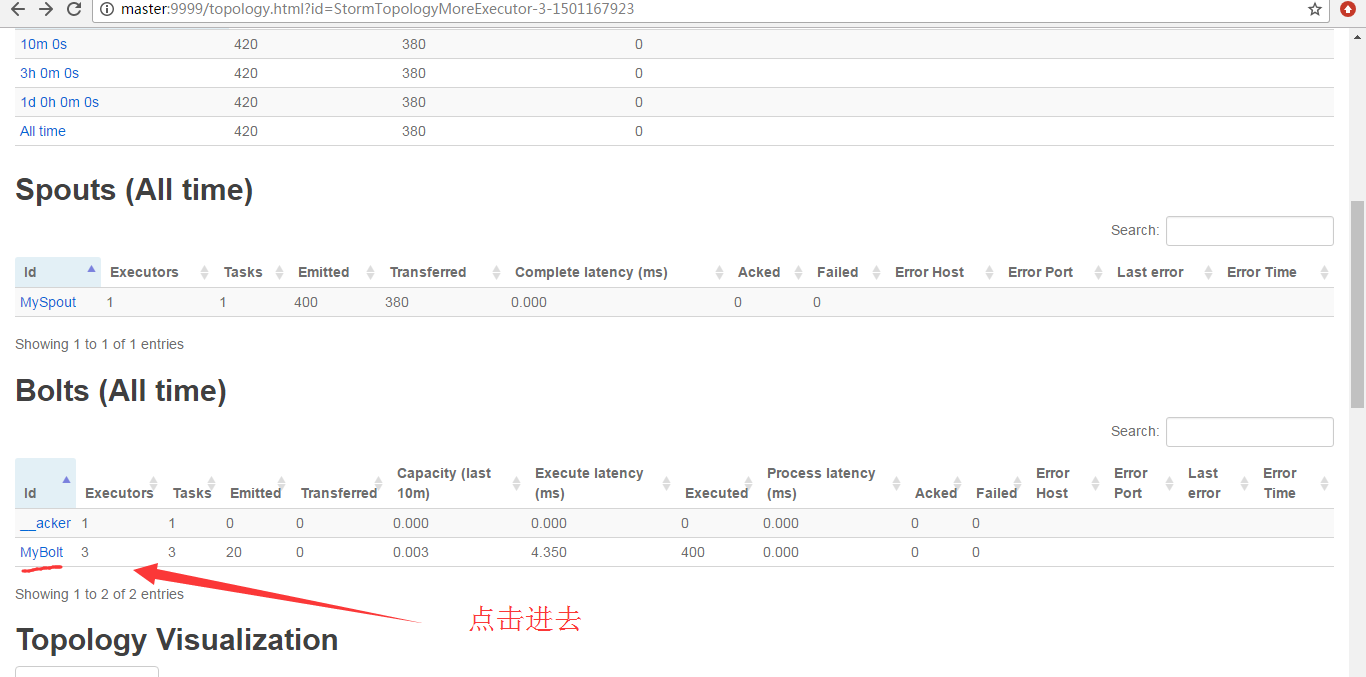

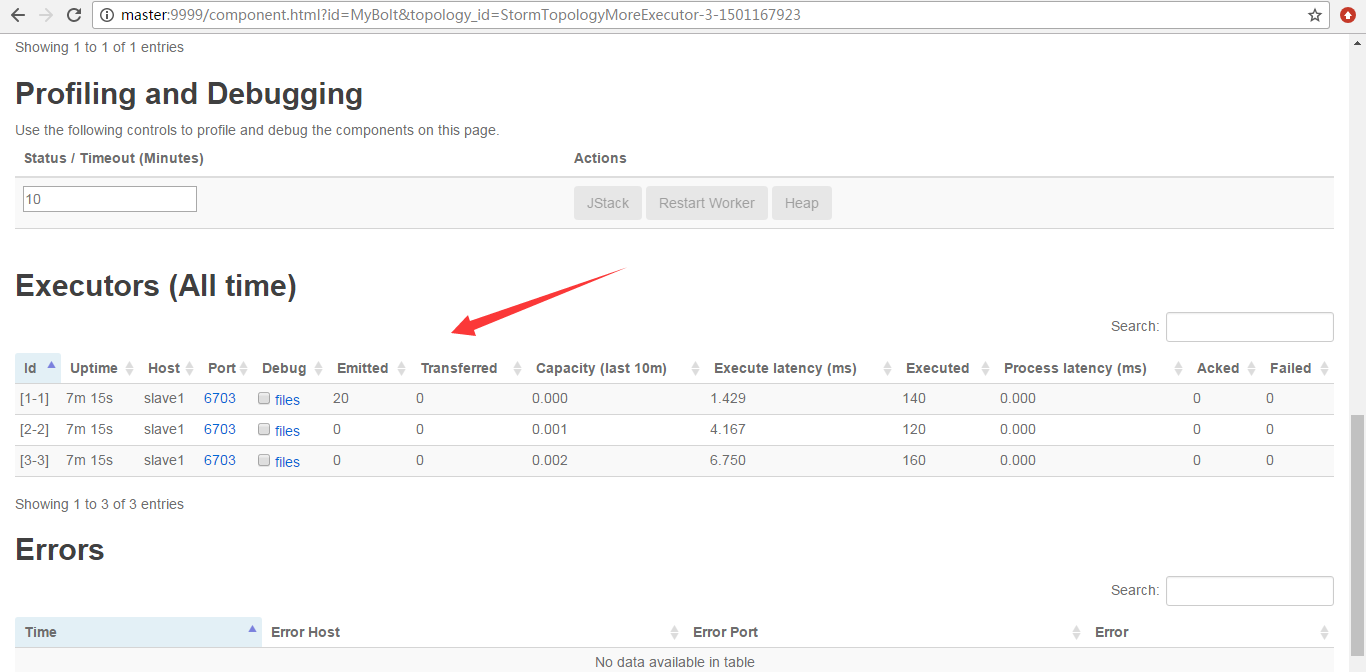

即,以下就是它的3个Executor

Storm编程入门API系列之Storm的Topology多个Executors数目控制实现的更多相关文章

- Storm编程入门API系列之Storm的Topology多个Workers数目控制实现

前期博客 Storm编程入门API系列之Storm的Topology默认Workers.默认executors和默认tasks数目 继续编写 StormTopologyMoreWorker.java ...

- Storm编程入门API系列之Storm的Topology多个tasks数目控制实现

前期博客 Storm编程入门API系列之Storm的Topology默认Workers.默认executors和默认tasks数目 Storm编程入门API系列之Storm的Topology多个Wor ...

- Storm编程入门API系列之Storm的定时任务实现

概念,见博客 Storm概念学习系列之storm的定时任务 Storm的定时任务,分为两种实现方式,都是可以达到目的的. 我这里,分为StormTopologyTimer1.java 和 Sto ...

- Storm编程入门API系列之Storm的Topology的stream grouping

概念,见博客 Storm概念学习系列之stream grouping(流分组) Storm的stream grouping的Shuffle Grouping 它是随机分组,随机派发stream里面的t ...

- Storm编程入门API系列之Storm的可靠性的ACK消息确认机制

概念,见博客 Storm概念学习系列之storm的可靠性 什么业务场景需要storm可靠性的ACK确认机制? 答:想要保住数据不丢,或者保住数据总是被处理.即若没被处理的,得让我们知道. publi ...

- Storm编程入门API系列之Storm的Topology默认Workers、默认executors和默认tasks数目

关于,storm的启动我这里不多说了. 见博客 storm的3节点集群详细启动步骤(非HA和HA)(图文详解) 建立stormDemo项目 Group Id : zhouls.bigdata Art ...

- Storm概念学习系列之storm的定时任务

不多说,直接上干货! 至于为什么,有storm的定时任务.这个很简单.但是,这个在工作中非常重要! 假设有如下的业务场景 这个spoult源源不断地发送数据,boilt呢会进行处理.然后呢,处理后的结 ...

- Storm概念学习系列之storm的可靠性

这个概念,对于理解storm很有必要. 1.worker进程死掉 worker是真实存在的.可以jps查看. 正是因为有了storm的可靠性,所以storm会重新启动一个新的worker进程. 2.s ...

- 第1节 storm编程:2、storm的基本介绍

课程大纲: 1.storm的基本介绍 2.storm的架构模型 3.storm的安装 4.storm的UI管理界面 5.storm的编程模型 6.storm的入门程序 7.storm的并行度 8.st ...

随机推荐

- Java Web 项目打包脚本

可用于 (但不限于) Eclipse 项目. 一次性生成:1. Java doc .zip 包:2. Java 源代码 .zip 包:3. Java 二进制文件 .jar 包:4. Java 源代码加 ...

- 简单数位DP

https://cn.vjudge.net/problem/HDU-4722 懒得写看,代码注释吧;主要存板子 #include <cstdio> #include <cstring ...

- Persistent connections CONN_MAX_AGE django

Persistent connections¶ Persistent connections avoid the overhead of re-establishing a connection to ...

- NMS 原理 了解

NMS 原理:对于Bounding Box的列表B及其对应的置信度S,采用下面的计算方式.选择具有最大score的检测框M,将其从B集合中移除并加入到最终的检测结果D中.通常将B中剩余检测框中与M的I ...

- Tinyplay

android里面的目录:external/tinyalsa 编译: 1. cd external/tinyalsa/ 2. vi Android.mk 3. mmm . 4. 拷贝出可执行文件 执行 ...

- Code:NFine目录

ylbtech-Code:NFine目录 1.返回顶部 2.返回顶部 3.返回顶部 4.返回顶部 5.返回顶部 6.返回顶部 作者:ylbtech出处:http://ylb ...

- kvm详细介绍

KVM详解,太详细太深入了,经典 2016-07-18 19:56:38 分类: 虚拟化 原文地址:KVM详解,太详细太深入了,经典 作者:zzjlzx KVM 介绍(1):简介及安装 http:// ...

- 转载 关于启用HTTPS的一些经验分享

本文转载自 https://imququ.com/post/sth-about-switch-to-https.html 随着国内网络环境的持续恶化,各种篡改和劫持层出不穷,越来越多的网站选择了全站 ...

- CSS动画的性能分析和浏览器GPU加速

此文已由作者袁申授权网易云社区发布. 欢迎访问网易云社区,了解更多网易技术产品运营经验. 有数的数据大屏可以在一块屏幕上展示若干张不同的图表,以炫酷的方式展示各种业务数据.其中有些图表使用CSS实现了 ...

- 牛客 - 700I - Matrix Again - 二维RMQ - 二分

https://ac.nowcoder.com/acm/contest/700/I 二维RMQ,贴个板子,注意爆内存,用char就可以了,char也可以存负数. 然后二分枚举对角线长度,理由很简单. ...