Spark之开窗函数

一.简介

开窗函数row_number()是按照某个字段分组,然后取另外一个字段排序的前几个值的函数,相当于分组topN。如果SQL语句里面使用了开窗函数,那么这个SQL语句必须使用HiveContext执行。

二.代码实践【使用HiveContext】

package big.data.analyse.sparksql

import org.apache.log4j.{Level, Logger}

import org.apache.spark.sql.types.{IntegerType, StringType, StructField, StructType}

import org.apache.spark.sql.{Row, SparkSession}

/**

* Created by zhen on 2019/7/6.

*/

object RowNumber {

/**

* 设置日志级别

*/

Logger.getLogger("org").setLevel(Level.WARN)

def main(args: Array[String]) {

/**

* 创建spark入口,支持Hive

*/

val spark = SparkSession.builder().appName("RowNumber")

.master("local[2]").enableHiveSupport().getOrCreate()

/**

* 创建测试数据

*/

val array = Array("1,Hadoop,12","5,Spark,6","3,Solr,15","3,HBase,8","6,Hive,16","6,TensorFlow,26")

val rdd = spark.sparkContext.parallelize(array).map{ row =>

val Array(id, name, age) = row.split(",")

Row(id, name, age.toInt)

}

val structType = new StructType(Array(

StructField("id", StringType, true),

StructField("name", StringType, true),

StructField("age", IntegerType, true)

))

/**

* 转化为df

*/

val df = spark.createDataFrame(rdd, structType)

df.show()

df.createOrReplaceTempView("technology")

/**

* 应用开窗函数row_number

* 注意:开窗函数只能在hiveContext下使用

*/

val result_1 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top <= 1")

result_1.show()

val result_2 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top <= 2")

result_2.show()

val result_3 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top <= 3")

result_3.show()

val result_4 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top > 3")

result_4.show()

}

}

三.结果【使用HiveContext】

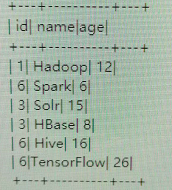

1.初始数据

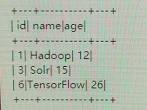

2.top<=1时

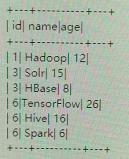

3.top<=2时

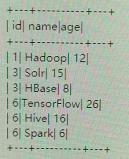

4.top<=3时

5.top>3时【分组中最大为3】

四.代码实现【不使用HiveContext】

package big.data.analyse.sparksql

import org.apache.log4j.{Level, Logger}

import org.apache.spark.sql.types.{IntegerType, StringType, StructField, StructType}

import org.apache.spark.sql.{Row, SparkSession}

/**

* Created by zhen on 2019/7/6.

*/

object RowNumber {

/**

* 设置日志级别

*/

Logger.getLogger("org").setLevel(Level.WARN)

def main(args: Array[String]) {

/**

* 创建spark入口,不支持Hive

*/

val spark = SparkSession.builder().appName("RowNumber")

.master("local[2]").getOrCreate()

/**

* 创建测试数据

*/

val array = Array("1,Hadoop,12","5,Spark,6","3,Solr,15","3,HBase,8","6,Hive,16","6,TensorFlow,26")

val rdd = spark.sparkContext.parallelize(array).map{ row =>

val Array(id, name, age) = row.split(",")

Row(id, name, age.toInt)

}

val structType = new StructType(Array(

StructField("id", StringType, true),

StructField("name", StringType, true),

StructField("age", IntegerType, true)

))

/**

* 转化为df

*/

val df = spark.createDataFrame(rdd, structType)

df.show()

df.createOrReplaceTempView("technology")

/**

* 应用开窗函数row_number

* 注意:开窗函数只能在hiveContext下使用

*/

val result_1 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top <= 1")

result_1.show()

val result_2 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top <= 2")

result_2.show()

val result_3 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top <= 3")

result_3.show()

val result_4 = spark.sql("select id,name,age from (select id,name,age," +

"row_number() over (partition by id order by age desc) top from technology) t where t.top > 3")

result_4.show()

}

}

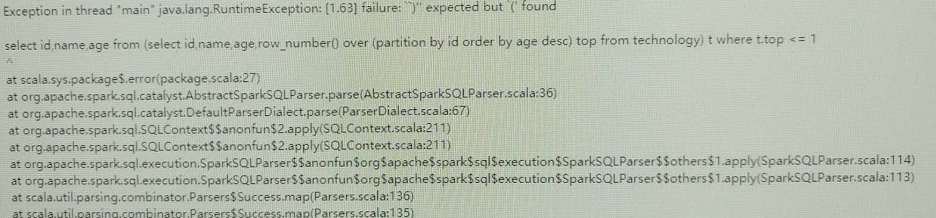

五.结果【不使用HiveContext】

Spark之开窗函数的更多相关文章

- 【Spark篇】---SparkSQL中自定义UDF和UDAF,开窗函数的应用

一.前述 SparkSQL中的UDF相当于是1进1出,UDAF相当于是多进一出,类似于聚合函数. 开窗函数一般分组取topn时常用. 二.UDF和UDAF函数 1.UDF函数 java代码: Spar ...

- Spark(十三)SparkSQL的自定义函数UDF与开窗函数

一 自定义函数UDF 在Spark中,也支持Hive中的自定义函数.自定义函数大致可以分为三种: UDF(User-Defined-Function),即最基本的自定义函数,类似to_char,to_ ...

- spark开窗函数

源文件内容示例: http://bigdata.beiwang.cn/laoli http://bigdata.beiwang.cn/laoli http://bigdata.beiwang.cn/h ...

- 【Spark-SQL学习之三】 UDF、UDAF、开窗函数

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk1.8 scala-2.10.4(依赖jdk1.8) spark ...

- SparkSQL开窗函数 row_number()

开始编写我们的统计逻辑,使用row_number()函数 先说明一下,row_number()开窗函数的作用 其实就是给每个分组的数据,按照其排序顺序,打上一个分组内行号 比如说,有一个分组20151 ...

- 开窗函数 First_Value 和 Last_Value

在Sql server 2012里面,开窗函数丰富了许多,其中带出了2个新的函数 First_Value 和 Last Value .现在来介绍一下这2个函数的应用场景. 首先分析一下First_Va ...

- Oracle开窗函数 over()(转)

copy文链接:http://blog.csdn.net/yjjm1990/article/details/7524167#,http://www.2cto.com/database/201402/2 ...

- oracle的分析函数over 及开窗函数

转:http://www.2cto.com/database/201310/249722.html oracle的分析函数over 及开窗函数 一:分析函数over Oracle从8.1.6开 ...

- 开窗函数 --over()

一个学习性任务:每个人有不同次数的成绩,统计出每个人的最高成绩. 这个问题应该还是相对简单,其实就用聚合函数就好了. select id,name,max(score) from Student gr ...

随机推荐

- <c:forEach>, <c:forTokens> 标签

这些标签封装了Java中的for,while,do-while循环. 相比而言,<c:forEach>标签是更加通用的标签,因为它迭代一个集合中的对象. <c:forTokens&g ...

- C# INI配置文件读写类

ini是一种很古老的配置文件,C#操作ini文件借助windows底层ini操作函数,使用起来很方便: public class IniHelper { [DllImport("kernel ...

- Des加解密工具

import java.security.Key; import java.security.Security; import java.util.Date; import javax.crypto. ...

- Linux的.a、.so和.o文件 对比 window下的dll,lib,exe文件

连续几天终于将一个又一个问题解决了,这里说其中一个问题 描述问题:使用多线程pthread的时候,(我用的IDE,CODEBOLCKS)编译后发现直接弹出窗口,程序还没有被Build..巴拉巴拉,然后 ...

- spark笔记 环境配置

spark笔记 spark简介 saprk 有六个核心组件: SparkCore.SparkSQL.SparkStreaming.StructedStreaming.MLlib,Graphx Spar ...

- (CSDN迁移) jFinal无法启动_JFinalDemoGenerator问题解决办法

Eclipse -> 项目右键 -> Build Path -> Config Build Path -> Source -> Add Folder, 将a_little ...

- 关于jQuery请求后台成功一直走error回调函数问题

如果dataType声明与响应不符就会进入error回调.就算接口请求成功,也是走error回调函数.

- Cannot get a STRING value from a NUMERIC cell问题的解决办法

遇到以下错误的解决办法: 在cell加个setCellType()方法就可以了 cell.setCellType(CellType.STRING);

- Spring 通过@Import实现Bean的注册

今天看到一个神奇的用法, Spring可以通过@Import导入实现了ImportBeanDefinitionRegistrar接口的类来注册那个类. ImportBeanDefinitionRegi ...

- 前端向后端获取数据的三种方法:ajax、axios、fetch

1.jQuery中的ajax get方法: $.ajax({ url:"v4/api/film/now-playing?t=1539401039415&page=1&coun ...