爬虫,爬取景点信息采用pandas整理数据

一、首先需要导入我们的库函数

导语:通过看网上直播学习得到,如有雷同纯属巧合。

import requests#请求网页链接

import pandas as pd#建立数据模型

from bs4 import BeautifulSoup

import io

import sys#防止乱码

sys.stdout=io.TextIOWrapper(sys.stdout.buffer,encoding='gb18030')

注:如有库安装不了,可参考上一篇随笔。

二、源代码:

1 import requests

import pandas as pd

from bs4 import BeautifulSoup

import io

import sys#防止乱码

sys.stdout=io.TextIOWrapper(sys.stdout.buffer,encoding='gb18030')

def get_url(n):

#获取网页链接

urls=[]

for i in range(1,n+1):

urls.append('https://travel.qunar.com/p-cs299878-shanghai-jingdian-1-%s' %i)#获取n段网页链接

return urls pass def get_data(url):#获取一段网页链接的数据

r=requests.get(url)

soup=BeautifulSoup(r.text,'lxml')#lxml一种不错的编译器

ul=soup.find('ul',class_='list_item clrfix')#在网页中通过查找元素信息找到其名称

lis=ul.find_all('li')#查找所有信息

datalst=[]#定义一个数据字典

for li in lis:

dic={}#将需要查找的信息写入数据字典

dic['景点名称']=li.find('span',class_='cn_tit').text

dic['星级']=li.find('span',class_='cur_star')['style'].split(':')[1].replace('%','')#将数据中的百分号去掉实现初步数据清洗

dic['经度']=li['data-lng']

dic['纬度']=li['data-lat']

datalst.append(dic)

return datalst def get_alldata(n):#按要求查找多段网页链接的数据

alldata=[]

for url in get_url(n):

alldata.extend(get_data(url))

return alldata

#print(get_alldata(2))

df=pd.DataFrame(get_alldata(2))#建立pandas模型,按要求输出

print(df)

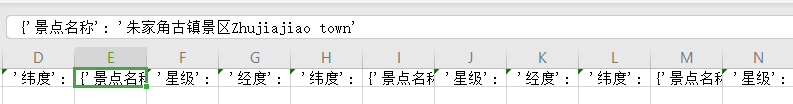

三、运行结果:

四、存储:

这里采用csv存储,在获取信息时写入以下代码把取得的信息写入表格中。

def get_alldata(n):

alldata=[]

for url in get_url(n):

alldata.extend(get_data(url))

alldata=[str(x) for x in alldata]

with open('describe.csv','a',encoding='utf8')as f:#在自己的运行目录下新建一个csv后缀名的文件夹然后打开以读写的方式

f.write(','.join('%s' %id for id in alldata))#为了防止数字转字符串出错首先逐个遍历我们的列表然后再写入

f.close()#操作完成应记住关闭文件夹。

return alldata

运行结果:

如上图所示数据已成功写入csv文件夹中。

小有瑕疵,初学见谅!!!

爬虫,爬取景点信息采用pandas整理数据的更多相关文章

- python爬虫爬取get请求的页面数据代码样例

废话不多说,上代码 #!/usr/bin/env python # -*- coding:utf-8 -*- # 导包 import urllib.request import urllib.pars ...

- 用Python写爬虫爬取58同城二手交易数据

爬了14W数据,存入Mongodb,用Charts库展示统计结果,这里展示一个示意 模块1 获取分类url列表 from bs4 import BeautifulSoup import request ...

- Python爬虫爬取异步加载的数据

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理.作者:努力努力再努力 爬取qq音乐歌手数据接口数据 https://y.qq ...

- 养只爬虫当宠物(Node.js爬虫爬取58同城租房信息)

先上一个源代码吧. https://github.com/answershuto/Rental 欢迎指导交流. 效果图 搭建Node.js环境及启动服务 安装node以及npm,用express模块启 ...

- (转)Python网络爬虫实战:世纪佳缘爬取近6万条数据

又是一年双十一了,不知道从什么时候开始,双十一从“光棍节”变成了“双十一购物狂欢节”,最后一个属于单身狗的节日也成功被攻陷,成为了情侣们送礼物秀恩爱的节日. 翻着安静到死寂的聊天列表,我忽然惊醒,不行 ...

- MATLAB爬虫爬取股票数据

近年来,大数据盛行,有关爬虫的教程层次不穷.那么,爬虫到底是什么呢? 什么是爬虫? 百度百科是这样定义的: 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种 ...

- 爬虫爬数据时,post数据乱码解决办法

最近在写一个爬虫,目标网站是:http://zx.bjmemc.com.cn/,可能是为了防止被爬取数据,它给自身数据加了密.用谷歌自带的抓包工具也不能捕获到数据.于是下了Fiddler. F ...

- 爬虫(二)Python网络爬虫相关基础概念、爬取get请求的页面数据

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程. 哪些语言可以实现爬虫 1.php:可以实现爬虫.php被号称是全世界最优美的语言(当然是其自己号称的,就是王婆 ...

- Python网络爬虫第三弹《爬取get请求的页面数据》

一.urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib. ...

随机推荐

- nginx rewrite重写规则简明笔记

nginx rewrite重写规则简明笔记 比方说http://newmiracle.cn/?p=888我要改成能这个访问http://newmiracle.cn/p888/ 首先用正则获取888 ^ ...

- vuex 源码分析(七) module和namespaced 详解

当项目非常大时,如果所有的状态都集中放到一个对象中,store 对象就有可能变得相当臃肿. 为了解决这个问题,Vuex允许我们将 store 分割成模块(module).每个模块拥有自己的 state ...

- .Net轻松处理亿级数据--clickhouse及可视化界面安装介绍

该篇内容由个人博客点击跳转同步更新!转载请注明出处! 前言 我是在17年就听说过Clickhouse,那时还未接触过亿数据的运算,那时我在的小公司对于千万数据的解决方案还停留在分库分表,最好的也是使用 ...

- Sitecore 8.2 渠道简介

渠道是联系人通过广告系列或面对面与您的品牌互动时所使用的路径.联系人可以通过手机上的应用与您的品牌互动,点击社交网络上的广告访问您的网站,或访问实体店购买商品.使用Sitecore体验平台,您可以使用 ...

- Spring源码系列 — Envoriment组件

何为Envoriment Envoriment是集成在Spring上下文容器中的核心组件,在Spring源码中由Envoriment接口抽象. 在Environment中,有两大主要概念: Profi ...

- 2019-3-20-UWP-How-to-custom-RichTextBlock-right-click-menu

原文:2019-3-20-UWP-How-to-custom-RichTextBlock-right-click-menu title author date CreateTime categorie ...

- px与em的区别

PX特点:px像素(Pixel).相对长度单位.像素px是相对于显示器屏幕分辨率而言的.EM特点 1. em的值并不是固定的:2. em会继承父级元素的字体大小.

- 关于css中布局遇到的一些问题

现在本人初学网页布局经常遇到一些布局问题比如图片错位. 遇到的问题以及解决方案如下 行内元素有缝隙 块级元素没有缝隙 行内块元素中间会有小缝隙 常见的解决办法就是浮动

- Vue.js 源码分析(七) 基础篇 侦听器 watch属性详解

先来看看官网的介绍: 官网介绍的很好理解了,也就是监听一个数据的变化,当该数据变化时执行我们的watch方法,watch选项是一个对象,键为需要观察的数据名,值为一个表达式(函数),还可以是一个对象, ...

- 【原创】Talend 配置SSL支持gitlab

背景 talend的源代码控制用的是gitlab,以前都是http方式的,但是最近突然改了https,所以talend登录失败,必须要SSL方式才能获取到分支等数据,才能提交代码. 证书导入 1.ta ...