java 爬虫:开源java爬虫 swing工具 Imgraber

1实现点:

- 1.返回给定URL网页内,所有图像url list

- 2.返回给定URL网页内,自动生成图像文件路径.txt 文件

- 3.返回给定URL网页内,下载txt文件指定的图片url,并将所有图像保存在 ./img文件夹下

- 4.实现简易swing 界面,有空再改造

2基于开源jsoup实现,鸣谢!

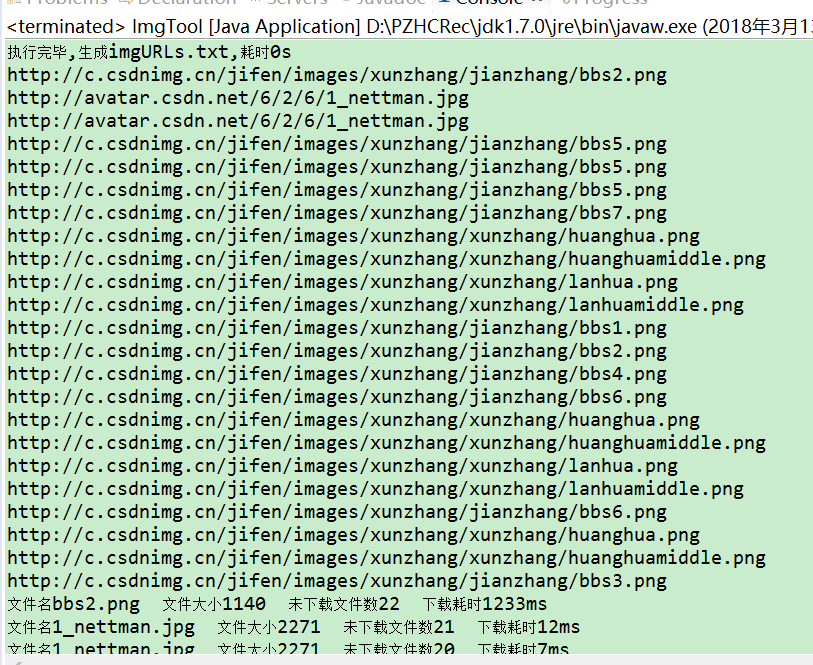

效果

github

package himi.crawler;

import java.io.BufferedInputStream;

import java.io.BufferedOutputStream;

import java.io.BufferedReader;

import java.io.BufferedWriter;

import java.io.File;

import java.io.FileOutputStream;

import java.io.FileReader;

import java.io.FileWriter;

import java.io.IOException;

import java.io.InputStream;

import java.io.OutputStream;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

import org.jsoup.Jsoup;

import org.jsoup.helper.StringUtil;

import org.jsoup.nodes.Document;

import org.jsoup.select.Elements;

/**

*

* @ClassName: ImgTool

* @Description:IMG tool ,请先赋值URL 获取指定ULR的某个网页里面

* 1.返回所有图像url list

* 2.图像文件夹路径.txt

* 3.所有图像保存在img文件夹里面

* @author penny

* @date 2018年3月7日 下午10:07:49

*

*/

public class ImgTool {

// 参数域

/** 指定URL */

public static String URL = "https://www.oschina.net";

private int imgNumbs = 0;

public static List<String> downloadMsg=new ArrayList<String>();

public String imgUrlTxt = "imgURLs.txt";

public static String regex= "^((https|http|ftp|rtsp|mms)?://)"

+ "?(([0-9a-z_!~*'().&=+$%-]+: )?[0-9a-z_!~*'().&=+$%-]+@)?" //ftp的user@

+ "(([0-9].)[0-9]" // IP形式的URL- 199.194.52.184

+ "|" // 允许IP和DOMAIN(域名)

+ "([0-9a-z_!~*'()-]+.)*" // 域名-

+ "([0-9a-z][0-9a-z-])?[0-9a-z]." // 二级域名

+ "[a-z])" // first level domain- .com or .museum

+ "(:[0-9])?" // 端口- :80

+ "((/?)|" // a slash isn't required if there is no file name

+ "(/[0-9a-z_!~*'().;?:@&=+$,%#-]+)+/?)$";

private ImgTool() {

};

private static ImgTool instance = new ImgTool();

/** 获取ImgTool 单例 */

public static ImgTool getInstance() {

return instance;

}

public List<String> getURLs() {

return getURLs(null);

}

public boolean isURL(String str) {

if(StringUtil.isBlank(str)){

return false;

}else{

// String regex = "^(?:https?://)?[\\w]{1,}(?:\\.?[\\w]{1,})+[\\w-_/?&=#%:]*$";

// String regex = "^([hH][tT]{2}[pP]:/*|[hH][tT]{2}[pP][sS]:/*|[fF][tT][pP]:/*)(([A-Za-z0-9-~]+).)+([A-Za-z0-9-~\\/])+(\\?{0,1}(([A-Za-z0-9-~]+\\={0,1})([A-Za-z0-9-~]*)\\&{0,1})*)$";

Pattern pattern = Pattern.compile(regex);

Matcher matcher = pattern.matcher(str);

if(matcher.matches()){

return true;

}else{

return false;

}

}};

/***

* @Title: getURLs

* @Description: 给定cssQuery对象

* @param @param cssQuery HTML中的CSS(或者 JQuery)选择器语法,更多详细用法见Jsoup介绍 < a

* href="https://jsoup.org/apidocs/org/jsoup/select/Selector.html"

* ></a>

* @param @return List

* @throws

*

*/

public List<String> getURLs(String cssQuery) {

List<String> urls = null;

Document doc;

Elements imgElements ;

if (!isURL(URL)) {

return null;

}

if(StringUtil.isBlank(cssQuery)){

cssQuery="img";

}

try {

doc = Jsoup.connect(URL).get();

} catch (IOException e) {

e.printStackTrace();

return null;

}

if(doc==null)return null;

imgElements = doc.select(cssQuery);

urls = new ArrayList<String>();

for (Object eleObj : imgElements) {

//"(https?|ftp|http)://[-A-Za-z0-9+&@#/%?=~_|!:,.;]+[-A-Za-z0-9+&@#/%=~_|]"

Pattern pattern = Pattern.compile("(https?|http)://[-A-Za-z0-9+&@#/%?=~_|!:,.;]+[-A-Za-z0-9+&@#/%=~_|]");

Matcher matcher = pattern.matcher(eleObj.toString());

if (matcher.find()) {

String url = matcher.group();

urls.add(url);

}

}

imgNumbs = imgElements.size();

return urls;

}

/**

*

* @Title: createImgURLTxt

* @Description:

* @param @param cssQuery:默认使用img HTML中的CSS(或者 JQuery)选择器语法,更多详细用法见Jsoup介绍 <

* a href="https://jsoup.org/apidocs/org/jsoup/select/Selector.html">

* </a>

* @throws 生成imgURLs.txt

*/

public String createImgURLTxt(String cssQuery) {

long start = System.currentTimeMillis();

List<String> urls;

urls = getURLs(cssQuery);

BufferedWriter os = null;

File urlsFiles = new File("imgURLs.txt");

if(urlsFiles.exists()){

try {

urlsFiles.createNewFile();

} catch (IOException e) {

e.printStackTrace();

}

}

try {

os = new BufferedWriter(new FileWriter(urlsFiles));

if(urls==null)return null;

for (int i = 0; i < urls.size(); i++) {

os.write(urls.get(i) + "\n");

}

String result = "执行完毕,生成imgURLs.txt,耗时"

+ (System.currentTimeMillis() - start) / 1000 + "s";

System.out.println(result);

return result;

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

if (os != null)

os.close();

} catch (IOException e) {

e.printStackTrace();

}

}

return null;

}

/**

*

* @Title: createImgs

* @Description:

* @param @param cssQuery

* @param @throws IOException

* @throws

*/

public void createImgs(String cssQuery) throws IOException {

long startTime = System.currentTimeMillis();

downloadMsg.add("Your images is downloading ");

BufferedReader br = null;

OutputStream out = null;

InputStream in = null;

ArrayList<String> imgList = null;

HttpURLConnection con = null;

String url; //待下载文件url

int fileSize = 0; //单个文件大小

int totalFileNum=0; //总文件数

int downLoadFileNum=0; //已下载文件

long totalTime=0; //总耗时/s

long singleTime=0; //单个文件耗时/ms

br = new BufferedReader(new FileReader(imgUrlTxt));

imgList = new ArrayList<String>();

while ((url = br.readLine()) != null) {

imgList.add(url);

}

downLoadFileNum=totalFileNum= imgList.size();

downloadMsg.add("总文件数"+(totalFileNum));

for (String listUrl : imgList) {

startTime = System.currentTimeMillis();

String fileName = listUrl.substring(listUrl.lastIndexOf('/') + 1);// 截取文件名

URL imgUrl = new URL(listUrl.trim());

if (con != null)

con.disconnect();

con = (HttpURLConnection) imgUrl.openConnection();

con.setRequestMethod("GET");

con.setDoInput(true);

con.setConnectTimeout(1000 * 30);

con.setReadTimeout(1000 * 30);

fileSize = con.getContentLength();

con.connect();

try {

in = con.getInputStream();

File file = new File("img" + File.separator, fileName);

if (!file.exists()) {

file.getParentFile().mkdirs();

file.createNewFile();

}

out = new BufferedOutputStream(new FileOutputStream(file));

int len = 0;

byte[] buff = new byte[1024 * 1024];

while ((len = new BufferedInputStream(in).read(buff)) != -1) {

out.write(buff, 0, len);

}

out.flush();

downLoadFileNum--;

} catch (Exception e) {

e.printStackTrace();

} finally {

if (br != null)

try {

br.close();

} catch (IOException e) {

e.printStackTrace();

}

if (in != null)

try {

in.close();

} catch (IOException e) {

e.printStackTrace();

}

if (out != null)

try {

out.close();

} catch (IOException e) {

e.printStackTrace();

}

singleTime=System.currentTimeMillis() - startTime;

totalTime+=singleTime;

downloadMsg.add("文件名" + fileName + " 文件大小" + fileSize

+" 未下载文件数"+(downLoadFileNum)

+" 下载耗时"+ singleTime + "ms" );

System.out.println(downloadMsg.get(downloadMsg.size()-1));

}

}

downloadMsg.add("总耗时"+totalTime/1000+"s");

}

/**

* @throws IOException

*

* @Title: main

* @Description: test

* @param @param args

* @throws

*/

public static void main(String[] args) throws IOException {

ImgTool img = ImgTool.getInstance();

img.createImgURLTxt("img");

List<String> urls = img.getURLs("img");

for (Object str : urls) {

System.out.println(str.toString());

}

img.createImgs(null);

}

}

java 爬虫:开源java爬虫 swing工具 Imgraber的更多相关文章

- 基于 Java 的开源网络爬虫框架 WebCollector

原文:https://www.oschina.net/p/webcollector

- 【转】44款Java 网络爬虫开源软件

原帖地址 http://www.oschina.net/project/lang/19?tag=64&sort=time 极简网络爬虫组件 WebFetch WebFetch 是无依赖极简网页 ...

- 不会python?那就换一种姿势爬虫!Java爬虫技术总结

-本博客为原创内容,转载需注明本人- 前几天有个师妹将要毕业,需要准备毕业论文,但是论文调研需要数据资料,上知网一查,十几万条数据!指导老师让她手动copy收集,十几万的数据手动copy要浪费多少时间 ...

- 用java实现新浪爬虫,代码完整剖析(仅针对当前SinaSignOn有效)

先来看我们的web.xml文件,如下 <!DOCTYPE web-app PUBLIC "-//Sun Microsystems, Inc.//DTD Web Application ...

- 7 款开源 Java 反编译工具

今天我们要来分享一些关于Java的反编译工具,反编译听起来是一个非常高上大的技术词汇,通俗的说,反编译是一个对目标可执行程序进行逆向分析,从而得到原始代码的过程.尤其是像.NET.Java这样的运行在 ...

- WEKA,一个开源java的数据挖掘工具

开始研究WEKA,一个开源java的数据挖掘工具. HS沉寂这么多天,谁知道偏偏在我申请离职的时候给我安排了个任务,哎,无语. 于是,今天看了一天的Weka. 主要是看了HS提供的三个文章(E文,在g ...

- 7款开源Java反编译工具

今天我们要来分享一些关于Java的反编译工具,反编译听起来是一个非常高上大的技术词汇,通俗的说,反编译是一个对目标可执行程序进行逆向分析,从而得到原始代码的过程.尤其是像.NET.Java这样的运行在 ...

- Java 图片爬虫,java打包jar文件

目录 1. Java 图片爬虫,制作 .jar 文件 spider.java 制作 jar 文件 添加执行权限 1. Java 图片爬虫,制作 .jar 文件 spider.java spider.j ...

- Arthas Alibaba 开源 Java 诊断工具

Arthas 用户文档 English Docs Arthas(阿尔萨斯) 能为你做什么? Arthas 是Alibaba开源的Java诊断工具,深受开发者喜爱. 当你遇到以下类似问题而束手无策时,A ...

随机推荐

- Flutter -------- Http库实现网络请求

第三方库 http实现网络请求,包含get,post http库文档:https://pub.dev/packages/http 1.添加依赖 dependencies: http: ^0.12.0 ...

- AndoridSQLite数据库开发基础教程(8)

AndoridSQLite数据库开发基础教程(8) 添加索引 索引是一种通过预先排序和对表的一个或多个列构建索引表来优化数据库查找的手段.下面为表添加索引,操作步骤如下: (1)在打开的数据库中,单击 ...

- ROS tf基础使用知识

博客参考:https://www.ncnynl.com/archives/201702/1306.html ROS与C++入门教程-tf-坐标变换 说明: 介绍在c++实现TF的坐标变换 概念: Co ...

- jsp、freemarker、velocity、thymeleaf

1.概述在java领域,表现层技术主要有三种, (1)jsp; (2)freemarker; (3)velocity; (4)thymeleaf; 2.jsp优点: 1.功能强大,可以写java代码 ...

- SQL语句精妙集合

1一.基础 2 31.说明:创建数据库 4Create DATABASE database-name 5 62.说明:删除数据库 7drop database dbname 8 93. ...

- Spring MVC初始化

整个Spring MVC的初始化,配置了DispatcherServlet和ContextLoaderListener,那么它们是如何初始化Spring IoC容器上下文和映射请求上下文的呢?所以 ...

- LODOP带空格和不带空格的字体对齐

有时候需要用到字体上下对齐,有些需要的文字较多,较少的文字需要加部分空格才能向上面的文字对齐.本文实际测试了一下字体对齐需要的空格.代码是在editplus里写的,该编辑软件里的字体首选项设置的是Co ...

- PhpStorm (强大的PHP开发环境)10.0.2 附注

最新版PhpStorm 10正式版改进了PHP 7支持,改进代码完成功能. PhpStorm 是最好的PHP开发工具,使用它进行PHP开发将会让你感觉到编程的乐趣. 快乐无极终于从oschina看到了 ...

- jvm(3)---常用监控工具指令

1.jps 查看jvm中运行的进程(获取对应pid) 参数:默认-V(大写) -v: 列出jvm启动参数. ---------------------------------- 2.jstack pi ...

- 使用第三方Java类库jaudiotagger完成Flac音频文件metadata(元数据)的读和修改

最近需要使用Java Swing做个读写Flac格式音频文件的小GUI工具,虽然Mp3tag完全可以完成Flac的读写(编辑)任务,但是为了简化工作流程(编辑Flac信息后调用其它系统的接口完成部分信 ...