Flink学习(十一) Sink到Elasticsearch

导入依赖

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-elasticsearch6_2.11</artifactId>

<version>1.7.2</version>

</dependency>

package com.wyh.streamingApi.sink import java.util import org.apache.flink.api.common.functions.RuntimeContext

import org.apache.flink.streaming.api.scala._

import org.apache.flink.streaming.connectors.elasticsearch.{ElasticsearchSinkFunction, RequestIndexer}

import org.apache.flink.streaming.connectors.elasticsearch6.ElasticsearchSink

import org.apache.http.HttpHost

import org.elasticsearch.client.Requests //温度传感器读数样例类

case class SensorReading(id: String, timestamp: Long, temperature: Double) object Sink2ES {

def main(args: Array[String]): Unit = {

val env = StreamExecutionEnvironment.getExecutionEnvironment

env.setParallelism(1) //Source操作

val inputStream = env.readTextFile("F:\\flink-study\\wyhFlinkSD\\data\\sensor.txt") //Transform操作

val dataStream: DataStream[SensorReading] = inputStream.map(data => {

val dataArray = data.split(",")

SensorReading(dataArray(0).trim, dataArray(1).trim.toLong, dataArray(2).trim.toDouble)

}) val httpHosts = new util.ArrayList[HttpHost]()

httpHosts.add(new HttpHost("192.168.230.30", 9200)) //创建一个ES Sink的builder

val esSinkBuilder: ElasticsearchSink.Builder[SensorReading] = new ElasticsearchSink.Builder[SensorReading](

httpHosts,

new ElasticsearchSinkFunction[SensorReading] {

override def process(t: SensorReading, runtimeContext: RuntimeContext, requestIndexer: RequestIndexer): Unit = {

println("saving data:" + t) //包装成一个Map或者JsonObject格式

val json = new util.HashMap[String, String]() json.put("sensor_id", t.id)

json.put("timestamp", t.timestamp.toString)

json.put("temperature", t.temperature.toString) //创建indexRequest准备发送数据

val indexRequest = Requests.indexRequest()

.index("sensor")

.`type`("readingdata")

.source(json) //利用requestIndexer进行发送请求,写入数据

requestIndexer.add(indexRequest)

println("data 写入完成。。。")

}

}

) //Sink操作

dataStream.addSink(esSinkBuilder.build()) env.execute("sink ES test")

} }

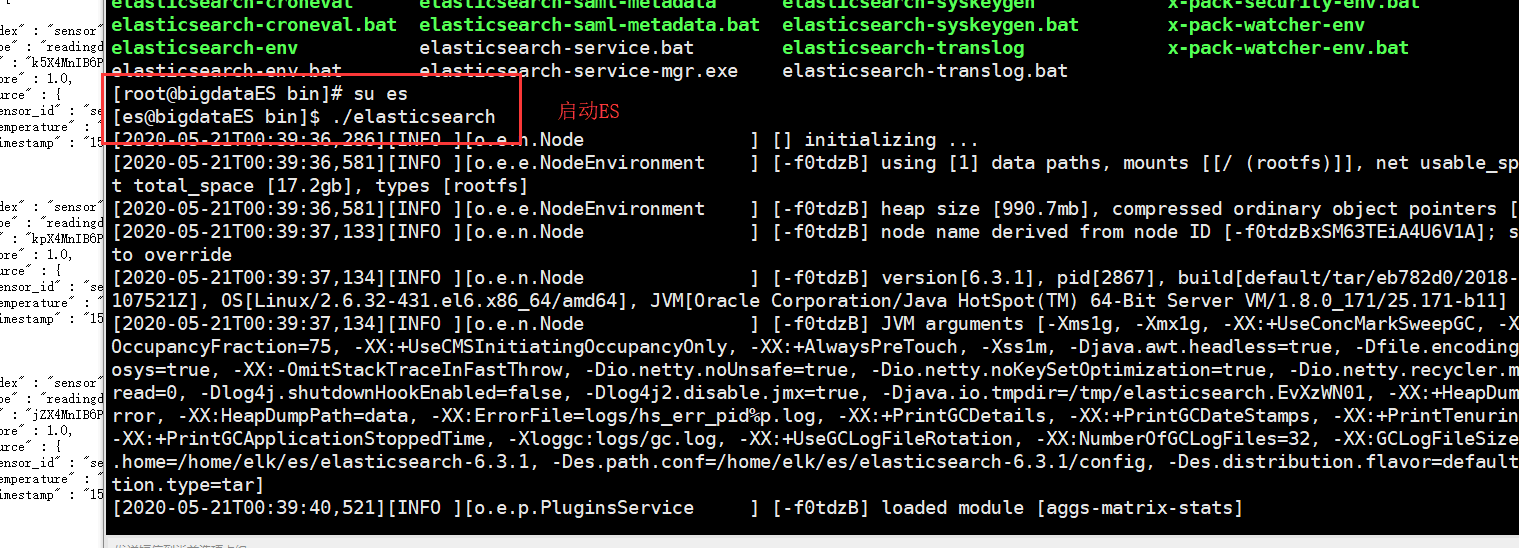

启动ES

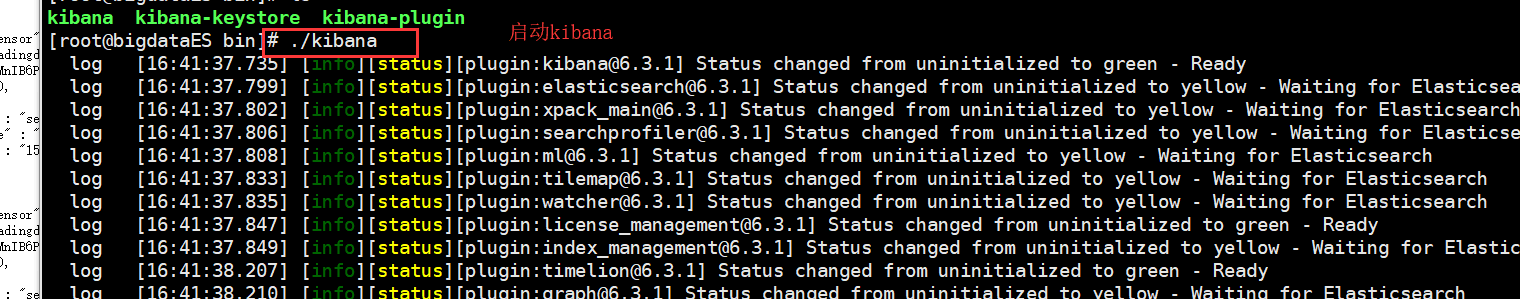

启动kibana

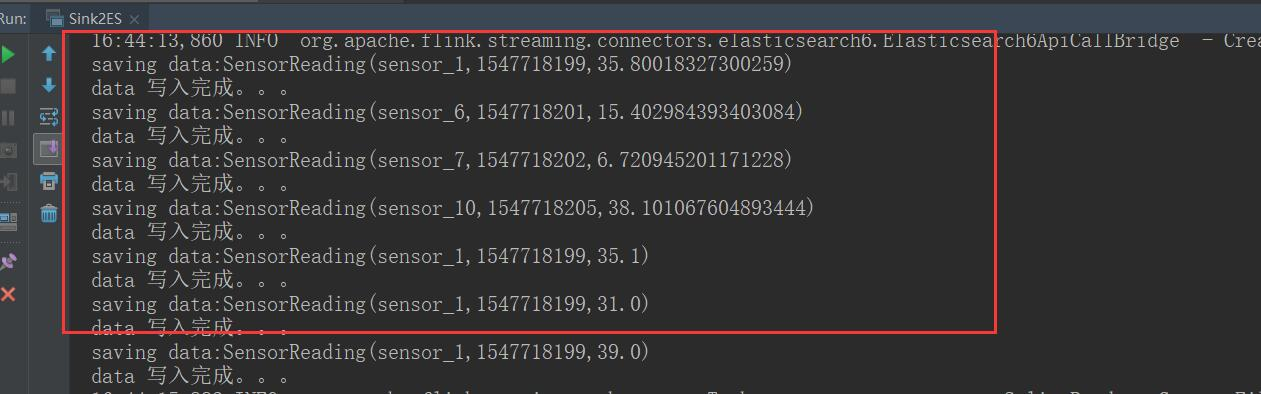

运行

查看结果

Flink学习(十一) Sink到Elasticsearch的更多相关文章

- 《从0到1学习Flink》—— Data Sink 介绍

前言 再上一篇文章中 <从0到1学习Flink>-- Data Source 介绍 讲解了 Flink Data Source ,那么这里就来讲讲 Flink Data Sink 吧. 首 ...

- Flink学习笔记:Connectors概述

本文为<Flink大数据项目实战>学习笔记,想通过视频系统学习Flink这个最火爆的大数据计算框架的同学,推荐学习课程: Flink大数据项目实战:http://t.cn/EJtKhaz ...

- Flink 之 写入数据到 ElasticSearch

前面 FLink 的文章中我们已经介绍了说 Flink 已经有很多自带的 Connector. 1.<从0到1学习Flink>—— Data Source 介绍 2.<从0到1学习F ...

- 使用Flink实现索引数据到Elasticsearch

使用Flink实现索引数据到Elasticsearch 2018-07-28 23:16:36 Yanjun 使用Flink处理数据时,可以基于Flink提供的批式处理(Batch Proce ...

- Elasticsearch学习总结 (Centos7下Elasticsearch集群部署记录)

一. ElasticSearch简单介绍 ElasticSearch是一个基于Lucene的搜索服务器.它提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口.Elasticse ...

- Flink 之 Data Sink

首先 Sink 的中文释义为: 下沉; 下陷; 沉没; 使下沉; 使沉没; 倒下; 坐下; 所以,对应 Data sink 意思有点把数据存储下来(落库)的意思: Source 数据源 ---- ...

- 入门大数据---Flink学习总括

第一节 初识 Flink 在数据激增的时代,催生出了一批计算框架.最早期比较流行的有MapReduce,然后有Spark,直到现在越来越多的公司采用Flink处理.Flink相对前两个框架真正做到了高 ...

- flink学习总结

flink学习总结 1.Flink是什么? Apache Flink 是一个框架和分布式处理引擎,用于处理无界和有界数据流的状态计算. 2.为什么选择Flink? 1.流数据更加真实的反映了我们的生活 ...

- 【转载】 强化学习(十一) Prioritized Replay DQN

原文地址: https://www.cnblogs.com/pinard/p/9797695.html ------------------------------------------------ ...

- Apache Flink学习笔记

Apache Flink学习笔记 简介 大数据的计算引擎分为4代 第一代:Hadoop承载的MapReduce.它将计算分为两个阶段,分别为Map和Reduce.对于上层应用来说,就要想办法去拆分算法 ...

随机推荐

- Nginx转发解析长域名多路径域名为一级域名

Nginx解析短域名,例如:访问 http://192.168.1.23 可直接跳转到 http://192.168.1.23/webroot/decision server { listen 90 ...

- 注册美区 Apple ID 账号!都2020年了,你还没有一个自己的海外苹果ID?

写在前面: 小伙伴们学腻了技术,不防今天来点大家都感兴趣的海外苹果 Apple ID 吧! 今天就教大家怎么注册美区 Apple ID,这个方法也是目前注册苹果美区 Apple ID 最快最简单的 ...

- 实用干货分享(4)- 分布式金融PaaS容器化部署实战

编辑 一.学习链接 http://www.itmuch.com/docker/00-docker-lession-index/ 二.安装步骤 sudo yum install -y yum-ut ...

- 龙哥量化:通达信的函数ma均线,ema、sma、dma的计算原理是什么,XMA是未来函数

注意均线也有未来函数,常见的是跨周期的用法,会导致信号闪烁, 不常见的是XMA这个未来函数太坑了, [代写公式,龙哥微信:Long622889] MA.EMA.SMA.DMA.TMA.WMA6种平均算 ...

- Qt开发经验小技巧156-160

Qt的UI界面在resize以后有个BUG,悬停样式没有取消掉,需要主动模拟鼠标动一下. void frmMain::on_btnMenu_Max_clicked() { ...... //最大化以后 ...

- [转]OpenLayers基于Vue项目的搭建

主要内容上次介绍了什么是OpenLayers以及其他的可以GIS工具,这次说说如何基于Vue搭建OpenLayers的项目,并且实现地图的加载. 一.vue项目搭建1.全局安装vue-cil npm ...

- Solution Set -「NOIP Simu.」20221005

\(\mathscr{A}\sim\)「CF 1252G」Performance Review Link & Submission. Tag:「水题无 tag」 记 \(A=a_1 ...

- DICOM-SCP,可以直接使用的SCP(.net framework 4.6.1以上)控制台接收端

此程序只能运行在.net framework 4.6.1版本上的环境,如果要运行在低版本环境,请看上一篇文档 using System; using System.IO; using System.T ...

- react 计算衍生数据

import React from 'react' import { connect } from 'react-redux' import TodoList from '../components/ ...

- Mac安装NTL库

Mac安装NTL库 NTL是一个高性能.可移植的C++库,为任意长度的整数提供数据结构和算法:用于整数和有限域上的向量.矩阵和多项式:以及任意精度的浮点运算. 具有以下功能: 任意长度整数运算和任意精 ...