Flume NG部署

本次配置单节点的Flume NG

1、下载flume安装包

下载地址:(http://flume.apache.org/download.html)

apache-flume-1.6.0-bin.tar.gz安装包上传解压到集群上的/usr/hadoop/目录下。

[hadoop@centpy hadoop]$ pwd

usr/hadoop

[hadoop@centpy hadoop]$ ls

hadoop-2.6. zookeeper-3.4. hbase-0.98. jdk1..0_60

[hadoop@centpy hadoop]$ rz [hadoop@centpy hadoop]$ ls

apache-flume-1.8.0-bin.tar.gz jdk1..0_60 hbase-0.98. zookeeper-3.4.6 hadoop-2.6.

[hadoop@centpy hadoop]$ tar -zxf apache-flume-1.8.0-bin.tar.gz

[hadoop@centpy hadoop]$ ls

apache-flume-1.8.0-bin hadoop-2.6.

apache-flume-1.8.-bin.tar.gz jdk1..0_60hbase-0.98.19 zookeeper-3.4.

[hadoop@centpy hadoop]$ rm -f apache-flume-1.8.0-bin.tar.gz

[hadoop@centpy hadoop]$ mv apache-flume-1.8.0-bin/ flume-1.8.0

[hadoop@centpy hadoop]$ ls

jdk1..0_60 flume-1.8.0 hbase-0.98. zookeeper-3.4.6 hadoop-2.6.0

2、配置flume

[hadoop@centpy hadoop]$ cd flume-1.8.0/conf/

[hadoop@centpy conf]$ ls

flume-conf.properties.template flume-env.ps1.template flume-env.sh.template log4j.properties

[hadoop@centpy conf]$ cp flume-conf.properties.template flume-conf.properties //需要通过flume-conf.properties.template复制一个flume-conf.properties配置文件

[hadoop@centpy conf]$ ls

flume-conf.properties flume-conf.properties.template flume-env.ps1.template flume-env.sh.template log4j.properties [hadoop@centpy conf]$ vi flume-conf.properties #Define sources, channels, sinks

agent1.sources = spool-source1

agent1.channels = ch1

agent1.sinks = hdfs-sink1 #Define and configure an Spool directory source

agent1.sources.spool-source1.channels = ch1

agent1.sources.spool-source1.type = spooldir

agent1.sources.spool-source1.spoolDir = /home/hadoop/test

agent1.sources.spool-source1.ignorePattern = event(_\d{}\-\d{}-\d{}_\d{}_\d{})?\.log(\.COMPLETED)?

agent1.sources.spool-source1.deserializer.maxLineLength = #Configure channels

agent1.sources.ch1.type = file

agent1.sources.ch1.checkpointDir = /home/hadoop/app/flume/checkpointDir

agent1.sources.ch1.dataDirs = /home/hadoop/app/flume/dataDirs #Define and configure a hdfs sink

agent1.sinks.hdfs-sink1.channels = ch1

agent1.sinks.hdfs-sink1.type = hdfs

agent1.sinks.hdfs-sink1.hdfs.path = hdfs://centpy:9000/flume/%Y%m%d

agent1.sinks.hdfs-sink1.hdfs.useLocalTimeStamp = true

agent1.sinks.hdfs-sink1.hdfs.rollInterval =

agent1.sinks.hdfs-sink1.hdfs.rollSize =

agent1.sinks.hdfs-sink1.hdfs.rollCount =

#agent1.sinks.hdfs-sink1.hdfs.codeC = snappy

修改集群上的flume-conf.properties配置文件,这里收集日志文件到收集端。配置参数的详细说明可以参考官方文档(https://cwiki.apache.org/confluence/display/FLUME/Getting+Started)。

3、启动并测试Flume

1)首先启动Hadoop集群

[hadoop@centpy hadoop]$ cd hadoop-2.6.0

[hadoop@centpy hadoop-2.6.]$ sbin/start-all.sh

This script is Deprecated. Instead use start-dfs.sh and start-yarn.sh

Starting namenodes on [centpy]

centpy: starting namenode, logging to /usr/hadoop/hadoop-2.6./logs/hadoop-hadoop-namenode-centpy.out

centpy: starting datanode, logging to /usr/hadoop/hadoop-2.6./logs/hadoop-hadoop-datanode-centpy.out

Starting secondary namenodes [0.0.0.0]

0.0.0.0: starting secondarynamenode, logging to /usr/hadoop/hadoop-2.6./logs/hadoop-hadoop-secondarynamenode-centpy.out

starting yarn daemons

starting resourcemanager, logging to /usr/hadoop/hadoop-2.6./logs/yarn-hadoop-resourcemanager-centpy.out

centpy: starting nodemanager, logging to /usr/hadoop/hadoop-2.6./logs/yarn-hadoop-nodemanager-centpy.out

[hadoop@centpy hadoop-2.6.]$ jps

ResourceManager

SecondaryNameNode

NameNode

NodeManager

DataNode

Jps

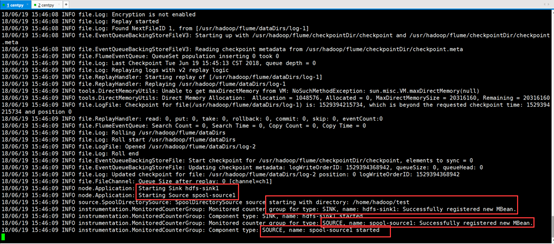

2)启动Flume

[hadoop@centpy hadoop-2.6.]$ cd ../flume/

[hadoop@centpy flume]$ bin/flume-ng agent -n agent1 -f conf/flume-conf.properties

如上图,我们已经成功启动Flume。

3)测试Flume

先上传一个测试文件到我们配置的测试目录中(/home/hadoop/test)

[hadoop@centpy conf]$ cd /home/hadoop/test/

[hadoop@centpy test]$ ls

[hadoop@centpy test]$ rz [hadoop@centpy test]$ ls

template.log

此时Flume会收集日志信息如下:

// :: INFO hdfs.BucketWriter: Creating hdfs://centpy:9000/flume/20180619/FlumeData.1529394914599.tmp

(此处会先在数据收集过程中先生成一个.tmp文件用于记录,等到30秒过后数据收集完成则会生成最终文件FlumeData.1529394914599)

// :: INFO file.EventQueueBackingStoreFile: Start checkpoint for /usr/hadoop/flume/checkpointDir/checkpoint, elements to sync =

// :: INFO file.EventQueueBackingStoreFile: Updating checkpoint metadata: logWriteOrderID: , queueSize: , queueHead:

// :: INFO file.Log: Updated checkpoint for file: /usr/hadoop/flume/dataDirs/log- position: logWriteOrderID:

// :: INFO hdfs.BucketWriter: Closing hdfs://centpy:9000/flume/20180619/FlumeData.1529394914599.tmp

// :: INFO hdfs.BucketWriter: Renaming hdfs://centpy:9000/flume/20180619/FlumeData.1529394914599.tmp to hdfs://centpy:9000/flume/20180619/FlumeData.1529394914599

// :: INFO hdfs.HDFSEventSink: Writer callback called.

我们也可以在Web浏览器查看文件信息

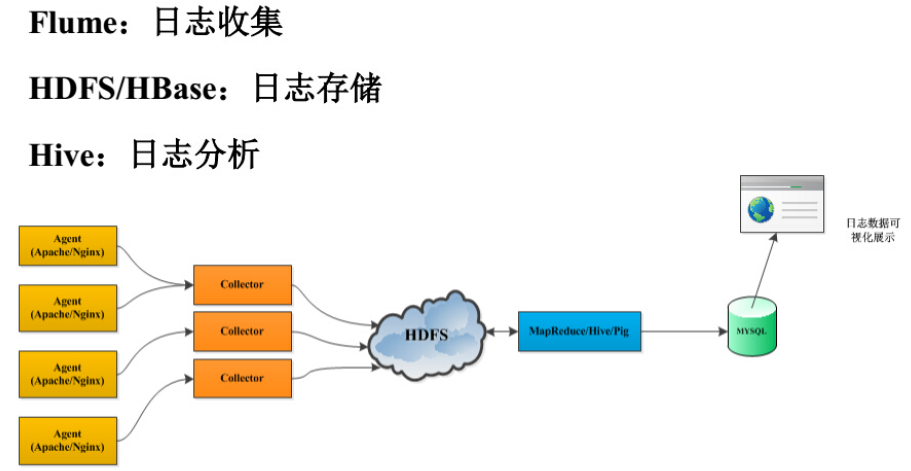

4、Flume 案例分析

下面我们看一下flume的实际应用场景,其示例图如下所示。

在上面的应用场景中,主要可以分为以下几个步骤。

1、首先采用flume进行日志收集。

2、采用HDFS进行日志的存储。

3、采用MapReduce/Hive进行日志分析。

4、将分析后的格式化日志存储到Mysql数据库中。

5、最后前端查询,实现数据可视化展示。

flume的实际应用场景,相信大家有了一个初步的认识,大家可以根据复杂的业务需求,实现flume来收集数据。这里就不一一讲述,希望大家在以后的学习过程中,学会学习、学会解决实际的问题。

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!

Flume NG部署的更多相关文章

- Flume NG安装部署及数据采集测试

转载请注明出处:http://www.cnblogs.com/xiaodf/ Flume作为日志收集工具,监控一个文件目录或者一个文件,当有新数据加入时,采集新数据发送给消息队列等. 1 安装部署Fl ...

- Flume NG Getting Started(Flume NG 新手入门指南)

Flume NG Getting Started(Flume NG 新手入门指南)翻译 新手入门 Flume NG是什么? 有什么改变? 获得Flume NG 从源码构建 配置 flume-ng全局选 ...

- Flume NG简介及配置

Flume下载地址:http://apache.fayea.com/flume/ 常用的分布式日志收集系统: Apache Flume. Facebook Scribe. Apache Chukwa ...

- Flume NG 简介及配置实战

Flume 作为 cloudera 开发的实时日志收集系统,受到了业界的认可与广泛应用.Flume 初始的发行版本目前被统称为 Flume OG(original generation),属于 clo ...

- Flume环境部署和配置详解及案例大全

flume是一个分布式.可靠.和高可用的海量日志采集.聚合和传输的系统.支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(比如文本.HDF ...

- 【Flume NG用户指南】(1)设置

作者:周邦涛(Timen) Email:zhoubangtao@gmail.com 转载请注明出处: http://blog.csdn.net/zhoubangtao/article/details ...

- Flume NG 配置详解(转)

原文链接:[转]Flume NG 配置详解 (说明,名词对应解释 源-Source,接收器-Sink,通道-Channel) 配置 设置代理 Flume代理配置存储在本地配置文件.这是一个文本文件格式 ...

- Flume NG初次使用

一.什么是Flume NG Flume是一个分布式.可靠.和高可用性的海量日志采集.聚合和传输的系统,支持在日志系统中定制各类数据发送方,用于收集数据:同时Flume提供对数据的简单处理,并写到各种数 ...

- 高可用Hadoop平台-Flume NG实战图解篇

1.概述 今天补充一篇关于Flume的博客,前面在讲解高可用的Hadoop平台的时候遗漏了这篇,本篇博客为大家讲述以下内容: Flume NG简述 单点Flume NG搭建.运行 高可用Flume N ...

随机推荐

- Python:sample函数

sample(序列a,n) 功能:从序列a中随机抽取n个元素,并将n个元素生以list形式返回. 例: from random import randint, sample date = [randi ...

- <%@ include file=""%>与<jsp:include page=""/>两种方式的作用

一.前言 身为一名coder有太多太多的知识点要去学,太多太多的东西要去记.往往一些小细节也就难免疏忽,但悲催的是多数困恼你的bug就是因为这些微不足道的知识点.我们又不是机器人,怎么可能什么都记得了 ...

- top查看CPU情况

Linux查看CPU情况 在系统维护的过程中,随时可能有需要查看 CPU 使用率,并根据相应信息分析系统状况的需要.在 CentOS 中,可以通过 top 命令来查看 CPU 使用状况.运行 top ...

- wdcp安全设置,让你的后台,只有你自己能访问

wdcp安全设置,让你的后台,只有你自己能访问 wdcp的后台,默认端口,是8080,可以修改为其它端口wdcp的后台,可以限制IP地址的访问,也可以限制域名的访问做了这些限制与设置后,已相对安全了, ...

- [51nod1247]可能的路径(思维题)

题意:给定(a,b),(x,y) ,(a,b)可以通向(a-b,b) (a+b,b) (a,a+b) (a,a-b) 求能否到达(x,y) 解题关键:类似于更相减损,变换过程中gcd是一样的. #i ...

- 为JFileChooser设定扩展名过滤

--------------------siwuxie095 工程名:TestFileChooser 包名:com.siwuxie095.fil ...

- layui 工具条实现分页

1.页面 <div id="getShowTable" style="width: 100%; height: auto;clear: both;"> ...

- 使用 typescript ,提升 vue 项目的开发体验(2)

此文已由作者张汉锐授权网易云社区发布. 欢迎访问网易云社区,了解更多网易技术产品运营经验. vuex-class 提供了和 vuex 相关的全部装饰器,从而解决了上面 Vue.extend + vue ...

- [笔记]解决git本地仓库不能上传到gitee远程仓库的问题

关键词:git.gitee.码云.上传远程仓库失败 1.gitee有一个远程仓库名字是CommandModel,里面只有两个README文件 2.假如我目录 D:\eclipse\workspace ...

- spring零配置AOP踩坑指南

今天照着书,试着配了AOP(全注解),结果踩了各种坑,后来参考书附带的源码,终于走出来了,现在总结一下 除了spring的jar包以外,还需要导入以下包: 1.Spring核心配置文件beans.xm ...