网页解析 -- bs4 和 xpath 的简单使用

bs4

BeautifulSoup 是一个可以从HTML或XML文件中提取数据的Python库,它的使用方式相对于正则来说更加的简单方便

中文文档:https://beautifulsoup.readthedocs.io/zh_CN/v4.4.0

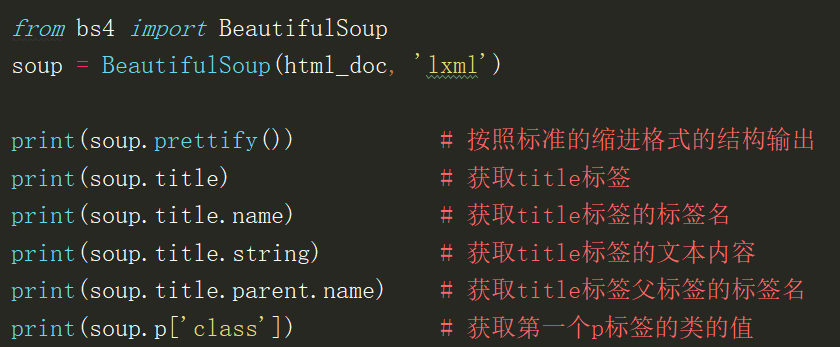

Tag

name:每一个tag对象都有name属性,为标签的名字

Attributes:在HTML中,tag可能有多个属性,所以tag属性的取值跟字典相同

get_text():通过get_text()方法可以获取某个tag下所有的文本内容

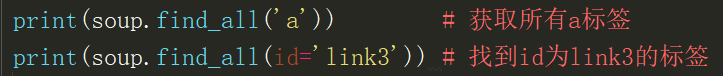

find_all()

通过name搜索,find_all('a')可以直接查找出整个文档树中所有的a标签,并返回列表

通过属性搜索,通过传递给attrs一个字典参数来搜索属性:soup.find_all(attrs={'class': 'sister'})

通过文本搜索,soup.find_all(text="Lacie")

通过正则表达式来筛选,将re.compile编译的对象传入find_all()方法,tags = soup.find_all(re.compile("^b"))

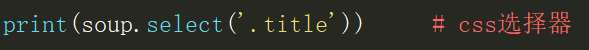

CSS选择器

使用select(),在其中传入字符串参数,就可以使用CSS选择器的语法来找到tag

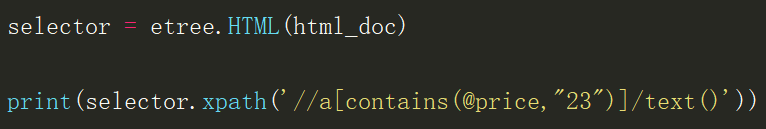

xpath

相比于BeautifulSoup,Xpath在提取数据时会更有效率

from lxml import etree

表达式

nodename 选取当前节点的所有nodename子节点

/ 根路径

// 从整个文档当中搜索,不考虑位置

. 当前节点

.. 当前节点的父节点

@ 选取属性

路径表达式

//bookstore/book[1] 选取属于bookstore子元素的第一个 book元素

//bookstore/book[last()] 选取属于bookstore子元素的最后一个book元素

//bookstore/book[|ast()-1] 选取属于bookstore子元素的倒数第二个 book元素

//bookstore/book[position0)<3] 选取最前面的两个属于bookstore元素的子元素的book元素

//title[@lang] 选取所有拥有名为lang的属性的title 元素

//title[@lang='eng'] 选取所有title 元素,且这些元素拥有值为eng的lang属性

//bookstore/book[price>35.00] 选取bookstore元素的所有book元素,且其中的price元素的值须大于35.00

//bookstore/book[price> 35.00]/title 选取bookstore元素中的book元素的所有title元素,且其中的price元素的值须大于35.00

选取未知节点

* 匹配任何元素节点 //bookstore/* 选取bookstore元素的所有子元素

@* 匹配任何属性节点 //* 选取文档中的所有元素

node() 匹配任何类型的节点 //title[@*] 选取所有带有属性的title元素

选取多个路径

//book/title| //book/price 选取book元素的所有title和price元素

//title | //price 选取文档中所有的title和price元素

//bookstore/book/title| //price 选取bookstore元素的book元素的所有title元素,以及文档中所有的price元素

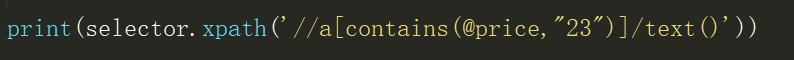

获取文本

用text()获取某个节点下的文本 //a/text()

用string()获取某个节点下所有的文本 string(//book[1])

其它

contains() 包含于 //div[contains(@id,'note')]

strats-with() 以什么开头

多个属性组合 //input(@id='ffff' and @name ='username')

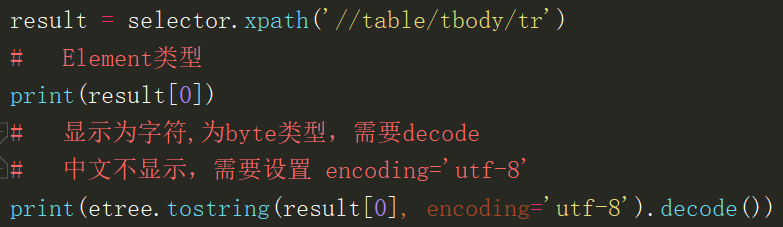

将Element显示为字符

网页解析 -- bs4 和 xpath 的简单使用的更多相关文章

- 爬虫——网页解析利器--re & xpath

正则解析模块re re模块使用流程 方法一 r_list=re.findall('正则表达式',html,re.S) 方法二 创建正则编译对象 pattern = re.compile('正则表达式 ...

- 网页解析:Xpath 与 BeautifulSoup

1. Xpath 1.1 Xpath 简介 1.2 Xpath 使用案例 2. BeautifulSoup 2.1 BeautifulSoup 简介 2.2 BeautifulSoup 使用案例 1) ...

- 关于爬虫中常见的两个网页解析工具的分析 —— lxml / xpath 与 bs4 / BeautifulSoup

http://www.cnblogs.com/binye-typing/p/6656595.html 读者可能会奇怪我标题怎么理成这个鬼样子,主要是单单写 lxml 与 bs4 这两个 py 模块名可 ...

- python爬虫的页面数据解析和提取/xpath/bs4/jsonpath/正则(1)

一.数据类型及解析方式 一般来讲对我们而言,需要抓取的是某个网站或者某个应用的内容,提取有用的价值.内容一般分为两部分,非结构化的数据 和 结构化的数据. 非结构化数据:先有数据,再有结构, 结构化数 ...

- 爬虫的三种解析方式(正则解析, xpath解析, bs4解析)

一 : 正则解析 : 常用正则回顾: 单字符: . : 除换行符以外的所有字符 [] : [aoe] [a-w] 匹配集合中任意一个字符 \d : 数字 [0-9] \D : 非数字 \w : 非数字 ...

- 网页解析库-Xpath语法

网页解析库 简介 除了正则表达式外,还有其他方便快捷的页面解析工具 如:lxml (xpath语法) bs4 pyquery等 Xpath 全称XML Path Language, 即XML路径语言, ...

- 【XPath Helper:chrome爬虫网页解析工具 Chrome插件】XPath Helper:chrome爬虫网页解析工具 Chrome插件下载_教程_安装 - 开发者插件 - Chrome插件网

[XPath Helper:chrome爬虫网页解析工具 Chrome插件]XPath Helper:chrome爬虫网页解析工具 Chrome插件下载_教程_安装 - 开发者插件 - Chrome插 ...

- Android Studio下的简单网页解析

Android Studio下的简单网页解析 一.导入数据 导入前添加依赖 implementation 'org.jsoup:jsoup:1.11.3' 使用字符串导入 String html = ...

- Python网页解析

续上篇文章,网页抓取到手之后就是解析网页了. 在Python中解析网页的库不少,我最开始使用的是BeautifulSoup,貌似这个也是Python中最知名的HTML解析库.它主要的特点就是容错性很好 ...

随机推荐

- oracle表空间相关统计查询

部分转自 https://www.cnblogs.com/xwdreamer/p/3511047.html--查询表空间使用情况SELECT UPPER(F.TABLESPACE_NAME) &quo ...

- python字典中列表追加数据

dict = {} for i in range(1, 6): if i not in dict: dict[i] = [] for j in range(101, 106): dict[i].app ...

- CentOS系统登陆root用户后发现提示符显示-bash-4.2#(已解决)

问题: 在root用户下终端显示,如图所示: 尝试退出登陆root用户依然不能解决 原因: root主目录下缺失.bash_profile和.bashrc文件 Tip: /etc/profile: 此 ...

- java8-04-初识函数式接口

为什么用函数式接口 在函数式编程思想下,允许函数本身作为参数传入另一个函数.使用函数式接口实现"传递行为"的思想 ...

- WINDOWS代理服务器搭建 - Apache httpd

1.检查电脑系统类型 检查电脑版本是为 32位操作系统 还是 64位操作系统 2.下载安装Apache Httpd 下载地址:https://www.apachehaus.com/cgi-bin/do ...

- docker搭建zookeeper集群

1.在官网拉取镜像 docker pull zookeeper 2.根据镜像启动zookeeper容器 docker run -itd --name zookeeper1 -h zookeeper1 ...

- 【洛谷4585】[FJOI2015] 火星商店问题(线段树分治)

点此看题面 大致题意: 有\(n\)家店,每个商品有一个标价.每天,都可能有某家商店进货,也可能有某人去购物.一个人在购物时,会于编号在区间\([L_i,R_i]\)的商店里挑选一件进货\(d_i\) ...

- nodejs的require是如何执行的

通常,在Node.js里导入是通过 require函数调用进行的. Node.js会根据 require的是相对路径还是非相对路径做出不同的行为. 相对路径 相对路径很简单. 例如,假设有一个文件路径 ...

- 为何我建议1-3年的Java程序员仔细看看这篇文章

此文的目的是为了督促自己去不断学习,让自己有更明确的方向去提升自己.以技能树为基础,以面试要点为大纲,我觉得比抓住什么看什么要更有目的,更能坚持下去.世界瞬息万变,我们要时刻准备着.时刻提高着自己,才 ...

- Kubernetes容器日志收集

日志采集方式 日志从传统方式演进到容器方式的过程就不详细讲了,可以参考一下这篇文章Docker日志收集最佳实践,由于容器的漂移.自动伸缩等特性,日志收集也就必须使用新的方式来实现,Kubernetes ...