Spark- Linux下安装Spark

Spark- Linux下安装Spark

前期部署

1.JDK安装,配置PATH

可以参考之前配置hadoop等配置

2.下载spark-1.6.1-bin-hadoop2.6.tgz,并上传到服务器解压

[root@srv01 ~]# tar -xvzf spark-1.6.-hadoop2..tgz /usr/spark-1.6.-hadoop2.

3.在 /usr 下创建软链接到目标文件夹

[root@srv01 usr]# ln -s spark-1.6.-bin-hadoop2. spark

4.修改配置文件,目标目录 /usr/spark/conf/

[root@srv01 conf]# ls

docker.properties.template log4j.properties.template slaves.template spark-env.sh.template

fairscheduler.xml.template metrics.properties.template spark-defaults.conf.template

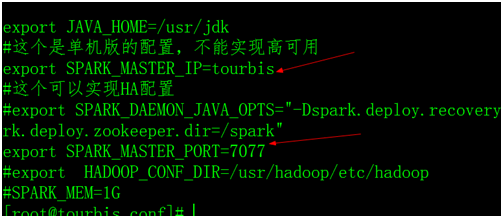

这里需要把spark-env.sh.template改名为spark-env.sh

export JAVA_HOME=/usr/jdk

#这个是单机版的配置,不能实现高可用

export SPARK_MASTER_IP=srv01

export SPARK_MASTER_PORT=

再配置slaves ,都是我的集群的机器的hostname

srv01

srv02

srv03

5.分发到集群各个机器上,再软链接一下,保持集群一致性,参考step-3

[root@srv01 usr]# scp -r spark-1.6.-bin-hadoop2. srv02:/usr

[root@srv01 usr]# scp -r spark-1.6.1-bin-hadoop2.6 srv03:/usr

6.Spark-sell

配置好,启动spark-shell,注意记得先关闭防火墙(也可以将spark写进PATH中)

输入 sc ,如果显示下面的,表示安装正常

scala> sc

res0: org.apache.spark.SparkContext = org.apache.spark.SparkContext@18811c42

7.测试单词计算案例

scala> sc.textFile("/root/file.log").flatMap(_.split(" ")).map((_,)).reduceByKey(_+_).collect.toBuffer

res7: scala.collection.mutable.Buffer[(String, Int)] = ArrayBuffer((scala,), (spark,), (hive,), (hadoop,), (mapreduce,), (zookeeper,), (hello,), (redis,), (world,))

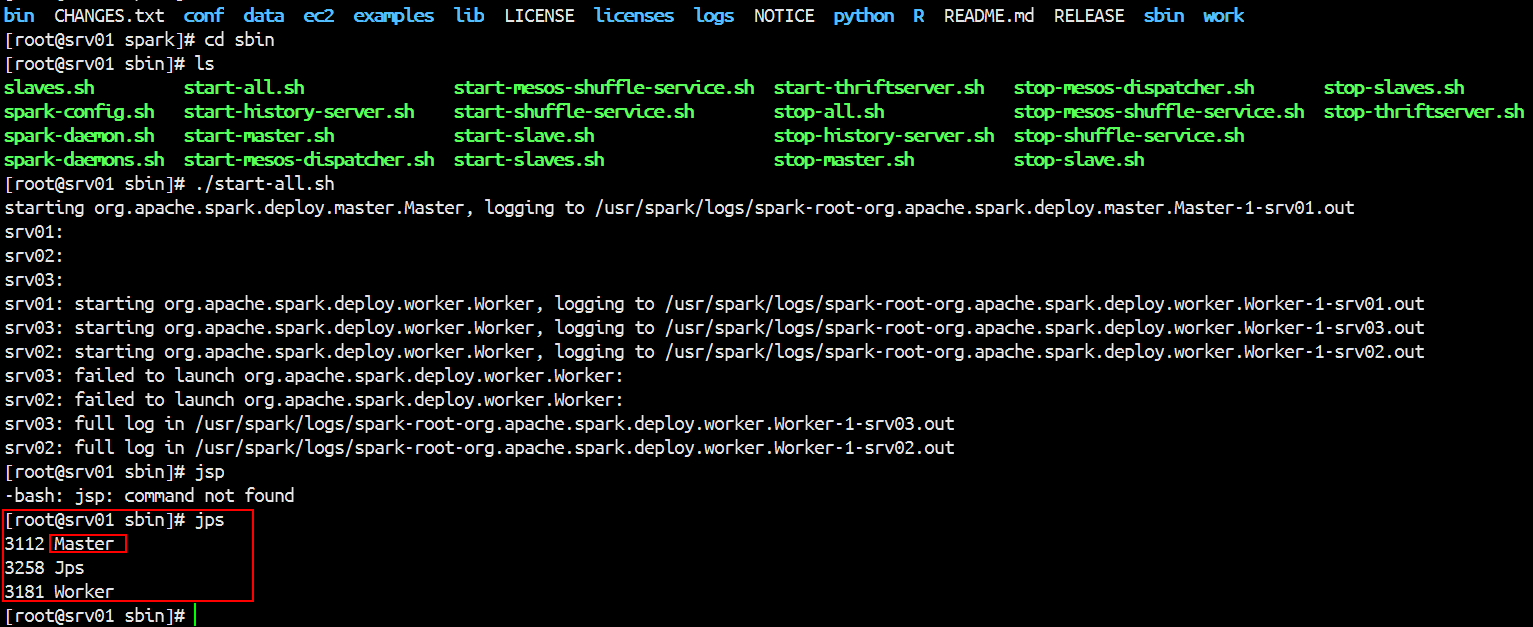

8.启动Spark集群模式(前提是3台机器的spark配置一样,配置文件spark-env.sh和slaves文件保持一致)

进入Spark的sbin目录下启动

./start-all.sh

这个脚本文件在sbin目录

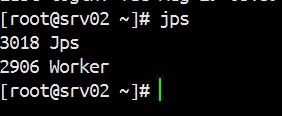

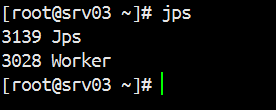

通过Jps查看角色

[root@srv01 conf]# jps

13079 Master

13148 Worker //这个worker的启动通过配置文件slaves

13234 Jps

下面是我的slaves的配置文件

srv01

srv02

srv03

slaves配置的决定了在哪几台机器上启动worker

下面的配置文件决定了在哪台机器上启动Master

启动Spark集群(如果有使用hdfs的场景,需要把hadoop的conf目录下的core-site.xml和dhfs-site.xml拷贝到spark的conf目录下,才能使用高可用的hdfs url)

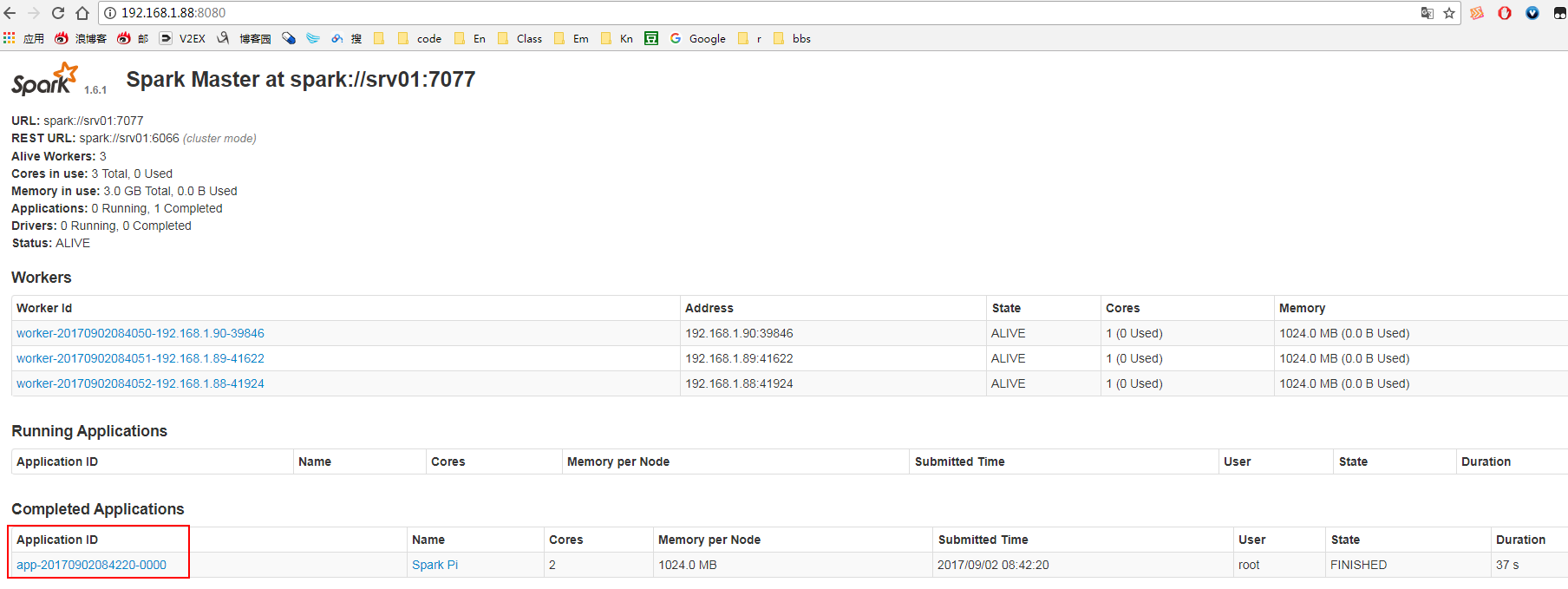

然后在通过网页查看spark的相关信息:

执行第一个Spark程序

执行第一个Spark程序

指定运行程序的主机名(Master)

./spark-submit --class org.apache.spark.examples.SparkPi --master spark://srv01:7077 --executor-memory 1G --total-executor-cores 2 /usr/spark-1.6.1-bin-hadoop2.6/lib/spark-examples-1.6.1-hadoop2.6.0.jar 500

IDEA上面编码使用集群上的spark运行程序

package com.rz.spark.base

import org.apache.log4j.{Level, Logger}

import org.apache.spark.{SparkConf, SparkContext}

object transactionApp {

def main(args: Array[String]): Unit = {

Logger.getLogger("org.apache.spark").setLevel(Level.OFF)

val conf = new SparkConf().setAppName(this.getClass.getSimpleName)

.setMaster("spark://hdp:7077")

val sc = new SparkContext(conf)

val rdd1 = sc.parallelize(Array(1,2,3,4,5,6,7,8,9))

println(rdd1.partitions.length)

sc.stop()

}

}

Spark- Linux下安装Spark的更多相关文章

- 在linux上安装spark详细步骤

在linux上安装spark ,前提要部署了hadoop,并且安装了scala. 提君博客原创 对应版本 >>提君博客原创 http://www.cnblogs.com/tijun/ ...

- Linux下安装 Posgresql 并设置基本参数

在Linux下安装Postgresql有二进制格式安装和源码安装两种安装方式,这里用的是二进制格式安装.各个版本的Linux都内置了Postgresql,所以可直接通过命令行安装便可.本文用的是Cen ...

- Linux下安装Tomcat服务器和部署Web应用

一.上传Tomcat服务器

- Linux下安装使用Solr

Linux下安装使用Solr 1.首先下载Solr.mmseg4j分词包.tomcat并解压,这用google.百度都可以搜索得到下载地址. 2.因为要使用到中文分词,所以要设置编码,进入tomcat ...

- Linux下安装tar.gz类型的jdk,并配置环境变量

近期因要学习一门技术,必须在Linux下运行,故开始学习如何使用Linux. 在安装jdk时出现了困难,环境变量配置不成功,花了一天时间才搞定,特分享出来,供大家参考. Linux下安装jdk,步骤如 ...

- Linux下安装和配置JDK与Tomcat(升级版)

在这个版本 Linux下安装和配置JDK与Tomcat(入门版) 的基础上优化升级 1.下载相关软件 apache-tomcat-6.0.37.tar.gz jdk-6u25-linux-i586-r ...

- Linux下安装cmake

cmake是一个跨平台的编译工具,特点是语句简单,编译高效,相对于原有的automake更为高效,接下来说明在Linux下安装cmake工具的过程 首先去cmake官网下载cmake安装包,下载界面网 ...

- linux下安装安装pcre-8.32

linux下安装安装pcre-8.32 ./configure --prefix=/usr/local/pcre 出现以下错误 configure: error: You need a C++ com ...

- CentOS linux下安装和配置Apache+SVN(用浏览器http方式访问SVN目录)

在CentOS linux下安装SVN,我们可以进行以下步骤: 第一步:安装CentOS Linux操作系统,并在CentOS安装进行的同时,自定义安装这一步,一定要勾选Subversion(在“开发 ...

随机推荐

- HM编码器代码阅读(14)——帧间预測之AMVP模式(二)predInterSearch函数

简单介绍 predInterSearch基本的工作是ME(运动预计)和MC(运动补偿). 函数中有一个bTestNormalMC变量.它表示是否进行正常的MC过程,正常的MC过程就是进 ...

- HTML border CSS输出三角形

有以下一段html代码: <!DOCTYPE html> <html lang="en"> <head> <meta charset=&q ...

- TP5结合聚合数据API查询天气

php根据城市查询天气情况看到有人分享java的查询全国天气情况的代码,于是我想分享一个php版本的查询天气接口.免费查询天气的接口有很多,比如百度的apistore的天气api接口,我本来想采用这个 ...

- eclipse 如何把java项目转成web项目

经常在eclipse中导入web项目时,出现转不了项目类型的问题,导入后就是一个java项目. 解决步骤: 1.进入项目目录,可看到.project文件,打开. 2.找到<natures> ...

- jQuery与ajax的应用(一)

<body> <div id="resText"></div> <div id="reshtml"></d ...

- android开发笔记之fastboot的使用

fastboot命令大全 在终端中.我们输入: fastboot 对于这些命令.我不解释,慢慢使用.慢慢的就会明确是怎么回事了. android分区 分区 作用 splash1 开机画面.使用Nand ...

- Lua学习七----------Lua函数

© 版权声明:本文为博主原创文章,转载请注明出处 1.Lua函数 - 完成指定的任务,这种情况下函数作为调用语句使用 - 计算并返回值,这种情况下函数作为赋值语句的表达式使用 - Lua函数可以返回多 ...

- 安装部署Solrcloud

实验说明: 三台虚拟机做solrcloud集群 安装solr前请确保jdk .tomcat.zookeeper已安装好,否则无法启动 三台虚拟机I ...

- 使用EasyPusher进行手机低延时直播推流便捷开发

基于EasyPusher sdk库工程(即library module)实现一个推送客户端非常简单便捷,因为sdk端已经将各种烦人的状态维护\错误检查\权限判定\UI同步等功能都实现了,开发者仅仅只需 ...

- vue入门(二) 让axios发送表单形式数据

(一) 使用 axios vue-axios qs 1.qs是必不可少的插件 npm install --save axios vue-axios qs 2.安装完成后,在main.js插入以下代码 ...