数据集成工具—Sqoop

数据集成/采集/同步工具

@

Sqoop简介

sqoop将关系型数据库(mysql、oracle等)数据与hadoop数据进行转换的工具。

sqoop1.4.x与sqoop1.99.x完全不兼容

Sqoop安装

安装包资源主页自取

1、上传并解压

tar -zxvf sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz -C /usr/local/soft/

2、修改文件夹名字

mv sqoop-1.4.7.bin__hadoop-2.6.0/ sqoop-1.4.7

3、修改配置文件

# 切换到sqoop配置文件目录

cd /usr/local/soft/sqoop-1.4.7/conf

# 复制配置文件并重命名

cp sqoop-env-template.sh sqoop-env.sh

# vim sqoop-env.sh 编辑配置文件,并加入以下内容

export HADOOP_COMMON_HOME=/usr/local/soft/hadoop-2.7.6

export HADOOP_MAPRED_HOME=/usr/local/soft/hadoop-2.7.6/share/hadoop/mapreduce

export HBASE_HOME=/usr/local/soft/hbase-1.4.6

export HIVE_HOME=/usr/local/soft/hive-1.2.1

export ZOOCFGDIR=/usr/local/soft/zookeeper-3.4.6/conf

export ZOOKEEPER_HOME=/usr/local/soft/zookeeper-3.4.6

# 切换到bin目录

cd /usr/local/soft/sqoop-1.4.7/bin

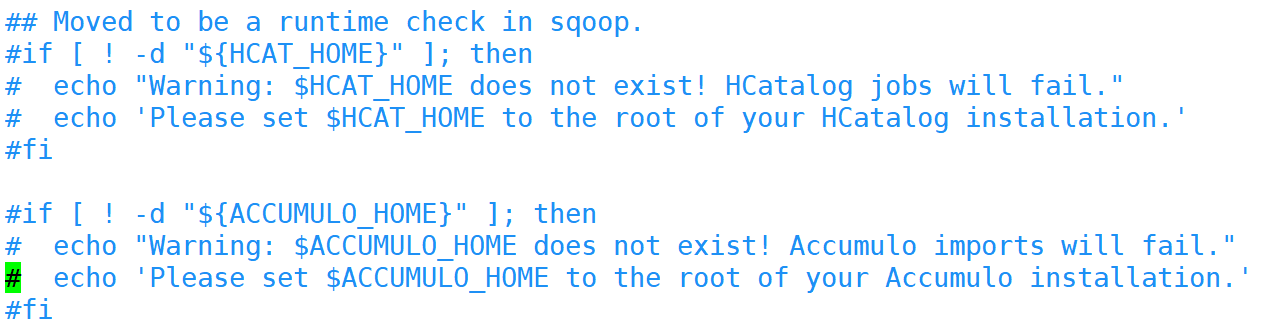

# vim configure-sqoop 修改配置文件,注释掉没用的内容(就是为了去掉警告信息)

4、修改环境变量

vim /etc/profile

# 将sqoop的目录加入环境变量

export SQOOP_HOME=/usr/local/soft/sqoop-1.4.7

5、添加MySQL连接驱动

# 从HIVE中复制MySQL连接驱动到$SQOOP_HOME/lib

cp /usr/local/soft/hive-1.2.1/lib/mysql-connector-java-5.1.49.jar /usr/local/soft/sqoop-1.4.7/lib/

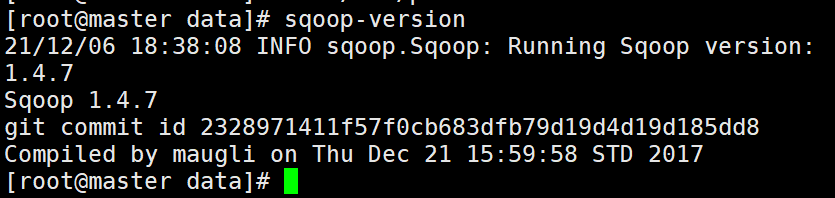

6、测试

# 打印sqoop版本

sqoop version

# 测试MySQL连通性

sqoop list-databases -connect jdbc:mysql://master:3306?useSSL=false -username root -password 123456

准备MySQL数据

登录MySQL数据库

mysql -u root -p123456;

创建student数据库

create database student;

切换数据库并导入数据

# mysql shell中执行

use student;

source /root/student.sql;

source /root/score.sql;

另外一种导入数据的方式

# linux shell中执行

mysql -u root -p123456 student</root/student.sql

mysql -u root -p123456 student</root/score.sql

使用Navicat运行SQL文件

也可以通过Navicat导入

导出MySQL数据库

mysqldump -u root -p123456 数据库名>/路径/任意一个文件名.sql

import

从传统的关系型数据库导入HDFS、HIVE、HBASE......

MySQLToHDFS

编写脚本,保存为MySQLToHDFS.conf

将下面内容写进脚本

import

--connect

jdbc:mysql://master:3306/student?useSSL=false

--username

root

--password

123456

--table

student

--m

2

--split-by

age

--target-dir

/sqoop/data/student1

--fields-terminated-by

','

属性解析

--m mapr任务

2 两个

--split-by 按照age切分

age

--target-dir hdfs路径

/sqoop/data/student1

--fields-terminated-by ',' 列之间的分隔符为,

运行方式一: 执行脚本

sqoop --options-file MySQLToHDFS.conf

运行方式二:直接在shell运行

sqoop import \

--connect \

jdbc:mysql://master:3306/student?useSSL=false \

--username \

root \

--password \

123456 \

--table \

student \

--m \

2 \

--split-by \

age \

--target-dir \

/sqoop/data/student1 \

--fields-terminated-by \

','

注意事项:

1、--m 表示指定生成多少个Map任务,不是越多越好,因为MySQL Server的承载能力有限。

2、当指定的Map任务数>1,那么需要结合--split-by参数,指定分割键,以确定每个map任务到底读取哪一部分数据,最好指定数值型的列,最好指定主键(或者分布均匀的列=>避免每个map任务处理的数据量差别过大),如果mysql建表时,设置了主键,并且是数值型,就会默认是按照主键切分,如果没有设置主键,报错。

3、如果指定的分割键数据分布不均,可能导致map端“数据倾斜”问题。

4、分割的键最好指定数值型的,而且字段的类型为int、bigint这样的数值型

5、编写脚本的时候,注意:例如:--username参数,参数值不能和参数名同一行

--username root // 错误的

// 应该分成两行

--username

root

6、运行的时候会报错InterruptedException,hadoop2.7.6自带的问题,忽略即可

21/01/25 14:32:32 WARN hdfs.DFSClient: Caught exception

java.lang.InterruptedException

at java.lang.Object.wait(Native Method)

at java.lang.Thread.join(Thread.java:1252)

at java.lang.Thread.join(Thread.java:1326)

at org.apache.hadoop.hdfs.DFSOutputStream$DataStreamer.closeResponder(DFSOutputStream.java:716)

at org.apache.hadoop.hdfs.DFSOutputStream$DataStreamer.endBlock(DFSOutputStream.java:476)

at org.apache.hadoop.hdfs.DFSOutputStream$DataStreamer.run(DFSOutputStream.java:652)

7、实际上sqoop在读取mysql数据的时候,用的是JDBC的方式,所以当数据量大的时候,效率不是很高。

8、sqoop底层通过MapReduce完成数据导入导出,只需要Map任务,不需要Reduce任务

9、每个Map任务会生成一个文件。

MySQLToHive

Sqoop 导入数据到 Hive 是通过先将数据导入到 HDFS 上的临时目录,然后再将数据从 HDFS 上 Load 到 Hive 中,最后将临时目录删除。可以使用 target-dir 来指定临时目录。

在Hive中创建testsqoop库

hive> create database testsqoop;

编写脚本,并保存为MySQLToHIVE.conf文件

import

--connect

jdbc:mysql://master:3306/student?useSSL=false

--username

root

--password

123456

--table

score

--fields-terminated-by

"\t"

--lines-terminated-by

"\n"

--m

3

--split-by

student_id

--hive-import

--hive-overwrite

--create-hive-table

--hive-database

testsqoop

--hive-table

score

--delete-target-dir

直接运行报错

将HADOOP_CLASSPATH加入环境变量中

vim /etc/profile

# 加入如下内容

export HADOOP_CLASSPATH=$HADOOP_HOME/lib:$HIVE_HOME/lib/*

# 重新加载环境变量

source /etc/profile

将hive-site.xml放入SQOOP_HOME/conf/

cp /usr/local/soft/hive-1.2.1/conf/hive-site.xml /usr/local/soft/sqoop-1.4.7/conf/

执行脚本

sqoop --options-file MySQLToHIVE.conf

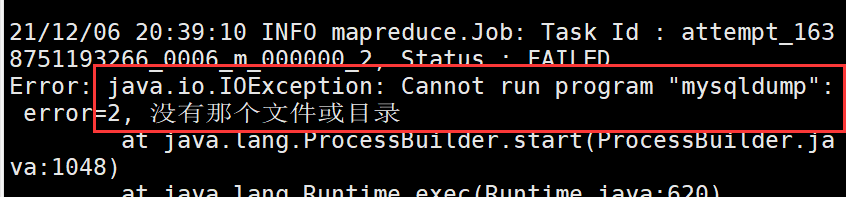

--direct

加上这个参数,可以在导出MySQL数据的时候,使用MySQL提供的导出工具mysqldump,加快导出速度,提高效率

直接加上--direct,运行后报错

需要将master上的/usr/bin/mysqldump分发至 node1、node2的/usr/bin目录下

mapreduce任务在nodeManager上面执行的

scp /usr/bin/mysqldump node1:/usr/bin/

scp /usr/bin/mysqldump node2:/usr/bin/

-e参数的使用

-e 可以在后面加上sql语句

"select * from score where student_id=1500100011 and $CONDITIONS"

import

--connect

jdbc:mysql://master:3306/student

--username

root

--password

123456

--fields-terminated-by

"\t"

--lines-terminated-by

"\n"

--m

2

--split-by

student_id

--e

"select * from score where student_id=1500100011 and $CONDITIONS"

--target-dir

/testQ

--hive-import

--hive-overwrite

--create-hive-table

--hive-database

testsqoop

--hive-table

score2

MySQLToHBase

编写脚本,并保存为MySQLToHBase.conf

import

--connect

jdbc:mysql://master:3306/student?useSSL=false

--username

root

--password

123456

--table

student

--hbase-table

student

--hbase-create-table

--hbase-row-key

id

--m

1

--column-family

cf1

在HBase中创建student表

create 'student','cf1'

执行脚本

sqoop --options-file MySQLToHBase.conf

export

HDFSToMySQL

编写脚本,并保存为HDFSToMySQL.conf

export

--connect

jdbc:mysql://master:3306/student?useSSL=false

--username

root

--password

123456

--table

student

-m

1

--columns

id,name,age,gender,clazz

--export-dir

/sqoop/data/student1/

--fields-terminated-by

','

先清空MySQL student表中的数据,不然会造成主键冲突

执行脚本

sqoop --options-file HDFSToMySQL.conf

查看sqoop help

sqoop help

21/04/26 15:50:36 INFO sqoop.Sqoop: Running Sqoop version: 1.4.6

usage: sqoop COMMAND [ARGS]

Available commands:

codegen Generate code to interact with database records

create-hive-table Import a table definition into Hive

eval Evaluate a SQL statement and display the results

export Export an HDFS directory to a database table

help List available commands

import Import a table from a database to HDFS

import-all-tables Import tables from a database to HDFS

import-mainframe Import datasets from a mainframe server to HDFS

job Work with saved jobs

list-databases List available databases on a server

list-tables List available tables in a database

merge Merge results of incremental imports

metastore Run a standalone Sqoop metastore

version Display version information

See 'sqoop help COMMAND' for information on a specific command.

# 查看import的详细帮助

sqoop import --help

sqoop官网:

数据集成工具—Sqoop的更多相关文章

- 数据集成工具Kettle、Sqoop、DataX的比较

数据集成工具很多,下面是几个使用比较多的开源工具. 1.阿里开源软件:DataX DataX 是一个异构数据源离线同步工具,致力于实现包括关系型数据库(MySQL.Oracle等).H ...

- 数据集成工具Teiid Designer的环境搭建

由于实验室项目要求的关系,看了些数据汇聚工具 Teiid 的相关知识.这里总结下 Teiid 的可视化配置工具 Teiid Designer 的部署过程. 背景知识 数据集成是把不同来源.格式.特点性 ...

- 数据集成工具:Teiid实践

数据集成是把不同来源.格式.特点性质的数据在逻辑上或物理上有机地集中,从而为企业提供全面的数据共享.数据集成的方式多种多样,这里介绍的 Teiid 是其中的一种:通过抽象和联邦技术,实现分布式数据源的 ...

- 数据同步工具Sqoop和DataX

在日常大数据生产环境中,经常会有集群数据集和关系型数据库互相转换的需求,在需求选择的初期解决问题的方法----数据同步工具就应运而生了.此次我们选择两款生产环境常用的数据同步工具进行讨论 Sqoop ...

- 数据集成工具—FlinkX

@ 目录 FlinkX的安装与简单使用 FlinkX的安装 FlinkX的简单使用 读取mysql中student表中数据 FlinkX本地运行 MySQLToHDFS MySQLToHive MyS ...

- 【ODI】| 数据ETL:从零开始使用Oracle ODI完成数据集成(一)

0. 环境说明及软件准备 ODI(Oracle Data Integrator)是Oracle公司提供的一种数据集成工具,能高效地实现批量数据的抽取.转换和加载.ODI可以实现当今大多数的主流关系型数 ...

- [Hadoop 周边] Hadoop和大数据:60款顶级大数据开源工具(2015-10-27)【转】

说到处理大数据的工具,普通的开源解决方案(尤其是Apache Hadoop)堪称中流砥柱.弗雷斯特调研公司的分析师Mike Gualtieri最近预测,在接下来几年,“100%的大公司”会采用Hado ...

- Hadoop和大数据:60款顶级大数据开源工具

一.Hadoop相关工具 1. Hadoop Apache的Hadoop项目已几乎与大数据划上了等号.它不断壮大起来,已成为一个完整的生态系统,众多开源工具面向高度扩展的分布式计算. 支持的操作系统: ...

- 【转载】Hadoop和大数据:60款顶级大数据开源工具

一.Hadoop相关工具 1. Hadoop Apache的Hadoop项目已几乎与大数据划上了等号.它不断壮大起来,已成为一个完整的生态系统,众多开源工具面向高度扩展的分布式计算. 支持的操作系统: ...

随机推荐

- 二叉树中和为某一值的路径 牛客网 程序员面试金典 C++ Python

二叉树中和为某一值的路径 牛客网 程序员面试金典 题目描述 输入一颗二叉树的跟节点和一个整数,打印出二叉树中结点值的和为输入整数的所有路径.路径定义为从树的根结点开始往下一直到叶结点所经过的结点形成一 ...

- Luogu P1525 [NOIp2010提高组]关押罪犯 | 并查集

题目链接 这一道题,我用了并查集来做.在此题中,并查集的作用就是:将同一个监狱里的罪犯合并到一起. 思路:将每对罪犯之间的怨气值从大到小排序,再依次把他们分到不同的两个监狱里,当发现这一对罪犯已经在同 ...

- robot_framewok自动化测试--(5)Screenshot 库

Screenshot 库 Scrennshot 同样为 Robot Framework 标准类库,我们只将它提供的其它中一个关键字"TakeScreenshot",它用于截取到当前 ...

- Python基础入门(2)- python中的数据类型

python数据类型 什么是数据类型? 将数据分类,能有效的被电脑识别 为什么会有多种数据类型? 为了适应更多的使用场景,将数据划分为多种类型,每一种类型都有着各自的特点和使用场景,帮助计算机高效的处 ...

- 美妙绝伦面向node引用-zico图标(逐浪矢量全真图标)1.9发布

15年前,那个农村小伙初入广告行业被讥笑没有审美 于是他狠下决心,积极研发,缔就技术之核, 再后来,那些PPT和美工er们随便怎么自好,无法让其心怵. 因为他是中华人民共和国唯一具备web.cms.o ...

- Python基础(递归函数)

def age(n): if n == 1: return 18 else: return age(n - 1) + 2 ret=age(100) print(ret)#216 def test(nu ...

- python实现圆检测

目录: (一)霍夫圆检测原理 (二)代码实现 (一)霍夫圆检测原理 (二)代码实现 1 #霍夫圆检测 2 import cv2 as cv 3 import numpy as np 4 5 def d ...

- [luogu7092]计数题

由于$\mu(i)$,因此每一个素数最多存在1次,当$k=0$答案必然为0 根据莫比乌斯和欧拉函数的积性,答案与对素数的划分无关,仅与每一个素数是否出现有关,换言之枚举素数出现的集合$P'$,答案即为 ...

- [bzoj1934]善意的投票

最小割,考虑最小割就是要将整张图分为两块,本题中就分别表示赞同和不赞同,那么首先一开始赞同的点向S连边,不赞同的点向T连边,如果这些点分到了另一边就要割掉这条边,朋友关系同理,连双向边同样表示分到两边 ...

- [bzoj1084]最大子矩阵

用f[i][j][k]表示第一行前i个数,第二行前j个数选k个子矩形的答案,考虑转移:1.在第一行/第二行选择一个矩形2.当i=j时,可以选择一个两行的矩形注意要特判m=1的情况 1 #include ...