Riche, N., Mancas, M., Duvinage, M., Mibulumukini, M., Gosselin, B., & Dutoit, T. (2013). RARE2012: A multi-scale rarity-based saliency detection with its comparative statistical analysis. Signal Processing: Image Communication, 28(6), 642–658.

https://doi.org/10.1016/j.image.2013.03.009

一篇老早老早以前的文章啦,今天看到有文章使用它的方法,特地拜读下。

视觉注意力机制这东西我们感兴趣,那就是因为它有用呀。比如帮助人机交互界面优化,让用户使用交互按钮更加舒服;广告设计的评估;视频图像数据压缩,着重保留更感兴趣的图像信息。机器人的视觉感知等等吧。

关于人类的视觉注意力的通用定义,不知道现在生物学上有没有研究明白这是怎么回事,反正在这篇文章发表的时候是没有滴。但是一般意义上讲,人类的注意力可以定义为对传入刺激进行优先排序并有选择地关注其中一部分的自然能力。行,有个初步的定义也好呀。那视觉上的注意力咋搞呢,大脑接收到的图像信号并不只是一个待排序的信号序列呀。

在计算机视觉中,对注意力机制的探索大部分依赖于“saliency maps”这一概念,字面意思就是“显著性图”。简单来讲,“saliency maps”就是对某一个模型的输入信号做了一个映射,映射的结果就是,对模型比较重要的信号会得到一个较强的相应。

那么对于视觉注意力机制来讲,输入就是图像;人眼容易被吸引的地方就是比较重要的信号。所以,解释视觉注意力机制,就是想找到一个更好的“saliency maps”。它应该迅速的根据输入图像告诉我们,那些地方对我们的视觉感知系统非常有吸引力。

按照这样的思路,“saliency maps”中就包含了两种机制。一种是自下而上的注意力,也称为刺激驱动的或外在的注意力。另一种是自上而下的,也称为任务驱动的或内生的注意力,它集成了观察者在特定情况下可能具有的特定知识(任务,场景类型的模型,可识别的对象等)。而RARE2012纯粹是自下而上的,因为自下而上的方法性能更好。就是完全依靠输入图像信息,不需要考虑其他决策机制,当然性能更好辣。

文章对比了当年流行的好几种 方法,结论就是他们的方法挺好。哈哈哈

-------------------------------------------------------------------------------------------

第一步:首先用主成分分析PCA的方法,把rgb三通道的图像映射到三个线性不相关空间。就是拆分成了三个通道,这三个通道中,channal1主要包含亮度信息,而channal2和channal3则包含色度的信息。但是三个通道的信息都是独立的。看起来它的三个通道有点像hsv嘛,hsv就是明度、色调和饱和度。不过具体怎样分解的我不知道哦,还要看源码,文章中没说。

第二步:对三个通道的图像直接用PCA计算rarity。哎,这里还是得看源码,对图像进行主成分分析得到降维我可以理解,那上边用PCA方法拆分通道是咋回事呢?不管如何,这样做得到了三张rarity分布图。这样做就是在提取图像中的低级颜色特征,当然也包括亮度分布特征。

第三步:然后再对上述三个通道图像利用Gabor滤波器提取方向特征图。选择Gabor滤波器是因为Gabor类似于大脑中视觉皮层(V1)的简单神经处理过程。

Gabor与人类视觉系统中简单细胞的视觉刺激响应非常相似。它在提取目标的局部空间和频率域信息方面具有良好的特性。Gabor小波对于图像的边缘敏感,能够提供良好的方向选择和尺度选择特性,而且对于光照变化不敏感,能够提供对光照变化良好的适应性。

用Gabor 函数形成的二维Gabor 滤波器具有在空间域和频率域同时取得最优局部化的特性,因此能够很好地描述对应于空间频率(尺度)、空间位置及方向选择性的局部结构信息。Gabor就是用来提取图像中的空间方向和纹理特征。

文章中对Gabor分别输入8个方向,这样对于一幅输入图像来讲,一共会有8个结果。这8幅输出要融合到1张输出图像中。

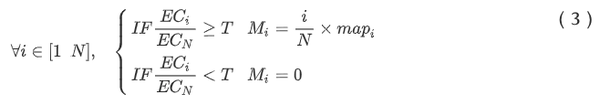

根据EC大小对8张方向图排序。每张方向图都乘以权重:i/N 。N=8,i就是这张方向图的EC排第几位。文中设了一个阈值,筛选掉EC太小的方向图:

这样PCA方法得到的三张图像channal1、channal2和channal3经过Gabor提取到了3幅纹理方向的rarity图。

-------------------------------------------------------------------------------------------

这一阶段的稀有度机制才是rare2012的关键,毕竟名字就是这个嘛。

方法就是:统计在设定的尺度范围内,该像素出现的频率。

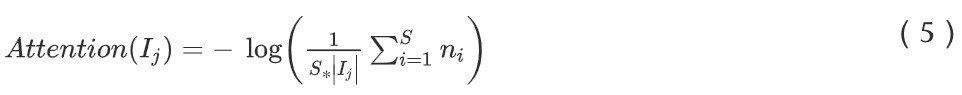

n_i 是当前像素j的灰度值为i的概率(比例),

n_i 就是根据rarity图的直方图得到的。这个公式说的有点不明不白的,S是啥?看起来是没有归一化的rarity图中的灰度最大值。不管怎样,它的思想就是统计图像中某一灰度出现的频率,认为是某一个灰度在局部区域出现的概率。这就是该像素的注意力得分,就是Attention()。

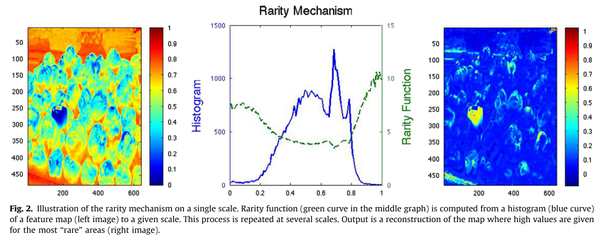

Fig. 2中给出了一个例子,输入左图,蓝色的区域在整幅图像中出现的概率较低,那么它在稀有度图中的值就偏高。

第二阶段中,对第一阶段得到的6张map计算attention。

-------------------------------------------------------------------------------------------

对第二阶段得到的6张attention map进行融合操作。

首先是通道内融合,由channal1得到的颜色特征图和纹理方向图计算attention后,进行融合。融合方法为:

就是EC和map点乘。这里出现了S哦,不过它是不是公式5中的S呢,这个要看下源码,论文中没说。N=2,为啥是2,哪里来的两张图,也不明白。

先不管这些地方,看最后,rare2012是如何得到最终的输出的:

根据第三阶段的融合操作,三个通道的图像最后输出了三个结果。

这三个结果再融合起来,就是最后的输出了。融合的方法就是第一阶段的第三步,融合gabor后的8张图像的方法。首先计算效率系数,然后排序,然后乘权重,阈值筛选。

rare2012是由rare2007和rare2011发展而来,每一次改进都带来的一些创新。性能更好,考虑的特征更全面。俺么rare2012结果如何?

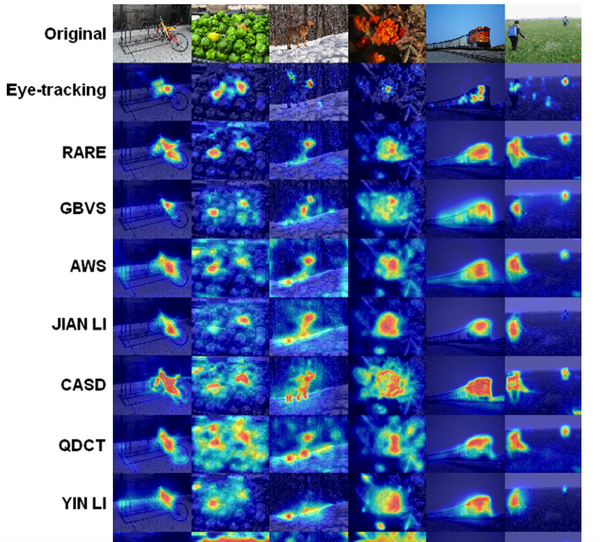

对比结果中,上面是眼动监测的结果,也就是人眼实际的聚焦情况。下面是rare2012的结果。看起来挺好的嘛。

但是rare2012有时也有完全出错的时候。fig7中后面三个数据的结果,rare2012都错了。看来注意力机制还是要引入充分合理的自上而下的逻辑判断。

不过rare2012在当年对比同类模型,还是相当有优势的。当然论文中有定量的性能和准确率分析。

- (读论文)推荐系统之ctr预估-NFM模型解析

本系列的第六篇,一起读论文~ 本人才疏学浅,不足之处欢迎大家指出和交流. 今天要分享的是另一个Deep模型NFM(串行结构).NFM也是用FM+DNN来对问题建模的,相比于之前提到的Wide& ...

- 读论文系列:Deep transfer learning person re-identification

读论文系列:Deep transfer learning person re-identification arxiv 2016 by Mengyue Geng, Yaowei Wang, Tao X ...

- (读论文)推荐系统之ctr预估-DeepFM模型解析

今天第二篇(最近更新的都是Deep模型,传统的线性模型会后面找个时间更新的哈).本篇介绍华为的DeepFM模型 (2017年),此模型在 Wide&Deep 的基础上进行改进,成功解决了一些问 ...

- 读论文系列:Object Detection SPP-net

本文为您解读SPP-net: Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition Motivat ...

- Deep Learning 33:读论文“Densely Connected Convolutional Networks”-------DenseNet 简单理解

一.读前说明 1.论文"Densely Connected Convolutional Networks"是现在为止效果最好的CNN架构,比Resnet还好,有必要学习一下它为什么 ...

- Deep Learning 24:读论文“Batch-normalized Maxout Network in Network”——mnist错误率为0.24%

读本篇论文“Batch-normalized Maxout Network in Network”的原因在它的mnist错误率为0.24%,世界排名第4.并且代码是用matlab写的,本人还没装caf ...

- Deep Learning 23:dropout理解_之读论文“Improving neural networks by preventing co-adaptation of feature detectors”

理论知识:Deep learning:四十一(Dropout简单理解).深度学习(二十二)Dropout浅层理解与实现.“Improving neural networks by preventing ...

- Deep Learning 18:DBM的学习及练习_读论文“Deep Boltzmann Machines”的笔记

前言 论文“Deep Boltzmann Machines”是Geoffrey Hinton和他的大牛学生Ruslan Salakhutdinov在论文“Reducing the Dimensiona ...

- Deep Learning 16:用自编码器对数据进行降维_读论文“Reducing the Dimensionality of Data with Neural Networks”的笔记

前言 论文“Reducing the Dimensionality of Data with Neural Networks”是深度学习鼻祖hinton于2006年发表于<SCIENCE > ...

随机推荐

- hdu 2807 The Shortest Path(矩阵+floyd)

The Shortest Path Time Limit: 4000/2000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others ...

- poj1741 树上距离小于等于k的对数 点分治 入门题

#include <iostream> #include <stdio.h> #include <string.h> #include <algorithm& ...

- 用JavaScript判断网站是在手机端还是在PC端打开的方法

我们可以在网站的首页加上一段JavaScript代码对用户的浏览器进行判断,从而显示不同的网址,代码如下: <script type="text/javascript"> ...

- 怎么查看mysql 的binlog日志存放的位置

image.png 这个你可以看配置文件 启用了才有这样的记录默认是没有的 linux系统中的/etc/my.cnf my.cnf内容: log-bin = mysqlbin # 默认配置 一般放在/ ...

- 防止SyntaxHighlighter.js的闪烁闪一下的方法

SyntaxHighlighter.js是一个代码高亮的JS插件,使用也很简单,但是由于是浏览器段执行JS代码来着色,会出现视觉上闪一下的效果.比如你的20行代码网页打开显示高度为100px,但是Sy ...

- H3C 总线型以太网拓扑扩展

- C#循环语句练习(三)

for循环拥有两类:一.穷举:把所有可能的情况都走一遍,使用if条件筛选出来满足条件的情况. (1).羽毛球拍15元,球3元,水2元.200元每种至少一个,有多少可能. (2).百鸡百钱:公鸡2文钱一 ...

- pycharm下的多个python版本共存(二)

上一篇博文介绍了在windows下同时安装python2和python3.而在工作的过程中,我习惯于用pycharm作为IDE.本文将记录如何在pycharm中选择python版本,并给相应的版本安装 ...

- H3C IGP与EGP

- java 反射和泛型-反射来获取泛型信息

通过指定对应的Class对象,程序可以获得该类里面所有的Field,不管该Field使用private 方法public.获得Field对象后都可以使用getType()来获取其类型. Class&l ...