Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网。

使用VMW安装四台CentOS-7-x86_64-DVD-1804.iso虚拟机:

计划配置三台centos虚拟机:

master:192.168.0.120

slave1:192.168.0.121

slave2:192.168.0.122

slave3:192.168.0.123

资源分配情况:

每台虚拟机分配:内存2G,CPU核数1个,磁盘20G。

VMW配置及本地IPv4上网配置情况:

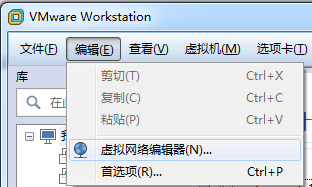

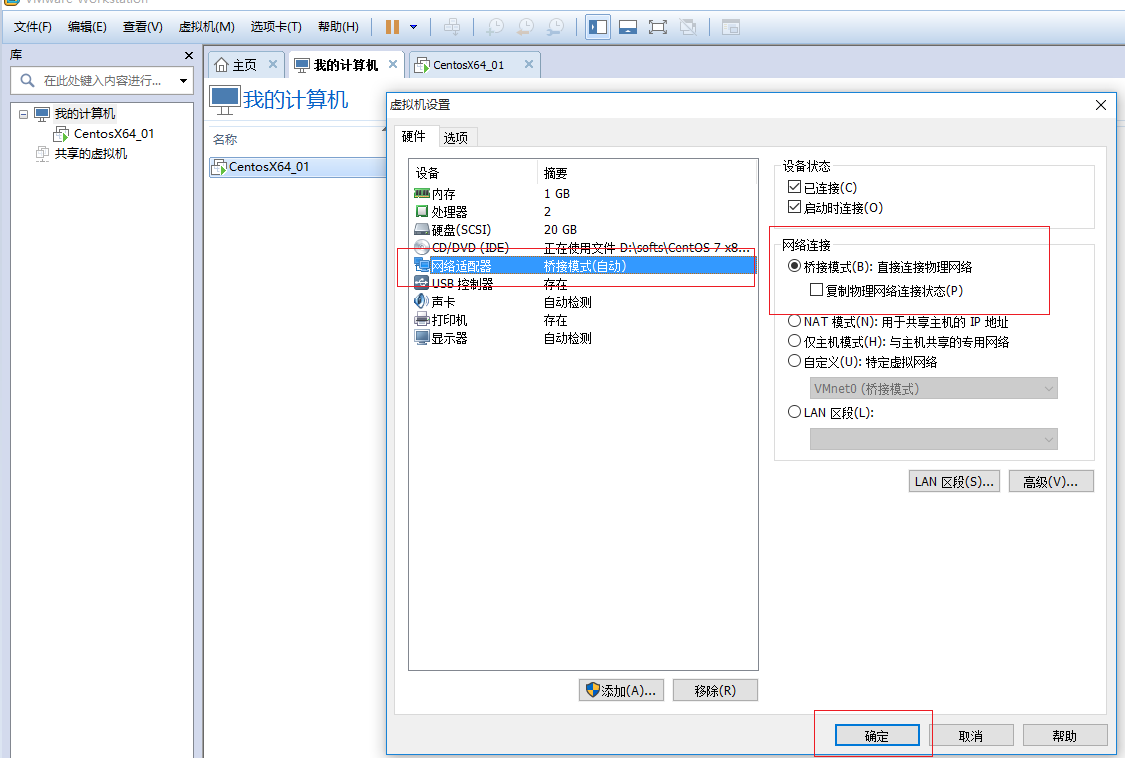

安装VMW,并设置其连接方式为桥接方式:

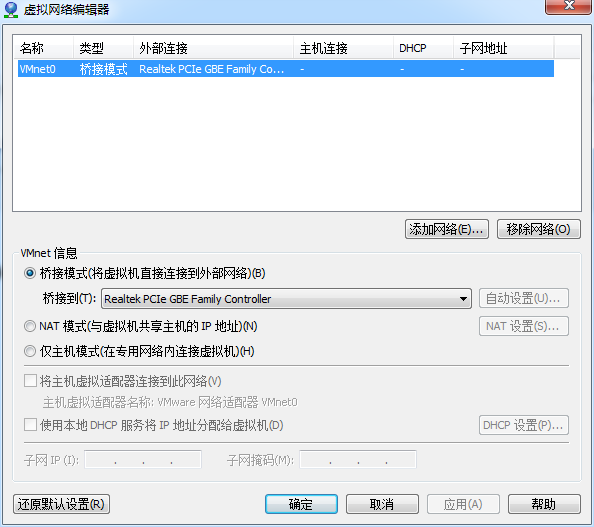

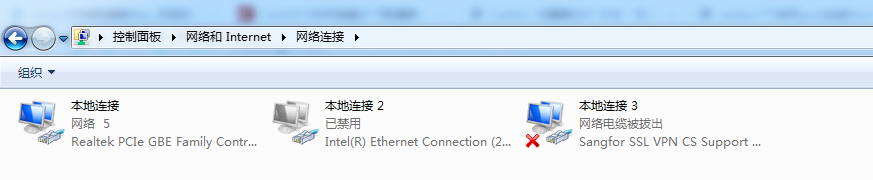

本地网络适配器除了“本地连接”外,其他都禁用:

本地连接的IPV4配置,这里采用的自适应方式:

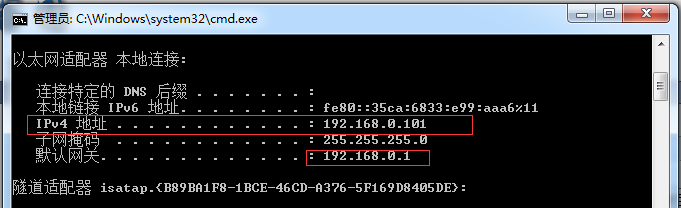

本地ipconfig如下:

安装CentOS

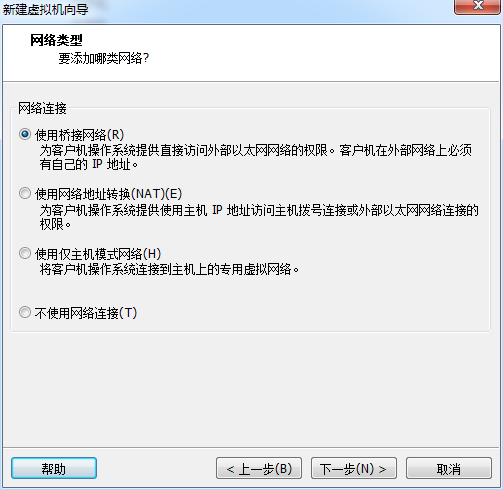

安装CentOS时,采用上网方式选取“使用桥接网络”:

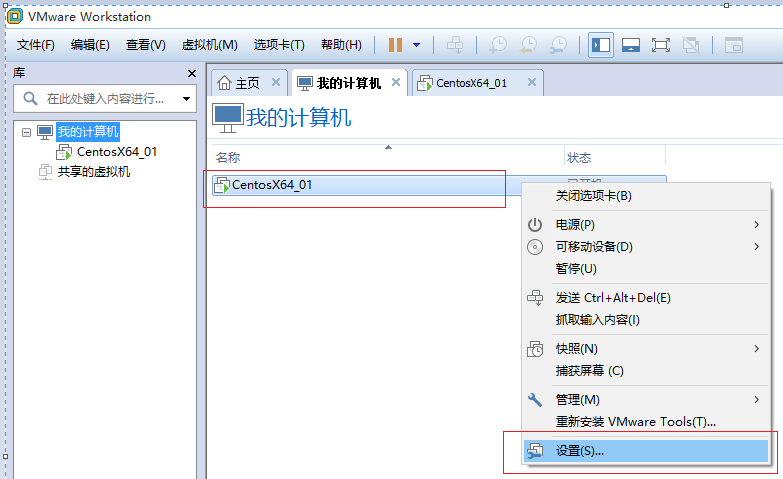

安装完后,确认是否采用“桥接”方式:

安装完后配置静态ip,dns及测试

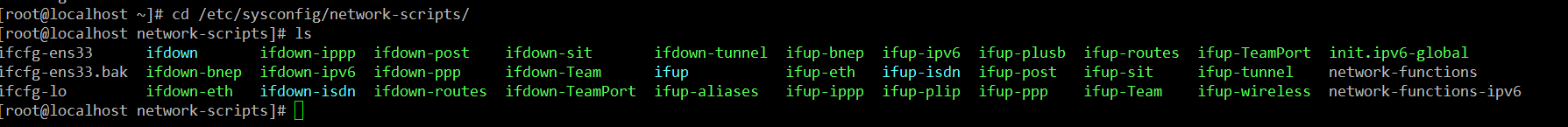

1)备份/etc/sysconfig/network-scripts/ifcfg-ens333

cd /etc/sysconfig/network-scripts/

scp ifcfg-ens333 ifcfg-ens333.bak

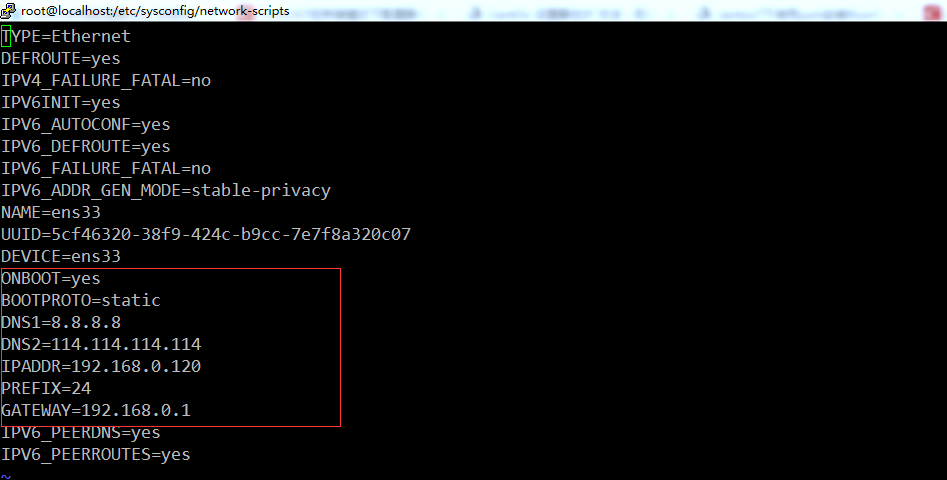

2)修改vi /etc/sysconfig/network-scripts/ifcfg-ens333

TYPE=Ethernet

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=5cf46320-38f9-424c-b9cc-7e7f8a320c07 #每台服务器的该地址不同,请使用自己的虚拟机的UUID。

DEVICE=ens33

ONBOOT=yes

BOOTPROTO=static

DNS1=8.8.8.8

DNS2=114.114.114.114

IPADDR=192.168.0.120

PREFIX=

GATEWAY=192.168.0.1

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

注意:图中圈中的配置信息是重点配置信息。

3)配置/etc/sysconfig/network:

# Created by anaconda

NETWORKING=yes

HOSTNAME=master

GATEWAY=192.168.0.1

slave节点,以slave1为例:

# Created by anaconda

NETWORKING=yes

HOSTNAME=slave1

GATEWAY=192.168.0.1

4)配置/etc/resolv.conf

# Generated by NetworkManager

nameserver 8.8.8.8

nameserver 114.114.114.114

注意:该信息也可以不配置,当重启网络后,会自动配置。

5)设置host名称

master(192.168.0.120)执行:

hostnamectl --static set-hostname master

hostnamectl status

slave1(192.168.0.121)执行:

hostnamectl --static set-hostname slave1

hostnamectl status

slave2(192.168.0.122)执行:

hostnamectl --static set-hostname slave2

hostnamectl status

slave3(192.168.0.123)执行:

hostnamectl --static set-hostname slave3

hostnamectl status

6)重启网络,测试:

[root@localhost network-scripts]# service network restart

Restarting network (via systemctl): [ OK ]

[root@localhost network-scripts]#

测试1:是否host名称修改成功

[spark@master ~]$ hostname

master

slave1,slave2,slave3依次验证。

测试2:是否可以连接本地

[root@localhost network-scripts]# ping 192.168.0.1

PING 192.168.0.1 (192.168.0.1) () bytes of data.

bytes from 192.168.0.1: icmp_seq= ttl= time=1.23 ms

bytes from 192.168.0.1: icmp_seq= ttl= time=1.13 ms

bytes from 192.168.0.1: icmp_seq= ttl= time=1.02 ms

测试3:是否可以连接其他虚拟机

[root@localhost network-scripts]# ping 192.168.0.121

PING 192.168.0.121 (192.168.0.121) () bytes of data.

bytes from 192.168.0.121: icmp_seq= ttl= time=0.860 ms

bytes from 192.168.0.121: icmp_seq= ttl= time=0.404 ms

测试4:是否可以上网,是否可以解析域名

[root@localhost network-scripts]# ping www.baidu.com

PING www.baidu.com (61.135.169.125) () bytes of data.

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=2.92 ms

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=4.46 ms

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=3.98 ms

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=2.83 ms

到此,所有服务器按照这么安装验证,经过上边三个测试验证就说明静态ip配置成功。

重启后,发现某一台服务器的不能的ifcfg-ens33配置的ip失效解决方案:《Centos7:Failed to start LSB: Bring up/down networking

》

Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网。的更多相关文章

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十四)Structured Streaming:Encoder

一般情况下我们在使用Dataset<Row>进行groupByKey时,你会发现这个方法最后一个参数需要一个encoder,那么这些encoder如何定义呢? 一般数据类型 static ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十一)NIFI1.7.1安装

一.nifi基本配置 1. 修改各节点主机名,修改/etc/hosts文件内容. 192.168.0.120 master 192.168.0.121 slave1 192.168.0.122 sla ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十三)kafka+spark streaming打包好的程序提交时提示虚拟内存不足(Container is running beyond virtual memory limits. Current usage: 119.5 MB of 1 GB physical memory used; 2.2 GB of 2.1 G)

异常问题:Container is running beyond virtual memory limits. Current usage: 119.5 MB of 1 GB physical mem ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十二)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网。

Centos7出现异常:Failed to start LSB: Bring up/down networking. 按照<Kafka:ZK+Kafka+Spark Streaming集群环境搭 ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十一)定制一个arvo格式文件发送到kafka的topic,通过Structured Streaming读取kafka的数据

将arvo格式数据发送到kafka的topic 第一步:定制avro schema: { "type": "record", "name": ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十)安装hadoop2.9.0搭建HA

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(九)安装kafka_2.11-1.1.0

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(八)安装zookeeper-3.4.12

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(三)安装spark2.2.1

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二)安装hadoop2.9.0

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

随机推荐

- dp和px,那些不得不吐槽的故事——Android平台图片文字元素单位浅析 (转)

一个优秀的手机软件,不仅要有精巧的功能,流畅的速度,让人赏心悦目的UI也往往是用户选择的重要理由.作为移动产品的PM,也需要了解一些在UI设计中的基本知识. 1. px和pt,一对好伙伴 在视觉设计中 ...

- Yarn使用简介

Yarn是由Facebook.Google.Exponent 和 Tilde 联合推出了一个新的 JS 包管理工具 , 它主要是为了弥补 npm 的一些缺陷而出现的.和npm相比,它具有如下特点: 速 ...

- oracle HA 高可用性具体解释(之二,深入解析TAF,以及HA框架)

oracle HA 高可用性具体解释(之中的一个,client.server端服务具体解释):http://write.blog.csdn.net/postedit 我们已经看到TAF是的Oracle ...

- Flex+blazeds实现与mySQL数据库的连接(已成功实现此文的例子)

http://bdk82924.iteye.com/blog/1067285 几个下载地址 blazeds_turnkey_3-0-0-544.zip 下载地址:http://download.mac ...

- AngularJS中实现显示或隐藏动画效果的3种方式

本篇体验在AngularJS中实现在"显示/隐藏"这2种状态切换间添加动画效果. 通过CSS方式实现显示/隐藏动画效果 思路: →npm install angular-anima ...

- AngularJS一个由于未声明对象而报的错

实现这样的一个需求:点击某个按钮,然后显示或隐藏某块区域. 先注册一个AngularJS的一个module: var myApp = angular.module("myApp", ...

- 在VC中使用SendInput函数实现中文的自动输入

很早以前写了一个刷卡程序,功能是定时监控读卡器,当发现有IC卡放到读卡器上后,自动识别出卡号,然后带着这个卡号搜索一个英文用户名和卡号的对照表,最后把英文用户名直接自动输入到当前光标所在的位置.本来程 ...

- nginx网站攻击防护

1.上上个月架构全部迁移上云以后,总的来说比较稳定,业务量也上来,可爱的坏人也来了,7X24小时不停恶意攻击我的网站,第一次收到报警是网站流入流量1分钟以内连续3次超过1000000bps,换算下1M ...

- ibatis.net:第七天,QueryWithRowDelegate

xml <statement id="FindOrdersByCustomer" parameterClass="string" resultClass= ...

- Android之sqlite3命令行简单使用

首先需要定位到database所在的目录里面,然后使用命令 sqlite3 databasename(数据库的名字)进入 常用命令: 1. .table 列取该数据库下面的数据表名 2. .s ...