OSS文件上传及OSS与ODPS之间数据连通

场景描述

实现目标

准备工作

OSS是个什么东东?

为什么选用云产品OSS服务呢?

OSS控制台限制条件?

需要注意几点

本地大文件分片上传到OSS

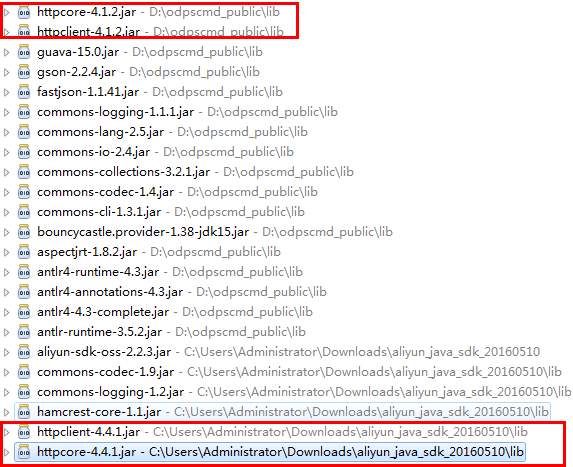

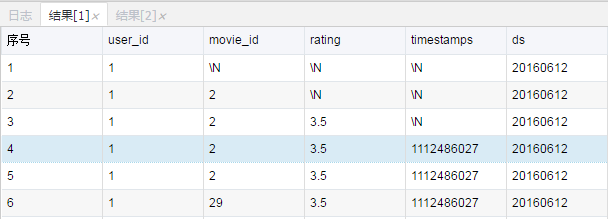

单线程实现将OSS文件上传至ODPS(OSS java-SDK与tunnel SDK结合)

多线程实现将OSS文件上传至ODPS(OSS java-SDK与tunnel SDK结合)

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.util.ArrayList;

import java.util.concurrent.Callable;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors; import com.aliyun.odps.Column;

import com.aliyun.odps.Odps;

import com.aliyun.odps.PartitionSpec;

import com.aliyun.odps.TableSchema;

import com.aliyun.odps.account.Account;

import com.aliyun.odps.account.AliyunAccount;

import com.aliyun.odps.data.Record;

import com.aliyun.odps.data.RecordWriter;

import com.aliyun.odps.tunnel.TableTunnel;

import com.aliyun.odps.tunnel.TableTunnel.UploadSession;

import com.aliyun.odps.tunnel.TunnelException;

import com.aliyun.oss.OSSClient;

import com.aliyun.oss.model.GetObjectRequest;

import com.aliyun.oss.model.OSSObject; class UploadThread implements Callable<Boolean> {

private long id;

private TableSchema schema = null;

private RecordWriter recordWriter = null;

private Record record = null;

private BufferedReader reader = null; public UploadThread(long id, RecordWriter recordWriter, Record record,

TableSchema schema,BufferedReader reader) {

this.id = id;

this.recordWriter = recordWriter;

this.record = record;

this.schema = schema;

this.reader = reader;

} public Boolean call() throws Exception {

while (true) {

String line = reader.readLine();

if (line == null) break;

if(id == 0){ //第一行是字段名,忽略掉

id++;

continue;

}

System.out.println(line);

String[] s = line.split(",");

for (int i = 0; i < schema.getColumns().size(); i++) {

Column column = schema.getColumn(i);

switch (column.getType()) {

case BIGINT:

record.setBigint(i, Long.valueOf(s[i]));

break;

// case BOOLEAN:

// record.setBoolean(i, str);

// break;

// case DATETIME:

// record.setDatetime(i, str);

// break;

case DOUBLE:

record.setDouble(i, Double.valueOf(s[i]));

break;

case STRING:

record.setString(i,s[i]);

break;

default:

throw new RuntimeException("Unknown column type: "

+ column.getType());

}

}

recordWriter.write(record);

}

recordWriter.close();

return true;

}

} public class OSSToODPS_UploadThread {

private static String accessKeyId = "UQV2yoSSWNgquhhe";

private static String accessKeySecret = "bG8xSLwhmKYRmtBoE3HbhOBYXvknG6"; private static String endpoint = "http://oss-cn-hangzhou.aliyuncs.com";

private static String bucketName = "qf-test";

private static String key = "data_test/movies.csv"; private static String tunnelUrl = "http://dt.odps.aliyun.com";

private static String odpsUrl = "http://service.odps.aliyun.com/api";

private static String project = "dtstack_dev";

private static String table = "movies_odps2";

//private static String partition = "ds=20160612"; private static int threadNum = 10; public static void main(String args[]) {

/*

* Constructs a client instance with your account for accessing OSS

*/

OSSClient client = new OSSClient(endpoint, accessKeyId, accessKeySecret);

System.out.println("Downloading an object");

OSSObject object = client.getObject(new GetObjectRequest(bucketName, key));

BufferedReader reader = new BufferedReader(new InputStreamReader(object.getObjectContent())); Account account = new AliyunAccount(accessKeyId, accessKeySecret);

Odps odps = new Odps(account);

odps.setEndpoint(odpsUrl);

odps.setDefaultProject(project);

try {

TableTunnel tunnel = new TableTunnel(odps);

tunnel.setEndpoint(tunnelUrl);

//PartitionSpec partitionSpec = new PartitionSpec(partition);

UploadSession uploadSession = tunnel.createUploadSession(project,table);

// UploadSession uploadSession = tunnel.createUploadSession(project,

// table, partitionSpec); //分区 System.out.println("Session Status is : "

+ uploadSession.getStatus().toString()); ExecutorService pool = Executors.newFixedThreadPool(threadNum);

ArrayList<Callable<Boolean>> callers = new ArrayList<Callable<Boolean>>();

for (int i = 0; i < threadNum; i++) {

RecordWriter recordWriter = uploadSession.openRecordWriter(i);

Record record = uploadSession.newRecord();

callers.add(new UploadThread(i, recordWriter, record,

uploadSession.getSchema(),reader));

}

pool.invokeAll(callers);

pool.shutdown(); Long[] blockList = new Long[threadNum];

for (int i = 0; i < threadNum; i++)

blockList[i] = Long.valueOf(i);

uploadSession.commit(blockList);

reader.close();

System.out.println("upload success!");

} catch (TunnelException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

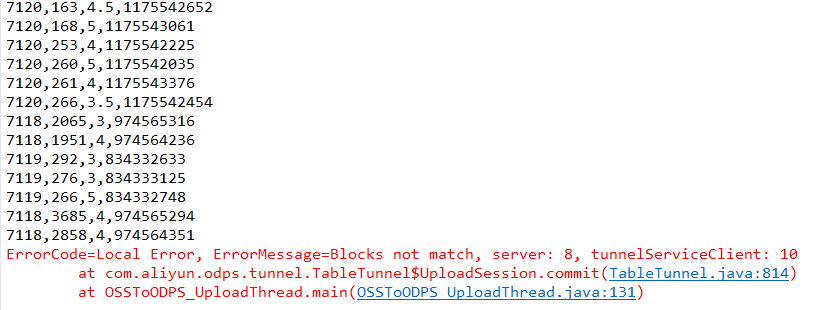

编程实现中遇到Bug

多线程上传任务无故中断,如下是异常截图

OSS文件上传及OSS与ODPS之间数据连通的更多相关文章

- 构建基于阿里云OSS文件上传服务

转载请注明来源:http://blog.csdn.net/loongshawn/article/details/50710132 <构建基于阿里云OSS文件上传服务> <构建基于OS ...

- 记一次阿里云oss文件上传服务假死

引言 记得以前刚开始学习web项目的时候,经常涉及到需要上传图片啥的,那时候都是把图片上传到当前项目文件夹下面,每次项目一重启图片就丢了.虽然可以通过修改/tomcat/conf/server.xml ...

- SpringBoot整合阿里云OSS文件上传、下载、查看、删除

1. 开发前准备 1.1 前置知识 java基础以及SpringBoot简单基础知识即可. 1.2 环境参数 开发工具:IDEA 基础环境:Maven+JDK8 所用技术:SpringBoot.lom ...

- js实现oss文件上传及一些问题

关于兼容性问题,ie8以下的可以使用4.x的版本 一.引入sdk和jq <script src="http://libs.baidu.com/jquery/2.0.0/jquery.m ...

- PHP实现阿里云OSS文件上传(支持批量)

上传文件至阿里云OSS,整体逻辑是,文件先临时上传到本地,然后在上传到OSS,最后删除本地的临时文件(也可以不删,具体看自己的业务需求),具体实现流程如下: 1.下载阿里云OSS对象上传SDK(P ...

- php阿里云oss文件上传

php的文件上传 文件上传 php的文件上传放在了$_FILES数组里,单文件和多文件上传的区别在于$_FILES['userfile']['name']是否为数组, 不熟悉的可以读一下官方文档 单文 ...

- 使用laravel-amdin调用文件上传阿里oss注意点

开发者工作中,项目代码开发提高效率,往往会使用一些github上面的一些扩展类,这里举例说明一下遇到的情况. 一.使用laravel-admin框架开发管理后台文件或者图片上传 情景:运营或者产品通过 ...

- 微信小程序环境下将文件上传到 OSS

步骤 1: 配置 Bucket 跨域 客户端进行表单直传到 OSS 时,会从浏览器向 OSS 发送带有 Origin 的请求消息.OSS 对带有 Origin 头的请求消息会进行跨域规则(CORS)的 ...

- 阿里云OSS文件上传封装

1.先用composer安装阿里云OSS的PHPSDK 2.配置文件里定义阿里云OSS的秘钥 3.在index控制器里的代码封装 <?php namespace app\index\contro ...

随机推荐

- GoBelieve UseID及ImID方案

GoBelieve: imId = (appid + uid) IM 服务器用(appid + uid)imid做用户的唯一标示 imid是IM平台上沟通的凭证 客户端请求联系人列表后,会有对应uid ...

- dubbox provider cosumer 包坐标及xml

provider pom <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http:// ...

- ie浏览器下载文件时文件名乱码

做一个文件下载功能时,用ie浏览器下载时文件名乱码,火狐和谷歌正常,修改后ie显示正常,修改方法如下: @RequestMapping(value = "fileDownload" ...

- Vue--- vue-cli 脚手架 安装 -reeber

vue-cli 脚手架 安装 一. node安装 1)如果不确定自己是否安装了node,可以在命令行工具内执行: node -v (检查一下 版本): 2)如果 执行结果显示: xx 不是内部命 ...

- CF考古活动

Codeforces Beta Round #1 http://codeforces.com/contest/1 A.测试用水题,呵呵.给三个数nma,求ceil(n/a)*ceil(m/a). 长整 ...

- angular-sanitize 插件的使用,获取带html标签的内容

1,安装 angular-sanitize bower install angular-sanitize --save 引入到 html <script src="/bower_com ...

- win10 下安装 MongoDB 数据库支持模块(python)

C:\>pythonPython 3.5.2 (v3.5.2:4def2a2901a5, Jun 25 2016, 22:18:55) [MSC v.1900 64 bit (AMD64)] o ...

- 如何将24位RGB颜色转换16位RGB颜色

有许多朋友第一次使用16位彩色显示屏会遇到如何将24位RGB颜色转换为对应的16位RGB颜色的问题, 通过查阅相关资料,就写一下其中的转换原理吧,希望对大家会有所帮助. 我们知道24位RGB是分别由8 ...

- Linux内核调用I2C驱动_驱动嵌套驱动方法

禁止转载!!!! Linux内核调用I2C驱动_以MPU6050为例 0. 导语 最近一段时间都在恶补数据结构和C++,加上导师的事情比较多,Linux内核驱动的学习进程总是被阻碍.不过,十一假期终于 ...

- java中有关Volatile的几个小题

1.java中能创建volatile数组吗? 能,java中可以创建volatile数组,不过只是一个指向数组的引用,而不是整个数组,如果改变引用指向的数组,将会受到volatile的保护,但是如果多 ...