使用 docker-compose 安装 es、kibana、mysql、redis、kafka

由于经常的安装虚拟机,每次都要重装环境比较麻烦。

这次写了一个 docker-compose 文件,一次性搞定安装问题。

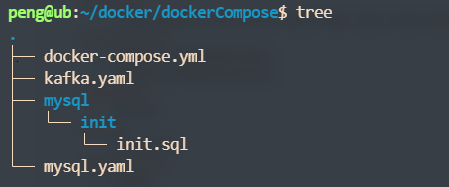

目录结果如下:

---

version: "3.1"

networks:

zh-net:

driver: bridge

services:

db:

image: mysql:latest

container_name: zh_mysql

environment:

- MYSQL_ROOT_PASSWORD=123456

- TZ=Asia/Shanghai

volumes:

- /home/peng/docker/data/mysql:/var/lib/mysql

- ./mysql/init/:/docker-entrypoint-initdb.d/

ports:

- 3306:3306

command:

--character-set-server=utf8mb4

--collation-server=utf8mb4_general_ci

--explicit_defaults_for_timestamp=true

--lower_case_table_names=1

redis:

image: redis:latest

container_name: zh_redis

ports:

- 6379:6379

etcd:

image: bitnami/etcd:latest

container_name: zh_etcd

environment:

- ALLOW_NONE_AUTHENTICATION=yes

ports:

- 2379:2379

es:

image: elasticsearch:7.17.5

container_name: zh_es

environment:

- discovery.type=single-node

volumes:

- /home/peng/docker/conf/elasticsearch/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /home/peng/docker/conf/elasticsearch/plugins:/usr/share/elasticsearch/plugins

ports:

- 9200:9200

networks:

- zh-net

kibana:

image: kibana:7.17.5

container_name: zh_kibana

volumes:

- /home/peng/docker/conf/kibana/kibana.yml:/usr/share/kibana/config/kibana.yml

ports:

- 5601:5601

networks:

- zh-net

depends_on:

- es

zookeeper:

image: confluentinc/cp-zookeeper:7.0.1

container_name: zh_zookeeper

environment:

ZOOKEEPER_CLIENT_PORT: 2181

ZOOKEEPER_TICK_TIME: 2000

broker:

image: confluentinc/cp-kafka:7.0.1

container_name: zh_broker

ports:

# To learn about configuring Kafka for access across networks see

# https://www.confluent.io/blog/kafka-client-cannot-connect-to-broker-on-aws-on-docker-etc/

- "9092:9092"

depends_on:

- zookeeper

environment:

KAFKA_BROKER_ID: 1

KAFKA_ZOOKEEPER_CONNECT: 'zookeeper:2181'

KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: PLAINTEXT:PLAINTEXT,PLAINTEXT_INTERNAL:PLAINTEXT

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://localhost:9092,PLAINTEXT_INTERNAL://broker:29092

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

KAFKA_TRANSACTION_STATE_LOG_MIN_ISR: 1

KAFKA_TRANSACTION_STATE_LOG_REPLICATION_FACTOR: 1

kafka-map:

image: dushixiang/kafka-map:latest

container_name: zh_kafka-map

volumes:

- /home/peng/docker/data/kafka-map:/usr/local/kafka-map/data

environment:

- DEFAULT_USERNAME=admin

- DEFAULT_PASSWORD=admin

networks:

- zh-net

ports:

- 8089:8080

depends_on:

- broker

非持久化安装

---

version: "3.1"

networks:

zh-net:

driver: bridge

services:

db:

image: mysql:latest

container_name: zh_mysql

environment:

- MYSQL_ROOT_PASSWORD=123456

- TZ=Asia/Shanghai

networks:

- zh-net

ports:

- 3306:3306

command:

--character-set-server=utf8mb4

--collation-server=utf8mb4_general_ci

--explicit_defaults_for_timestamp=true

--lower_case_table_names=1

redis:

image: redis:latest

container_name: zh_redis

networks:

- zh-net

ports:

- 6379:6379

etcd:

image: bitnami/etcd:latest

container_name: zh_etcd

environment:

- ALLOW_NONE_AUTHENTICATION=yes

networks:

- zh-net

ports:

- 2379:2379

es:

image: elasticsearch:7.17.5

container_name: zh_es

environment:

- discovery.type=single-node

networks:

- zh-net

ports:

- 9200:9200

networks:

- zh-net

kibana:

image: kibana:7.17.5

container_name: zh_kibana

networks:

- zh-net

ports:

- 5601:5601

depends_on:

- es

zookeeper:

image: confluentinc/cp-zookeeper:7.0.1

container_name: zh_zookeeper

networks:

- zh-net

ports:

- 2181:2181

environment:

ZOOKEEPER_CLIENT_PORT: 2181

ZOOKEEPER_TICK_TIME: 2000

broker:

image: confluentinc/cp-kafka:7.0.1

container_name: zh_broker

networks:

- zh-net

ports:

- 9092:9092

depends_on:

- zookeeper

environment:

KAFKA_BROKER_ID: 1

KAFKA_ZOOKEEPER_CONNECT: 'zookeeper:2181'

KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: PLAINTEXT:PLAINTEXT,PLAINTEXT_INTERNAL:PLAINTEXT

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://localhost:9092,PLAINTEXT_INTERNAL://broker:29092

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

KAFKA_TRANSACTION_STATE_LOG_MIN_ISR: 1

KAFKA_TRANSACTION_STATE_LOG_REPLICATION_FACTOR: 1

kafka-map:

image: dushixiang/kafka-map:latest

container_name: zh_kafka-map

environment:

- DEFAULT_USERNAME=admin

- DEFAULT_PASSWORD=admin

networks:

- zh-net

ports:

- 8089:8080

depends_on:

- broker

使用 docker-compose 安装 es、kibana、mysql、redis、kafka的更多相关文章

- Spring Boot 2.0(五):Docker Compose + Spring Boot + Nginx + Mysql 实践

我知道大家这段时间看了我写关于 docker 相关的几篇文章,不疼不痒的,仍然没有感受 docker 的便利,是的,我也是这样认为的,I know your felling . 前期了解概念什么的确实 ...

- (转)Spring Boot 2 (五):Docker Compose + Spring Boot + Nginx + Mysql 实践

http://www.ityouknow.com/springboot/2018/03/28/dockercompose-springboot-mysql-nginx.html 我知道大家这段时间看了 ...

- Spring Boot 2 (五):Docker Compose + Spring Boot + Nginx + Mysql 实践

Spring Boot 2 (五):Docker Compose + Spring Boot + Nginx + Mysql 实践 Spring Boot + Nginx + Mysql 是实际工作中 ...

- Docker Compose + Spring Boot + Nginx + Mysql

Docker Compose + Spring Boot + Nginx + Mysql 实践 我知道大家这段时间看了我写关于 docker 相关的几篇文章,不疼不痒的,仍然没有感受 docker 的 ...

- 安装logstash+kibana+elasticsearch+redis搭建集中式日志分析平台

安装logstash+kibana+elasticsearch+redis搭建集中式日志分析平台 2014-01-16 19:40:57| 分类: logstash | 标签:logstash ...

- 手把手教你 Docker Compose安装DOClever

一.什么是Docker Compose以及Docker Compose的安装和使用 查看我的另外一篇博客:Docker Compose的安装和使用 二.DOClever是什么 DOClever是一个可 ...

- docker和docker compose安装使用、入门进阶案例

一.前言 现在可谓是容器化的时代,云原生的袭来,导致go的崛起,作为一名java开发,现在慌得一批.作为知识储备,小编也是一直学关于docker的东西,还有一些持续继承jenkins. 提到docke ...

- Docker Compose安装以及入门

Docker Compose 是 Docker 官方编排(Orchestration)项目之一,负责快速在集群中部署分布式应用. Compose 简介 Compose 项目是 Docker 官方的开源 ...

- 使用 docker compose 安装 tidb

目标 : 单机上通过 Docker Compose 快速一键部署一套 TiDB 测试集群 前提条件: 1.centos版本在7.3 以上 2.安装git 3.安装docker Docker versi ...

- Docker Compose 安装 on centos7

本文演示如何在CentOS7上安装Docker Compose. 1 在线安装 1.1 下载安装包 $ curl -L https://github.com/docker/compose/releas ...

随机推荐

- 如何查看库函数实现的某些函数(strlen,strcmp,strcpy等)

我们拿strlen()作为举例(编译环境为:VS2022) strlen()引用的头文件为 string.h,如下进行操作 ps:打开strlen.c文件 便可以看到库函数对于strlen()的实现, ...

- 上篇 | 使用 🤗 Transformers 进行概率时间序列预测

介绍 时间序列预测是一个重要的科学和商业问题,因此最近通过使用基于深度学习 而不是经典方法的模型也涌现出诸多创新.ARIMA 等经典方法与新颖的深度学习方法之间的一个重要区别如下. 概率预测 通常,经 ...

- JZOJ 4318. 【NOIP2015模拟11.5】俄罗斯套娃

题目大意 求逆序对个数小于等于 \(k\) 的排列数 解析 已经做过很多次了,经典得不能再经典的问题 注意本题很卡空间,要用滚动数组 \(Code\) #include<cstdio> u ...

- 【模板】AC自动机(二次加强版)

模板 \(Problem:\) 求 \(n\) 个模式串在文本串中出现的次数 \(templete:\) \(Luogu5357\) \(Code\) #include<cstdio> # ...

- 自定义顺序表ArrayList

1.简介 顺序表是在计算机内存中以数组的形式保存的线性表,线性表的顺序存储是指用一组地址连续的存储单元依次存储线性表中的各个元素.使得线性表中在逻辑结构上相邻的数据元素存储在相邻的物理存储单元中,即通 ...

- 多资产VAR风险--基于python处理

一.数据准备,先在excel表格上计算每日的波动率: excel数据为: 二.数据导入: import pandas as pd import numpy as np import akshare a ...

- Kotlin相关语法

1.Kotlin的匿名函数 { val a = 1 val b = 2 a+b } 就是一个不带名字的函数体 2.Kotlin的函数类型 函数类型:用来声明一个函数参数和返回值形式的 特殊数据类型声 ...

- MySQL5.7升级版本到8.0

升级二进制包安装的MySQL In-Place Upgrade(替代升级) 替代升级涉及到shutdown down旧版本的MySQL,用新版本的包替代旧版本的二进制包,用存在的数据文件目录重启MyS ...

- C++实现链栈相关操作代码

#include<iostream>#include<cstdlib>using namespace std;#define MAXSIZE 100#define OK 1#d ...

- Day13 字符串的常用方法

API帮助文档的使用流程 在索引的位置搜索自己要查看的类 看包 目的:是不是 Java.lang包(核心包),不需要编写导包代码(import) -------不是 java.lang包,都需要编写导 ...