机器学习系列-tensorflow-03-线性回归Linear Regression

利用tensorflow实现数据的线性回归

**导入相关库**

import tensorflow as tf

import numpy

import matplotlib.pyplot as plt

rng = numpy.random

参数设置

learning_rate = 0.01

training_epochs = 1000

display_step = 50

训练数据

train_X = numpy.asarray([3.3,4.4,5.5,6.71,6.93,4.168,9.779,6.182,7.59,2.167,

7.042,10.791,5.313,7.997,5.654,9.27,3.1])

train_Y = numpy.asarray([1.7,2.76,2.09,3.19,1.694,1.573,3.366,2.596,2.53,1.221,

2.827,3.465,1.65,2.904,2.42,2.94,1.3])

n_samples = train_X.shape[0]

tf图输入

X = tf.placeholder("float")

Y = tf.placeholder("float")

设置权重和偏置

W = tf.Variable(rng.randn(), name="weight")

b = tf.Variable(rng.randn(), name="bias")

构建线性模型

pred = tf.add(tf.multiply(X, W), b)

均方误差

cost = tf.reduce_sum(tf.pow(pred-Y, 2))/(2*n_samples)

梯度下降

optimizer = tf.train.GradientDescentOptimizer(learning_rate).minimize(cost)

初始化变量

init = tf.global_variables_initializer()

开始训练

with tf.Session() as sess:

sess.run(init)

# 适合所有训练数据

for epoch in range(training_epochs):

for (x, y) in zip(train_X, train_Y):

sess.run(optimizer, feed_dict={X: x, Y: y})

# 显示每个纪元步骤的日志

if (epoch+1) % display_step == 0:

c = sess.run(cost, feed_dict={X: train_X, Y:train_Y})

print("Epoch:", '%04d' % (epoch+1), "cost=", "{:.9f}".format(c), \

"W=", sess.run(W), "b=", sess.run(b))

print("Optimization Finished!")

training_cost = sess.run(cost, feed_dict={X: train_X, Y: train_Y})

print("Training cost=", training_cost, "W=", sess.run(W), "b=", sess.run(b), '\n')

# 画图显示

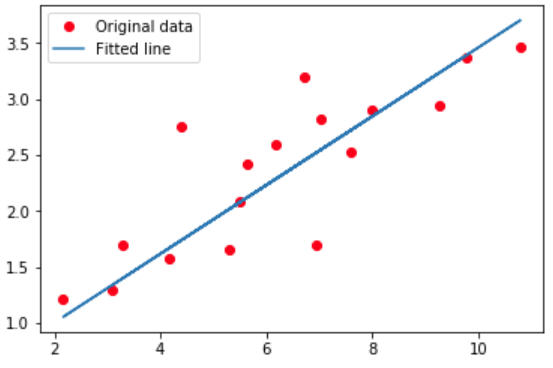

plt.plot(train_X, train_Y, 'ro', label='Original data')

plt.plot(train_X, sess.run(W) * train_X + sess.run(b), label='Fitted line')

plt.legend()

plt.show()

结果展示

Epoch: 0050 cost= 0.183995649 W= 0.43250677 b= -0.5143978

Epoch: 0100 cost= 0.171630666 W= 0.42162812 b= -0.43613702

Epoch: 0150 cost= 0.160693780 W= 0.41139638 b= -0.36253116

Epoch: 0200 cost= 0.151019916 W= 0.40177315 b= -0.2933027

Epoch: 0250 cost= 0.142463341 W= 0.39272234 b= -0.22819161

Epoch: 0300 cost= 0.134895071 W= 0.3842099 b= -0.16695316

Epoch: 0350 cost= 0.128200993 W= 0.37620357 b= -0.10935676

Epoch: 0400 cost= 0.122280121 W= 0.36867347 b= -0.055185713

Epoch: 0450 cost= 0.117043234 W= 0.36159125 b= -0.004236537

Epoch: 0500 cost= 0.112411365 W= 0.3549302 b= 0.04368245

Epoch: 0550 cost= 0.108314596 W= 0.34866524 b= 0.08875148

Epoch: 0600 cost= 0.104691163 W= 0.34277305 b= 0.13114017

Epoch: 0650 cost= 0.101486407 W= 0.33723122 b= 0.17100765

Epoch: 0700 cost= 0.098651998 W= 0.33201888 b= 0.20850417

Epoch: 0750 cost= 0.096145160 W= 0.32711673 b= 0.24377018

Epoch: 0800 cost= 0.093927994 W= 0.32250607 b= 0.27693948

Epoch: 0850 cost= 0.091967128 W= 0.31816947 b= 0.308136

Epoch: 0900 cost= 0.090232961 W= 0.31409115 b= 0.33747625

Epoch: 0950 cost= 0.088699281 W= 0.31025505 b= 0.36507198

Epoch: 1000 cost= 0.087342896 W= 0.30664718 b= 0.39102668

Optimization Finished!

Training cost= 0.087342896 W= 0.30664718 b= 0.39102668

参考:

Author: Aymeric Damien

Project: https://github.com/aymericdamien/TensorFlow-Examples/

机器学习系列-tensorflow-03-线性回归Linear Regression的更多相关文章

- Stanford机器学习---第二讲. 多变量线性回归 Linear Regression with multiple variable

原文:http://blog.csdn.net/abcjennifer/article/details/7700772 本栏目(Machine learning)包括单参数的线性回归.多参数的线性回归 ...

- 机器学习 (一) 单变量线性回归 Linear Regression with One Variable

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang的个人笔 ...

- ISLR系列:(1)线性回归 Linear Regression

Linear Regression 此博文是 An Introduction to Statistical Learning with Applications in R 的系列读书笔记,作为本 ...

- [笔记]机器学习(Machine Learning) - 01.线性回归(Linear Regression)

线性回归属于回归问题.对于回归问题,解决流程为: 给定数据集中每个样本及其正确答案,选择一个模型函数h(hypothesis,假设),并为h找到适应数据的(未必是全局)最优解,即找出最优解下的h的参数 ...

- 吴恩达机器学习(二) 单变量线性回归(Linear Regression with one variable)

一.模型表示 1.一些术语 如下图,房价预测.训练集给出了房屋面积和价格,下面介绍一些术语: x:输入变量或输入特征(input variable/features). y:输出变量或目标变量(out ...

- 吴恩达机器学习笔记8-多变量线性回归(Linear Regression with Multiple Variables)--多维特征

我们探讨了单变量/特征的回归模型,现在我们对房价模型增加更多的特征,例如房间数楼层等,构成一个含有多个变量的模型,模型中的特征为(

- 吴恩达机器学习笔记1-单变量线性回归(Linear Regression with One Variable)

在监督学习中我们有一个数据集,这个数据集被称训练集.

- TensorFlow 学习笔记(1)----线性回归(linear regression)的TensorFlow实现

此系列将会每日持续更新,欢迎关注 线性回归(linear regression)的TensorFlow实现 #这里是基于python 3.7版本的TensorFlow TensorFlow是一个机器学 ...

- 机器学习(三)--------多变量线性回归(Linear Regression with Multiple Variables)

机器学习(三)--------多变量线性回归(Linear Regression with Multiple Variables) 同样是预测房价问题 如果有多个特征值 那么这种情况下 假设h表示 ...

随机推荐

- django----Form提交按钮

form表单中要用submit,如果用button切记要加上type,不然button默认的type是submit,会有影响 <button class="login" ty ...

- mysql 文件导入

load data infile 文件路径 into table 表 fields terminated by ',' lines terminated '\n'

- Nginx详解十三:Nginx场景实践篇之防盗链

防盗链: 目的:防止资源被盗用 防盗链设置思路 首要方式:区别哪些请求是非正常的用户请求 基于http_refer防盗链配置模块(判断refer(上一步的链接)信息是否为允许访问的网站) 配置语法:v ...

- C++ Primer 笔记——异常处理

1.栈展开过程沿着嵌套函数的调用链不断查找,直到找到了与异常匹配的catch句子为止,或者也可能一直没找到匹配的catch,则程序将调用terminate,退出主函数后查找过程终止.假设找到了一个ca ...

- java操作office和pdf文件java读取word,excel和pdf文档内容

在平常应用程序中,对office和pdf文档进行读取数据是比较常见的功能,尤其在很多web应用程序中.所以今天我们就简单来看一下Java对word.excel.pdf文件的读取.本篇博客只是讲解简单应 ...

- tensorflow实现RNN及Word2Vec

参考:<tensorflow实战> 首先介绍一下Word2Vec Word2Vec:从原始语料中学习字词空间向量的预测模型.主要分为CBOW(Continue Bags of Words) ...

- Windows 添加永久静态路由

route add -p 10.10.0.0 mask 255.255.0.0 10.10.6.1 -p 参数: p 即 persistent 的意思 -p 表示将路由表项永久加入系统注册表

- 一脸懵逼学习Hadoop中的序列化机制——流量求和统计MapReduce的程序开发案例——流量求和统计排序

一:序列化概念 序列化(Serialization)是指把结构化对象转化为字节流.反序列化(Deserialization)是序列化的逆过程.即把字节流转回结构化对象.Java序列化(java.io. ...

- javaScript事件(八)事件类型之变动事件

DOM2级的变动(mutation)事件能在DOM中某一部分发送变化时给出提示.变动事件为XML或HTML DOM设计的,并不特定于某种语言.DOM2级定义了如下变动事件. DOMSubtreeMod ...

- VS2013 快捷键 与 RESHARPER 冲突(转)

1.VS设置工具-->选项-->环境-->键盘-->重置 2.RESHARPER -->Options-->Environment → Keyboard & ...