ADAM : A METHOD FOR STOCHASTIC OPTIMIZATION

Kingma D P, Ba J. Adam: A Method for Stochastic Optimization[J]. arXiv: Learning, 2014.

@article{kingma2014adam:,

title={Adam: A Method for Stochastic Optimization},

author={Kingma, Diederik P and Ba, Jimmy},

journal={arXiv: Learning},

year={2014}}

概

鼎鼎大名.

主要内容

用\(f(\theta)\)表示目标函数, 随机最优通常需要最小化\(\mathbb{E}(f(\theta))\), 但是因为每一次我们都取的是一个小批次, 故实际上我们处理的是\(f_1(\theta),\ldots, f_T(\theta)\). 用\(g_t=\nabla_{\theta}f_t(\theta)\)表示第\(t\)步对应的梯度.

Adam 方法分别估计梯度\(\mathbb{E}(g_t)\)的一阶矩和二阶矩(Adam: adaptive moment estimation 名字的由来).

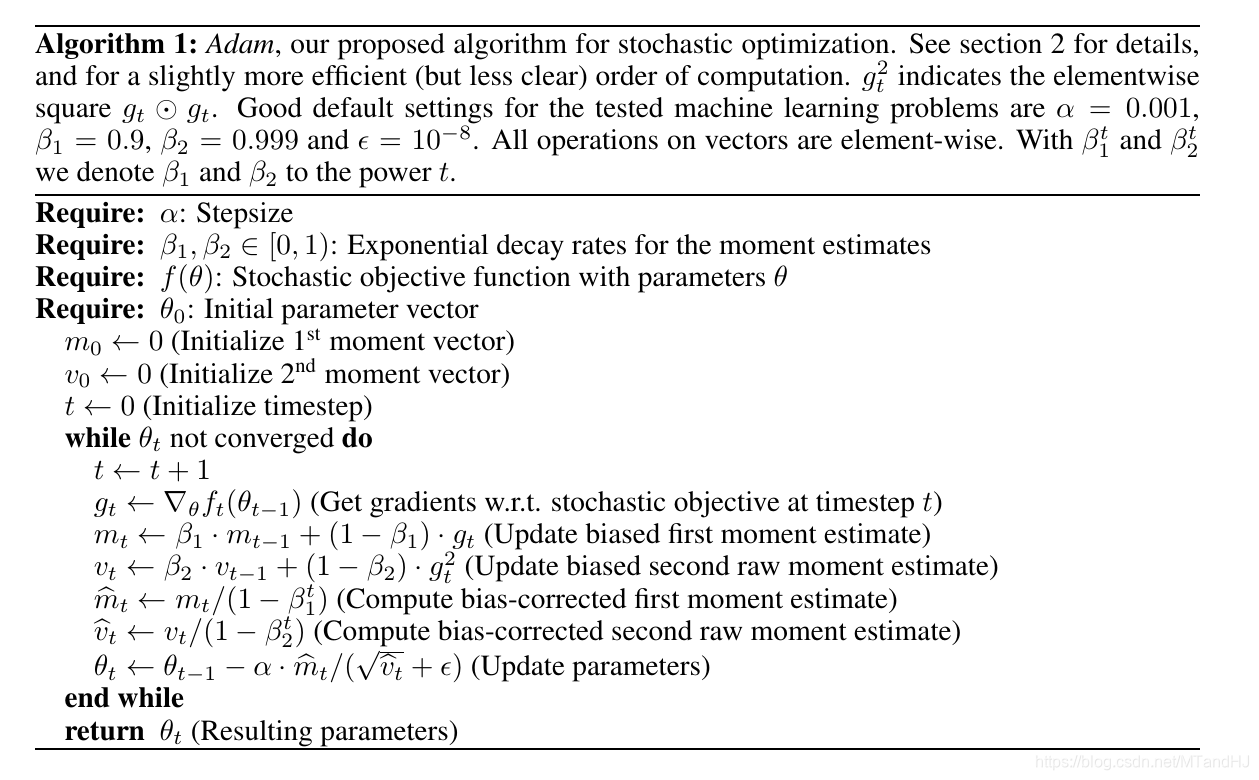

算法

注意: 下面的算法中关于向量的运算都是逐项(element-wise)的运算.

选择合适的参数

首先, 分析为什么会有

\hat{m}_t \leftarrow m_t / (1-\beta_2^t), \\

\hat{v}_t \leftarrow v_t / (1-\beta_2^t).

\]

可以用归纳法证明

m_t = (1-\beta_1) \sum_{i=1}^t \beta_1^{t-i} \cdot g_i \\

v_t = (1-\beta_2) \sum_{i=1}^t \beta_2^{t-i} \cdot g_i^2.

\]

倘若分布稳定: \(\mathbb{E}[g_t]=\mathbb{E}[g],\mathbb{E}[g_t^2]=\mathbb{E}[g^2]\), 则

\mathbb{E}[m_t]=\mathbb{E}[g] \cdot(1-\beta_1^t) \\

\mathbb{E}[v_t]= \mathbb{E}[g^2] \cdot (1- \beta_2^t).

\]

这就是为什么会有(A.1)这一步.

Adam提出时的一个很大的应用场景就是dropout(正对梯度是稀疏的情况), 这是往往需要我们取较大的\(\beta_2\)(可理解为抵消随机因素).

既然\(\mathbb{E}[g]/\sqrt{\mathbb{E}[g^2]}\le 1\), 我们可以把步长\(\alpha\)理解为一个信赖域(既然\(|\Delta_t| \frac{<}{\approx} a\)).

另外一个很重要的性质是, 比如函数扩大(或缩小)\(c\)倍\(cf\), 此时梯度相应为\(cg\), 我们所对应的

\]

并无变化.

一些别的优化算法

AdaGrad:

\]

RMSprop:

\theta_{t+1} = \theta_t -\alpha \cdot \frac{1}{\sqrt{v_t+\epsilon}}g_t.

\]

AdaDelta:

\theta_{t+1} = \theta_t -\alpha \cdot \frac{\sqrt{m_{t-1}+\epsilon}}{\sqrt{v_t+\epsilon}}g_t \\

m_t = \beta_1 m_{t-1}+(1-\beta_1)[\theta_{t+1}-\theta_t]^2.

\]

注: 均为逐项

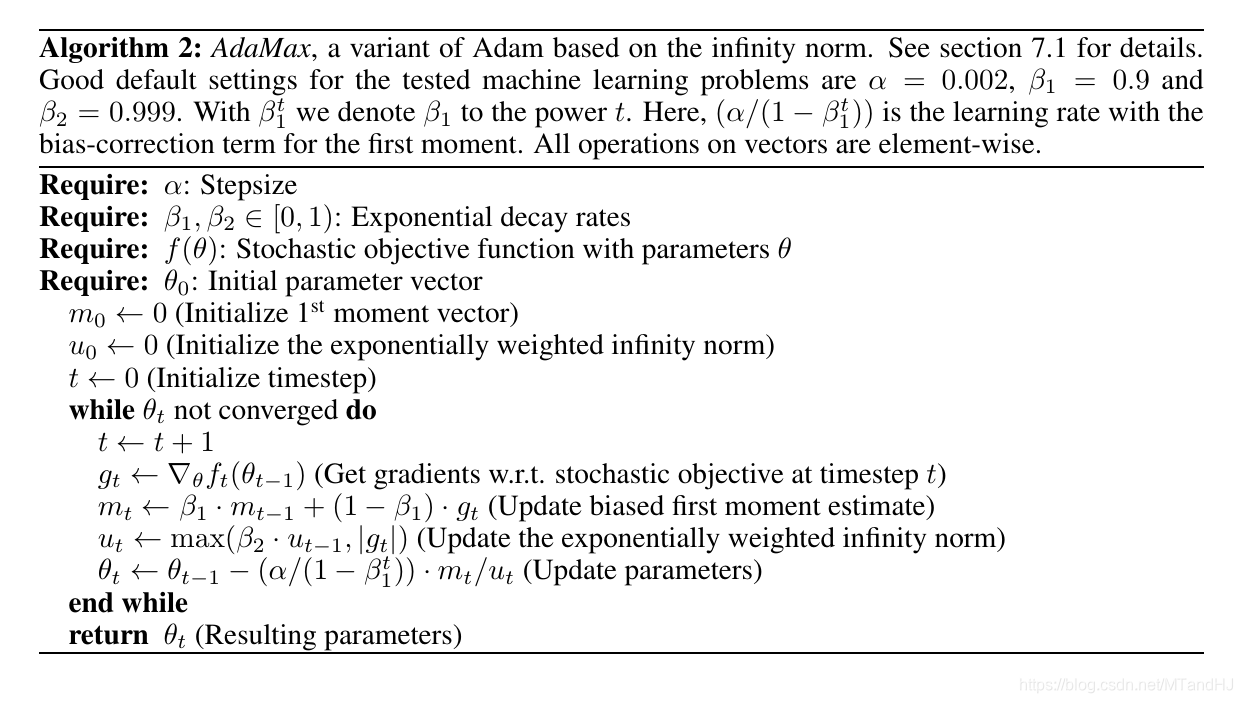

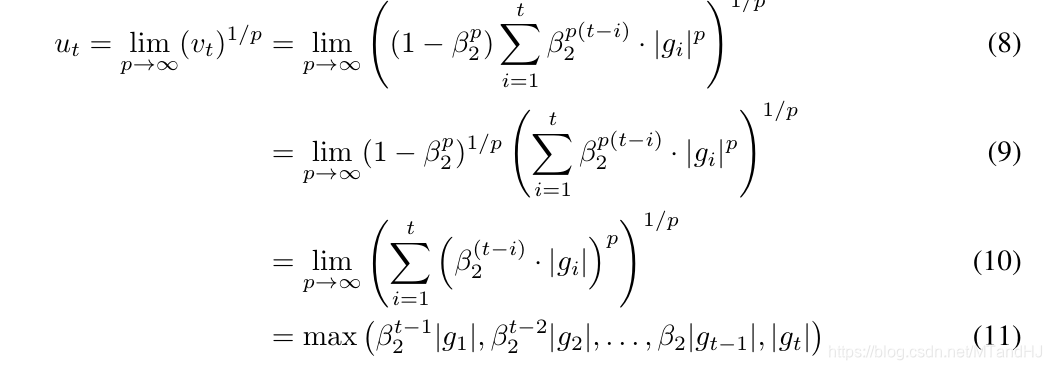

AdaMax

本文还提出了另外一种算法

理论

不想谈了, 感觉证明有好多错误.

代码

import numpy as np

class Adam:

def __init__(self, instance, alpha=0.001, beta1=0.9, beta2=0.999,

epsilon=1e-8, beta_decay=1., alpha_decay=False):

""" the Adam using numpy

:param instance: the theta in paper, should have the grad method to call the grads

and the zero_grad method for clearing the grads

:param alpha: the same as the paper default:0.001

:param beta1: the same as the paper default:0.9

:param beta2: the same as the paper default:0.999

:param epsilon: the same as the paper default:1e-8

:param beta_decay:

:param alpha_decay: default False, if True, we will set alpha = alpha / sqrt(t)

"""

self.instance = instance

self.alpha = alpha

self.beta1 = beta1

self.beta2 = beta2

self.epsilon = epsilon

self.beta_decay = beta_decay

self.alpha_decay = alpha_decay

self.initialize_paras()

def initialize_paras(self):

self.m = 0.

self.v = 0.

self.timestep = 0

def update_paras(self):

grads = self.instance.grad

self.beta1 *= self.beta_decay

self.beta2 *= self.beta_decay

self.m = self.beta1 * self.m + (1 - self.beta1) * grads

self.v = self.beta2 * self.v + (1 - self.beta2) * grads ** 2

self.timestep += 1

if self.alpha_decay:

return self.alpha / np.sqrt(self.timestep)

return self.alpha

def zero_grad(self):

self.instance.zero_grad()

def step(self):

alpha = self.update_paras()

betat1 = 1 - self.beta1 ** self.timestep

betat2 = 1 - self.beta2 ** self.timestep

temp = alpha * np.sqrt(betat2) / betat1

self.instance.parameters -= temp * self.m / (np.sqrt(self.v) + self.epsilon)

class PPP:

def __init__(self, parameters, grad_func):

self.parameters = parameters

self.zero_grad()

self.grad_func = grad_func

def zero_grad(self):

self.grad = np.zeros_like(self.parameters)

def calc_grad(self):

self.grad += self.grad_func(self.parameters)

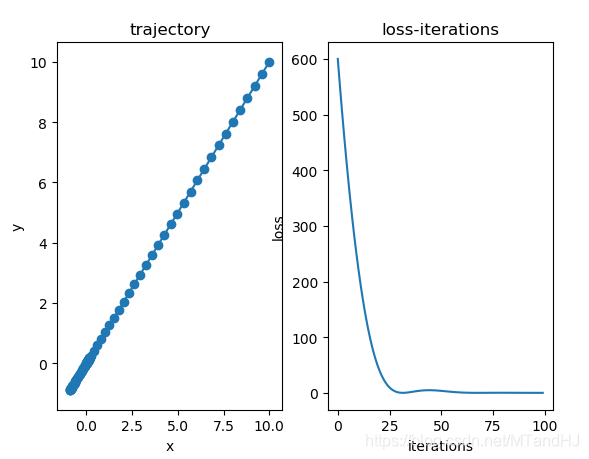

def f(x):

return x[0] ** 2 + 5 * x[1] ** 2

def grad(x):

return np.array([2 * x[0], 100 * x[1]])

if __name__ == "__main__":

x = np.array([10., 10.])

x = PPP(x, grad)

xs = []

ys = []

optim = Adam(x, alpha=0.4)

for i in range(100):

xs.append(x.parameters.copy())

y = f(x.parameters)

ys.append(y)

optim.zero_grad()

x.calc_grad()

optim.step()

xs = np.array(xs)

ys = np.array(ys)

import matplotlib.pyplot as plt

fig, (ax0, ax1)= plt.subplots(1, 2)

ax0.plot(xs[:, 0], xs[:, 1])

ax0.scatter(xs[:, 0], xs[:, 1])

ax0.set(title="trajectory", xlabel="x", ylabel="y")

ax1.plot(np.arange(len(ys)), ys)

ax1.set(title="loss-iterations", xlabel="iterations", ylabel="loss")

plt.show()

ADAM : A METHOD FOR STOCHASTIC OPTIMIZATION的更多相关文章

- Stochastic Optimization Techniques

Stochastic Optimization Techniques Neural networks are often trained stochastically, i.e. using a me ...

- TensorFlow 深度学习笔记 Stochastic Optimization

Stochastic Optimization 转载请注明作者:梦里风林 Github工程地址:https://github.com/ahangchen/GDLnotes 欢迎star,有问题可以到I ...

- Stochastic Optimization of PCA with Capped MSG

目录 Problem Matrix Stochastic Gradient 算法(MSG) 步骤二(单次迭代) 单步SVD \(project()\)算法 \(rounding()\) 从这里回溯到此 ...

- (转) An overview of gradient descent optimization algorithms

An overview of gradient descent optimization algorithms Table of contents: Gradient descent variants ...

- PyTorch-Adam优化算法原理,公式,应用

概念:Adam 是一种可以替代传统随机梯度下降过程的一阶优化算法,它能基于训练数据迭代地更新神经网络权重.Adam 最开始是由 OpenAI 的 Diederik Kingma 和多伦多大学的 Jim ...

- An overview of gradient descent optimization algorithms

原文地址:An overview of gradient descent optimization algorithms An overview of gradient descent optimiz ...

- Adam优化算法

Question? Adam 算法是什么,它为优化深度学习模型带来了哪些优势? Adam 算法的原理机制是怎么样的,它与相关的 AdaGrad 和 RMSProp 方法有什么区别. Adam 算法应该 ...

- Adam 算法

简介 Adam 是一种可以替代传统随机梯度下降(SGD)过程的一阶优化算法,它能基于训练数据迭代地更新神经网络权重.Adam 最开始是由 OpenAI 的 Diederik Kingma 和多伦多大学 ...

- 从 SGD 到 Adam —— 深度学习优化算法概览(一) 重点

https://zhuanlan.zhihu.com/p/32626442 骆梁宸 paper插画师:poster设计师:oral slides制作人 445 人赞同了该文章 楔子 前些日在写计算数学 ...

随机推荐

- day04 sersync实时同步和ssh服务

day04 sersync实时同步和ssh服务 sersync实时同步 1.什么是实时同步 实时同步是一种只要当前目录发生变化则会触发一个事件,事件触发后会将变化的目录同步至远程服务器. 2.为什么使 ...

- day07 Linux配置修改

day07 Linux配置修改 昨日回顾 1.系统目录 /etc :系统配置目录 /bin-> /usr/bin :保存常用命令的目录 /root :超级管理员目录 /home :普通管理员目录 ...

- 「译」 .NET 6 中 gRPC 的新功能

gRPC是一个现代的.跨平台的.高性能的 RPC 框架.gRPC for .NET 构建在 ASP.NET Core 之上,是我们推荐的在 .NET 中构建 RPC 服务的方法. .NET 6 进一步 ...

- [PE结构]导入表与IAT表

导入表的结构导入表的结构 typedef struct _IMAGE_IMPORT_DESCRIPTOR { union { DWORD Characteristics; // 0 for termi ...

- jvm的优化

a) 设置参数,设置jvm的最大内存数 b) 垃圾回收器的选择

- 【Services】【Web】【Nginx】静态下载页面的安装与配置

1. 拓扑 F5有自动探活机制,如果一台机器宕机,请求会转发到另外一台,省去了IPVS漂移的麻烦 F5使用轮询算法,向两台服务器转发请求,实现了负载均衡 2. 版本: 2.1 服务器版本:RHEL7. ...

- Reactor之发射器(Flux、Mono)转换操作函数

数据合并函数 由于业务需求有的时候需要将多个数据源进行合并,Reactor提供了concat方法和merge方法: concat public static <T> Flux<T&g ...

- shell脚本 binlog方式增量备份mysql

一.简介 源码地址 日期:2018/4/12 介绍:复制Binlog日志方式的增量备份脚本,并保存固定天数的备份 效果图: 二.使用 适用:centos6+ 语言:中文 注意:使用前先修改脚本中变量 ...

- Jenkins监控

目录 一.Monitoring插件 二.Prometheus监控 一.Monitoring插件 Monitoring插件(monitoring)使用JavaMelody,对Jenkins进行监控.插件 ...

- 搞IT的应届生如何写好简历?

本人在互联网大厂和外企做过技术面试官,也有过校招和招聘应届毕业生的经验,所以自认为在这个问题上有一定的发言权. 应届毕业生(其实其他求职者也一样)首先要知道,面试官凭什么决定这份简历有面试机会?而 ...