hdfs的FileSystem实例化

前言

在spark中通过hdfs的java接口并发写文件出现了数据丢失的问题,一顿操作后发现原来是FileSystem的缓存机制。补一课先

FileSystem实例化

FileSystem.get(config)是如何创建一个hadoop的FileSystem。

分为3个步骤。

1. 初始化所有支持的FileSystem(没有实例话,只是缓存类)

2. 通过uri的scheme拿到相应FileSystem

3. 缓存机制(如果不关闭的话,默认是开启)

下面详细分析一下各步骤流程

1. 初始化

通过java提供的ServiceLoader来录入所有可能的FileSystem,就像这样

ServiceLoader<FileSystem> serviceLoader = ServiceLoader.load(FileSystem.class);

for (FileSystem fs : serviceLoader) {

SERVICE_FILE_SYSTEMS.put(fs.getScheme(), fs.getClass());

}

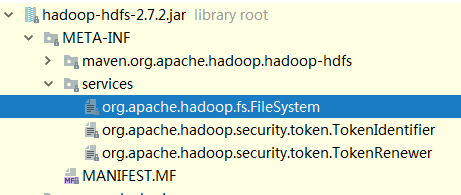

待初始化的类通过配置文件声明,配置可以在hadoop-hdfs.jar里找到

捎带一嘴,java提供的ServiceLoader有点像乞丐版spring的依赖反转。

2.scheme

通过对Uri的解析来判断创建一个什么FileSystem,

例如

hdfs://master:9200/test的scheme就是hdfs。

然后通过scheme和已经缓存好的FileSystem映射,找到需要实例化的类。

例如scheme是hdfs,那么就会创建一个DistributedFileSystem。 3. 缓存

FileSystem类中有一个Cache内部类,用于缓存已经被实例化的FileSystem。注意这个跟连接池还是有区别的,Cache中的缓存只是一个map,可以被多个线程拿到。这就会有一个问题,当你多线程同时get FileSystem的时候,可能返回的是同一个对象。所以切记,在多线程场景中,不要随意调用FileSystem.close,你关的连接可能会影响到其他正在使用的线程。

注意: 当你在其他框架上拿fileSystem对象需要额外注意,例如在spark上进行 FileSystem.get(),如果你想自定义某些配置,设置hdfs的副本数(dfs.replication) 之类,你必须在configuration中关闭FileSystem的缓存机制,也就是设置

configuration.set("fs.hdfs.impl.disable.cache","true")

这很重要,因为你不确定spark是否在你之前创建了一个FileSystem,而你得到的可能不是你想要的。

参考资料

// 遇到的相同问题

hdfs的FileSystem实例化的更多相关文章

- FileSystem实例化过程

HDFS案例代码 Configuration configuration = new Configuration(); FileSystem fileSystem = FileSystem.get(n ...

- 4、记录1----获取hdfs上FileSystem的方法 记录2:正则匹配路径:linux、hdfs

/** * 获取hadoop相关配置信息 * @param hadoopConfPath 目前用户需要提供hadoop的配置文件路径 * @return */ public static Config ...

- HDFS之FileSystem

package cn.hx.test; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.*; impo ...

- kafka-connect-hdfs连接hadoop hdfs时候,竟然是单点的,太可怕了。。。果断改成HA

2017-08-16 11:57:28,237 WARN [org.apache.hadoop.hdfs.LeaseRenewer][458] - <Failed to renew lease ...

- Hadoop(五):HDFS的JAVA API基本操作

HDFS的JAVA API操作 HDFS在生产应用中主要是客户端的开发,其核心步骤是从HDFS提供的api中构造一个HDFS的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS上的文件. 主 ...

- HDFS中Java的API使用测试

import java.io.IOException; import java.util.Arrays; import java.util.Date; import java.util.Scanner ...

- Hadoop HDFS编程 API入门系列之从本地上传文件到HDFS(一)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs5; import java.io.IOException; import ja ...

- HDFS文件系统基本文件命令、编程读写HDFS

基本文件命令: 格式为:hadoop fs -cmd <args> cmd的命名通常与unix对应的命令名相同.例如,文件列表命令: hadoop fs -ls 1.添加目录和文件 HDF ...

- HDFS操作--文件上传/创建/删除/查询文件信息

1.上传本地文件到HDFS //上传本地文件到HDFS public class CopyFile { public static void main(String[] args) { try { C ...

随机推荐

- java中日期常用

Java中日期的几种常见操作 —— 取值.转换.加减.比较 Java 的开发过程中免不了与 Date 类型纠缠,准备总结一下项目经常使用的日期相关操作,JDK 版本 1.7,如果能够帮助大家节约那么几 ...

- System.ArgumentException: 字体“Courier New”不支持样式“Regular”。

使用MongoVUE,发现报错,报错信息如下: System.ArgumentException: 字体“Courier New”不支持样式“Regular”. 说明本机字体安装不够:需安装完整的Co ...

- django URL的补充 默认值 传多个参数

url 后面还可以加上默认值 默认值 url(r'^index/', views.index, {'name': 'root'}), urls.py url对应关系 from django.conf. ...

- R中seurat等问题学习

1.Seurat 转自:https://cloud.tencent.com/developer/article/1055892 # Initialize the Seurat object with ...

- 奇异值与主成分分析(PCA)

主成分分析在上一节里面也讲了一些,这里主要谈谈如何用SVD去解PCA的问题.PCA的问题其实是一个基的变换,使得变换后的数据有着最大的方差.方差的大小描述的是一个变量的信息量,我们在讲一个东西的稳定性 ...

- Objective-C中new与alloc/init的区别

在实际开发中很少会用到new,一般创建对象我们看到的全是[[className alloc] init],但是并不意味着你不会接触到new,在一些代码中还是会看到[className new],还有去 ...

- ModelForm组件

ModelForm组件 Django的model form组件 这是一个神奇的组件,通过名字我们可以看出来,这个组件的功能就是把model和form组合起来,先来一个简单的例子来看一下这个东西怎么用: ...

- GIL用C语言解决

执行一个单线程死循环程序,单核cpu占用直接100% while True: pass 执行一个双线程的死循环程序,cpu同样占用100% import threading #子线程死循环 def t ...

- Tfs更新 TfsConfig

Start TfsJobAgent TfsServiceControl unquiesce 更新serviving状态 TfsConfig diagnose /scope:updates TfsCon ...

- idea新建的项目,文件夹右键不能新建class

一般情况下,新建的mave项目,通常没有XXX\src\main\java这个目录,如果手动创建,则又不能右键build与java相关的,强行建立的话,也不会被idea所识别,更不会被虚拟机编译执行. ...