小记---------spark优化之更优分配资源

|

属性名称

|

默认值

|

含义

|

|

spark.app.name

|

(none)

|

你的应用程序的名字。这将在UI和日志数据中出现

|

|

spark.driver.cores

|

1

|

driver程序运行需要的cpu内核数

|

|

spark.driver.maxResultSize

|

1g

|

每个Spark action(如collect)所有分区的序列化结果的总大小限制。设置的值应该不小于1m,0代表没有限制。如果总大小超过这个限制,程序将会终止。大的限制值可能导致driver出现内存溢出错误(依赖于spark.driver.memory和JVM中对象的内存消耗)。

|

|

spark.driver.memory

|

512m

|

driver进程使用的内存数

|

|

spark.executor.memory

|

512m

|

每个executor进程使用的内存数。和JVM内存串拥有相同的格式(如512m,2g)

|

|

spark.extraListeners

|

(none)

|

注册监听器,需要实现SparkListener

|

|

spark.local.dir

|

/tmp

|

Spark中暂存空间的使用目录。在Spark1.0以及更高的版本中,这个属性被SPARK_LOCAL_DIRS(Standalone, Mesos)和LOCAL_DIRS(YARN)环境变量覆盖。

|

|

spark.logConf

|

false

|

当SparkContext启动时,将有效的SparkConf记录为INFO。

|

|

spark.master

|

(none)

|

集群管理器连接的地方

|

小记---------spark优化之更优分配资源的更多相关文章

- Spark(六)Spark之开发调优以及资源调优

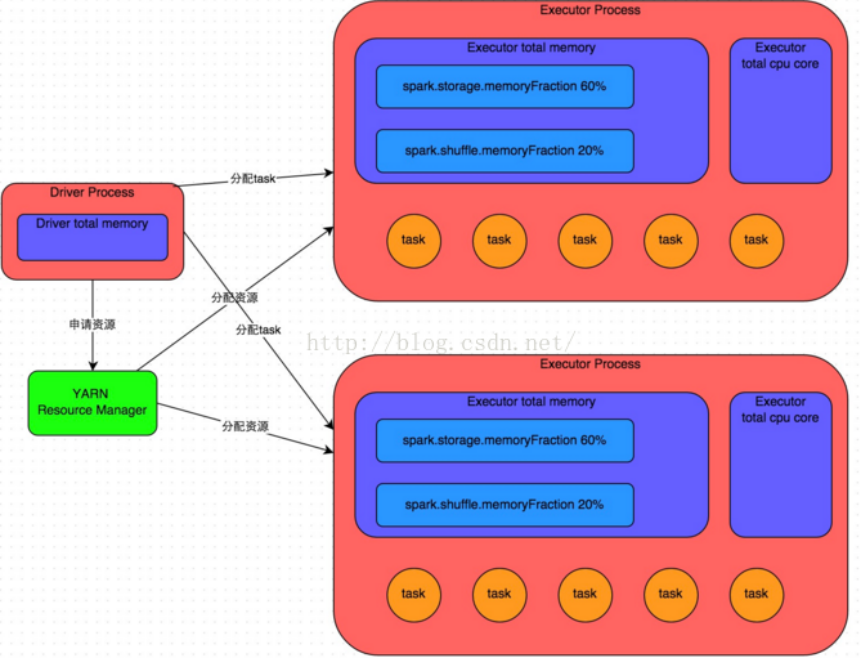

Spark调优主要分为开发调优.资源调优.数据倾斜调优.shuffle调优几个部分.开发调优和资源调优是所有Spark作业都需要注意和遵循的一些基本原则,是高性能Spark作业的基础:数据倾斜调优,主 ...

- Spark性能优化--开发调优与资源调优

参考: https://tech.meituan.com/spark-tuning-basic.html https://zhuanlan.zhihu.com/p/22024169 一.开发调优 1. ...

- 如何用Serverless让SaaS获得更灵活的租户隔离和更优的资源开销

关于SaaS和Serverless,相信关注我的很多读者都已经不陌生,所以这篇不会聊它们的技术细节,而将重点放在SaaS软件架构中引入Serverless之后,能给我们的SaaS软件带来多大的收益. ...

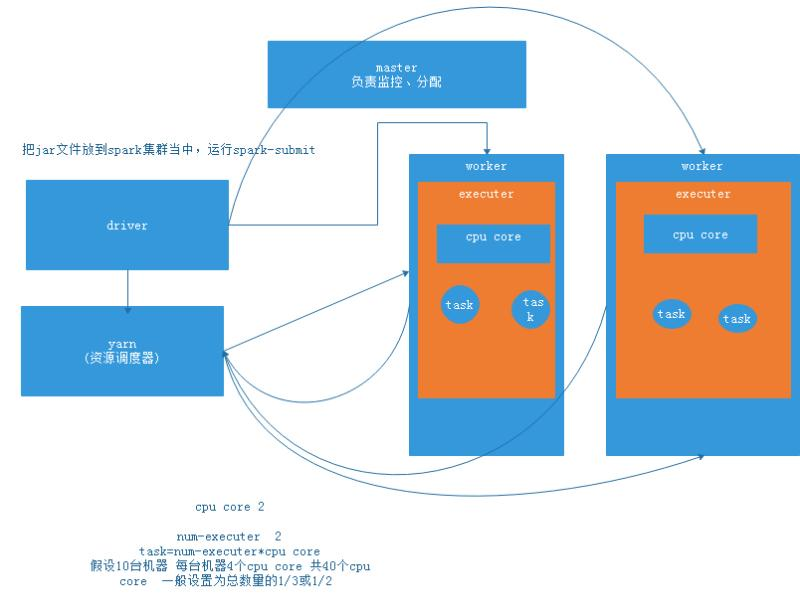

- spark性能调优:资源优化

在开发完Spark作业之后,就该为作业配置合适的资源了.Spark的资源参数,基本都可以在spark-submit命令中作为参数设置.很多Spark初学者,通常不知道该设置哪些必要的参数,以及如何设置 ...

- Spark学习之路 (十二)SparkCore的调优之资源调优

摘抄自:https://tech.meituan.com/spark-tuning-basic.html 一.概述 在开发完Spark作业之后,就该为作业配置合适的资源了.Spark的资源参数,基本都 ...

- Spark在实际项目中分配更多资源

Spark在实际项目中分配更多资源 Spark在实际项目中分配更多资源 性能调优概述 分配更多资源 性能调优问题 解决思路 为什么调节了资源以后,性能可以提升? 性能调优概述 分配更多资源 性能调优的 ...

- Spark学习之路 (十二)SparkCore的调优之资源调优[转]

概述 在开发完Spark作业之后,就该为作业配置合适的资源了.Spark的资源参数,基本都可以在spark-submit命令中作为参数设置.很多Spark初学者,通常不知道该设置哪些必要的参数,以及如 ...

- Spark的性能调优杂谈

下面这些关于Spark的性能调优项,有的是来自官方的,有的是来自别的的工程师,有的则是我自己总结的. 基本概念和原则 <1> 每一台host上面可以并行N个worker,每一个worke ...

- Spark(九)Spark之Shuffle调优

一.概述 大多数Spark作业的性能主要就是消耗在了shuffle环节,因为该环节包含了大量的磁盘IO.序列化.网络数据传输等操作.因此,如果要让作业的性能更上一层楼,就有必要对shuffle过程进行 ...

随机推荐

- 用electrion打包angular成桌面应用

用electrion官网的不行. 还好,可以直接照搬 https://github.com/maximegris/angular-electron 安装必要的库 npm i --save-dev el ...

- mysql5.7提示密码过期的解决方法

首先把MySQL关闭 打开一个终端,输入 sudo /usr/local/mysql/bin/mysqld_safe --skip-grant-tables 执行完命令后,再打开一个新的终端 sudo ...

- 第06课:作用域、JS预解析机制

从字面上理解----域就是空间.范围.区域,作用就是读.写,所以作用域我们可以简单理解为:在什么样空间或者范围内对数据进行什么样的读或写操作. 看一下代码 alert(a); // 为什么是undef ...

- (十七)C语言之变量

- Ubuntu16.04配置vncserver后 导致重复进入登陆界面,无法进入桌面的问题

1.在配置vncserver的时候,可能导致该用户不能正常登录桌面. 2.问题现象:正确输入密码,系统无法进入桌面,闪回到登录界面. 3.在登录界面按ctrl+Alt+F1,进入虚拟控制台(输入r ...

- 极光推送报错time_to_live value should be a non-negative integertime_to_live value should be a non-negative integer

文件中修改

- linu逻辑分区动态调整大小

注意: 这个动态调整的方法是有丢数据风险的,要确保调整的源分区没有使用或者使用率很低.源分区中如果有重要的文件最好先备份 在centos 6.5上操作过 lvdisplay 查看已有的分区的大小 lv ...

- cp复制命令详解

linux复制指定目录下的全部文件到另一个目录中复制指定目录下的全部文件到另一个目录中文件及目录的复制是经常要用到的.linux下进行复制的命令为cp.假设复制源目录 为 dir1 ,目标目录为dir ...

- jxbrowser 监听所有网络请求 jxbrowser 系列教程2

原文:https://blog.csdn.net/shuaizai88/article/details/73649322

- 微信小程序开发工具下载以及安装教程

微信公众平台上登录你的微信小程序账号 登录进入小程序开发-工具-下载,再根据你的系统选择相对应的版本地址进行下载. 以管理员身份运行下载,点击下一步,如图所示: 下一步,就会出现许可证协议 ...