scrapy xpath用法

一、实验环境

1.Windows7x64_SP1

2.anaconda3 + python3.7.3(anaconda集成,不需单独安装)

3.scrapy1.6.0

二、用法举例

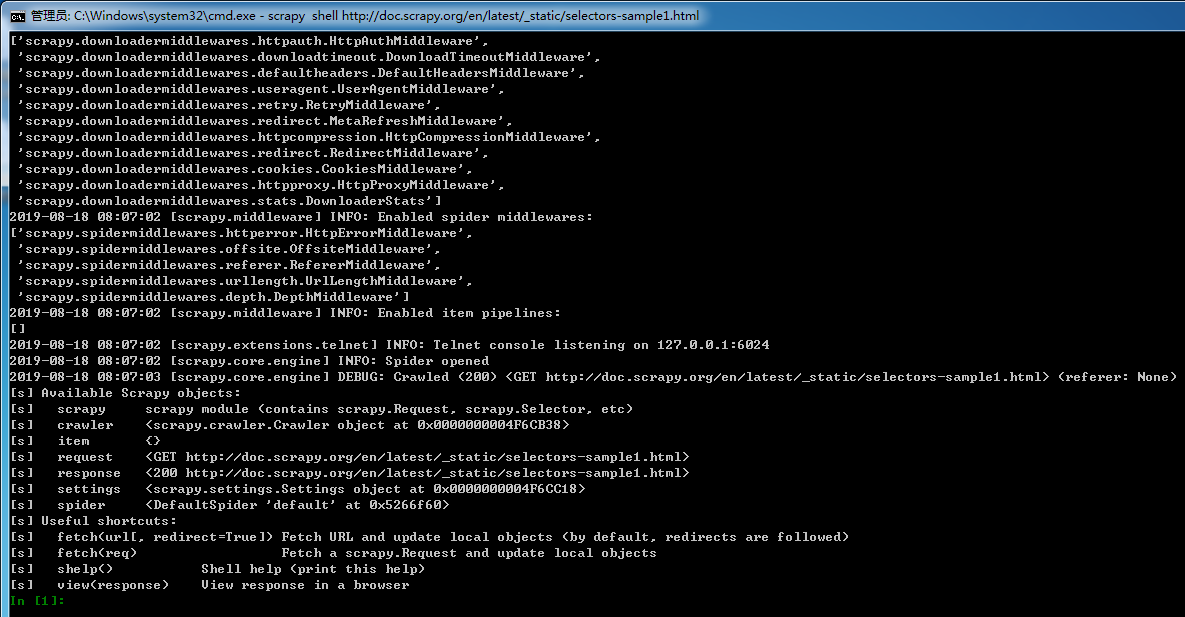

1.开启scrapy shell,在命令行输入如下命令:

scrapy shell http://doc.scrapy.org/en/latest/_static/selectors-sample1.html

结果如下:

2.提取a节点

xpath中用法

result = response.xpath('//a')

结果如下:

[<Selector xpath='//a' data='<a href="image1.html">Name: My image 1 <'>,

<Selector xpath='//a' data='<a href="image2.html">Name: My image 2 <'>,

<Selector xpath='//a' data='<a href="image3.html">Name: My image 3 <'>,

<Selector xpath='//a' data='<a href="image4.html">Name: My image 4 <'>,

<Selector xpath='//a' data='<a href="image5.html">Name: My image 5 <'>]

css中用法

result = response.css('a')

结果如下:

[<Selector xpath='descendant-or-self::a' data='<a href="image1.html">Name: My image 1 <'>,

<Selector xpath='descendant-or-self::a' data='<a href="image2.html">Name: My image 2 <'>,

<Selector xpath='descendant-or-self::a' data='<a href="image3.html">Name: My image 3 <'>,

<Selector xpath='descendant-or-self::a' data='<a href="image4.html">Name: My image 4 <'>,

<Selector xpath='descendant-or-self::a' data='<a href="image5.html">Name: My image 5 <'>]

3.查看result的类型

type(result)

结果如下:

scrapy.selector.unified.SelectorList

说明:result为Selector组成的列表,也是SelectList类型,他们都可以继续调用xpath()和css()等方法,进一步提取数据。

4.查看result提取数据全部内容,使用extract()函数

result.extract()

结果如下:

['<a href="image1.html">Name: My image 1 <br><img src="data:image1_thumb.jpg"></a>',

'<a href="image2.html">Name: My image 2 <br><img src="data:image2_thumb.jpg"></a>',

'<a href="image3.html">Name: My image 3 <br><img src="data:image3_thumb.jpg"></a>',

'<a href="image4.html">Name: My image 4 <br><img src="data:image4_thumb.jpg"></a>',

'<a href="image5.html">Name: My image 5 <br><img src="data:image5_thumb.jpg"></a>']

5.提取节点内容

xpath中用法,使用text()函数

response.xpath('//a/text()')

结果如下:

[<Selector xpath='//a/text()' data='Name: My image 1 '>,

<Selector xpath='//a/text()' data='Name: My image 2 '>,

<Selector xpath='//a/text()' data='Name: My image 3 '>,

<Selector xpath='//a/text()' data='Name: My image 4 '>,

<Selector xpath='//a/text()' data='Name: My image 5 '>]

查看HTML内容

response.xpath('//a/text()').extract()

结果如下:

['Name: My image 1 ',

'Name: My image 2 ',

'Name: My image 3 ',

'Name: My image 4 ',

'Name: My image 5 ']

css中用法

response.css('a::text').extract()

结果如下:

['Name: My image 1 ',

'Name: My image 2 ',

'Name: My image 3 ',

'Name: My image 4 ',

'Name: My image 5 ']

6.提取属性值

xpath中用法,使用/@属性名(如/@href)

response.xpath('//a/@href').extract()

结果如下:

['image1.html', 'image2.html', 'image3.html', 'image4.html', 'image5.html']

- css中用法

response.css('a::attr("href")').extract()

结果如下:

['image1.html', 'image2.html', 'image3.html', 'image4.html', 'image5.html']

7.提取节点内部子节点

xpath中用法,/子节点名

response.xpath('//a/img').extract()

结果如下:

['<img src="data:image1_thumb.jpg">',

'<img src="data:image2_thumb.jpg">',

'<img src="data:image3_thumb.jpg">',

'<img src="data:image4_thumb.jpg">',

'<img src="data:image5_thumb.jpg">']

css中用法

response.css('a img').extract()

结果如下:

['<img src="data:image1_thumb.jpg">',

'<img src="data:image2_thumb.jpg">',

'<img src="data:image3_thumb.jpg">',

'<img src="data:image4_thumb.jpg">',

'<img src="data:image5_thumb.jpg">']

再提取其中的src属性值,与步骤6相同

xpath用法

response.xpath('//a/img/@src').extract()

css用法

response.css('a img::attr("src")').extract()

8.公用方法

- extract_first() #用于提取第一个元素

- extract_first('default value') #同上,添加默认参数

scrapy xpath用法的更多相关文章

- xPath 用法总结整理

xPath 用法总结整理 一.xpath介绍 XPath 是一门在 XML 文档中查找信息的语言.XPath 用于在 XML 文档中通过元素和属性进行导航. XPath 使用路径表达式在 XML ...

- scrapy xpath、正则表达式、css选择器

scrapy xpath XPath即为XML路径语言,它是一种用来确定XML(标准通用标记语言的子集)文档中某部分位置的语言.XPath基于XML的树状结构,提供在数据结构树中找寻节点的能力. 学习 ...

- scrapy基本用法

scrapy官方文档http://doc.scrapy.org/en/latest/ 一.scrapy安装 安装lxml:pip3 install lxml 安装wheel:pip3 install ...

- scrapy Selector用法及xpath语法

准备工作 html示例: <?xml version="1.0" encoding="UTF-8"?> <html <head> ...

- scrapy shell 用法(慢慢更新...)

scrapy shell 命令 1.scrapy shell url #url指你所需要爬的网址 2.有些网址数据的爬取需要user-agent,scrapy shell中可以直接添加头文件, 第①种 ...

- 网络爬虫之Xpath用法汇总

众所周知,在设计爬虫时,最麻烦的一步就是对网页元素进行分析,目前流行的网页元素获取的工具有BeautifulSoup,lxml等,而据我使用的体验而言,Scrapy的元素选择器Xpath(结合正则表达 ...

- Xpath用法

在进行网页抓取的时候,分析定位html节点是获取抓取信息的关键,目前我用的是lxml模块(用来分析XML文档结构的,当然也能分析html结构), 利用其lxml.html的xpath对html进行分析 ...

- 扩展视图之xpath用法

在视图扩展中,需要定位扩展字段需要显示的位置,通过xpath来实现定位 odoo 视图函数 在整个项目文件中,结构并不是十分明显,虽然它也遵循MVC设计,类比django的MTV模式,各个模块区分的十 ...

- Python re模块, xpath 用法

1.re正则的用法总结 (1). ^ 表示以哪个字符为开头 eg: '^g' 表示以g开头的字符串 . 表示任意字符 '^g.d' 表示以g开头第二个为任意字符,第三个为b的字 ...

随机推荐

- Java编程思想:构建复杂模型

import sun.nio.cs.Surrogate; import java.util.ArrayList; import java.util.Random; public class Test ...

- [原创]SSH Tunnel for UDP

SSH Tunnel for UDP UDP port forwarding is a bit more complicated. We will need to convert the packet ...

- [记录]一则HTTP配置文件参考记录

# cat ../conf/httpd.conf | grep -vE "^$|^#" ServerTokens OS ServerRoot "/etc/httpd&qu ...

- 个人永久性免费-Excel催化剂功能第32波-空行空列批量插入和删除

批量操作永远是效率提升的王道,也是Excel用户们最喜欢能够实现的操作虽说有些批量操作不一定合适Excel的最佳实践操作,但万千世界,无奇不有,特别是在国人眼中领导最大的等级森严的职场环境下.Exce ...

- nginx配置目录访问&用户名密码控制

背景 项目上需要一些共享目录让外地同事可以网页访问对应的文件,且受权限控制: 现有环境: centos nginx 你可以了解到以下内容: 配置nginx开启目录访问 并配置nginx用户名和密码进行 ...

- 一文带你实现RPC框架

想要获取更多文章可以访问我的博客 - 代码无止境. 现在大部分的互联网公司都会采用微服务架构,但具体实现微服务架构的方式有所不同,主流上分为两种,一种是基于Http协议的远程调用,另外一种是基于RPC ...

- Python基础之格式化输出、运算符、数字与布尔值互换以及while...else

python是一天学一点,就这样零零碎碎…… 格式化输出 %是占位符,%s是字符串格式,%d整数格式,%f是浮点数格式 name = input('输入姓名') age = input('输入年龄') ...

- 写这篇博客之前,我又忘了“==”和equals的区别。

没错.嘟嘟又把==号和equals 的区别给忘掉了 ==号比较基本类型的时候比的是值,比较引用类型的时候比较的是地址.equals比较基本类型的时候.... 脑子里关于这道题的答案好模糊好没有安全感 ...

- python基础——字符串(string)

字符串是 Python 中最常用的数据类型.我们可以使用引号('或")来创建字符串. 创建字符串很简单,只要为变量分配一个值即可. str1 = 'python' str2 = " ...

- BGP属性控制实验

目录 实验拓扑 实验需求 实验步骤 个人小结: 实验拓扑 实验需求 更改BGP路由的属性让R4访问R1优先选R2这条路 实验步骤 1. 按照图示配置IP地址及环回口地址 R1 [R1]int g0/0 ...