Python抓取豆瓣电影top250!

前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者:404notfound

一直对爬虫感兴趣,学了python后正好看到某篇关于爬取的文章,就心血来潮实战一把吧。当然如果你学的不好,建议可以先去小编的Python交流.裙 :一久武其而而流一思(数字的谐音)转换下可以找到了,里面有最新Python教程项目,一起交流学习进步!

实现目标:抓取豆瓣电影top250,并输出到文件中

1.找到对应的url:https://movie.douban.com/top250

2.进行页面元素的抓取:

3.编写代码:

第一步:实现抓取第一个页面;

第二步:将其他页面的信息也抓取到;

第三步:输出到文件;

4.代码:

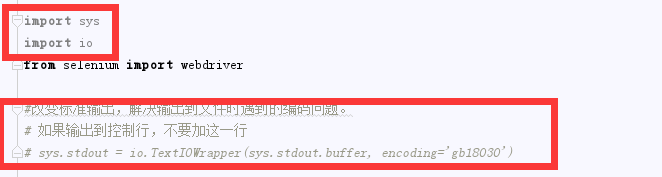

import sys

import io

from selenium import webdriver #改变标准输出,解决输出到文件时遇到的编码问题。

# 如果输出到控制行,不要加这一行

# sys.stdout = io.TextIOWrapper(sys.stdout.buffer, encoding='gb18030') class DouBan:

#初始化driver对象,打开页面,最大化页面

def __init__(self):

self.driver=webdriver.Chrome()

self.driver.get('https://movie.douban.com/top250')

self.driver.maximize_window() # 分页判断,默认显示第一页,输出第一页后,点击下一页按钮,再输出。总共10页

def get_content(self):

for page in range(1,10):

#获取元素定位: 对当前页面中 单个电影元素进行定位

movie = self.driver.find_elements_by_class_name('info') # for循环:循环输出当前页面中单部影片的电影信息(text输出元素的文本内容);

i = 1

for item in movie:

#输出格式: 电影序号 + 电影介绍 +换行展示

print(str(i+ page*25-25)+": "+item.text+'')

print("")

i+=1 # 判断:如果当前页面码小于10,则查找页码的元素,并点击页码。否则不用进行查找,因为最多点击第10页;

# 获取底部的页签元素(采用了format格式输出,根据当前页面做加1操作)

if page<10:

page_but = self.driver.find_element_by_xpath('//div[@class="paginator"]//a[contains(text(),{0})]'.format(page + 1))

page_but.click()

else:

pass if __name__ == '__main__':

DouBan().get_content()

5.结果:

1)控制台输出部分截图:

2)如果想要输出到文件,执行命令并重定向到TXT文件中:

python xxxx.py >d:/out_test.txt

6.遇到的问题:

1.多页时,for循环的数字设置,来回试几次就可以了,不难。

2.输出到文件中

真的很简单,不知道你们都懂了没? 如果没懂可以去小编的Python交流.裙 :一久武其而而流一思(数字的谐音)转换下可以找到了,里面有最新Python教程项目,一起交流学习进步!有问题留言问我吧~

Python抓取豆瓣电影top250!的更多相关文章

- Python:python抓取豆瓣电影top250

一直对爬虫感兴趣,学了python后正好看到某篇关于爬取的文章,就心血来潮实战一把吧. 实现目标:抓取豆瓣电影top250,并输出到文件中 1.找到对应的url:https://movie.douba ...

- Python小爬虫——抓取豆瓣电影Top250数据

python抓取豆瓣电影Top250数据 1.豆瓣地址:https://movie.douban.com/top250?start=25&filter= 2.主要流程是抓取该网址下的Top25 ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

- python2.7抓取豆瓣电影top250

利用python2.7抓取豆瓣电影top250 1.任务说明 抓取top100电影名称 依次打印输出 2.网页解析 要进行网络爬虫,利用工具(如浏览器)查看网页HTML文件的相关内容是很有必要,我使用 ...

- Python3 抓取豆瓣电影Top250

利用 requests 抓取豆瓣电影 Top 250: import re import requests def main(url): global num headers = {"Use ...

- python爬取豆瓣电影Top250(附完整源代码)

初学爬虫,学习一下三方库的使用以及简单静态网页的分析.就跟着视频写了一个爬取豆瓣Top250排行榜的爬虫. 网页分析 我个人感觉写爬虫最重要的就是分析网页,找到网页的规律,找到自己需要内容所在的地方, ...

- 零基础爬虫----python爬取豆瓣电影top250的信息(转)

今天利用xpath写了一个小爬虫,比较适合一些爬虫新手来学习.话不多说,开始今天的正题,我会利用一个案例来介绍下xpath如何对网页进行解析的,以及如何对信息进行提取的. python环境:pytho ...

- Python 爬取豆瓣电影Top250排行榜,爬虫初试

from bs4 import BeautifulSoup import openpyxl import re import urllib.request import urllib.error # ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

随机推荐

- mysql提示Packet for query is too large (1142 > 1024)解决方案

注:最近mysql一直提示如下错误 Packet for query is too large (1185 > 1024). You can change this value on the s ...

- Django 基本使用

Django 基本使用 Django 安装 pip install django Django 创建项目 django-admin startproject 项目名称 Django 创建应用 pyth ...

- ACE框架 基于共享内存的进程间通讯

ACE框架将基于共享内存的进程间通讯功能,如其它IO组件或IPC组件一样,设计成三个组件.流操作组件ACE_MEM_Stream,连接器组件ACE_MEM_Connector,以及接收连接组件ACE_ ...

- Python自动化办公之操作Excel文件

模块导入 import openpyxl 读取Excel文件 打开Excel文件 workbook = openpyxl.load_workbook("test.xlsx") 输出 ...

- windows 10上源码编译dlib教程 | compile dlib on windows 10

本文首发于个人博客https://kezunlin.me/post/654a6d04/,欢迎阅读! compile dlib on windows 10 Series Part 1: compile ...

- 【Oracle】Oracle数据库基本指标查看

目录 1.查看表空间 2.查看用户 3.查看数据库内存 4.查看数据库版本 5.oracle归档情况 6.查看redo log日志位置 7.查看数据库的控制文件 8.查看RMAN的备份情况 9.FRA ...

- JavaScript 关于setTimeout与setInterval的小研究

说明 在开发功能"轨迹播放"时,遇到了一个情况. 原先同事已经开发了一版,这次有个新功能:点击线上任意一点后可以从点击处重新播放. 看了一下原来的版本,发现同时使用了setTime ...

- Java基础知识总结之多线程

1.基本概念 进程是程序的一次动态执行过程,是系统进行资源分配和调度运行的基本单位. 线程是进程的一个实体,它是比进程更小的的能够独立运行的基本单位.在引入线程的操作系统中,通常都是把进程作为分配资源 ...

- STDN: Scale-Transferrable Object Detection论文总结

概述 STDN是收录于CVPR 2018的一篇目标检测论文,提出STDN网络用于提升多尺度目标的检测效果.要点包括:(1)使用DenseNet-169作为基础网络提取特征:(2)提出Scale-tra ...

- [从今天开始修炼数据结构]线性表及其实现以及实现有Itertor的ArrayList和LinkedList

一.线性表 1,什么是线性表 线性表就是零个或多个数据元素的有限序列.线性表中的每个元素只能有零个或一个前驱元素,零个或一个后继元素.在较复杂的线性表中,一个数据元素可以由若干个数据项组成.比如牵手排 ...