spark 应用场景2-身高统计

原文引自:http://blog.csdn.net/fengzhimohan/article/details/78564610

a. 案例描述

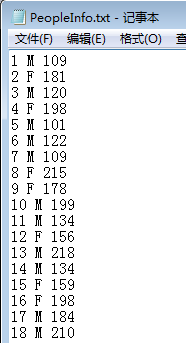

本案例假设我们需要对某个省的人口 (10万) 性别还有身高进行统计,需要计算出男女人数,男性中的最高和最低身高,以及女性中的最高和最低身高。本案例中用到的源文件有以下格式, 三列分别是 ID,性别,身高 (cm),格式如下:

b.人口数据的生成

利用Java语言随机生成一组人口数据,包括序列ID,性别M/F,身高cm,代码如下:

import java.io.File;

import java.io.FileWriter;

import java.io.IOException;

import java.util.Random; /**

* Created by Administrator on 2017/11/13.

*/

public class PeopleInfoFileGenerator {

public static void main(String[] args){

File file = new File("F:\\PeopleInfo.txt"); try {

Random random = new Random();//生成随机数

FileWriter fileWriter = new FileWriter(file);//新建一个文件

for (int i=1;i<=1000000;i++){ //生成10万个数字

int height = random.nextInt(220);

if (height < 50) {

height = height + 50;

}

String gender = getRandomGender(); //性别方法

if (height < 100 && gender == "M") {

height = height + 100;

}

if (height < 100 && gender == "F") {

height = height + 40;

}

fileWriter.write( i + " " + getRandomGender() + " " + height); //文件格式:ID 性别 身高

fileWriter.write(System.getProperty("line.separator"));

}

fileWriter.flush();

fileWriter.close();

System.out.println("People Information File generated successfully.");

}catch (IOException e){

e.printStackTrace();

}

} public static String getRandomGender(){ //构建一个随机生成性别方法

Random random = new Random();

int randomNum = random.nextInt(2) + 1;

if( randomNum % 2 == 0){

return "M";

}else{

return "F";

}

}

}

c. 实例过程分析

对于这个案例,我们要分别统计男女的信息,那么很自然的想到首先需要对于男女信息从源文件的对应的 RDD 中进行分离,这样会产生两个新的 RDD,分别包含男女信息;其次是分别对男女信息对应的 RDD 的数据进行进一步映射,使其只包含身高数据,这样我们又得到两个 RDD,分别对应男性身高和女性身高;最后需要对这两个 RDD 进行排序,进而得到最高和最低的男性或女性身高。

第一步,先分离男女信息,使用 filter 算子过滤条件包含”M” 的行是男性,包含”F”的行是女性;第二步我们需要使用 map 算子把男女各自的身高数据从 RDD 中分离出来;第三步我们需要使用 sortBy 算子对男女身高数据进行排序。

特别注意:RDD 转化的过程中需要把身高数据转换成整数,否则 sortBy 算子会把它视为字符串,那么排序结果就会受到影响,例如 身高数据如果是:123,110,84,72,100,那么升序排序结果将会是 100,110,123,72,84,显然这是不对的。

d.求出身高统计代码实现

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function;

import java.util.Arrays;

/**

* Created by Administrator on 2017/11/17.

*/

public class PeopleInfoCalculator {

public static void main(String[] args){

SparkConf sparkConf = new SparkConf().setAppName("PeopleInfoCalculator").setMaster("local[3]");

JavaSparkContext sc = new JavaSparkContext(sparkConf);

JavaRDD<String> dataFile = sc.textFile("F:\\PeopleInfo.txt"); JavaRDD<String> maleFilterData = dataFile.filter(new Function<String, Boolean>() {//过滤出性别为M的数据

@Override

public Boolean call(String s) throws Exception {

return s.contains("M");

}

});

JavaRDD<String> femaleFilterData = dataFile.filter(new Function<String, Boolean>() {//过滤出性别为F的数据

@Override

public Boolean call(String s) throws Exception {

return s.contains("F");

}

});

JavaRDD<String> maleHeightData = maleFilterData.flatMap(new FlatMapFunction<String, String>() {//得到性别为M的身高数据

@Override

public Iterable<String> call(String s) throws Exception {

return Arrays.asList(s.split(" ")[2]);

}

});

JavaRDD<String> femaleHeightData = femaleFilterData.flatMap(new FlatMapFunction<String, String>() {//得到性别为F的身高数据

@Override

public Iterable<String> call(String s) throws Exception {

return Arrays.asList(s.split(" ")[2]);

}

});

JavaRDD<Integer> maleHeightDataInt = maleHeightData.map(new Function<String, Integer>() {//将字符串格式转化为整型格式

@Override

public Integer call(String s) throws Exception {

return Integer.parseInt(String.valueOf(s));

}

});

JavaRDD<Integer> femaleHeightDataInt = femaleHeightData.map(new Function<String, Integer>() {//将字符串格式转化为整型格式

@Override

public Integer call(String s) throws Exception {

return Integer.parseInt(String.valueOf(s));

}

});

//sortBy(<T>,ascending,numPartitions) 解释:

//第一个参数是一个函数,该函数的也有一个带T泛型的参数,返回类型和RDD中元素的类型是一致的;

//第二个参数是ascending,这参数决定排序后RDD中的元素是升序还是降序,默认是true,也就是升序;

//第三个参数是numPartitions,该参数决定排序后的RDD的分区个数,默认排序后的分区个数和排序之前的个数相等,即为this.partitions.size。

JavaRDD<Integer> maleHeightLowSort = maleHeightDataInt.sortBy(new Function<Integer,Integer>(){// true表示默认排序,为升序排序,从低到高排

public Integer call(Integer s) throws Exception {

return s;

}

},true,3);

JavaRDD<Integer> femaleHeightLowSort = femaleHeightDataInt.sortBy(new Function<Integer,Integer>(){// true表示默认排序,为升序排序,从低到高排

public Integer call(Integer s) throws Exception {

return s;

}

},true,3);

JavaRDD<Integer> maleHeightHightSort = maleHeightDataInt.sortBy(new Function<Integer,Integer>(){// false表示为降序排序,从高到低

public Integer call(Integer s) throws Exception {

return s;

}

},false,3);

JavaRDD<Integer> femaleHeightHightSort = femaleHeightDataInt.sortBy(new Function<Integer,Integer>(){// true表示默认排序,为降序排序,从低到高排

public Integer call(Integer s) throws Exception {

return s;

}

},false,3);

Integer lowestMale = maleHeightLowSort.first(); //求出升序的第一个数,即最小值

Integer lowestFemale = femaleHeightLowSort.first();//求出升序的第一个数,即最小值

Integer highestMale = maleHeightHightSort.first();//求出降序的第一个数,即最大值

Integer highestFemale = femaleHeightHightSort.first();//求出降序的第一个数,即最大值 System.out.println("Number of Female Peole:" + femaleHeightData.count());//求出女性的总个数

System.out.println("Number of Male Peole:" + maleHeightData.count());//求出男性的总个数

System.out.println("Lowest Male:" + lowestMale);//求出男性最矮身高

System.out.println("Lowest Female:" + lowestFemale);//求出女性最矮身高

System.out.println("Highest Male:" + highestMale);//求出男性最高身高

System.out.println("Highest Female:" + highestFemale);//求出女性最高身高 }

}

e.运行结果:

spark 应用场景2-身高统计的更多相关文章

- Spark学习笔记1——第一个Spark程序:单词数统计

Spark学习笔记1--第一个Spark程序:单词数统计 笔记摘抄自 [美] Holden Karau 等著的<Spark快速大数据分析> 添加依赖 通过 Maven 添加 Spark-c ...

- Spark案例练习-UV的统计

关注公众号:分享电脑学习回复"百度云盘" 可以免费获取所有学习文档的代码(不定期更新)云盘目录说明:tools目录是安装包res 目录是每一个课件对应的代码和资源等doc 目录是一 ...

- spark 应用场景1-求年龄平均值

原文引自:http://blog.csdn.net/fengzhimohan/article/details/78535143 该案例中,我们将假设我们需要统计一个 10 万人口的所有人的平均年龄,当 ...

- spark SQL学习(案例-统计每日销售)

需求:统计每日销售额 package wujiadong_sparkSQL import org.apache.spark.sql.types._ import org.apache.spark.sq ...

- spark SQL学习(案例-统计每日uv)

需求:统计每日uv package wujiadong_sparkSQL import org.apache.spark.sql.{Row, SQLContext} import org.apache ...

- Spark Streaming的样本demo统计

废话不多说,直接上代码 package com.demo; import java.util.List; import java.util.regex.Pattern; import org.apac ...

- Spark应用场景以及与hadoop的比较

一.大数据的四大特征: a.海量的数据规模(volume) b.快速的数据流转和动态的数据体系(velocity) c.多样的数据类型(variety) d.巨大的数据价值(value) 二.Spar ...

- Spark案例练习-PV的统计

关注公众号:分享电脑学习回复"百度云盘" 可以免费获取所有学习文档的代码(不定期更新) 云盘目录说明: tools目录是安装包res 目录是每一个课件对应的代码和资源等doc ...

- Spark词频前十的统计练习

注:图片如果损坏,点击文章链接:https://www.toutiao.com/i6815390070254600712/ 承接上一个文档<Spark本地环境实现wordCount单词计数> ...

随机推荐

- javascript追加节点

追加节点 <!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3 ...

- hive的数据压缩

hive的数据压缩 在实际工作当中,hive当中处理的数据,一般都需要经过压缩,前期我们在学习hadoop的时候,已经配置过hadoop的压缩,我们这里的hive也是一样的可以使用压缩来节省我们的MR ...

- JS常见的报错类型

解决错误前,首先要学会阅读报错信息 eg:Uncaught TypeError: ... is not a function Uncaught 表示没有被catch语句捕获到的错误 TypeError ...

- Python 爬虫-爬取京东手机页面的图片

具体代码如下: __author__ = 'Fred Zhao' import requests from bs4 import BeautifulSoup import os from urllib ...

- 修改ActiveProcessLinks链表隐藏进程

在Windows内核中有一个活动进程链表AcvtivePeorecssList.它是一个双向链表,保存着系统中所有进程的EPROCESS结构.特别地,进程的EPROCESS结构包含一个具有指针成员FL ...

- ElasticSearch 命令执行漏洞(CVE-2014-3120)

POST /_search?pretty HTTP/1.1 Host: your-ip:9200 Accept: */* Accept-Language: en User-Agent: Mozilla ...

- mysql之MHA、Mycat综合分析

一.简介 MHA: 你可以把它看做是一个监控MySQL的工具,当master挂了之后,起一个slave作为master,另外一台slave重新作为新master的备库: 所以MHA的架构做好是三台数 ...

- SonarQube代码质量扫描持续集成

1.安装JDK和配置JAVA_HOME和CLASSPATH 2.安装mysql数据库 3.创建数据库和用户 mysql -u root -p mysql> CREATE DATABASE son ...

- 一些CSS3新技术

前些日子在SmashingMagazine看到一篇关于CSS3新技术不错的文章,它详细介绍了CSS3的新特性和它的使用方法,它包括:浏览器专有属性.选择器(属性选择器.连字符.伪类.伪元素).RGBA ...

- 使用CSS3开启GPU硬件加速提升网站动画渲染性能

遇到的问题: 网站本身设计初衷就没有打算支持IE8及以下版本浏览器,并不是因为代码兼容性问题,而是真的不想迁就那些懒得更新自己操作系统和浏览器的用户,毕竟是我自己的网站,所以我说了算!哈哈~ 没有了低 ...