linux运维、架构之路-Kubernetes本地镜像仓库+dashboard部署

一、部署docker registry

生产环境中我们一般通过搭建本地的私有镜像仓库(docker registry)来拉取镜像。

1、拉取registry镜像

[root@k8s-master ~]#docker pull docker.io/registry

Using default tag: latest

Trying to pull repository docker.io/library/registry ...

sha256:0e40793ad06ac099ba63b5a8fae7a83288e64b50fe2eafa2b59741de85fd3b97: Pulling from docker.io/library/registry

b7f33cc0b48e: Pull complete

46730e1e05c9: Pull complete

: Pull complete

0cf045fea0fd: Pull complete

b78a03aa98b7: Pull complete

Digest: sha256:0e40793ad06ac099ba63b5a8fae7a83288e64b50fe2eafa2b59741de85fd3b97

Status: Downloaded newer image for docker.io/registry:latest

2、启动registry

docker run -d -p : --name=registry --restart=always --privileged=true --log-driver=none -v /home/data/registrydata:/tmp/registry registry

注:/home/data/registrydata是一个比较大的系统分区,今后镜像仓库中的全部数据都会保存在这个外挂目录下

3、Node节点改名并推送镜像

①以部署dashboard的镜像为例,后面也会用到

百度云下载链接:https://pan.baidu.com/s/1geKEADt#list/path=%2F 密码:lbyp

②上传到Node节点并推送到镜像仓库

docker load < dashboard.tar

docker load < podinfrastructure.tar

docker tag gcr.io/google_containers/kubernetes-dashboard-amd64:v1.7.1 10.0.0.211:/google_containers/kubernetes-dashboard-amd64:latest

docker tag registry.access.redhat.com/rhel7/pod-infrastructure:latest 10.0.0.211:/rhel7/pod-infrastructure:latest docker push 10.0.0.211:/google_containers/kubernetes-dashboard-amd64:latest

docker push 10.0.0.211:/rhel7/pod-infrastructure:latest

推送失败报错

Get https://10.0.0.211:5000/v1/_ping: http: server gave HTTP response to HTTPS client

解决办法

①种方法:vim /etc/sysconfig/docker加入

OPTIONS='--insecure-registry 10.0.0.211:5000'

②种方法

echo '{ "insecure-registries":["10.0.0.211:5000"] }' > /etc/docker/daemon.json

systemctl restart docker.service

4、Master节点从本地仓库拉取镜像

docker pull 10.0.0.211:/google_containers/kubernetes-dashboard-amd64:latest

docker pull 10.0.0.211:/rhel7/pod-infrastructure

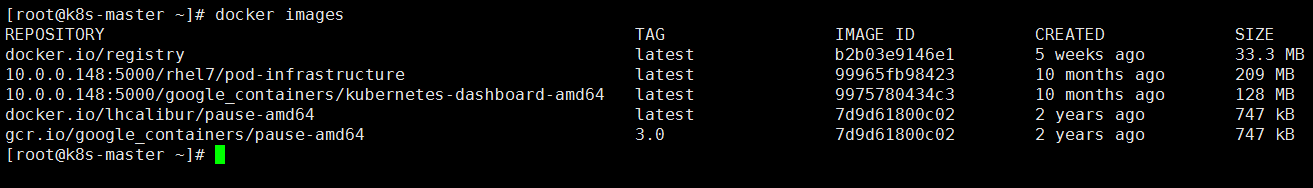

查看:

二、部署dashboard

1、编辑dashboard.yaml文件

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

# Keep the name in sync with image version and

# gce/coreos/kube-manifests/addons/dashboard counterparts

name: kubernetes-dashboard-latest

namespace: kube-system

spec:

replicas:

template:

metadata:

labels:

k8s-app: kubernetes-dashboard

version: latest

kubernetes.io/cluster-service: "true"

spec:

containers:

- name: kubernetes-dashboard

image: 10.0.0.211:/google_containers/kubernetes-dashboard-amd64:latest

resources:

# keep request = limit to keep this container in guaranteed class

limits:

cpu: 100m

memory: 50Mi

requests:

cpu: 100m

memory: 50Mi

ports:

- containerPort:

args:

- --apiserver-host=http://10.0.0.211:8080

livenessProbe:

httpGet:

path: /

port:

initialDelaySeconds:

timeoutSeconds:

注:Dashboard是在yaml中定义的,要更改dashboard.yaml中对应的“image: gcr.io/google_containers/kubernetes-dashboard-amd64:v1.5.1”为“image: 10.0.0.211:5000/kubernetes-dashboard-amd64:latest”

2、编辑dashboardsvc.yaml文件

apiVersion: v1

kind: Service

metadata:

name: kubernetes-dashboard

namespace: kube-system

labels:

k8s-app: kubernetes-dashboard

kubernetes.io/cluster-service: "true"

spec:

selector:

k8s-app: kubernetes-dashboard

ports:

- port:

targetPort:

3、Master节点创建启动命令

kubectl create -f dashboard.yaml

kubectl create -f dashboardsvc.yaml

4、Master执行命令验证

[root@k8s-master ~]# kubectl get deployment --all-namespaces

NAMESPACE NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE

kube-system kubernetes-dashboard-latest 3h

[root@k8s-master ~]# kubectl get svc --all-namespaces

NAMESPACE NAME CLUSTER-IP EXTERNAL-IP PORT(S) AGE

default kubernetes 10.254.0.1 <none> /TCP 2d

kube-system kubernetes-dashboard 10.254.233.11 <none> /TCP 3h

[root@k8s-master ~]# kubectl get pod -o wide --all-namespaces

NAMESPACE NAME READY STATUS RESTARTS AGE IP NODE

kube-system kubernetes-dashboard-latest--09p76 / Running 3h 172.16.6.2 k8s-node-

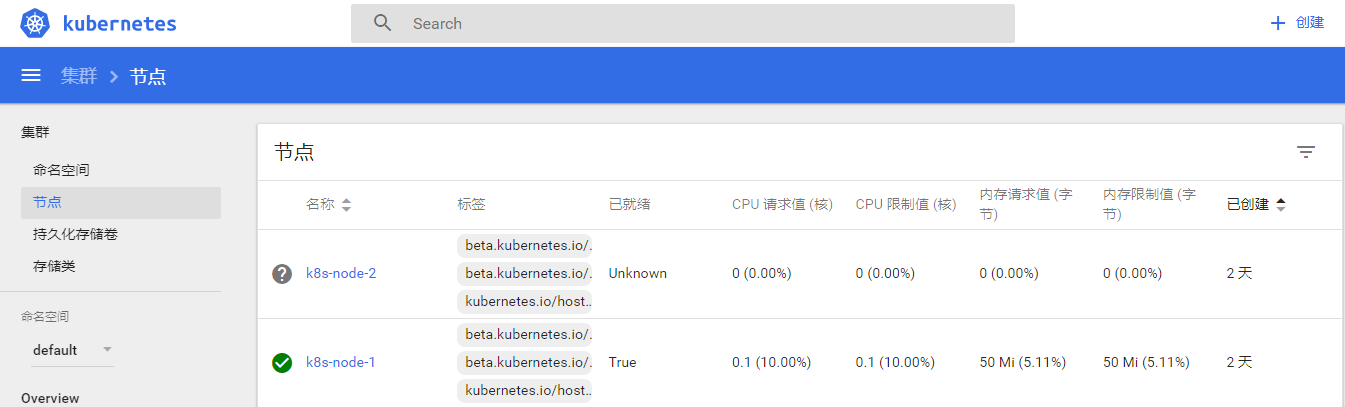

5、浏览器访问

http://10.0.0.211:8080/ui

6、销毁应用

Master节点执行

kubectl delete deployment kubernetes-dashboard-latest --namespace=kube-system

kubectl delete svc kubernetes-dashboard --namespace=kube-system

三、部署遇到的问题

问题1:

{

"kind": "Status",

"apiVersion": "v1",

"metadata": {},

"status": "Failure",

"message": "no endpoints available for service \"kubernetes-dashboard\"",

"reason": "ServiceUnavailable",

"code":

}

解决:需要pause-amd64这个镜像

docker pull googlecontainer/pause-amd64:3.0

docker tag googlecontainer/pause-amd64:3.0 gcr.io/google_containers/pause-amd64:3.0

kubectl delete -f dashboard.yaml

kubectl delete -f dashboardsvc.yaml kubectl create -f dashboard.yaml

kubectl create -f dashboardsvc.yaml

详细查看报错问题

kubectl describe pod kubernetes-dashboard-latest-bf59c4df4-xcblq --namespace kube-system

问题2:部署完成之后访问浏览器报错

Error: 'dial tcp 172.16.6.2:9090: getsockopt: connection refused'

Trying to reach: 'http://172.16.6.2:9090/'

解决:iptables拦截

iptables -P FORWARD ACCEPT 或者 echo "net.ipv4.ip_forward = 1" >>/usr/lib/sysctl.d/50-default.conf

如果永久生效的话,可以修改docker服务启动脚本

vim /etc/systemd/system/docker.service #增加一行

[Service]

ExecStartPost=/sbin/iptables -I FORWARD -s 0.0.0.0/ -j ACCEPT

总结排查方法:

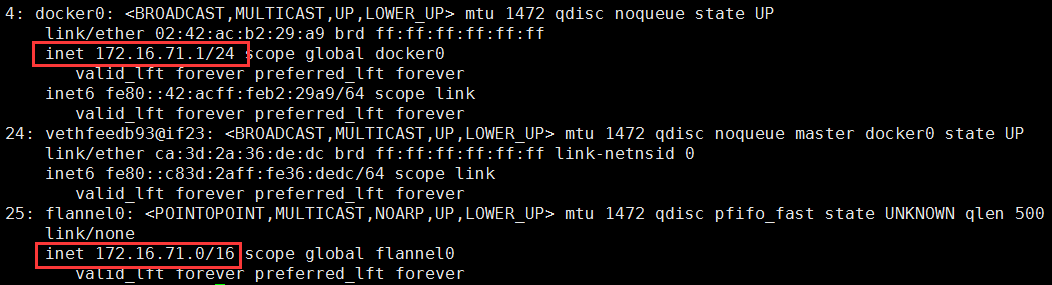

①检查apiserver的地址设置的是否正确,然后就是flannel是否配置启动,确保docker0和flannel0处于同一网段

②查看master和nodes上的flannel配置是否一致

# Flanneld configuration options # etcd url location. Point this to the server where etcd runs

FLANNEL_ETCD_ENDPOINTS="http://10.0.0.211:2379" # etcd config key. This is the configuration key that flannel queries

# For address range assignment

FLANNEL_ETCD_PREFIX="/atomic.io/network" # Any additional options that you want to pass

#FLANNEL_OPTIONS=""

③检查iptables -L,检查node节点上的FORWARD 查看转发是否是drop,如果是drop,则开启

iptables -P FORWARD ACCEPT

或者

echo "net.ipv4.ip_forward = 1" >>/usr/lib/sysctl.d/-default.conf

linux运维、架构之路-Kubernetes本地镜像仓库+dashboard部署的更多相关文章

- linux运维架构师职业规划

1.假如你从来未接触过Linux的话,首先要做的就找一本指导书来学习.现在公认的Linux的入门书籍是“鸟哥的私房菜”,讲的很全面,鸟哥的私房菜一共分为两部,一部是基础篇,一部是服务器篇.“鸟哥的私房 ...

- 微服务架构 - 基于Harbor构建本地镜像仓库

之前写过<搭建docker本地镜像仓库并提供权限校验及UI界面>文章,然后有同仁评论道这样做太复杂了,如果Harbor来搭建会更简单同时功能也更强大.于是抽时间研究了基于Harbor构建本 ...

- Kubernetes学习之路(28)之镜像仓库Harbor部署

Harbor的部署 官方文档 Harbor有两种安装的方式: 在线安装:直接从Docker Hub下载Harbor的镜像,并启动. 离线安装:在官网上下载离线安装包其地址为:https://githu ...

- 干货 | 京东云托管Kubernetes集成镜像仓库并部署原生DashBoard

在上一篇"Cloud Native 实操系列"文章中,我们为大家介绍了如何通过京东云原生容器实现Eureka的部署(

- [ Linux运维学习 ] 路径及实战项目合集

我们知道运维工程师(Operations)最基本的职责就是负责服务的稳定性并确保整个服务的高可用性,同时不断优化系统架构.提升部署效率.优化资源利用率,确保服务可以7*24H不间断地为用户提供服务. ...

- 从苦逼到牛逼,详解Linux运维工程师的打怪升级之路

做运维也快四年多了,就像游戏打怪升级,升级后知识体系和运维体系也相对变化挺大,学习了很多新的知识点. 运维工程师是从一个呆逼进化为苦逼再成长为牛逼的过程,前提在于你要能忍能干能拼,还要具有敏锐的嗅觉感 ...

- Linux 运维入门到跑路书单推荐

一.基础入门 <鸟哥的Linux私房菜基础学习篇>:最具知名度的Linux入门书<鸟哥的Linux私房菜基础学习篇>,全面而详细地介绍了Linux操作系统. https://b ...

- Nginx+Lua+Redis整合实现高性能API接口 - 网站服务器 - LinuxTone | 运维专家网论坛 - 最棒的Linux运维与开源架构技术交流社区! - Powered by Discuz!

Nginx+Lua+Redis整合实现高性能API接口 - 网站服务器 - LinuxTone | 运维专家网论坛 - 最棒的Linux运维与开源架构技术交流社区! - Powered by Disc ...

- Linux运维企业架构实战系列

Linux运维企业架构项目实战系列 项目实战1-LNMP的搭建.nginx的ssl加密.权限控制的实现 项目实战2-LVS.nginx实现负载均衡系列 2.1 项目实战2.1-实现基于LVS负载均衡集 ...

随机推荐

- 中国MOOC_零基础学Java语言_第4周 循环控制_2念整数

2 念整数(5分) 题目内容: 你的程序要读入一个整数,范围是[-100000,100000].然后,用汉语拼音将这个整数的每一位输出出来. 如输入1234,则输出: yi er san si 注意, ...

- DELPHI中函数、过程变量的声明与应用

Procedure型变量: 在DELPHI中,函数.过程的地址可以赋给一个特殊类型的变量,变量可用如下方式声明: var p : procedure(num:integer); //过程 或: var ...

- cocos2dx基础篇(18) 数据存储CCUserDefault

在cocos2dx中提供了一个数据存储类CCUserDefault,可以作为一个轻量级的数据库来使用.它支持五种数据bool.int.float.double.string的存储. [3.x] ...

- psp周总结02

周日 周一 周二 周三 周四 周五 周六 所花时间 180 60 240 180 340 180 培训 代码量 186 65 157 86 200 200 博客量 1 1 了解的知识点 jsp页面 ...

- 递归算法之排列组合-求一个集合S的m个元素的组合和所有可能的组合情况

求一个集合S的m个元素组合的所有情况,并打印出来,非常适合采用递归的思路进行求解.因为集合的公式,本身就是递归推导的: C(n,m) = C(n-1,m-1) + C(n-1,m). 根据该公式,每次 ...

- C盘无损扩容(傻逼拯救者128G固态分两个盘)

下载DiskGenius.exe 进行拆分分区(我从d盘拆分出20G给c盘) 然后右键此电脑,管理->磁盘管理 选中刚分出来的20G空间指向到c盘

- MAC_BOOKPRO苹果电脑系统常用快捷键大全

Mac 键盘快捷键 我在品多多上拼的Mac终于到货了,安全下车,接下来要熟练使用了! 您可以按下某些组合键来实现通常需要鼠标.触控板或其他输入设备才能完成的操作. 要使用键盘快捷键,请按住一个或多 ...

- mysql 修改成utf8编码

参考文档 https://www.cnblogs.com/chenshuo/p/4743144.html

- base64 换表 解密脚本

做逆向经常遇到换表的base64 有了py脚本 一切都好说: import base64 import string str1 = "x2dtJEOmyjacxDemx2eczT5cVS9f ...

- java中时间与时间戳的相互转换

package com.test.one; import java.text.ParseException; import java.text.SimpleDateFormat; import jav ...