tensorflow笔记(二)之构造一个简单的神经网络

tensorflow笔记(二)之构造一个简单的神经网络

版权声明:本文为博主原创文章,转载请指明转载地址

http://www.cnblogs.com/fydeblog/p/7425200.html

前言

这篇博客将一步步构建一个tensorflow的神经网络去拟合曲线,并将误差和结果可视化。博客的末尾会放本篇博客的jupyter notebook,可以下载自己调试调试。

实践——构造神经网络

本次构造的神经网络是要拟合一个二次曲线,神经网络的输入层是一个特征,即只有一个神经元,隐藏层有10个特征,即有10个神经元,输出为一个神经元,总结起来就是1—10—1的结构,如果没有神经网络结构的朋友,还请去补一补

首先我们先导入要用到的模块

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

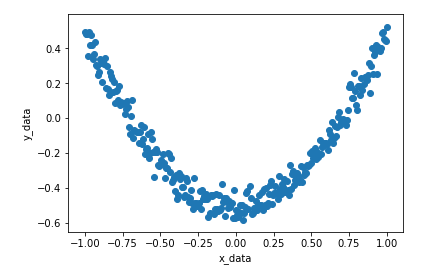

然后我们先构造出原始数据,并画出它的图形(为了更加符合实际,我们会加一些噪声)

x_data = np.linspace(-1,1,300) [:, np.newaxis] # [:,np.newaxis] make row vector transform column vector

noise = np.random.normal(0, 0.05, x_data.shape)

y_data = np.square(x_data) - 0.5 + noise

x_data是一个范围-1到1,以300分之2等份的列向量,noise的shape与x_data一样,值属于正态分布,0到0.05之间,y_data则是x_data的平方,减0.5,加噪声

fig=plt.figure()

ax = fig.add_subplot(1,1,1)

ax.scatter(x_data,y_data)

plt.xlabel('x_data')

plt.ylabel('y_data')

plt.show()

现在我们先写一个添加神经网络层的函数,函数名为add_nn_layer

def add_nn_layer(inputs, in_size, out_size, activation_function=None):

Weights = tf.Variable(tf.random_normal([in_size, out_size]))

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1)

Wx_plus_b = tf.matmul(inputs, Weights) + biases

if activation_function is None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b)

return outputs

神经网络的基本构造是要有输入,还要有输入映射到下一层的权重和偏差,最后神经元还有一个激活函数(这个有没有看需求),控制输出

我们上面讲到这个神经网络的结构是1—10—1,所以要添加两个层,一层是从输入层到隐藏层,另一层是隐藏层到输出层。

从输入层到隐藏层,1—10,输入是300x1的向量,到第二层则是300x10,权重则是1x10,偏差的shape与输出相同

从隐藏层到输出层,10—1,输入是300x10的向量,输出是300x1,可见权重是10x1,偏差的shape与输出相同

由此可以知道上面函数中各种变量的构造原因,简单说神经网络的构造就是输入乘以权重加上偏差,进入神经元的激活函数,然后输出

接下来我们开始写其他代码

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

tf.placeholder函数是一个非常重要的函数,以后用到它的次数会非常多,它表示占位符,相应的值会在sess.run里面feed进去,这样处理会非常灵活,大部分的学习都是分批的,不是一次传入,占位符满足这种需求

这里的xs和ys都是列向量,列数为1,行数不确定,feed的输入行数是多少就是多少

# add hidden layer

l1 = add_nn_layer(xs, 1, 10, activation_function=tf.nn.relu)

# add output layer

prediction = add_nn_layer(l1, 10, 1, activation_function=None)

这里隐藏层的激活函数用的是tf.nn.relu,relu全名是修正线性单元,详细请参考wiki(https://en.wikipedia.org/wiki/Rectifier_(neural_networks)),它的性质简单的说就是输入神经元的数据大于0则等于自身,小于0则等于0,使用它更符合神经网络的性质,即有抑制区域和激活区域,我试了没加激活函数和sigmoid激活函数,效果要比用relu差许多,你们可以试试。

#compute loss

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - prediction),reduction_indices=[1]))

# creat train op,then we can sess.run(train) to minimize loss

train = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

# creat init

init = tf.global_variables_initializer()

# creat a Session

sess = tf.Session()

# system initialize

sess.run(init)

# training

for i in range(1000):

sess.run(train, feed_dict={xs: x_data, ys: y_data})

prediction_value = sess.run(prediction, feed_dict={xs: x_data})

if i % 50 == 0:

# to see the step improvement

print('loss:',sess.run(loss, feed_dict={xs: x_data, ys: y_data}))

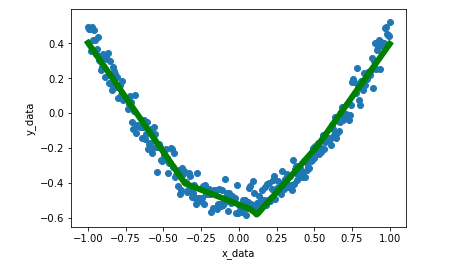

最后我们来看一下拟合的效果

fig=plt.figure()

bx = fig.add_subplot(1,1,1)

bx.scatter(x_data,y_data)

bx.plot(x_data,prediction_value,'g-',lw=6)

plt.xlabel('x_data')

plt.ylabel('y_data')

plt.show()

可见拟合的不错

结尾

下一个笔记将讲讲tensorboard的一些用法,敬请期待!

百度云链接: https://pan.baidu.com/s/1skAfUGH 密码: qw1g

tensorflow笔记(二)之构造一个简单的神经网络的更多相关文章

- twisted 学习笔记二:创建一个简单TCP客户端

#coding=utf-8 from twisted.internet import reactor,protocol class QuickClient(protocol.Protocol): de ...

- 20135202闫佳歆--week3 构造一个简单的Linux系统MenuOs--学习笔记

此为个人学习笔记存档 week 3 构造一个简单的Linux系统MenuOs 复习: 计算机有三个法宝:存储程序计算机,函数调用堆栈,中断 操作系统有两把剑: 1.中断上下文的切换,保存现场和恢复现场 ...

- 《Linux内核分析》第三周笔记 构造一个简单的Linux系统MenuOS

构造一个简单的Linux系统MenuOS 一.linux内核源代码简介 三大法宝(存储程序计算机.函数调用堆栈.中断)和两把宝剑(中断上下文的切换:保存现场和恢复现场.进程上下文的切换) 1.在lin ...

- Linux内核分析 笔记三 构造一个简单的Linux系统MenuOS ——by王玥

一.知识点总结 (一)Linux源代码简介 arch/x86目录下的代码是我们重点关注的 内核启动相关代码都在init目录下 start_kernel函数相当于普通C程序的main函数 linux的核 ...

- Linux内核分析第三周学习总结:构造一个简单的Linux系统MenuOS

韩玉琪 + 原创作品转载请注明出处 + <Linux内核分析>MOOC课程http://mooc.study.163.com/course/USTC-1000029000 一.Linux内 ...

- 《Linux内核分析》第三周学习小结 构造一个简单的Linux系统OS

郝智宇 无转载 <Linux内核分析>MOOC课程http://mooc.study.163.com/course/USTC-1000029000 第三周 构造一个简单的Linux系统Me ...

- 第三周:构造一个简单的LINUX系统MENUOS

吕松鸿 + 原创作品转载请注明出处 + <Linux内核分析>MOOC课程http://mooc.study.163.com/course/USTC-1000029000 一.Linux内 ...

- Linux内核分析——构造一个简单的Linux系统MenuOS

马悦+原创作品转载请注明出处+<Linux内核分析>MOOC课程http://mooc.study.163.com/course/USTC-1000029000 一.Linux内核源代码简 ...

- 《Linux内核分析》 第三周 构造一个简单的Linux系统MenuOS

Linux内核分析 第三周 构造一个简单的Linux系统MenuOS 张嘉琪 原创作品转载请注明出处 <Linux内核分析>MOOC课程http://mooc.study.163.com/ ...

随机推荐

- IIS 反向代理 golang web开发

一. beego 开发编译 bee run 后会编译成 exe文件 编译生成后发布文件结构为 cmd 运行 cd D:/run beegoDemo.exe run 默认配置端口 不能为 80 跟iis ...

- 入职15天,Angular2 小记!

ng 配置@ngModule({ imports: [ BrowserModule ], //导入模块 declarations: [ AppComponent ], //导入组件 providers ...

- kali ssh服务连接问题,无法远程管理

1.修改sshd_config文件,命令为:vi /etc/ssh/sshd_config 2.将#PasswordAuthentication no的注释去掉,并且将NO修改为YES 3.将#Per ...

- Out of mind - 魔术纸

魔术纸 显示屏与纸张的完美结合.类似电子墨水.柔性显示器.魔术纸柔软似真正的纸张.用魔术纸做成的电子书,控制器在书轴处. 每一页能显示不同的东西.一本书可以完全按页显示在电子书上.可以换一本书来显示. ...

- linux 的一些脑洞操作

把当前文件夹的文件名用","连接成一行,或者将多行转变为一行 ls | paste -s -d "," # -s 选项将输入进行一次性粘贴 ls | xargs ...

- 【NOIP2016】Day1 T3 换教室(期望DP)

题目背景 NOIP2016 提高组 Day1 T3 题目描述 对于刚上大学的牛牛来说,他面临的第一个问题是如何根据实际情况申请合适的课程. 在可以选择的课程中,有 2n 节课程安排在 n 个时间段上. ...

- 【JAVASCRIPT】event对象

一.preventDefault 与 stopPropagation event.preventDefault() 和 event.stopPropagation() 不是JQuery的方法,是JS ...

- Unity Shader入门教程(四)反射光斑的实现

本节内容介绍PhongModel(也就是上文说的反射光的计算模型),采用的计算方法是BlinPhong(也即是用视线方向V+光源方向L的和,与N做点积,随后幂化得到高光反射系数)下图采用了csdn博文 ...

- Storm源码阅读之SpoutOutputCollector

不得不说storm是一个特别棒的实时计算框架.为了对后文理解的方便,先说几个storm中的术语: Topology:拓扑图或者拓扑结构.在storm中它通过消息分组的分式连接Spout和Bolt节点定 ...

- C#导入导出Excele数据

注:对于实体类对象最好新建一个并且继承原有实体类,这样可以将类型进行修改: 方法一:此种方法是用EPPLUS中的FileInfo流进行读取的(是不是流我还真不太了解,若有懂得请留言,非常感谢了) us ...