机器学习pipeline总结

# -*- coding: utf-8 -*-

"""scikit-learn introduction

Automatically generated by Colaboratory.

Original file is located at

https://colab.research.google.com/drive/1quaJafg43SN7S6cNwKFr0_WYn2ELt4Ph

scikit-learn官方网站:https://scikit-learn.org/stable/

模块引入

"""

from sklearn import datasets

from sklearn.metrics import mean_squared_error, r2_score

import matplotlib.pyplot as plt

import numpy as np

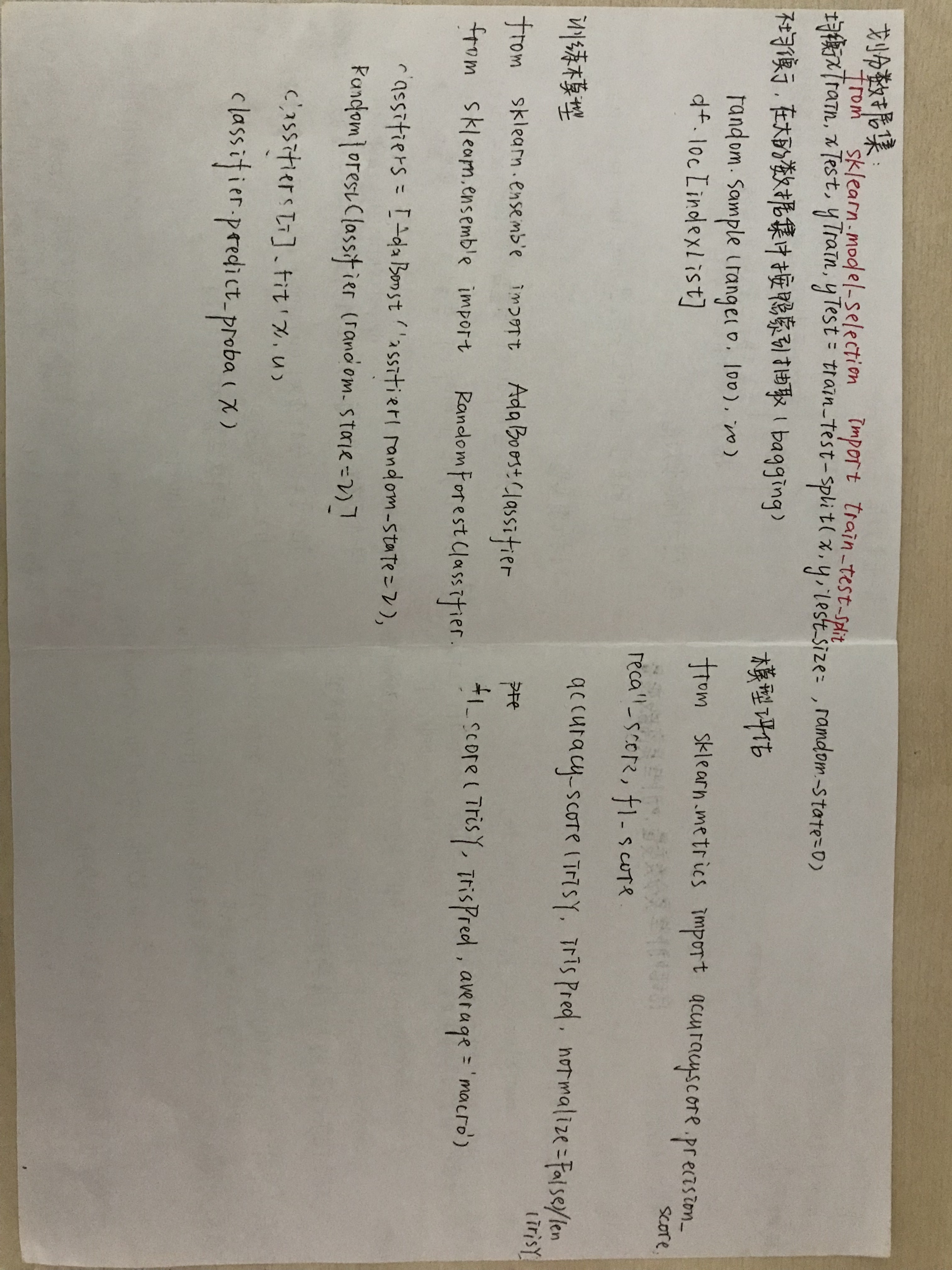

"""#分类:

- SVM(support vector machine):支持向量机

- svm.SVC()

###iris数据集

- iris feature: 花萼长度,花萼宽度,花瓣长度,花瓣宽度

- iris lable: 山鸢尾,杂色鸢尾,维吉尼亚鸢尾

"""

iris = datasets.load_iris()

print('iris feature\n', iris.data[0:5])

print('iris label\n', iris.target[0:5])

"""###创建模型"""

from sklearn import svm

clf = svm.SVC()

irisX = iris.data

irisY = iris.target

clf.fit(irisX, irisY)

irisPred = clf.predict(irisX)

clf.predict([[5.1,3.5,1.4,0.2]]) #刚刚的第1个数据

"""###评估指标

- accuracy

- precision

- recall

- F1

"""

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

print('acc is ', accuracy_score(irisY, irisPred, normalize=False)/len(irisY))

print('precision is ', precision_score(irisY, irisPred, average='macro'))

print('recall is ', recall_score(irisY, irisPred, average='macro'))

print('F1 is ', f1_score(irisY, irisPred, average='macro'))

"""#回归

- 线性回归

- 模块:linear_model.LinearRegression()

###糖尿病数据集

"""

diabetes = datasets.load_diabetes()

diabetesX = np.array([[diabetes.data[i][0]] for i in range(0,diabetes.data.shape[0])])

diabetesY = diabetes.target

print('feature\n',diabetesX[:5])

print('label\n',diabetesY[:5])

"""###创建模型"""

from sklearn import svm, linear_model

regr = linear_model.LinearRegression()

regr.fit(diabetesX, diabetes.target)

diabetesPred = regr.predict(diabetesX)

regr.predict([[0.03807591]]) #对于原始数据的第一个值的预测结果

plt.scatter(diabetesX, diabetes.target) #原始数据的散点图

plt.plot(diabetesX, diabetesPred) #线性回归的折线图

"""###评价指标

- 均方误差(mse)

"""

from sklearn.metrics import mean_squared_error

print('mean squared error is ', mean_squared_error(diabetesY, diabetesPred))

"""#聚类

- k-means

###创建数据集

"""

from sklearn.datasets.samples_generator import make_blobs

clusterX, clusterY = make_blobs(n_samples=1000, n_features=2, centers=[[-1,-1], [0,0], [1,1], [2,2]], cluster_std=[0.4, 0.2, 0.2, 0.2], random_state=0)

plt.scatter(clusterX[:, 0], clusterX[:, 1])

"""###建立模型"""

from sklearn.cluster import KMeans

clu = KMeans(n_clusters=2, random_state=9)

clusterPredict = clu.fit_predict(clusterX)

plt.scatter(clusterX[:, 0], clusterX[:, 1], c=clusterPredict)

plt.show()

"""#模型评估

- cross validation 交叉验证

- 以iris数据集为例

"""

from sklearn.model_selection import train_test_split,cross_val_score

from sklearn.metrics import accuracy_score

from sklearn import svm

import warnings

warnings.filterwarnings('ignore')

clf = svm.SVC()

scores = cross_val_score(clf, irisX, irisY, cv=10, scoring='accuracy')

print('十折交叉验证分别的accuracy ', scores)

print('平均的accuracy ', sum(scores/10))

"""- 通过设置随机种子来进行十次十折交叉验证"""

from sklearn.model_selection import StratifiedKFold,KFold

accEachTime = []

for i in range(0,10):

clf = svm.SVC()

scores = cross_val_score(clf, irisX, irisY, cv=KFold(n_splits=10, random_state=i, shuffle=True), scoring='accuracy')

print(scores)

accEachTime.append(sum(scores/10))

print('每一次的accuracy值 ', accEachTime)

print('十次十折交叉验证的平均accuracy值 ', sum(accEachTime)/10)

机器学习pipeline总结的更多相关文章

- Spark Pipeline官方文档

ML Pipelines(译文) 官方文档链接:https://spark.apache.org/docs/latest/ml-pipeline.html 概述 在这一部分,我们将要介绍ML Pipe ...

- FPGA的过去,现在和未来

我们知道,相对于专业的ASIC,FPGA有上市时间和成本上的优势.另外,在大多数情况下,FPGA执行某些功能较之CPU上的软件操作更高效.这就是为什么我们认为它不但会运用在数据中心的服务器.交换器.存 ...

- 2015 Spark 将走向哪里?

在刚刚过去的spark submit上,Matei Zahara简单回顾了下2014年spark的发展,可用一个词来概括那就是"Amazing"!!! 那么2015年,spark ...

- gen语言

概率编程语言(PPL)领域正经历着机器学习技术快速发展带来的奇迹般的复兴.在短短的几年里,PPL 已经从一个模糊的统计研究领域发展出十几个活跃的开源方案.最近,麻省理工学院(MIT)的研究人员推出了一 ...

- SparkMLLib的简单学习

一. 简介 1. 机器学习中,可以将数据划分为连续数据和离散数据 a. 连续数据:可以取任何值,如房价 b. 离散数据:仅有少量特殊值,如一个房屋有2个或3个房间,但不能为2.75个房间 二. 创建向 ...

- 使用PyTorch进行迁移学习

概述 迁移学习可以改变你建立机器学习和深度学习模型的方式 了解如何使用PyTorch进行迁移学习,以及如何将其与使用预训练的模型联系起来 我们将使用真实世界的数据集,并比较使用卷积神经网络(CNNs) ...

- 使用spark ml pipeline进行机器学习

一.关于spark ml pipeline与机器学习 一个典型的机器学习构建包含若干个过程 1.源数据ETL 2.数据预处理 3.特征选取 4.模型训练与验证 以上四个步骤可以抽象为一个包括多个步骤的 ...

- Spark2.0机器学习系列之2:基于Pipeline、交叉验证、ParamMap的模型选择和超参数调优

Spark中的CrossValidation Spark中采用是k折交叉验证 (k-fold cross validation).举个例子,例如10折交叉验证(10-fold cross valida ...

- spark ml pipeline构建机器学习任务

一.关于spark ml pipeline与机器学习一个典型的机器学习构建包含若干个过程 1.源数据ETL 2.数据预处理 3.特征选取 4.模型训练与验证 以上四个步骤可以抽象为一个包括多个步骤的流 ...

随机推荐

- PythonI/O进阶学习笔记_8.python的可迭代对象和迭代器、迭代设计模式

content: 1.什么是迭代协议 2. 什么是迭代器(Iterator)和可迭代对象(Iterable) 3. 使用迭代器和可迭代对象 4. 创建迭代器和可迭代对象 5. 迭代器设计模式 一 ...

- C# get md5,renamed file and can not change file's md5

using System; using System.Text; using System.IO; using System.Security.Cryptography; namespace Cons ...

- SpringBoot整合dubbo(yml格式配置)

yml文件 如果只作为服务的消费者不用暴露端口号,扫描的包名根据自己service改 dubbo: application: name: springboot-dubbo-demo #应用名 regi ...

- Appium(七):Appium API(一) 应用操作

1. 应用操作 本章所罗列的方法主要针对应用的操作,如应用的安装.卸载.关闭.启动等. 把前面的启动代码放在这里,后面只展示不同的部分. # coding:utf-8 from appium impo ...

- 使用PXE+DHCP+TFTP+kickstart搭建无人执守系统安装服务器

原理和概念: 1. 什么是PXE 严格来说,PXE 并不是一种安装方式,而是一种引导的方式.进行 PXE 安装的必要条件是要安装的计算机中包含一个 PXE 支持的网卡(NIC),即网卡中必须要有 ...

- java开发,入职半年。对未来迷茫,如何发展

蛮多人私密我一些问题,关于面试,关于技术的,我只能说有些路只能靠自己去走,没人可以帮到自己,哪怕偶尔帮一到两次,但是技术的路这么长,总归需要自己独自成长的.附一张自己藏书的照片,与各位共勉 工作三年多 ...

- IT兄弟连 HTML5教程 CSS3属性特效 2D变换1

通过CSS3转换,能够对元素进行移动.缩放.转动.拉长或拉伸.它如何工作?转换是使元素改变形状.尺寸和位置的一种效果.CSS3转换包括2D转换和3D转换,本小结我们来了解2D变换的转换方法. 转换属性 ...

- Java开发之使用websocket实现web客户端与服务器之间的实时通讯

使用websocket实现web客户端与服务器之间的实时通讯.以下是个简单的demo. 前端页面 <%@ page language="java" contentType=& ...

- Spring注解之@Component详细解析

@controller 控制器(注入服务) 2.@service 服务(注入dao) 3.@repository dao(实现dao访问) 4.@component (把普通pojo实例化到sprin ...

- golang 自动下载所有依赖包

go get -d -v ./... -d标志只下载代码包,不执行安装命令: -v打印详细日志和调试日志.这里加上这个标志会把每个下载的包都打印出来: ./...这个表示路径,代表当前目录下所有的文件 ...