用java代码调用shell脚本执行sqoop将hive表中数据导出到mysql

1:创建shell脚本

touch sqoop_options.sh

chmod 777 sqoop_options.sh

编辑文件 特地将执行map的个数设置为变量 测试 可以java代码传参数 同时也验证sqoop的 options 属性支持这种写法

#!/bin/bash

/opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/bin/sqoop --options-file /opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/sqoop-import-mysql.txt --num-mappers $1

if [ $? -eq 0 ];then

echo "success"

else

echo "error"

fi

2:创建 sqoop-import-mysql.txt 文件并编辑

touch sqoop-import-mysql.txt

export

--connect

jdbc:mysql://172.16.71.27:3306/babasport

--username

root

--password

root

--table

test_hive

--export-dir

/user/hive/warehouse/hive_bbs_product_snappy

--input-fields-terminated-by

'\t'

hive数据存在hdfs位置

3:开始写java后台代码 目前只支持 window写法 后期加上linux调用shell脚本的写法

package com.liveyc.common.utils; import java.util.Properties; import org.apache.commons.logging.Log;

import org.apache.commons.logging.LogFactory; public class FileToHbase {

/**

* shell脚本执行成功标识

*/

public static int SHELL_EXIT_OK = 0;

public static Log log = LogFactory.getLog(FileToHbase.class);

public static String connIp = "172.16.71.120";

public static String connUser = "root";

public static String connPwd = "123456"; public static void main(String[] args) throws Exception {

boolean result = export();

System.out.println(result);

} public static boolean export() throws Exception {

boolean result = false;

// 如果当前系统是window系统需要远程ssh连接系统

if (isWinSystem()) {

ConnectShell connectShell = new ConnectShell(connIp, connUser, connPwd, "utf-8");

String url = "/opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/sqoop_options.sh" + " " +1;

result = connectShell.excuteShellCommand(url);

}

return result;

} /**

* 当前操作系统类型

*

* @return true 为windos系统,false为linux系统

*/

public static boolean isWinSystem() {

// 获取当前操作系统类型

Properties prop = System.getProperties();

String os = prop.getProperty("os.name");

if (os.startsWith("win") || os.startsWith("Win")) {

return true;

} else {

return false;

}

}

}

package com.liveyc.common.utils; import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.UnsupportedEncodingException;

import java.nio.charset.Charset; import org.apache.commons.logging.Log;

import org.apache.commons.logging.LogFactory; import ch.ethz.ssh2.ChannelCondition;

import ch.ethz.ssh2.Connection;

import ch.ethz.ssh2.Session;

import ch.ethz.ssh2.StreamGobbler; /**

*

* ConnectShell

*

* @Description:连接Shell脚本所在服务器

* @author:aitf

* @date: 2016年3月31日

*

*/

public class ConnectShell {

private Connection conn;

private String ipAddr;

private String userName;

private String password;

private String charset = Charset.defaultCharset().toString();

private static final int TIME_OUT = 1000 * 5 * 60;

public static Log log = LogFactory.getLog(ConnectShell.class); public ConnectShell(String ipAddr, String userName, String password, String charset) {

this.ipAddr = ipAddr;

this.userName = userName;

this.password = password;

if (charset != null) {

this.charset = charset;

}

} public boolean login() throws IOException {

conn = new Connection(ipAddr);

conn.connect();

return conn.authenticateWithPassword(userName, password); // 认证

} /**

*

* @Title: excuteShellCommand

* @Description: 执行shell脚本命令

* @param shellpath

* @return

*/

public boolean excuteShellCommand(String shellpath) {

InputStream in = null;

boolean result = false;

String str = "";

try {

if (this.login()) {

Session session = conn.openSession();

//session.execCommand("cd /root");

session.execCommand(shellpath);

in = new StreamGobbler(session.getStdout());

// in = session.getStdout();

str = this.processStdout(in, charset);

session.waitForCondition(ChannelCondition.EXIT_STATUS, TIME_OUT);

session.close();

conn.close();

if (str.contains("success")) {

result = true;

}else{

result = false;

}

}

} catch (IOException e1) {

e1.printStackTrace();

}

return result;

} public String excuteShellCommand2(String shellpath) throws Exception {

InputStream in = null;

String result = "";

try {

if (this.login()) {

Process exec = Runtime.getRuntime().exec(shellpath);// ipconfig

in = exec.getInputStream();

result = this.processStdout(in, this.charset);

}

} catch (IOException e1) {

e1.printStackTrace();

}

return result;

} /**

* 转化结果

*

* @param in

* @param charset

* @return

* @throws UnsupportedEncodingException

*/

public String processStdout(InputStream in, String charset) throws UnsupportedEncodingException {

String line = null;

BufferedReader brs = new BufferedReader(new InputStreamReader(in, charset));

StringBuffer sb = new StringBuffer();

try {

while ((line = brs.readLine()) != null) {

sb.append(line + "\n");

}

} catch (IOException e) {

log.error("---转化出现异常---");

}

return sb.toString();

} }

4:开始测试

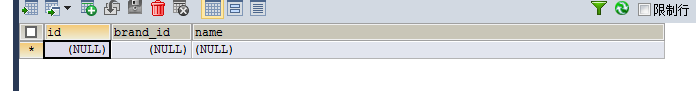

在mysql创建一个表 hive中数据格式 是 int int String

CREATE TABLE test_hive(

id INT,

brand_id INT,

NAME VARCHAR(200)

)

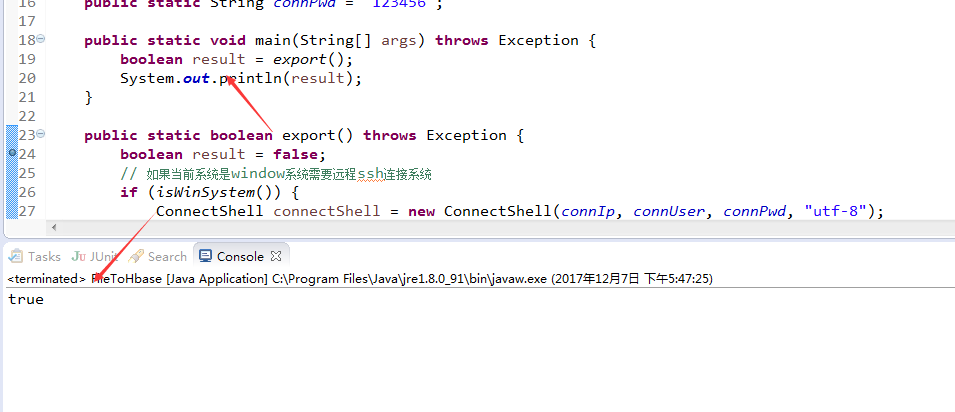

执行java main方法 开始测试

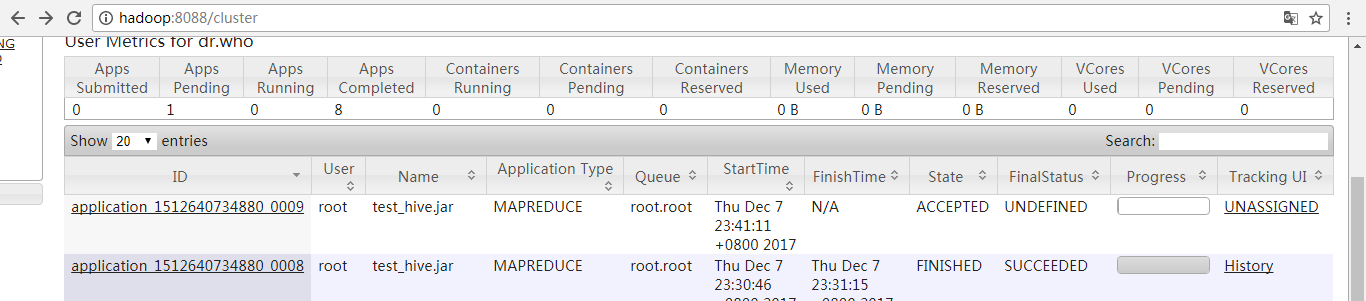

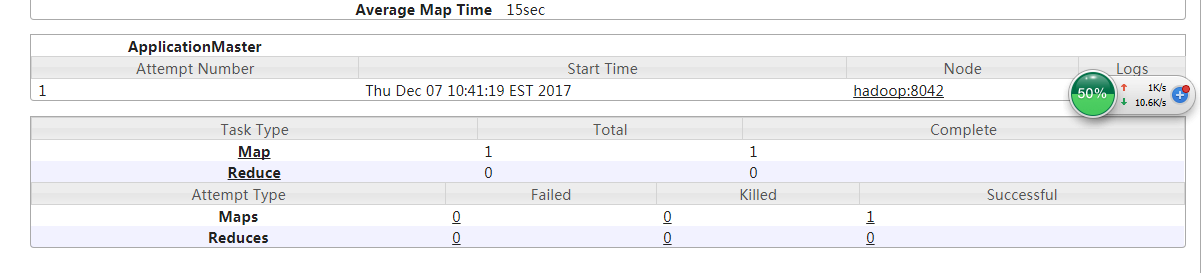

观看8088端口 查看MapReduce的运行状况 发现正在运行(开心)

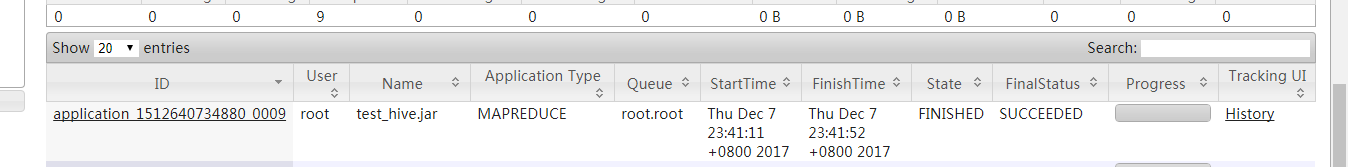

执行完毕

可以看到 只有1个 MapReduce任务 (默认的个数是4个 这样看来第一步写的shell脚本 参数是传递过来了 sqoop的 options 也支持这种直接指定参数的写法)

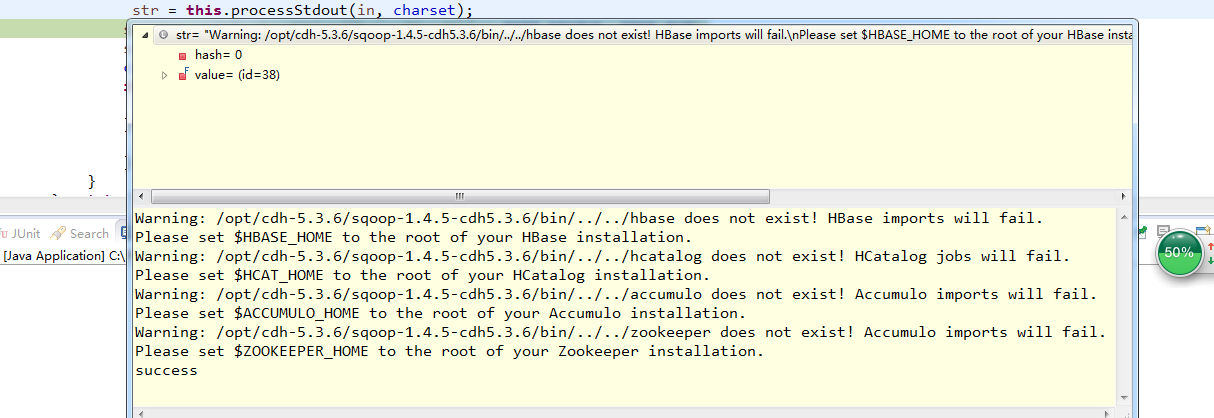

现在转过来看java代码

返回值 :

Warning: /opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/bin/../../hbase does not exist! HBase imports will fail.

Please set $HBASE_HOME to the root of your HBase installation.

Warning: /opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/bin/../../hcatalog does not exist! HCatalog jobs will fail.

Please set $HCAT_HOME to the root of your HCatalog installation.

Warning: /opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/bin/../../accumulo does not exist! Accumulo imports will fail.

Please set $ACCUMULO_HOME to the root of your Accumulo installation.

Warning: /opt/cdh-5.3.6/sqoop-1.4.5-cdh5.3.6/bin/../../zookeeper does not exist! Accumulo imports will fail.

Please set $ZOOKEEPER_HOME to the root of your Zookeeper installation.

success

发现返回 success 说明shell脚本执行成功了

一切执行正常 看下mysql 数据库表中有没有数据

OK 一切正常 , 后期把linux执行shell脚本的语句也补充上 。

用java代码调用shell脚本执行sqoop将hive表中数据导出到mysql的更多相关文章

- Java代码调用Shell脚本并传入参数实现DB2数据库表导出到文件

本文通过Java代码调用Shell脚本并传入参数实现DB2数据库表导出到文件,代码如下: import java.io.File; import java.io.IOException; import ...

- (MySQL里的数据)通过Sqoop Import Hive 里 和 通过Sqoop Export Hive 里的数据到(MySQL)

Sqoop 可以与Hive系统结合,实现数据的导入和导出,用户需要在 sqoop-env.sh 中添加HIVE_HOME的环境变量. 具体,见我的如下博客: hadoop2.6.0(单节点)下Sqoo ...

- Java如何调用shell脚本的

有些时候会碰到这样的场景:java的功能里面要嵌入一个功能点,这个功能是通过是shell脚本实现的.这种时候就需要Java对脚本调用的支持了. 测试环境 Ubuntu16.04 i3-6100,12G ...

- 通过ant调用shell脚本执行adb命令

在Hudson或者Jenkins中利用ant的exec 来调用shell命令,通过shell脚本来执行adb shell命令,可以正常执行,不会出现在ant中直接调用adb shell出现的假死情况. ...

- 利用jmeter发起java请求调用shell脚本

1.创建maven项目 在pom文件中加入依赖: 2.在路径src/main/java下创建类,如类名shellclass 3. 创建jmet ...

- java调用shell脚本执行操作

//定时清空 日志 String shellString = "sh /home/jyapp/delete_log.sh"; Process process = Runtime.g ...

- Java 调用 shell 脚本详解

这一年的项目中,有大量的场景需要Java 进程调用 Linux的bash shell 脚本实现相关功能. 从之前的项目中拷贝的相关模块和网上的例子来看,有个别的“陷阱”造成调用shell 脚本在某些特 ...

- python调用shell脚本时需要切换目录

最近遇到了一个问题,就是python代码调用shell脚本时,发现输入输出的文件,总是和自己预想的有偏差,但是单独在linux下执行命令的时候,却没有错误.后来发现是相对路径的问题,因为执行pytho ...

- Java代码调用服务器上的Shell脚本

Java代码调用服务器上的Shell脚本 这里主要是因为我们报表平台有用到用户手工录入的数据作为结果数据且需要纳入saiku去展示 如我们所知,saiku不会自动刷新,所以需要在数据更新接口中调用服务 ...

随机推荐

- Windows连接Linux服务器中MySQL数据库-权限配置

问题描述 在Windows系统中安装了监控MySQL数据库服务器性能的工具Spotlight on MySQL,利用Spotlight连接Linux服务器中的MySQL,进行相关配置如下: 点击& ...

- jquery中on绑定click事件在苹果手机失效问题解决(巨坑啊)

描述:用一个div写一个按钮,并给这个按钮添加一个点击事件,在安卓机器上一切正常,但是在苹果机型上会出现点击事件失效. <!DOCTYPE html> <html lang=&quo ...

- py27使用redis

1.安装redis pip install redis 转载请注明博客出处:http://www.cnblogs.com/cjh-notes/

- Ubuntu系统下adb devices 不能显示手机设备

1. 查看usb设备,命令:lsusb 结果如下:Bus 001 Device 002: ID 8087:0024 Intel Corp. Integrated Rate Matching Hub B ...

- java map的 keyset()方法

- 【HLSDK系列】怎么增加一种新实体

你平常肯定接触到很多比如 info_player_start hostage info_target 之类的实体,这里就解释一下怎么创建一种新的实体. 首先建立一个新的 .h 文件(当然你写在现有的文 ...

- 个人博客开发-01-nodeJs项目搭建

// window系统下 1.nodeJs 安装 nodeJs 安装 看 这里 , 先下载再下一步下一步就OK了,我的是在C盘里安装的. 安装完以后 按 win + R ,在弹出的小框框里输入 CM ...

- C++解析(13):临时对象与const对象

0.目录 1.临时对象 2.const对象 3.类成员 4.小结 1.临时对象 一个有趣的问题--下面的程序输出什么?为什么? #include <stdio.h> class Test ...

- 洛谷 P3723 [AH2017/HNOI2017]礼物 解题报告

P3723 [AH2017/HNOI2017]礼物 题目描述 我的室友最近喜欢上了一个可爱的小女生.马上就要到她的生日了,他决定买一对情侣手环,一个留给自己,一个送给她.每个手环上各有 \(n\) 个 ...

- innodb--表空间

MySQL把数据库中表结构的定义信息保存到数据库目录的.frm文件中. 在InnoDB中数据库中存储的数据及索引实际是存放在表空间里的(tablespace). 可以将每个基于InnoDB存储引擎的表 ...