pandas:如何保存数据比较好?

我们在使用pandas处理完数据之后,最终总是要把数据作为一个文件保存下来,

那么,保存数据最常用的文件是什么呢?

我想大部分人一定会选择csv或者excel。

刚接触数据分析时,我也是这么选择的,不过,今天将介绍几种不一样的存储数据的文件格式。

这些文件格式各有自己的一些优点,希望本文能让你以后的数据存储方式能有不一样的选择,从而存储的更加专业。

1. 准备数据

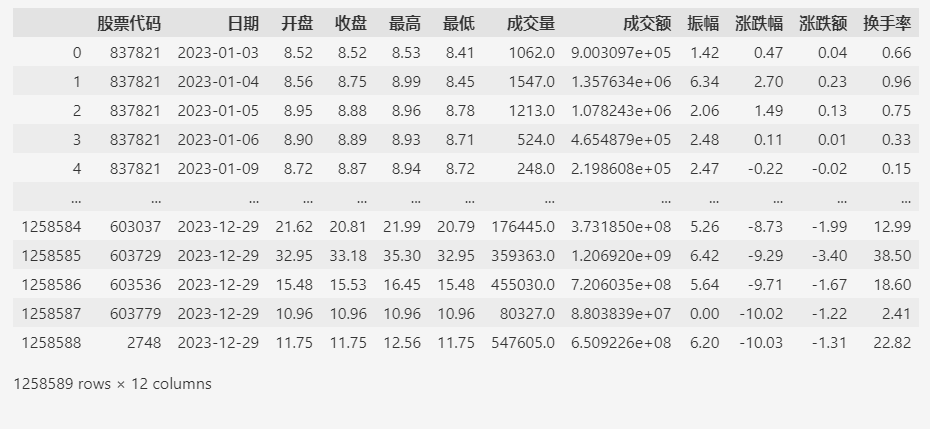

本次使用的数据来自A股2023年全年的日交易数据。

数据下载地址:https://databook.top/。

导入数据:

import pandas as pd

fp = "d:/share/历史行情数据-不复权-2023.csv"

df = pd.read_csv(fp)

df

总共大约120多万条数据。

准备好测试数据之后,开始测试各种文件的效果。

2. CSV

使用pandas做数据分析时,保存数据最常用的格式一定是CSV(或者excel)。

因为CSV格式易于分享,用excel或者文本编辑器都能直接打开。

但是当数据集规模比较大时,它的磁盘利用率和读写效率究竟如何呢?

首先我们把准备的数据保存为一个测试用的test.csv文件。

df = pd.read_csv(fp)

df.to_csv("d:/share/test.csv", index=None)

看看文件大小:

ls .\test.csv

目录: D:\share

Mode LastWriteTime Length Name

---- ------------- ------ ----

-a---- 2024/03/15 10:41:27 101411037 test.csv

test.csv文件大约:\(101411037/1024/1024 \approx 96.7MB\)

读取效率:

%%timeit

df = pd.read_csv("d:/share/test.csv")

1.73 s ± 54.7 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

写入的效率:

%%timeit

df.to_csv("d:/share/test.csv", index=None)

13.2 s ± 402 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

3. Pickle

Pickle格式是一种用于序列化和反序列化Python对象结构的二进制格式。

它的主要特点是能够将程序中运行的对象信息保存到文件中。

下面,我们先把准备的数据保存为一个测试用的test.pkl文件。

# pickle file

df = pd.read_csv(fp)

df.to_pickle("d:/share/test.pkl")

文件大小:

ls .\test.pkl

目录: D:\share

Mode LastWriteTime Length Name

---- ------------- ------ ----

-a---- 2024/03/15 10:49:09 116904470 test.pkl

test.pkl文件大约:\(116904470/1024/1024 \approx 111.5MB\)

读取效率:

%%timeit

df = pd.read_pickle("d:/share/test.pkl")

136 ms ± 5.09 ms per loop (mean ± std. dev. of 7 runs, 10 loops each)

写入效率:

%%timeit

df.to_pickle("d:/share/test.pkl")

182 ms ± 7.42 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

4. Parquet

Parquet格式是一种列式存储格式,被广泛应用于大数据处理领域。

它采用了压缩和编码技术,能够有效地存储和压缩数据,同时保持数据的结构和模式。

下面,我们先把准备的数据保存为一个测试用的test.parquet文件。

# parquet file

df = pd.read_csv(fp)

df.to_parquet("d:/share/test.parquet")

文件大小:

ls .\test.parquet

目录: D:\share

Mode LastWriteTime Length Name

---- ------------- ------ ----

-a---- 2024/03/15 10:52:08 32964728 test.parquet

test.parquet文件大约:\(32964728/1024/1024 \approx 31.4MB\)

读取效率:

%%timeit

df = pd.read_parquet("d:/share/test.parquet")

200 ms ± 8.54 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

写入效率:

%%timeit

df.to_parquet("d:/share/test.parquet")

1.23 s ± 62.4 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

5. Feather

Feather格式是一种高速、轻量且易于使用的二进制文件格式,专门用于存储数据帧。

Feather的主要目标是提供高性能的读写操作。

下面,我们先把准备的数据保存为一个测试用的test.feather文件。

# feather file

df = pd.read_csv(fp)

df.to_feather("d:/share/test.feather")

文件大小:

ls .\test.feather

目录: D:\share

Mode LastWriteTime Length Name

---- ------------- ------ ----

-a---- 2024/03/15 11:17:15 57347098 test.feather

test.feather文件大约:\(57347098/1024/1024 \approx 54.7MB\)

读取效率:

%%timeit

df = pd.read_feather("d:/share/test.feather")

130 ms ± 5.29 ms per loop (mean ± std. dev. of 7 runs, 10 loops each)

写入效率:

%%timeit

df.to_feather("d:/share/test.feather")

277 ms ± 14.8 ms per loop (mean ± std. dev. of 7 runs, 1 loop each)

6. 总结

pandas能够保存的文件格式有很多,比如还有XML,JSON,HTML等等,

上面列出的4种是我认为比较典型,且在数据分析领域用的比较多的格式。

4种格式的比较总结如下:

| 磁盘占用 | 读取效率 | 写入效率 | |

|---|---|---|---|

| csv | 96.7 MB | 1.73 s ± 54.7 ms | 13.2 s ± 402 ms |

| pickle | 111.5 MB | 136 ms ± 5.09 ms | 182 ms ± 7.42 ms |

| parquet | 31.4 MB | 200 ms ± 8.54 ms | 1.23 s ± 62.4 ms |

| feather | 54.7 MB | 130 ms ± 5.29 ms | 277 ms ± 14.8 ms |

综合来看,当我们的数据量不大的时候,用CSV格式比较好,分享方便,可以用多种编辑器直接打开查看。

当数据规模变大了之后,如果数据需要长期存储,而且不需要经常的更新写入,那么用parquet格式(它的磁盘占用最低,读取性能好,写入性能略逊);

如果只要短期存储的话,用fetdher格式更好(磁盘占用不算高,读写性能都不错)。

至于pickle格式,它的读写性能也不错,但它的最大优势是可以保存python对象的状态,只用来保存数据的话,这个优势难以体现。

而且它的磁盘占用比较大,单纯保存数据的话,不建议使用这种格式。

pandas:如何保存数据比较好?的更多相关文章

- pandas读取保存数据

将本人使用过的一些操作记录下来 1.读取数据,使用:data = pd.read_csv('./data/file.csv') 2.数据处理,如果你要修改某一个数据,其实把DATAFRAME数据看做是 ...

- pandas+sqlalchemy 保存数据到mysql

import pandas as pd from sqlalchemy import create_engine data3={"lsit1":[1,2],"lsit2& ...

- pandas学习(常用数学统计方法总结、读取或保存数据、缺省值和异常值处理)

pandas学习(常用数学统计方法总结.读取或保存数据.缺省值和异常值处理) 目录 常用数学统计方法总结 读取或保存数据 缺省值和异常值处理 常用数学统计方法总结 count 计算非NA值的数量 de ...

- [数据清洗]-使用 Pandas 清洗“脏”数据

概要 准备工作 检查数据 处理缺失数据 添加默认值 删除不完整的行 删除不完整的列 规范化数据类型 必要的转换 重命名列名 保存结果 更多资源 Pandas 是 Python 中很流行的类库,使用它可 ...

- [数据清洗]-Pandas 清洗“脏”数据(一)

概要 准备工作 检查数据 处理缺失数据 添加默认值 删除不完整的行 删除不完整的列 规范化数据类型 必要的转换 重命名列名 保存结果 更多资源 Pandas 是 Python 中很流行的类库,使用它可 ...

- Python 保存数据的方法(4种方法)

Python 保存数据的方法: open函数保存 使用with open()新建对象 写入数据(这里使用的是爬取豆瓣读书中一本书的豆瓣短评作为例子) import requests from lxml ...

- Pandas透视表处理数据(转)

手把手教你用Pandas透视表处理数据(附学习资料) 2018-01-06 数据派THU 来源:伯乐在线 - PyPer 本文共2203字,建议阅读5分钟.本文重点解释pandas中的函数pivot ...

- Python 保存数据的方法:

open函数保存 使用with open()新建对象 写入数据(这里使用的是爬取豆瓣读书中一本书的豆瓣短评作为例子) 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 ...

- [开发技巧]·pandas如何保存numpy元素

[开发技巧]·pandas如何保存numpy元素 1.问题描述 在开发的过程中遇到一个问题,就是需要把numpy作为pandas的一个元素进行保存,注意不是作为一列元素.但是实践的过程中却不顺利, ...

- EasyUI使用JSON保存数据

目前来说,使用JSON保存数据比较方便,前台可以不用Test.aspx 页面,可以直接用Html页面,使用.aspx页面的弊端就不在这里熬述. 具体步骤如下: 1.新建一个Html页面,命名为Test ...

随机推荐

- 2022年“腾讯杯”大学生程序设计竞赛 死去的 Elo 突然开始攻击我 题解

题目链接:死去的 Elo 突然开始攻击我 容易知道,如果暴力对某个区间而言进行查询,我们可以考虑使用并查集,开一个桶,每次添加一个数 \(val\),那么如果已经存在了 \(val-1\) 或者 \( ...

- (python)每日代码||2024.1.27||类方法与实例方法

class test(): aaa = 111 bbb = 222 ccc = 333 @classmethod def cm(cls): cls.aaa="***" def im ...

- 零基础入门Vue之窥探大法——计算与侦听

前言 在 上一小节 我介绍了我学习vue入门 插值语法 的过程. 在本篇,我将记录我对vue的 计算属性和侦听器 的学习记录 注:本篇对于"侦听"和"监听"是一 ...

- 数学问题,2的n次方 - 1 是怎么来的? 通常用作计算数值

- OGG-Postgres实时同步到MySQL

(一)数据库信息 名称 源端数据库 目标端数据库 数据库类型 Postgresql 12.4 MySQL 5.7 IP地址 20.2.127.23 20.2.127.24 端口 5432 3306 数 ...

- Linux-解决jps查看正在运行的Java进程时显示:process information unavailable 问题

背景:jps全称为Java Virtual Machine Process Status Tool,是Java提供的一个查看当前用户有权访问的主机的Java进程情况的工具. 因为每一个Java程序都会 ...

- 【Unity3D】Renderer Feature简介

1 3D 项目迁移到 URP 项目后出现的问题 3D 项目迁移至 URP 项目后,会出现很多渲染问题,如:材质显示异常.GL 渲染不显示.多 Pass 渲染异常.屏幕后处理异常等问题.下面将针对这 ...

- CSS实现页脚始终在页面底部

说明 最近在布局自己的博客系统,我是想练练手把时下比较流行的前后端技术串起来.同时,我会把设计和编码过程中遇到的问题或值得分享的技术点.实现方式做下总结,记录下来.本篇就是第一篇,个人能力有限,不足之 ...

- ContentType组件表使用

https://www.shuzhiduo.com/A/qVdepN2r5P/

- JS内存爆破问题

原理 检测到调试,格式化等,疯狂的在js文件,或者html中进行读写,cookie重写追加,字节追加,导致内存不足够,卡死 内存爆破,指js通过死循环/频繁操作数据库(包括cookie)/频繁调取hi ...