javacv实现直播流

javacv实现直播流

javacv从入门到入土系列,音视频入门有一点门槛的延迟大概是2~4秒之间,

依赖

<!-- 需要注意,javacv主要是一组API为主,还需要加入对应的实现 -->

<dependency>

<groupId>org.bytedeco</groupId>

<artifactId>javacv</artifactId>

<version>1.5.6</version>

</dependency>

<!-- 用到了 ffmpeg 需要把 ffmpeg 的平台实现依赖引入 -->

<dependency>

<groupId>org.bytedeco</groupId>

<artifactId>ffmpeg-platform</artifactId>

<version>4.4-1.5.6</version>

</dependency>

<!--所有平台实现,依赖非常大,几百MB吧-->

<!--<dependency>

<groupId>org.bytedeco</groupId>

<artifactId>javacv-platform</artifactId>

<version>1.5.6</version>

</dependency>-->

视频采集可以使用摄像头或者什么的,我这里用了桌面录像

package top.lingkang.test.gui;

import javafx.application.Application;

import javafx.event.ActionEvent;

import javafx.event.EventHandler;

import javafx.scene.Scene;

import javafx.scene.control.Alert;

import javafx.scene.control.Button;

import javafx.scene.image.Image;

import javafx.scene.image.ImageView;

import javafx.scene.layout.VBox;

import javafx.stage.Stage;

import javafx.stage.WindowEvent;

import org.bytedeco.ffmpeg.global.avcodec;

import org.bytedeco.javacv.*;

import javax.sound.sampled.AudioFormat;

import javax.sound.sampled.AudioSystem;

import javax.sound.sampled.DataLine;

import javax.sound.sampled.TargetDataLine;

import java.io.File;

import java.nio.ByteBuffer;

import java.nio.ByteOrder;

import java.nio.ShortBuffer;

import java.util.Timer;

import java.util.TimerTask;

/**

* @author lingkang

* Created by 2022/5/10

*/

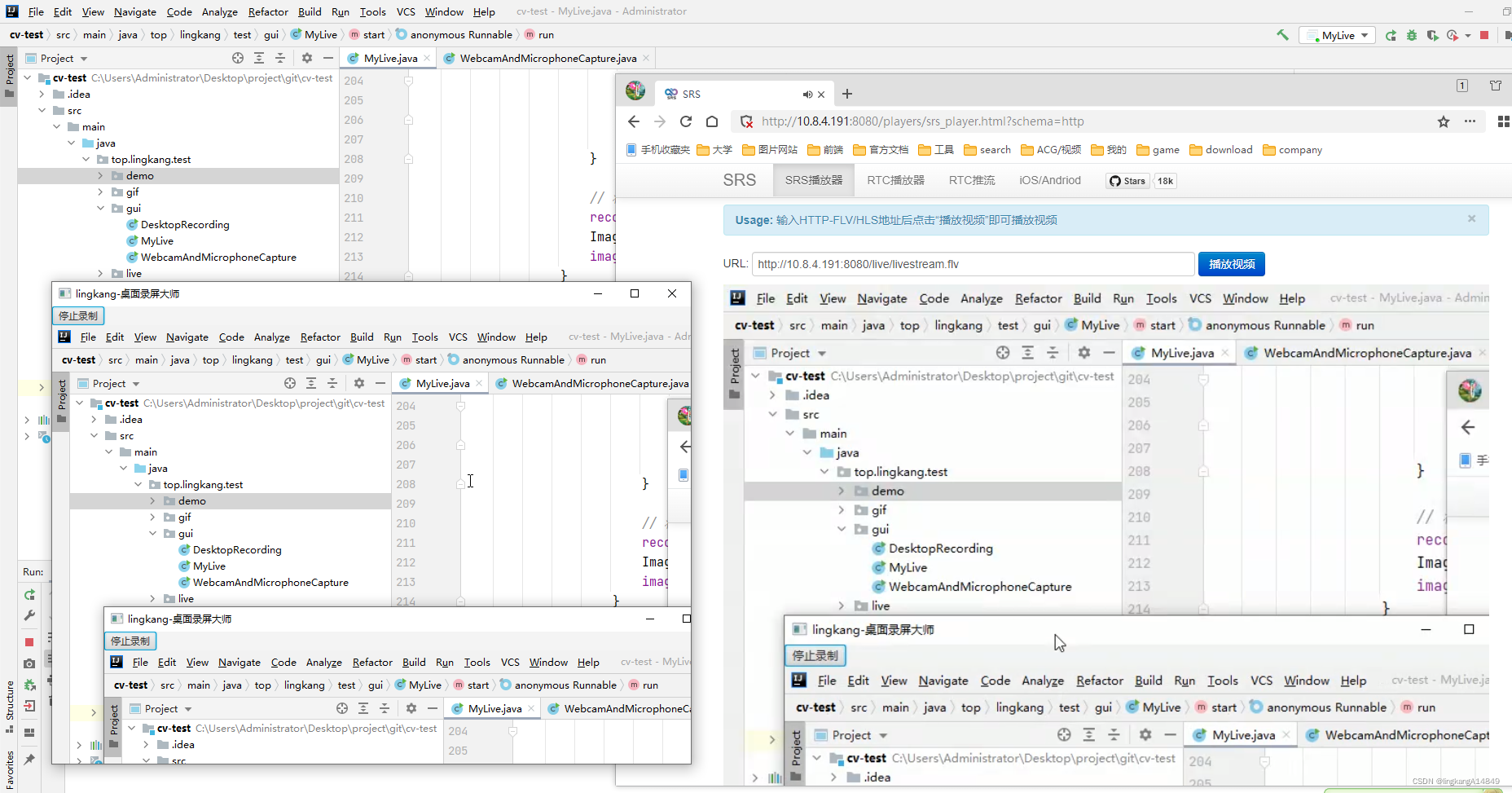

public class MyLive extends Application {

private static final int frameRate = 24;// 录制的帧率

private static boolean isStop = false;

private static TargetDataLine line;

@Override

public void start(Stage primaryStage) throws Exception {

primaryStage.setTitle("lingkang-桌面录屏大师");

ImageView imageVideo = new ImageView();// 用于软件录制显示

imageVideo.setFitWidth(800);

imageVideo.setFitHeight(600);

Button button = new Button("停止录制");

button.setOnAction(new EventHandler<ActionEvent>() {

@Override

public void handle(ActionEvent event) {

isStop = true;

if (line != null) {// 马上停止声音录入

try {

line.close();

} catch (Exception e) {

}

}

Alert alert = new Alert(Alert.AlertType.INFORMATION);

alert.setTitle("info");

alert.setHeaderText("已经停止录制");

alert.setOnCloseRequest(event1 -> alert.hide());

alert.showAndWait();

}

});

VBox box = new VBox();

box.getChildren().addAll(button, imageVideo);

primaryStage.setScene(new Scene(box));

primaryStage.setHeight(600);

primaryStage.setWidth(800);

primaryStage.show();

primaryStage.setOnCloseRequest(new EventHandler<WindowEvent>() {

@Override

public void handle(WindowEvent event) {// 退出时停止

isStop = true;

System.exit(0);

}

});

// 帧记录

// window 建议使用 FFmpegFrameGrabber("desktop") 进行屏幕捕捉

FrameGrabber grabber = new FFmpegFrameGrabber("desktop");

grabber.setFormat("gdigrab");

grabber.setFrameRate(frameRate);// 帧获取间隔

// 捕获指定区域,不设置则为全屏

grabber.setImageHeight(600);

grabber.setImageWidth(800);

// grabber.setOption("offset_x", "200");

// grabber.setOption("offset_y", "200");//必须设置了大小才能指定区域起点,参数可参考 FFmpeg 入参

grabber.start();

File file = new File("D://output.avi");

if (file.exists())

file.delete();

// 直播推流

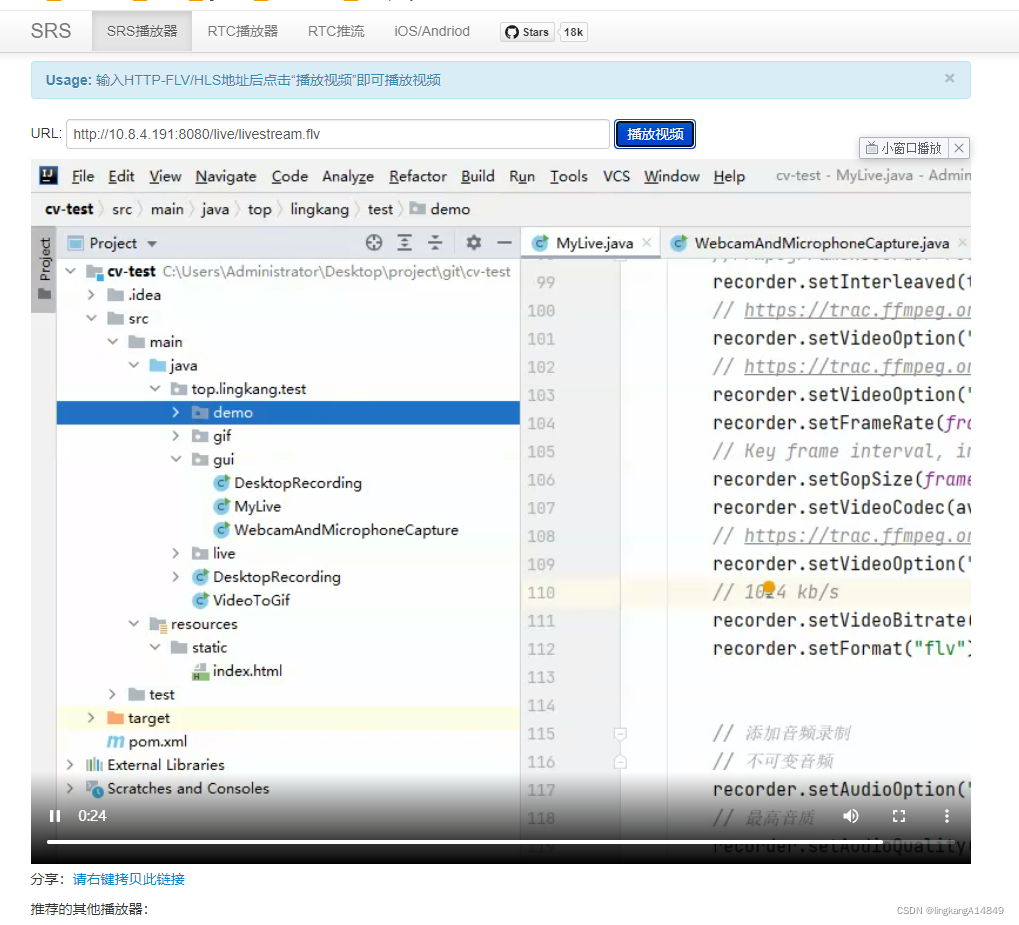

final FFmpegFrameRecorder recorder = new FFmpegFrameRecorder(

"rtmp://10.8.4.191/live/livestream",

grabber.getImageWidth(), grabber.getImageHeight(), 2);

// 用于存储视频 , 调用stop后,需要释放,就会在指定位置输出文件,,这里我保存到D盘

//FFmpegFrameRecorder recorder = FFmpegFrameRecorder.createDefault(file, grabber.getImageWidth(), grabber.getImageHeight());

recorder.setInterleaved(true);

// https://trac.ffmpeg.org/wiki/StreamingGuide

recorder.setVideoOption("tune", "zerolatency");// 加速

// https://trac.ffmpeg.org/wiki/Encode/H.264

recorder.setVideoOption("preset", "ultrafast");

recorder.setFrameRate(frameRate);// 设置帧率,重要!

// Key frame interval, in our case every 2 seconds -> 30 (fps) * 2 = 60

recorder.setGopSize(frameRate * 2);

recorder.setVideoCodec(avcodec.AV_CODEC_ID_H264);// 编码,使用编码能让视频占用内存更小,根据实际自行选择

// https://trac.ffmpeg.org/wiki/Encode/H.264

recorder.setVideoOption("crf", "28");

// 2000 kb/s 720P

recorder.setVideoBitrate(2000000);

recorder.setFormat("flv");

// 添加音频录制

// 不可变音频

recorder.setAudioOption("crf", "0");

// 最高音质

recorder.setAudioQuality(0);

// 192 Kbps

recorder.setAudioBitrate(192000);

recorder.setSampleRate(44100);

recorder.setAudioChannels(2);

recorder.setAudioCodec(avcodec.AV_CODEC_ID_AAC);

recorder.start();

// 44100 16声道

AudioFormat audioFormat = new AudioFormat(44100.0F, 16, 2, true, false);

DataLine.Info dataLineInfo = new DataLine.Info(TargetDataLine.class, audioFormat);

// 可以捕捉不同声道

line = (TargetDataLine) AudioSystem.getLine(dataLineInfo);

// 录制声音

new Thread(new Runnable() {

@Override

public void run() {

try {

line.open(audioFormat);

line.start();

final int sampleRate = (int) audioFormat.getSampleRate();

final int numChannels = audioFormat.getChannels();

// 缓冲区

final int audioBufferSize = sampleRate * numChannels;

final byte[] audioBytes = new byte[audioBufferSize];

Timer timer = new Timer();

timer.schedule(new TimerTask() {

@Override

public void run() {

try {

if (isStop) {// 停止录音

line.stop();

line.close();

System.out.println("已经停止!");

timer.cancel();

}

// 读取音频

// read会阻塞

int readLenth = 0;

while (readLenth == 0)

readLenth = line.read(audioBytes, 0, line.available());

// audioFormat 定义了音频输入为16进制,需要将字节[]转为短字节[]

// FFmpegFrameRecorder.recordSamples 源码中的 AV_SAMPLE_FMT_S16

int rl = readLenth / 2;

short[] samples = new short[rl];

// short[] 转换为 ShortBuffer

ByteBuffer.wrap(audioBytes).order(ByteOrder.LITTLE_ENDIAN).asShortBuffer().get(samples);

ShortBuffer sBuff = ShortBuffer.wrap(samples, 0, rl);

// 记录

recorder.recordSamples(sampleRate, numChannels, sBuff);

} catch (Exception e) {

e.printStackTrace();

}

}

}, 1000, 1000 / frameRate);

} catch (Exception e) {

e.printStackTrace();

}

}

}).start();

new Thread(new Runnable() {

@Override

public void run() {

try {

// 获取屏幕捕捉的一帧

Frame frame = null;

// 屏幕录制,由于已经对音频进行了记录,需要对记录时间进行调整即可

// 即上面调用了 recorder.recordSamples 需要重新分配时间,否则视频输出时长等于实际 的2倍

while ((frame = grabber.grab()) != null) {

if (isStop) {

try {

// 停止

recorder.stop();

grabber.stop();

// 释放内存,我们都知道c/c++需要手动释放资源

recorder.release();

grabber.release();

} catch (Exception e) {

e.printStackTrace();

}

break;

}

// 将这帧放到录制

recorder.record(frame);

Image convert = new JavaFXFrameConverter().convert(frame);

imageVideo.setImage(convert);

}

} catch (Exception e) {

e.printStackTrace();

}

}

}).start();

}

public static void main(String[] args) {

launch(args);

}

}

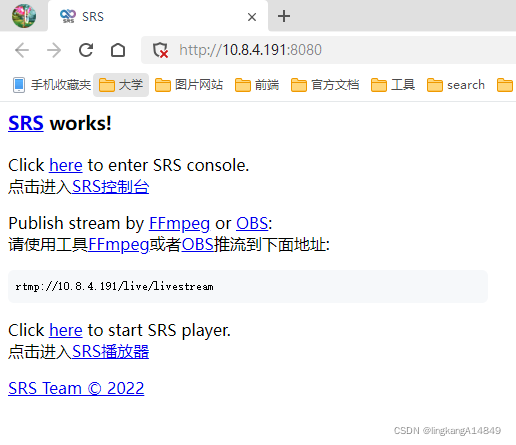

可以用docker起一个srs进行推流播放。

# 先启动

docker run -p 1935:1935 -p 1985:1985 -p 8080:8080 \

ccr.ccs.tencentyun.com/ossrs/srs:4

再启动推流:

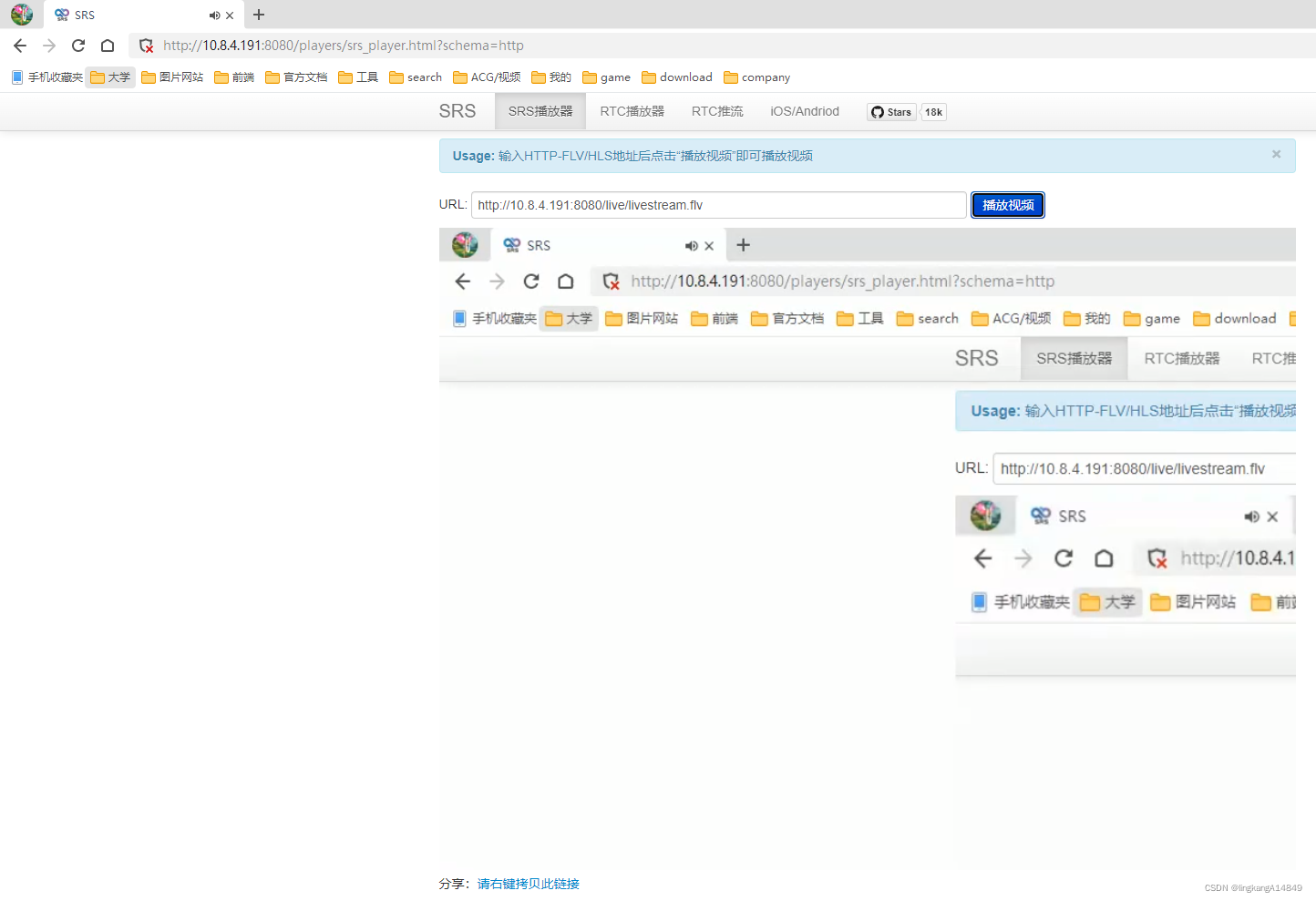

http://10.8.4.191:8080/players/srs_player.html?schema=http

javacv实现直播流的更多相关文章

- 利用docker搭建RTMP直播流服务器实现直播

一.rtmp服务器搭建 环境: centos 7.* 1.先安装docker(省略) 2.下载docker容器 docker pull alfg/nginx-rtmp 3.运行容器(记得打开防火墙端口 ...

- nginx + nginx-rtmp-module搭建直播流服务器实现推流实时直播功能

业务需求 最近公司在做养老相关的业务,现在需要子女从小程序端对家里的老人通过家庭终端交互屏进行实时看护. 解决方案 第三方的一些现成的服务:腾讯音视频通话.直播功能; 阿里的音视频通信;两者都挺好的, ...

- Java 监控直播流rtsp协议转rtmp、hls、httpflv协议返回浏览器

Java 监控直播流rtsp协议转rtmp.hls.httpflv协议返回浏览器 目录 需求背景: 一:了解音视频流协议: 二:方案一 rtsp 转rtmp 1.下载nginx + nginx-rtm ...

- 抛开flash,自己开发实现C++ RTMP直播流播放器

抛开flash,自己开发实现C++ RTMP直播流播放器 众所周知,RTMP是以flash为客户端播放器的直播协议,主要应用在B/S形式的场景中.本人研究并用C++开发实现了RTMP直播流协议的播放器 ...

- 实现输出h264直播流的rtmp服务器

RTMP(Real Time Messaging Protocol)是常见的流媒体协议,用来传输音视频数据,结合flash,广泛用于直播.点播.聊天等应用,以及pc.移动.嵌入式等平台,是做流媒体开发 ...

- 实现输出h264直播流的rtmp服务器 flash直播服务器【转】

实现输出h264直播流的rtmp服务器 RTMP(Real Time Messaging Protocol)是常见的流媒体协议,用来传输音视频数据,结合flash,广泛用于直播.点播.聊天等应用,以及 ...

- 实现输出h264直播流的rtmp服务器 flash直播服务器

http://www.cnblogs.com/haibindev/archive/2012/04/16/2450989.html 实现输出h264直播流的rtmp服务器 RTMP(Real Time ...

- 调用Live555接收RTSP直播流,转换为Http Live Streaming(iOS直播)协议

Live555接收RTSP直播流,转换Http Live Streaming(iOS直播)协议 RTSP协议也是广泛使用的直播/点播流媒体协议,之前实现过一个通过live555接收RTSP协议,然后转 ...

- 搭建rtmp直播流服务之4:videojs和ckPlayer开源播放器二次开发(播放rtmp、hls直播流及普通视频)

前面几章讲解了使用 nginx-rtmp搭建直播流媒体服务器; ffmpeg推流到nginx-rtmp服务器; java通过命令行调用ffmpeg实现推流服务; 从数据源获取,到使用ffmpeg推流, ...

- 实时监控、直播流、流媒体、视频网站开发方案流媒体服务器搭建及配置详解:使用nginx搭建rtmp直播、rtmp点播、,hls直播服务配置详解

注意:这里不会讲到nginx流媒体模块如何安装的问题,只研究rtmp,hls直播和录制相关的nginx服务器配置文件的详细用法和说明.可以对照这些命令详解配置nginx -rtmp服务 一.nginx ...

随机推荐

- 记一次 .NET 某拍摄监控软件 卡死分析

一:背景 1. 讲故事 今天本来想写一篇 非托管泄露 的生产事故分析,但想着昨天就上了一篇非托管文章,连着写也没什么意思,换个口味吧,刚好前些天有位朋友也找到我,说他们的拍摄监控软件卡死了,让我帮忙分 ...

- getc()、getchar()、getch() 和 getche() 的区别

所有这些函数都从输入中读取一个字符并返回一个整数值.返回整数以容纳用于指示失败的特殊值.EOF值通常用于此目的. getc() 它从给定的输入流中读取单个字符,并在成功时返回相应的整数值(通常 ...

- c#装饰器模式详解

基础介绍: 动态地给一个对象添加一些额外的职责.适用于需要扩展一个类的功能,或给一个类添加多个变化的情况. 装饰器,顾名思义就是在原有基础上添加一些功能. 大家都只知道如果想单纯的给原有类 ...

- x86平台SIMD编程入门(1):SIMD基础知识

1.简介 SIMD(Single Instruction, Multiple Data)是一种并行计算技术,它通过向量寄存器存储多个数据元素,并使用单条指令同时对这些数据元素进行处理,从而提高了计算效 ...

- KingabseES例程-事实数据与规则的匹配校验

KingabseES例程-事实数据与规则的匹配校验 背景 使用规则,对数据进行校验,比如电商的用户购物订单,是否合法.这就需要订单的多维度,如 用户.地区.物流.支付手段.供应商 等各类信息,进行动态 ...

- DM数据库SQL分页案例

DM一哥们找我优化条分页的SQL语句,结果集很小返回99行数据,废话不说安排一下. 原始SQL语句如下,保密要求,给真实的表名换了别名: SELECT count(*) FROM (SELECT TM ...

- 【Spring】事务实现原理

在使用事务的时候需要添加@EnableTransactionManagement注解来开启事务,Spring事务底层是通过AOP来实现的,所以启用事务后,同样会向容器中注入一个代理对象创建器,AOP使 ...

- PZthon

一道新式题目,python.exe的分析 这个时候没有思路不要紧,直接wp 先用特别的软件执行.exe程序,就是对.exe进行反编译 然后在反编译脚本的目录写就有了一个打包文件夹 在里面找到文件的.p ...

- shell 语法介绍

大家好,我是蓝胖子,在日常开发中或多或少都会接触到shell脚本,可以说会shell脚本是一位后端开发的基本功,今天我将会花上一篇文章总结下常见的shell的语法,学完本篇,相信简单的shell脚本就 ...

- Vite4+Typescript+Vue3+Pinia 从零搭建(3) - vite配置

项目代码同步至码云 weiz-vue3-template 关于vite的详细配置可查看 vite官方文档,本文简单介绍vite的常用配置. 初始内容 项目初建后,vite.config.ts 的默认内 ...