指导手册03:Hadoop基础操作

指导手册03:Hadoop基础操作

1.查询存储系统信息

(1)在WEB浏览器的地址栏输入http://master:50070/

请查看自己的Hadoop集群填写下表

|

Configured Capacity:己配置的文件系统存储总量 |

|

|

DFS Remaining :可使用的DFS存储总量 |

|

|

Non DFS Used 被非DFS的应用所占用的存储总量 |

|

|

DFS Used:己使用的 DFS存储总量 |

|

|

Live Nodes: 在线的数据节点: |

查询HDFS信息的命令

Hdfs dfsadmin –report [-live] [-dead] [decommissioning]

report:输出文件系统的基本信息及相关数据统计。

-report -live:输出文件系统中在线节点的基本信息及相关数据统计。

-report -dead:输出文件系统中失效节点的基本信息及相关数据统计。

-report -decommissioning:输出文件系统中停用节点的基本信息及相关数据统计。

|

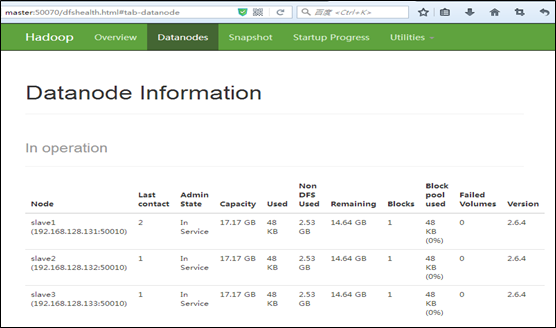

节点名(Node) |

总存储空间(capacity) |

己使用(DFS Used) |

DFS没使用(Non DFS Used) |

DFS 剩余(Remaining) |

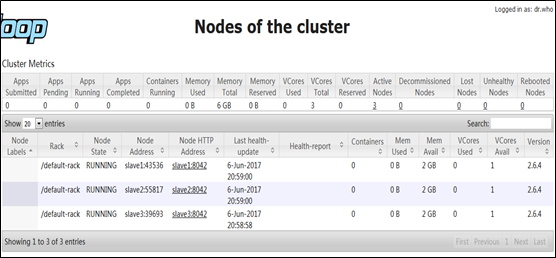

(3)查询集群的计算资源信息

继续单击页面上的超链接“slave1:8042”,可以显示计算机slave1的各项资源信息。

情景描述:

把存储在本机中的原始数据文件email_log.txt上传到Hadoop集群中的HDFS目录/user/root/

1.HDFS的基本操作

在本地计算机的Web浏览器可远程访问HDFS的监控服务端口(http://master:50070)。当需要访问HDFS上的目录及文件时,推荐使用http://master:50070/nn_browsedfscontent.jsp

(1) 创建新目录

hdfs dfs -mkdir [-p] <path> -p:不加只能逐级创建目录,加了可以多级创建目录

例:

[root@master]#hdfs dfs –mkdir –p /user/dfstest

[root@master]#hdfs dfs –mkdir –p /user/test/example

(2) 上传文件

命令 解释

hdfs dfs [-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>] 将文件从本地文件系统拷贝到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为拷贝的目标路径。

hdfs dfs [-moveFromLocal <localsrc> ... <dst>] 将文件从本地文件系统移动到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为移动的目标路径。

hdfs dfs [-put [-f] [-p] [-l] <localsrc> ... <dst>]

将文件从本地文件系统上传到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为上传的目标路径。

例:

将集群服务器节点上的本地文件a.txt上传到HDFS目录/user/dfstest中。(a.txt请自行新建)

[root@master hadoop-2.6.4] #hdfs dfs –copyFromLocal a.txt /user/dfstest

[root@master hadoop-2.6.4] #hdfs dfs –moveFromLocal a.txt /user/dfstest/b.txt

[root@master hadoop-2.6.4] #hdfs dfs –put a.txt /user/dfstest/c.txt

命令 解释

hdfs dfs [-copyToLocal [-p] [-ignoreCrc] [-crc] <src>... <localdst>] 将文件从HDFS文件系统拷贝到本地文件系统,主要参数<src>为HDFS文件系统路径,<localdst>为本地文件系统路径。

hdfs dfs [-get [-p] [-ignoreCrc] [-crc] <src>...<localdst>] 获取HDFS文件系统上指定路径的文件到本地文件系统,主要参数<src>为HDFS文件系统路径,<localdst>为本地文件系统路径。

例:

从/user/dfstest中下载a.txt和c.txt,存储在集群服务器节点master上的本地目录/data/hdfs_test/中。(hdfs_test目录请自行创建)

[root@master hdfs_test] #hdfs dfs –copyToLocal /user/dfstest/a.txt

[root@master hdfs_test] #hdfs dfs get /user/dfstest/c.txt

[root@master hdfs_test] # ls

命令 解释

hdfs dfs [-cat [-ignoreCrc] <src> ...] 查看HDFS文件内容,主要参数<src>指示文件路径。

hdfs dfs [-tail [-f] <file>] 输出HDFS文件最后1024字节,主要参数<file>指定文件。

例:

[root@master hdfs_test] #hdfs dfs –cat /user/dfstest/a.txt

[root@master hdfs_test] #hdfs dfs –tail /user/dfstest/c.txt

命令 解释

hdfs dfs [-rm [-f] [-r|-R] [-skipTrash] <src> ...] 删除HDFS上的文件,主要参数-r用于递归删除,<src>指定删除文件的路径。

hdfs dfs [-rmdir [--ignore-fail-on-non-empty] <dir> ...] 如果删除的是一个目录,则可以用该方法,主要参数<dir>指定目录路径。

例:

[root@master hdfs_test] #hdfs dfs –mkdir /user/dfstest/rmdir

[root@master hdfs_test] #hdfs dfs –rm /user/dfstest/c.txt

[root@master hdfs_test] #hdfs dfs –rmdir /user/dfstest/rmdir

(1)把本地计算机硬盘中的数据文件email_log.txt传输到集群服务器(master)的本地目录/root/hadoop。

可以使用SSH Secure等工具上传。

(2)在集群服务器(master)的终端执行HDFS命令,上传email_log.txt到HDFS目录/user/root/

Hdfs dfs -put /root/hadoop/email_log.txt /user/root/

指导手册03:Hadoop基础操作的更多相关文章

- 实训任务02:Hadoop基础操作

实训任务02:Hadoop基础操作 班级 学号 姓名 实训1:创建测试文件上传HDFS,并显示内容 需求说明: 在本地计算机上创建测试文件helloH ...

- hadoop - 基础操作

查看文件: [root@hadoop hadoop]# hadoop fs -lsr /drwxr-xr-x - root supergroup 0 2016-12-27 10:49 /homedrw ...

- hadoop基础操作

通过hadoop上的hive完成WordCount 启动hadoop Hdfs上创建文件夹 上传文件至hdfs 启动Hive 创建原始文档表 导入文件内容到表docs并查看 用HQL进行词频统计,结果 ...

- 指导手册04:运行MapReduce

指导手册04:运行MapReduce Part 1:运行单个MapReduce任务 情景描述: 本次任务要求对HDFS目录中的数据文件/user/root/email_log.txt进行计算处理, ...

- 指导手册02:伪分布式安装Hadoop(ubuntuLinux)

指导手册02:伪分布式安装Hadoop(ubuntuLinux) Part 1:安装及配置虚拟机 1.安装Linux. 1.安装Ubuntu1604 64位系统 2.设置语言,能输入中文 3.创建 ...

- 【Linux 操作系统】Ubuntu 基础操作 基础命令 热键 man手册使用 关机 重启等命令使用

. : 关机, 如果将Linux默认运行等级设置为0, 系统将无法启动; -- : 多用户模式, 允许使用网络文件系统, 一般不使用图形界面登陆就是这种模式; -- : 多用户图形界面模式, 该模式下 ...

- Hadoop基础-通过IO流操作HDFS

Hadoop基础-通过IO流操作HDFS 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.上传文件 /* @author :yinzhengjie Blog:http://www ...

- 指导手册01:安装Hadoop

指导手册01:安装Hadoop Part 1:安装及配置虚拟机 1.安装Linux. (1)打开VMvirtualBox (2) 控制->新建虚拟机,输入虚拟机名称“marst+学号” 类型: ...

- Hadoop基础-HDFS的API常见操作

Hadoop基础-HDFS的API常见操作 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本文主要是记录一写我在学习HDFS时的一些琐碎的学习笔记, 方便自己以后查看.在调用API ...

随机推荐

- Fluxion无线攻击

使用步骤 github地址 https://github.com/deltaxflux/fluxion 进入到fluxion目录下 ./fluxion 启动fluxion 启动之后会先检测没有安装的 ...

- ADB工具的使用

ADB即Android Debug Bridge调试桥,可以用来调试管理Android设备与设备模拟器的状态,比如,在Android设备上运行Shell,在电脑和设备之间互传文件... 那么问题来了. ...

- Access restriction: The type 'Unsafe' is not API

错误:Access restriction: The type 'Unsafe' is not API Eclipse中有一种叫做存取限制的机制,来防止你错误使用那些非共享的API.通常来说,Ecli ...

- .NetCore实现简单的分布式缓存

分布式缓存能够处理大量的动态数据,因此比较适合应用在Web 2.0时代中的社交网站等需要由用户生成内容的场景.从本地缓存扩展到分布式缓存后,关注重点从CPU.内存.缓存之间的数据传输速度差异也扩展到了 ...

- Javascript 面向对象编程2:构造函数的继承

这个系列的第一部分,主要介绍了如何"封装"数据和方法,以及如何从原型对象生成实例.对象之间的"继承"的五种方法.比如,现在有一个"动物"对象 ...

- Eclipse中Tomcat v8.0 Server at localhost右键选择Properties详情页中Server Locations变灰无法编辑

Eclipse中Tomcat v8.0 Server at localhost右键选择Properties详情页中Server Locations变灰无法编辑解决办法:1.首先将Servers中部署的 ...

- Docker 部署 elk + filebeat

Docker 部署 elk + filebeat kibana 开源的分析与可视化平台logstash 日志收集工具 logstash-forwarder(原名lubmberjack)elastics ...

- MySql 三大知识点,索引、锁、事务,原理分析

1.索引 索引,类似书籍的目录,可以根据目录的某个页码立即找到对应的内容. 索引的优点:1. 天生排序,2. 快速查找. 索引的缺点:1. 占用空间,2. 降低更新表的速度. 注意点:小表使用全表扫描 ...

- UI自动化(三)css优先级

<!DOCTYPE html><html lang="en"><head> <meta charset="UTF-8" ...

- D3生成树专题

这一天不知道怎的上课 竟然我说了两道题正解: 第一题:我写过一篇较详细的博客:https://www.cnblogs.com/Tyouchie/p/10366967.html 第二题:UVA10369 ...