Storm 系列(八)—— Storm 集成 HDFS 和 HBase

一、Storm集成HDFS

1.1 项目结构

本用例源码下载地址:storm-hdfs-integration

1.2 项目主要依赖

项目主要依赖如下,有两个地方需要注意:

- 这里由于我服务器上安装的是 CDH 版本的 Hadoop,在导入依赖时引入的也是 CDH 版本的依赖,需要使用

<repository>标签指定 CDH 的仓库地址; hadoop-common、hadoop-client、hadoop-hdfs均需要排除slf4j-log4j12依赖,原因是storm-core中已经有该依赖,不排除的话有 JAR 包冲突的风险;

<properties>

<storm.version>1.2.2</storm.version>

</properties>

<repositories>

<repository>

<id>cloudera</id>

<url>https://repository.cloudera.com/artifactory/cloudera-repos/</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>org.apache.storm</groupId>

<artifactId>storm-core</artifactId>

<version>${storm.version}</version>

</dependency>

<!--Storm 整合 HDFS 依赖-->

<dependency>

<groupId>org.apache.storm</groupId>

<artifactId>storm-hdfs</artifactId>

<version>${storm.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0-cdh5.15.2</version>

<exclusions>

<exclusion>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.6.0-cdh5.15.2</version>

<exclusions>

<exclusion>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.6.0-cdh5.15.2</version>

<exclusions>

<exclusion>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

</exclusion>

</exclusions>

</dependency>

</dependencies>1.3 DataSourceSpout

/**

* 产生词频样本的数据源

*/

public class DataSourceSpout extends BaseRichSpout {

private List<String> list = Arrays.asList("Spark", "Hadoop", "HBase", "Storm", "Flink", "Hive");

private SpoutOutputCollector spoutOutputCollector;

@Override

public void open(Map map, TopologyContext topologyContext, SpoutOutputCollector spoutOutputCollector) {

this.spoutOutputCollector = spoutOutputCollector;

}

@Override

public void nextTuple() {

// 模拟产生数据

String lineData = productData();

spoutOutputCollector.emit(new Values(lineData));

Utils.sleep(1000);

}

@Override

public void declareOutputFields(OutputFieldsDeclarer outputFieldsDeclarer) {

outputFieldsDeclarer.declare(new Fields("line"));

}

/**

* 模拟数据

*/

private String productData() {

Collections.shuffle(list);

Random random = new Random();

int endIndex = random.nextInt(list.size()) % (list.size()) + 1;

return StringUtils.join(list.toArray(), "\t", 0, endIndex);

}

}产生的模拟数据格式如下:

Spark HBase

Hive Flink Storm Hadoop HBase Spark

Flink

HBase Storm

HBase Hadoop Hive Flink

HBase Flink Hive Storm

Hive Flink Hadoop

HBase Hive

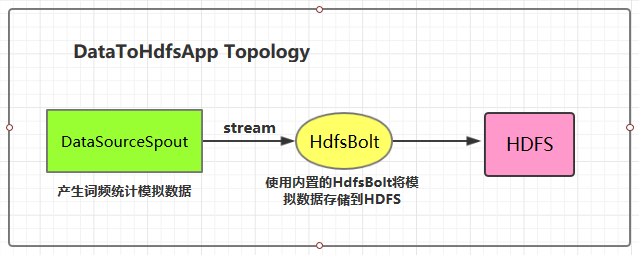

Hadoop Spark HBase Storm1.4 将数据存储到HDFS

这里 HDFS 的地址和数据存储路径均使用了硬编码,在实际开发中可以通过外部传参指定,这样程序更为灵活。

public class DataToHdfsApp {

private static final String DATA_SOURCE_SPOUT = "dataSourceSpout";

private static final String HDFS_BOLT = "hdfsBolt";

public static void main(String[] args) {

// 指定 Hadoop 的用户名 如果不指定,则在 HDFS 创建目录时候有可能抛出无权限的异常 (RemoteException: Permission denied)

System.setProperty("HADOOP_USER_NAME", "root");

// 定义输出字段 (Field) 之间的分隔符

RecordFormat format = new DelimitedRecordFormat()

.withFieldDelimiter("|");

// 同步策略: 每 100 个 tuples 之后就会把数据从缓存刷新到 HDFS 中

SyncPolicy syncPolicy = new CountSyncPolicy(100);

// 文件策略: 每个文件大小上限 1M,超过限定时,创建新文件并继续写入

FileRotationPolicy rotationPolicy = new FileSizeRotationPolicy(1.0f, Units.MB);

// 定义存储路径

FileNameFormat fileNameFormat = new DefaultFileNameFormat()

.withPath("/storm-hdfs/");

// 定义 HdfsBolt

HdfsBolt hdfsBolt = new HdfsBolt()

.withFsUrl("hdfs://hadoop001:8020")

.withFileNameFormat(fileNameFormat)

.withRecordFormat(format)

.withRotationPolicy(rotationPolicy)

.withSyncPolicy(syncPolicy);

// 构建 Topology

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout(DATA_SOURCE_SPOUT, new DataSourceSpout());

// save to HDFS

builder.setBolt(HDFS_BOLT, hdfsBolt, 1).shuffleGrouping(DATA_SOURCE_SPOUT);

// 如果外部传参 cluster 则代表线上环境启动,否则代表本地启动

if (args.length > 0 && args[0].equals("cluster")) {

try {

StormSubmitter.submitTopology("ClusterDataToHdfsApp", new Config(), builder.createTopology());

} catch (AlreadyAliveException | InvalidTopologyException | AuthorizationException e) {

e.printStackTrace();

}

} else {

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("LocalDataToHdfsApp",

new Config(), builder.createTopology());

}

}

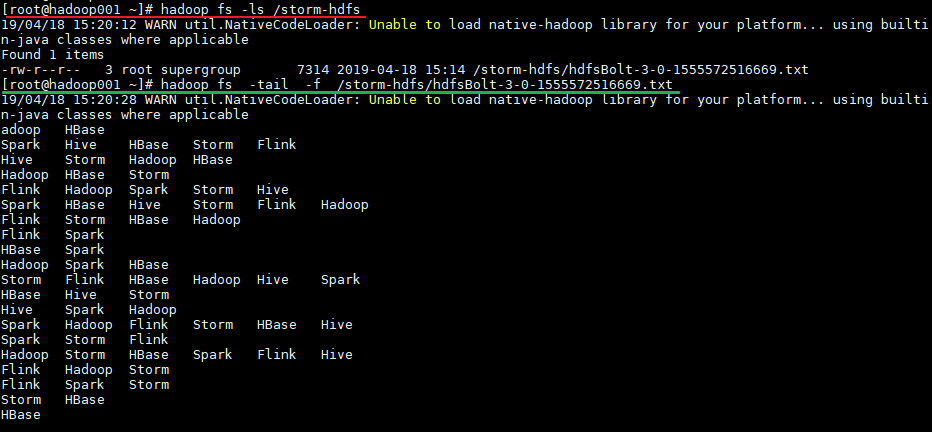

}1.5 启动测试

可以用直接使用本地模式运行,也可以打包后提交到服务器集群运行。本仓库提供的源码默认采用 maven-shade-plugin 进行打包,打包命令如下:

# mvn clean package -D maven.test.skip=true运行后,数据会存储到 HDFS 的 /storm-hdfs 目录下。使用以下命令可以查看目录内容:

# 查看目录内容

hadoop fs -ls /storm-hdfs

# 监听文内容变化

hadoop fs -tail -f /strom-hdfs/文件名

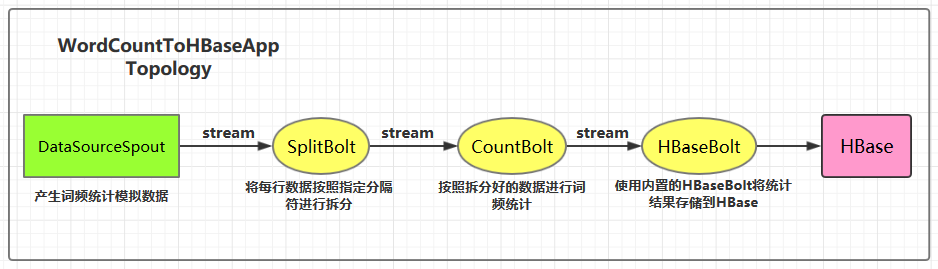

二、Storm集成HBase

2.1 项目结构

集成用例: 进行词频统计并将最后的结果存储到 HBase,项目主要结构如下:

本用例源码下载地址:storm-hbase-integration

2.2 项目主要依赖

<properties>

<storm.version>1.2.2</storm.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.storm</groupId>

<artifactId>storm-core</artifactId>

<version>${storm.version}</version>

</dependency>

<!--Storm 整合 HBase 依赖-->

<dependency>

<groupId>org.apache.storm</groupId>

<artifactId>storm-hbase</artifactId>

<version>${storm.version}</version>

</dependency>

</dependencies>2.3 DataSourceSpout

/**

* 产生词频样本的数据源

*/

public class DataSourceSpout extends BaseRichSpout {

private List<String> list = Arrays.asList("Spark", "Hadoop", "HBase", "Storm", "Flink", "Hive");

private SpoutOutputCollector spoutOutputCollector;

@Override

public void open(Map map, TopologyContext topologyContext, SpoutOutputCollector spoutOutputCollector) {

this.spoutOutputCollector = spoutOutputCollector;

}

@Override

public void nextTuple() {

// 模拟产生数据

String lineData = productData();

spoutOutputCollector.emit(new Values(lineData));

Utils.sleep(1000);

}

@Override

public void declareOutputFields(OutputFieldsDeclarer outputFieldsDeclarer) {

outputFieldsDeclarer.declare(new Fields("line"));

}

/**

* 模拟数据

*/

private String productData() {

Collections.shuffle(list);

Random random = new Random();

int endIndex = random.nextInt(list.size()) % (list.size()) + 1;

return StringUtils.join(list.toArray(), "\t", 0, endIndex);

}

}产生的模拟数据格式如下:

Spark HBase

Hive Flink Storm Hadoop HBase Spark

Flink

HBase Storm

HBase Hadoop Hive Flink

HBase Flink Hive Storm

Hive Flink Hadoop

HBase Hive

Hadoop Spark HBase Storm2.4 SplitBolt

/**

* 将每行数据按照指定分隔符进行拆分

*/

public class SplitBolt extends BaseRichBolt {

private OutputCollector collector;

@Override

public void prepare(Map stormConf, TopologyContext context, OutputCollector collector) {

this.collector = collector;

}

@Override

public void execute(Tuple input) {

String line = input.getStringByField("line");

String[] words = line.split("\t");

for (String word : words) {

collector.emit(tuple(word, 1));

}

}

@Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("word", "count"));

}

}2.5 CountBolt

/**

* 进行词频统计

*/

public class CountBolt extends BaseRichBolt {

private Map<String, Integer> counts = new HashMap<>();

private OutputCollector collector;

@Override

public void prepare(Map stormConf, TopologyContext context, OutputCollector collector) {

this.collector=collector;

}

@Override

public void execute(Tuple input) {

String word = input.getStringByField("word");

Integer count = counts.get(word);

if (count == null) {

count = 0;

}

count++;

counts.put(word, count);

// 输出

collector.emit(new Values(word, String.valueOf(count)));

}

@Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("word", "count"));

}

}2.6 WordCountToHBaseApp

/**

* 进行词频统计 并将统计结果存储到 HBase 中

*/

public class WordCountToHBaseApp {

private static final String DATA_SOURCE_SPOUT = "dataSourceSpout";

private static final String SPLIT_BOLT = "splitBolt";

private static final String COUNT_BOLT = "countBolt";

private static final String HBASE_BOLT = "hbaseBolt";

public static void main(String[] args) {

// storm 的配置

Config config = new Config();

// HBase 的配置

Map<String, Object> hbConf = new HashMap<>();

hbConf.put("hbase.rootdir", "hdfs://hadoop001:8020/hbase");

hbConf.put("hbase.zookeeper.quorum", "hadoop001:2181");

// 将 HBase 的配置传入 Storm 的配置中

config.put("hbase.conf", hbConf);

// 定义流数据与 HBase 中数据的映射

SimpleHBaseMapper mapper = new SimpleHBaseMapper()

.withRowKeyField("word")

.withColumnFields(new Fields("word","count"))

.withColumnFamily("info");

/*

* 给 HBaseBolt 传入表名、数据映射关系、和 HBase 的配置信息

* 表需要预先创建: create 'WordCount','info'

*/

HBaseBolt hbase = new HBaseBolt("WordCount", mapper)

.withConfigKey("hbase.conf");

// 构建 Topology

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout(DATA_SOURCE_SPOUT, new DataSourceSpout(),1);

// split

builder.setBolt(SPLIT_BOLT, new SplitBolt(), 1).shuffleGrouping(DATA_SOURCE_SPOUT);

// count

builder.setBolt(COUNT_BOLT, new CountBolt(),1).shuffleGrouping(SPLIT_BOLT);

// save to HBase

builder.setBolt(HBASE_BOLT, hbase, 1).shuffleGrouping(COUNT_BOLT);

// 如果外部传参 cluster 则代表线上环境启动,否则代表本地启动

if (args.length > 0 && args[0].equals("cluster")) {

try {

StormSubmitter.submitTopology("ClusterWordCountToRedisApp", config, builder.createTopology());

} catch (AlreadyAliveException | InvalidTopologyException | AuthorizationException e) {

e.printStackTrace();

}

} else {

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("LocalWordCountToRedisApp",

config, builder.createTopology());

}

}

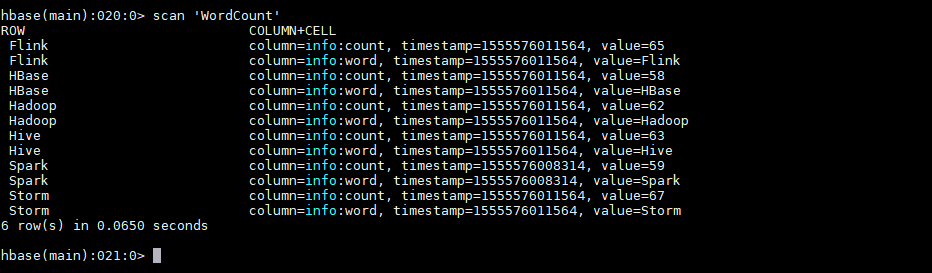

}2.7 启动测试

可以用直接使用本地模式运行,也可以打包后提交到服务器集群运行。本仓库提供的源码默认采用 maven-shade-plugin 进行打包,打包命令如下:

# mvn clean package -D maven.test.skip=true运行后,数据会存储到 HBase 的 WordCount 表中。使用以下命令查看表的内容:

hbase > scan 'WordCount'

2.8 withCounterFields

在上面的用例中我们是手动编码来实现词频统计,并将最后的结果存储到 HBase 中。其实也可以在构建 SimpleHBaseMapper 的时候通过 withCounterFields 指定 count 字段,被指定的字段会自动进行累加操作,这样也可以实现词频统计。需要注意的是 withCounterFields 指定的字段必须是 Long 类型,不能是 String 类型。

SimpleHBaseMapper mapper = new SimpleHBaseMapper()

.withRowKeyField("word")

.withColumnFields(new Fields("word"))

.withCounterFields(new Fields("count"))

.withColumnFamily("cf");参考资料

更多大数据系列文章可以参见 GitHub 开源项目: 大数据入门指南

Storm 系列(八)—— Storm 集成 HDFS 和 HBase的更多相关文章

- Storm 学习之路(八)—— Storm集成HDFS和HBase

一.Storm集成HDFS 1.1 项目结构 本用例源码下载地址:storm-hdfs-integration 1.2 项目主要依赖 项目主要依赖如下,有两个地方需要注意: 这里由于我服务器上安装的是 ...

- Storm系列一: Storm初步

初入Storm 前言 学习Storm已经有两周左右的时间,但是认真来说学习过程确实是零零散散,遇到问题去百度一下,找到新概念再次学习,在这样的一个循环又不成体系的过程中不断学习Storm. 前人栽树, ...

- Storm系列之一——Storm Topology并发

1.是什么构成一个可运行的topology? worker processes(worker进程),executors(线程)和tasks. 一台Storm集群里面的机器可能运行一个或多个worker ...

- Spring Boot系列 八、集成Kafka

一.引入依赖 <dependency> <groupId>org.springframework.kafka</groupId> <artifactId> ...

- Storm 系列(七)—— Storm 集成 Redis 详解

一.简介 Storm-Redis 提供了 Storm 与 Redis 的集成支持,你只需要引入对应的依赖即可使用: <dependency> <groupId>org.apac ...

- Storm 系列(二)实时平台介绍

Storm 系列(二)实时平台介绍 本章中的实时平台是指针对大数据进行实时分析的一整套系统,包括数据的收集.处理.存储等.一般而言,大数据有 4 个特点: Volumn(大量). Velocity(高 ...

- Storm 系列(一)基本概念

Storm 系列(一)基本概念 Apache Storm(http://storm.apache.org/)是由 Twitter 开源的分布式实时计算系统. Storm 可以非常容易并且可靠地处理无限 ...

- Storm 系列(六)—— Storm 项目三种打包方式对比分析

一.简介 在将 Storm Topology 提交到服务器集群运行时,需要先将项目进行打包.本文主要对比分析各种打包方式,并将打包过程中需要注意的事项进行说明.主要打包方式有以下三种: 第一种:不加任 ...

- Storm 系列(五)—— Storm 编程模型详解

一.简介 下图为 Strom 的运行流程图,在开发 Storm 流处理程序时,我们需要采用内置或自定义实现 spout(数据源) 和 bolt(处理单元),并通过 TopologyBuilder 将它 ...

随机推荐

- 一文彻底搞懂Java中的环境变量

一文搞懂Java环境变量 记得刚接触Java,第一件事就是配环境变量,作为一个初学者,只知道环境变量怎样配,在加上各种IDE使我们能方便的开发,而忽略了其本质的东西,只知其然不知其所以然,随着不断的深 ...

- element el-table resetfields() 不生效

表单中的重置按钮不生效的问题,结合文档对照后,发现是没有为el-form-item设置prop字段 所以,想让resetfields()生效有2个前提: form要设置ref,且ref值要与 this ...

- How to extract WeChat chat messages from a smartphone running Android 7.x or above

A friend of mine she was frustarted in extracting WeChat chat messages from suspect's smartphone run ...

- spring学习笔记之---bean管理

bean管理(xml) (一)spring的工厂类 FileSystemXmlApplicationContext 读取磁盘配置文件 (二)bean实例化的三种方式 (1)使用类构造器实例化(默认无参 ...

- 前端笔记之微信小程序(三)GET请求案例&文件上传和相册API&配置https

一.信息流小程序-GET请求案例 1.1服务端接口开发 一定要养成接口的意识,前端单打独斗出不来任何效果,必须有接口配合,写一个带有分页.关键词查询的接口: 分页接口:http://127.0.0.1 ...

- 基于opencv,开发摄像头播放程序

前言 Windows下实现摄像视频捕捉有多种实现方式:各种方式的优劣,本文不做对比.但是,opencv是一款老牌开发库,在图像处理领域声名显赫.采用opencv来处理摄像视频,在性能和稳定性上,是有保 ...

- 关于 java中的换行符

java中实现换行有以下3种方法: 1.使用java中的转义符"\r\n": String str="aaa"; str+="\r\n"; ...

- Netty学习(九)-Netty编解码技术之Marshalling

前面我们讲过protobuf的使用,主流的编解码框架其实还有很多种: ①JBoss的Marshalling包 ②google的Protobuf ③基于Protobuf的Kyro ④Apache的Thr ...

- Vue创建项目配置

前言 安装VS Code,开始vue的学习及编程,但是总是遇到各种各样的错误,控制台语法错误,格式错误.一股脑的袭来,感觉创建个项目怎么这个麻烦.这里就讲一下vue的安装及创建. 安装环境 当然第一步 ...

- 记一次JPA遇到的奇葩错误——本地sql不识别表名的别名

记一次JPA遇到的奇葩错误——本地sql不识别表名的别名 报错:Unknown column 'our' in 'field list' 起因:需要本地sql查询后,分页返回自定义对象.报错信息如下: ...