p1 批梯度下降算法

(蓝色字体:批注;绿色背景:需要注意的地方;橙色背景是问题)

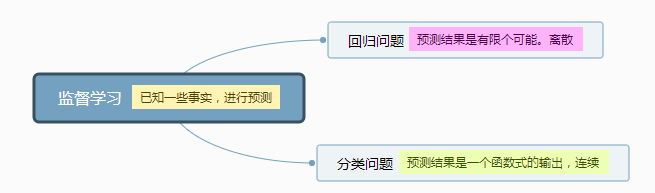

一,机器学习分类

二,梯度下降算法:2.1模型 2.2代价函数 2.3 梯度下降算法

一,机器学习分类

无监督学习和监督学习

无监督学习主要有聚类算法(例题:鸡尾酒会算法)根据数据中的变量关系来将数据进行分类

其中分类算法,可以根据一个特征来分类,多个特征分类更加准确

二,多元回归问题

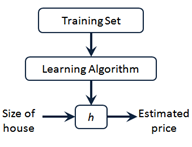

2.1 模型定义:

m代表训练集中实例的数量

x 代表特征或者输入变量 (x是一个向量,可以有很多特征)

y 代表目标变量/输出变量(y也有可能是一个特征)

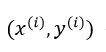

(x,y)代表训练集中的实例(训练样本)

代表第 i个观察实例(训练样本)

代表第 i个观察实例(训练样本)

h :假设。

2.2 代价函数

定义:衡量 模型预测出来的值h(θ)与真实值y之间的差异 的函数。(如果有多个样本,则可以将所有代价函数的取值求均值,记做J(θ)。)

用处:我们用代价函数是为了训练参数θ,利用代价函数衡量θ的好坏。从而得到最符合训练集的模型

性质:

- 对于每种算法来说,代价函数不是唯一的;

- 代价函数的自变量是θ,而假设函数h的自变量是x。

- 总的代价函数J(θ)可以用来评价模型的好坏,代价函数越小说明模型和参数越符合训练样本(x, y);

- J(θ)是一个标量;

- 选择代价函数时,最好挑选对参数θ可微的函数

理想情况下,当我们取到代价函数J的最小值时,就得到了最优的参数θ,记为:minθJ(θ)。例如,J(θ) = 0,表示我们的模型完美的拟合了观察的数据,没有任何误差。

参考:https://www.cnblogs.com/Belter/p/6653773.html?utm_source=itdadao&utm_medium=referral

(在训练过程中:选取模型,这个过程只是一个模型比如是多元多次函数,指数函数等,确定参数个数;给参数一个初始值;然后利用训练集训练;使代价函数收敛于最小值,即确定参数)

代价函数有均方误差函数,交叉熵函数等

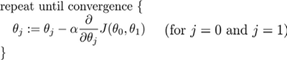

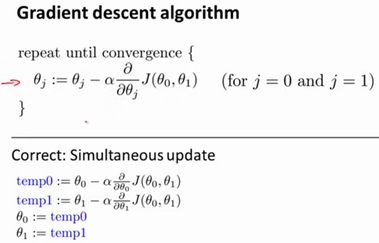

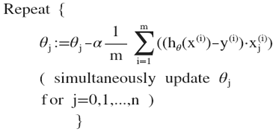

2.3 批梯度下降算法

对于二元线性问题:

实现梯度下降算法的微妙之处是,在这个表达式中,需要同时更新 和Θ1,Θ0:

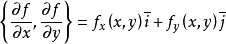

- 这里的Θ是一个标量,减法并不能代表矢量运算,梯度下降里面的偏导数现在只是一个正负的区别,并不表示一个方向。因为梯度的定义是:

。梯度是一个向量。这这里只是梯度的一个坐标。所以每一次参数更新都是同时更新两个

。梯度是一个向量。这这里只是梯度的一个坐标。所以每一次参数更新都是同时更新两个 - 这里的同步更新是很重要的,因为不同步,两个参数会前后影响

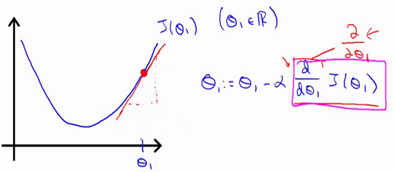

- 这里的参数更新用相减的形式是为了更靠近J最低点的地方,就是让J更快速靠近最低点。而且此时的更新不再沿着函数变化,而是沿着每一个地方的切线。

对于二元问题,这里的 α 是我们切线上纵坐标变化值Δy。这里我们不用改变α ,最终由偏导数来控制大小然后实现收敛。

梯度下降算法是根据当前点找偏导数最小的方向然后更改点的位置,所以算法看不见最小值,只能找到这个方向进行参数的训练,所以要注意当学习率比较大时,如果代价函数不是凸函数就很有可能迭代到离我们的最小值很远的局部最小值点。而且对于多维函数,偏导的方向并不向一维一样只能在正负方向,偏导方向可能是四面八方。

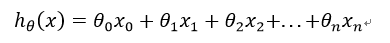

对于多元线性问题:

其中x0=1(为了方便运算添加了x0)

其中x0=1(为了方便运算添加了x0)

计算所有的预测结果后,再给所有的参数一个新的值,如此循环直到收敛。这里注意也是同时更新

p1 批梯度下降算法的更多相关文章

- 监督学习:随机梯度下降算法(sgd)和批梯度下降算法(bgd)

线性回归 首先要明白什么是回归.回归的目的是通过几个已知数据来预测另一个数值型数据的目标值. 假设特征和结果满足线性关系,即满足一个计算公式h(x),这个公式的自变量就是已知的数据x,函数值h(x)就 ...

- 监督学习——随机梯度下降算法(sgd)和批梯度下降算法(bgd)

线性回归 首先要明白什么是回归.回归的目的是通过几个已知数据来预测另一个数值型数据的目标值. 假设特征和结果满足线性关系,即满足一个计算公式h(x),这个公式的自变量就是已知的数据x,函数值h(x)就 ...

- 梯度下降算法实现原理(Gradient Descent)

概述 梯度下降法(Gradient Descent)是一个算法,但不是像多元线性回归那样是一个具体做回归任务的算法,而是一个非常通用的优化算法来帮助一些机器学习算法求解出最优解的,所谓的通用就是很 ...

- 梯度下降算法的一点认识(Ng第一课)

昨天开始看Ng教授的机器学习课,发现果然是不错的课程,一口气看到第二课. 第一课 没有什么新知识,就是机器学习的概况吧. 第二课 出现了一些听不太懂的概念.其实这堂课主要就讲了一个算法,梯度下降算法. ...

- ng机器学习视频笔记(二) ——梯度下降算法解释以及求解θ

ng机器学习视频笔记(二) --梯度下降算法解释以及求解θ (转载请附上本文链接--linhxx) 一.解释梯度算法 梯度算法公式以及简化的代价函数图,如上图所示. 1)偏导数 由上图可知,在a点 ...

- [机器学习Lesson3] 梯度下降算法

1. Gradient Descent(梯度下降) 梯度下降算法是很常用的算法,可以将代价函数J最小化.它不仅被用在线性回归上,也被广泛应用于机器学习领域中的众多领域. 1.1 线性回归问题应用 我们 ...

- Spark MLib:梯度下降算法实现

声明:本文参考< 大数据:Spark mlib(三) GradientDescent梯度下降算法之Spark实现> 1. 什么是梯度下降? 梯度下降法(英语:Gradient descen ...

- AI-2.梯度下降算法

上节定义了神经网络中几个重要的常见的函数,最后提到的损失函数的目的就是求得一组合适的w.b 先看下损失函数的曲线图,如下 即目的就是求得最低点对应的一组w.b,而本节要讲的梯度下降算法就是会一步一步地 ...

- Logistic回归Cost函数和J(θ)的推导(二)----梯度下降算法求解最小值

前言 在上一篇随笔里,我们讲了Logistic回归cost函数的推导过程.接下来的算法求解使用如下的cost函数形式: 简单回顾一下几个变量的含义: 表1 cost函数解释 x(i) 每个样本数据点在 ...

随机推荐

- 【Linux 进程】fork父子进程间共享数据分析

之前我们通过fork()函数,得知了父子进程之间的存在着代码的拷贝,且父子进程都相互独立执行,那么父子进程是否共享同一段数据,即是否存在着数据共享.接下来我们就来分析分析父子进程是否存在着数据共享. ...

- JDK1.5 Excutor 与ThreadFactory

Excutor 源码解读: /** * An object that executes submitted {@link Runnable} tasks. This * interface provi ...

- 33-Java中的String,StringBuilder,StringBuffer三者的区别

转载自:https://www.cnblogs.com/su-feng/p/6659064.html StringBuilder 详解 (String系列之2) Java中的String,String ...

- <context:annotation-config/>,<mvc:annotation-driven/>和<context:component-scan>之间的关系

首先看一下三个注解各自定义: ① <context:annotation-config/> 1.如果你想使用@Autowired注解,那么就必须事先在 spring 容器中声明 Autow ...

- centos7下keepalived1.3.4安装与使用

keepalived是集群管理中保证集群高可用的一个服务软件,其功能类似于heartbeat,用来防止单点故障. 一.下载keepalived http://www.keepalived.org/ 如 ...

- centos7+nginx+rtmp+ffmpeg搭建流媒体服务器

1.安装前需要的工具 #net-tool 查本地IP #wget 下载安装包 #unzip 解压zip包 #gcc gcc-c++ perl 编译软件包用 yum install -y net-too ...

- Python 字符串(count)

字符串 count:(python中的count()函数,从字面上可以知道,他具有统计功能) Python count() 方法用于统计字符串里某个字符出现的次数.可选参数为在字符串搜索的开始与结束位 ...

- Hadoop(四)shell脚本定时采集日志数据到hdfs

#!/bin/bash #set java envexport JAVA_HOME=/wocloud/java/jdk1.7.0_45export JRE_HOME=${JAVA_HOME}/jree ...

- Fedora : multilib version problems found

摘自:https://smjrifle.net/fedora-fix-multilib-version-problems/ This error was due to duplicate packag ...

- git的命令详解

# git三个区 + 工作区: 写代码的地方 + 暂存区: 暂时存储代码 + 仓库区: 代码提交到了仓库区,就生成一条历史记录(版本) 工作区===> 暂存区 ===> 仓库区 # git ...