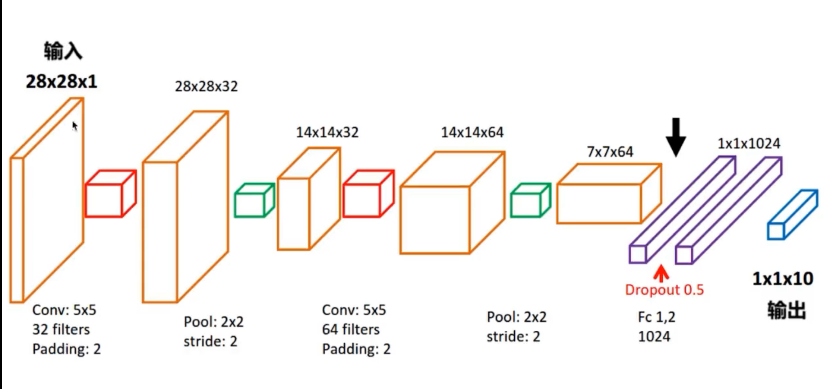

实现CNN卷积神经网络

以上是模型,下面是代码:

import tensorflow as tf

import numpy as np

import time

from tensorflow.examples.tutorials.mnist import input_data import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '' start = time.clock() # 下载并载入MNIST 手写数字库

mnist = input_data.read_data_sets("./data/MNIST", one_hot=True) input_x = tf.placeholder(tf.float32, shape=[None, 28 * 28]) / 255 # 灰度的处理

output_y = tf.placeholder(tf.float32, shape=[None, 10]) #输出10个数字的标签

input_x_images = tf.reshape(input_x, shape=[-1, 28, 28, 1]) #改变形状之后的输入 # 从Test(测试)数据集里选取3000个手写数字的图片和对应的标签

test_x = mnist.test.images[:3000]

test_y = mnist.test.labels[:3000] # 构建我们的卷积神经网络

# 第一层卷积

conv1 = tf.layers.conv2d(inputs=input_x_images, # 形状为[28,28,1]

filters=32, # 32个过滤器,输出的深度位32

kernel_size=[5, 5], # 过滤器在二维的大小是(5*5)

strides=1, # 步长是1

padding="same", # snme表示输出大小不变,因此要在外围补零2圈

activation=tf.nn.relu # 表示激活函数是relu

) # 形状[28,28,32] # 第一层池化(亚采样)

pool1 = tf.layers.max_pooling2d(

inputs=conv1, # 形状[28,28,32]

pool_size=[2, 2], # 过滤器在二维的大小是[2,2]

strides=2 # 步长是2

) # 形状[14,14,32] # 第二层卷积

conv2 = tf.layers.conv2d(inputs=pool1, # 形状为[14,14,32]

filters=64, # 64个过滤器,输出的深度位64

kernel_size=[5, 5], # 过滤器在二维的大小是(5*5)

strides=1, # 步长是1

padding="same", # snme表示输出大小不变,因此要在外围补零2圈

activation=tf.nn.relu # 表示激活函数是relu

) # 形状[14,14,64] # 第二层池化(亚采样)

pool2 = tf.layers.max_pooling2d(

inputs=conv2, # 形状[14,14,64]

pool_size=[2, 2], # 过滤器在二维的大小是[2,2]

strides=2 # 步长是2

) # 形状[7,7,64] #平坦化(flat)

flat = tf.reshape(pool2,shape=[-1,7 * 7 * 64]) #形状[7 * 7 * 64] #1024个神经元的全连接层

dense = tf.layers.dense(inputs=flat,units=1024,activation=tf.nn.relu) #Dropout :丢弃 50% rate = 0.5

dropout = tf.layers.dropout(inputs=dense,rate=0.5) #10个神经元的全连接层,这里不用激活函数来做非线性化了。

logits = tf.layers.dense(inputs=dropout,units=10) #输出形状[1,1,10] #计算误差(计算 Cross entropy(交叉熵)),再用softmax计算百分比概率

loss = tf.losses.softmax_cross_entropy(onehot_labels=output_y,logits=logits) # Adam 优化器来最小化误差,学习率0.001

train_op = tf.train.AdadeltaOptimizer(learning_rate=0.001).minimize(loss) #精度,计算,预测值 和 实际标签 的匹配程度

#返回 (accuracy .update_op) 会创建两个局部变量

accuracy = tf.metrics.accuracy(

labels=tf.argmax(input=output_y,axis=1),

predictions=tf.argmax(input=logits,axis=1)

)[1] #创建会话

with tf.Session() as sess:

#初始化变量

init = tf.group(tf.global_variables_initializer(),tf.local_variables_initializer())

sess.run(init)

for i in range(20000):

batch = mnist.train.next_batch(50) #从Train(训练)数据集里下一个50个样本

train_loss,train_op_ = sess.run([loss,train_op],feed_dict={input_x:batch[0],output_y:batch[1]})

if i % 100 == 0:

test_accuracy = sess.run(accuracy,feed_dict={input_x:test_x,output_y:test_y})

print(("Step+%d,Train loss=%.4f,[Test accuracy=%.2f]") % (i,train_loss,test_accuracy)) #测试:打印20个 预测值 和 真实值 的对

test_output = sess.run(logits,feed_dict={input_x:test_x[:20]})

inference_y = np.argmax(test_output,1)

print(inference_y," Inference number") #推测的数字

print(np.argmax(test_y[:20],1),"Real numbers") #真实的数字 #显示时间

end = time.clock()

print(end - start, "秒")

当然CNN还有很长一段路要走。代码不容易,且敲且珍惜。

实现CNN卷积神经网络的更多相关文章

- Deep Learning模型之:CNN卷积神经网络(一)深度解析CNN

http://m.blog.csdn.net/blog/wu010555688/24487301 本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep le ...

- [转]Theano下用CNN(卷积神经网络)做车牌中文字符OCR

Theano下用CNN(卷积神经网络)做车牌中文字符OCR 原文地址:http://m.blog.csdn.net/article/details?id=50989742 之前时间一直在看 Micha ...

- Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现(转)

Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文, ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

https://www.zhihu.com/question/34681168 CNN(卷积神经网络).RNN(循环神经网络).DNN(深度神经网络)的内部网络结构有什么区别?修改 CNN(卷积神经网 ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN,LSTM

http://cs231n.github.io/neural-networks-1 https://arxiv.org/pdf/1603.07285.pdf https://adeshpande3.g ...

- day-16 CNN卷积神经网络算法之Max pooling池化操作学习

利用CNN卷积神经网络进行训练时,进行完卷积运算,还需要接着进行Max pooling池化操作,目的是在尽量不丢失图像特征前期下,对图像进行downsampling. 首先看下max pooling的 ...

- cnn(卷积神经网络)比较系统的讲解

本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep learning简介 [2]Deep Learning训练过程 [3]Deep Learning模型之 ...

- Keras(四)CNN 卷积神经网络 RNN 循环神经网络 原理及实例

CNN 卷积神经网络 卷积 池化 https://www.cnblogs.com/peng8098/p/nlp_16.html 中有介绍 以数据集MNIST构建一个卷积神经网路 from keras. ...

- TensorFlow——CNN卷积神经网络处理Mnist数据集

CNN卷积神经网络处理Mnist数据集 CNN模型结构: 输入层:Mnist数据集(28*28) 第一层卷积:感受视野5*5,步长为1,卷积核:32个 第一层池化:池化视野2*2,步长为2 第二层卷积 ...

- tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图

tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图 因为很多 demo 都比较复杂,专门抽出这两个函数,写的 demo. 更多教程:http://www.tensorflown ...

随机推荐

- Vue.js中ref ($refs)用法举例总结

原文地址:http://www.cnblogs.com/xueweijie/p/6907676.html <div id="app"> <input type=& ...

- Win32-Application的窗口和对话框

Win32 Application,没有基于MFC的类库,而是直接调用C++接口来编程. 一.弹出消息窗口 (1)最简单的,在当前窗口中弹出新窗口.新窗口只有“YES”按钮. int APIENTRY ...

- 排产的两种方式(前推式与后拉式)在Optaplanner上的体现

生产计划的约束 在制定生产计划过程中,必然是存在某些制约因素,满足某些需求才能进行的,或是交期保证.或是产能限制.或是关键工序制约.即TOC理论 - 任何系统至少存在着一个制约因素/瓶颈:否则它就可能 ...

- PAT 甲级 1035 Password (20 分)

1035 Password (20 分) To prepare for PAT, the judge sometimes has to generate random passwords for th ...

- 2018-2019-2 20175227张雪莹《Java程序设计》实验三 《敏捷开发与XP实践》

2018-2019-2 20175227张雪莹<Java程序设计> 实验三 <敏捷开发与XP实践> 实验报告封面 课程:Java程序设计 班级:1752班 姓名:张雪莹 学号: ...

- 报错:Flink Could not resolve substitution to a value: ${akka.stream.materializer}

报错现象: Exception in thread "main" com.typesafe.config.ConfigException$UnresolvedSubstitutio ...

- snmpd 服务安装和配置(转载)

snmp rpm包安装步骤 https://blog.csdn.net/macrothunder/article/details/50394566 rpm包位置: http://rpm.pbone.n ...

- 三、thymeleaf模板引擎构建前台html, 后台使用 ModelAndView 和 Model 模型

项目源码:https://github.com/y369q369/springBoot.git -> thymeleaf 私聊QQ: 1486866853 1.pom.xml中 ...

- linux: 用户组, 文件权限详解

一.用户组 linux中每个用户必须属于一个组,不能独立于组外. 每个文件有所有者.所在组.其他组的概念 --所有者 一般为文件的创建者,谁创建了该文件,就天然的成为该文件的所有者 用ls ‐ahl命 ...

- Troubleshooting 10g and 11.1 Clusterware Reboots (文档 ID 265769.1)

Troubleshooting 10g and 11.1 Clusterware Reboots (文档 ID 265769.1) This document is intended for DBA' ...