lvs-dr 模式-piranha

系统: redhat 6.5 mini

|

机器名 |

ip |

vip |

|

lvs01(主lvs) |

192.168.20.10 |

192.168.20.254 |

|

lvs02(备lvs) |

192.168.20.20 |

|

|

rs01 (web) |

192.168.20.100 |

|

|

rs02 (web) |

192.168.20.200 |

1、 在各个机器上配置ip地址,机器名,关闭selinux,同步时间

[root@lvs01 ~]# hostname

lvs01

[root@lvs01 ~]# getenforce

Disabled

[root@lvs02 ~]# hostname

lvs02

[root@lvs02 ~]# getenforce

Disabled

[root@rs01 ~]# hostname

rs01

[root@rs01 ~]# getenforce

Disabled

[root@rs02 ~]# hostname

rs02

[root@rs02 ~]# getenforce

Disabled

[root@lvs01 yum.repos.d]# cat /etc/hosts

192.168.20.10 lvs01

192.168.20.20 lvs02

192.168.20.100 rs01

192.168.20.200 rs02

[root@lvs01 yum.repos.d]# ntpdate 0.rhel.pool.ntp.org

[root@lvs02 yum.repos.d]# ntpdate 0.rhel.pool.ntp.org

[root@rs01 yum.repos.d]# ntpdate 0.rhel.pool.ntp.org

[root@rs02 yum.repos.d]# ntpdate 0.rhel.pool.ntp.org

2、 在各个机器关闭防火墙,配置yum源

[root@lvs01 yum.repos.d]# service iptables stop

[root@lvs01 yum.repos.d]# chkconfig iptables off

[root@lvs02 ~]# service iptables stop

[root@lvs02 ~]# chkconfig iptables off

[root@rs01 ~]# service iptables stop

[root@rs01 ~]# chkconfig iptables off

[root@rs02 ~]# service iptables stop

[root@rs02 ~]# chkconfig iptables off

[root@lvs01 yum.repos.d]# service iptables stop

[root@lvs01 yum.repos.d]# chkconfig iptables off

[root@lvs01 yum.repos.d]# cat rhel-source.repo

[base]

name=base

baseurl=file:///mnt

enabled=1

gpgcheck=0

[LB]

name=LB

baseurl=file:///mnt/LoadBalancer

enabled=1

gpgcheck=0

[HA]

name=HA

baseurl=file:///mnt/HighAvailability

enabled=1

gpgcheck=0

[RS]

name=RS

baseurl=file:///mnt/ResilientStorage

enabled=1

gpgcheck=0

[root@lvs01 yum.repos.d]# scp rhel-source.repo lvs02:/etc/yum.repos.d/rhel-source.repo

3、 在rs01.rs02上部署web服务,设置arptables,添加vip

[root@rs01 ~]#ip addr add 192.168.20.254/24 dev eth0

[root@rs01 ~]# echo "ip addr add 192.168.20.254/24 dev eth0">>/etc/rc.d/rc.local

[root@rs01 ~]# arptables -A IN -d 192.168.20.254 -j DROP

[root@rs01 ~]# arptables -A OUT -s 192.168.20.254 -j mangle --mangle-ip-s 192.168.20.100

[root@rs01 ~]# service arptables_jf save

将当前规则保存到 /etc/sysconfig/arptables: [确定]

[root@rs01 ~]# chkconfig arptables_jf on

[root@rs01 ~]# yum install -y httpd

[root@rs01 ~]# echo "rs01">/var/www/html/index.html

[root@rs01 ~]# service httpd restart

[root@rs01 ~]# chkconfig httpd on

[root@rs02 ~]# arptables -A IN -d 192.168.20.254 -j DROP

[root@rs02 ~]# arptables -A OUT -s 192.168.20.254 -j mangle --mangle-ip-s 192.168.20.100

[root@rs02 ~]# service arptables_jf save

将当前规则保存到 /etc/sysconfig/arptables: [确定]

[root@rs02 ~]# chkconfig arptables_jf on

[root@rs02 ~]#ip addr add 192.168.20.254/24 dev eth0

[root@rs02 ~]# echo "ip addr add 192.168.20.254/24 dev eth0">>/etc/rc.d/rc.local

[root@rs02 ~]# yum install -y httpd

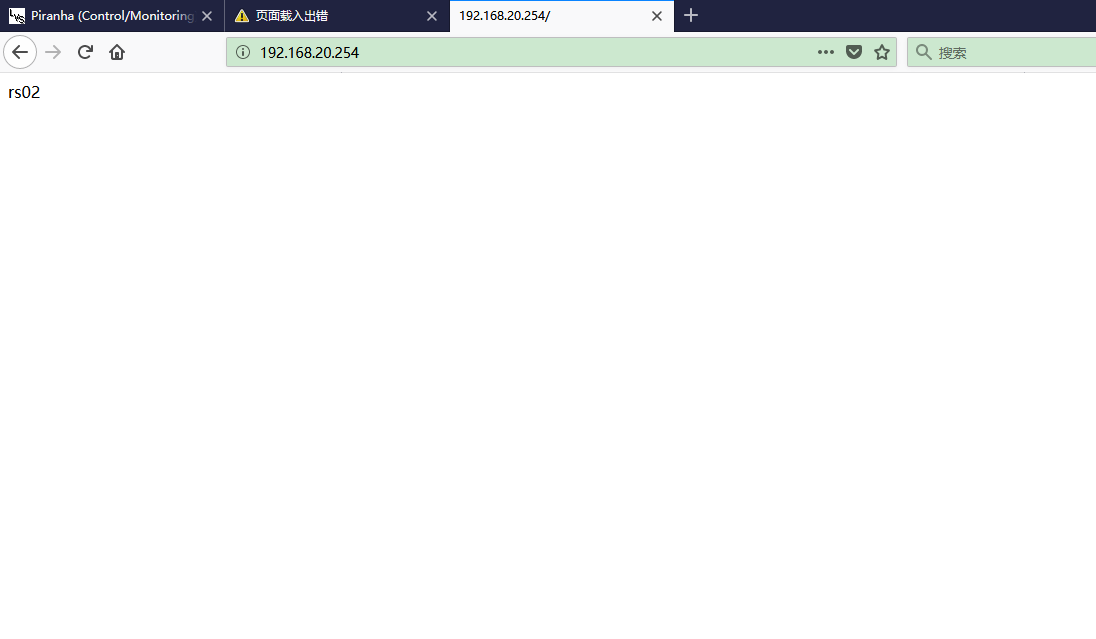

[root@rs02 ~]# echo "rs02">/var/www/html/index.html

[root@rs02 ~]# service httpd restart

[root@rs02 ~]# chkconfig httpd on

4、 在lvs01,lvs02安装LB,在lvs01上配置lvs集群登录用户和密码

[root@lvs01 yum.repos.d]# yum groupinstall "Load Balancer"

[root@lvs02 yum.repos.d]# yum groupinstall "Load Balancer"

[root@lvs01 yum.repos.d]# piranha-passwd

New Password:

Verify:

Adding password for user piranha

[root@lvs01 yum.repos.d]# /etc/init.d/piranha-gui start

[root@lvs01 yum.repos.d]# chkconfig piranha-gui on

5、通过浏览器配置lvs集群

5.1 在浏览器输入http://192.168.20.10:3636 输入用户名和密码

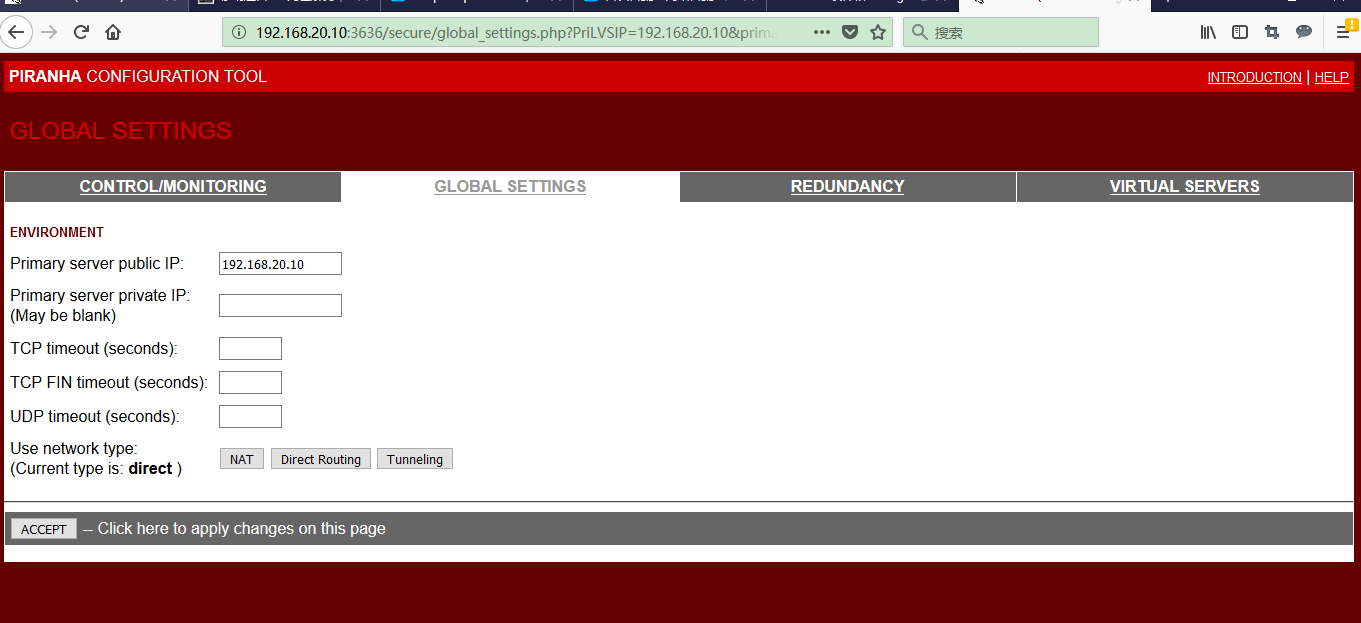

5.2 配置lvs01,ip地址,选direct

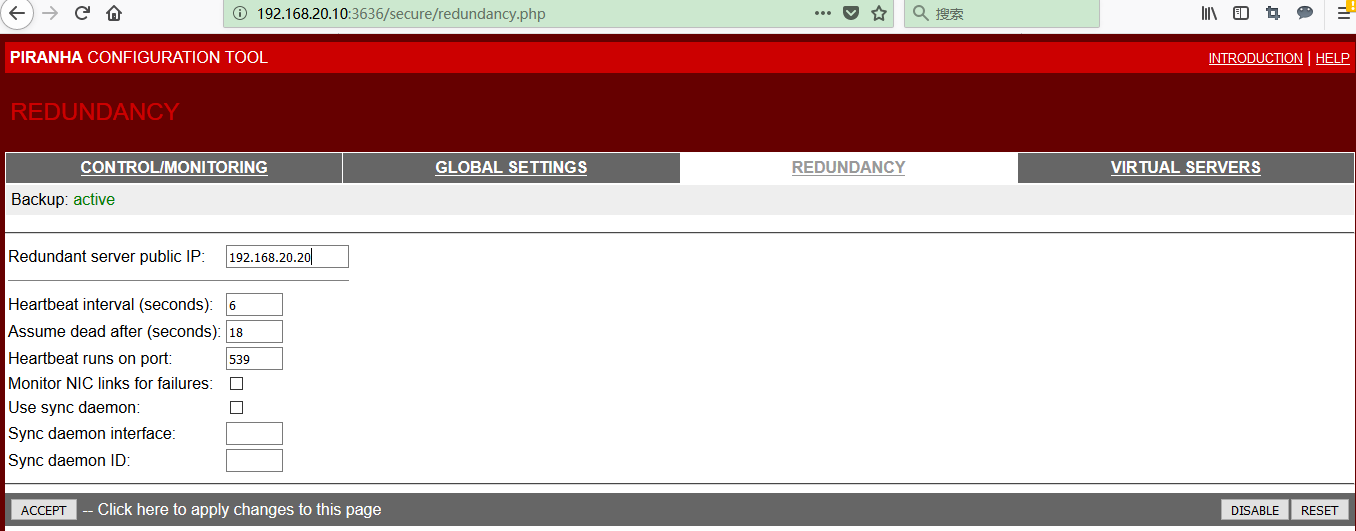

5.3 配置lvs02

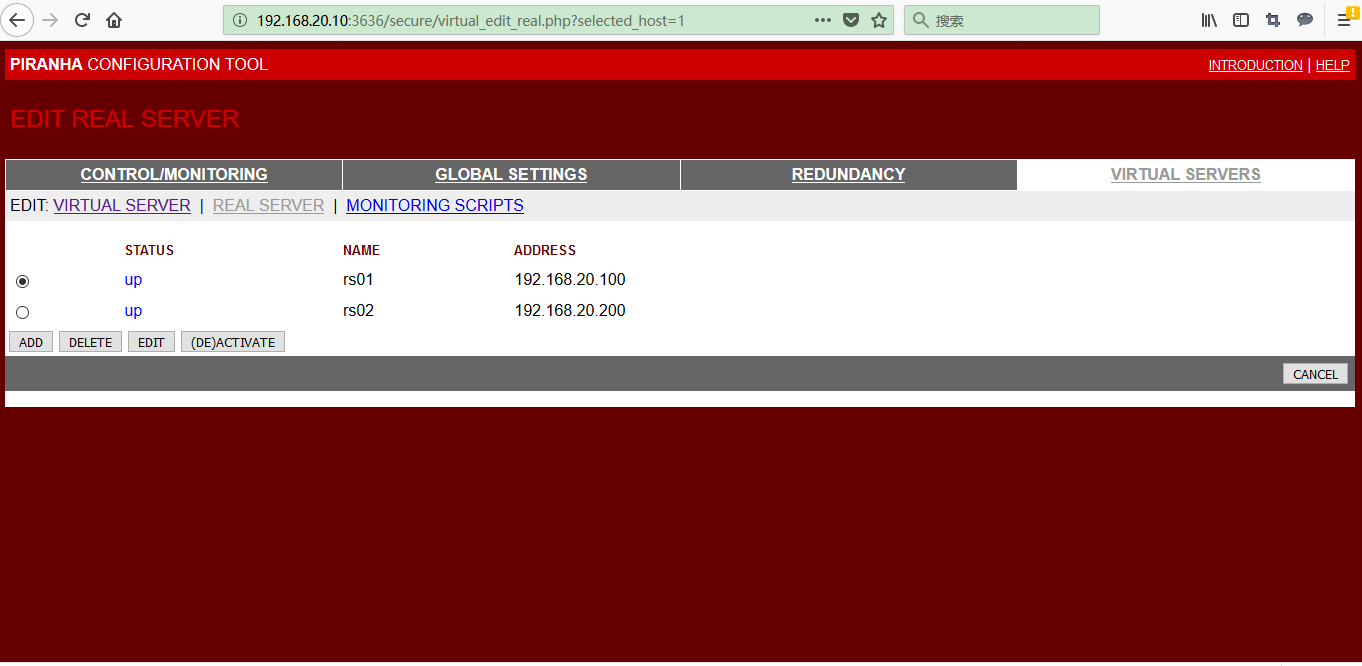

5.4 配置对外服务和真实服务器

5.5 将在lvs01 上的配置文件复制到lvs02 上,在lvs01,lvs02 上启动负载均衡的监控进程

[root@lvs01 ~]# scp /etc/sysconfig/ha/lvs.cf lvs02:/etc/sysconfig/ha/lvs.cf

root@lvs02's password:

lvs.cf 100% 865 0.8KB/s 00:00

[root@lvs01 ~]# /etc/init.d/pulse restart

Shutting down pulse: [失败]

Starting pulse: [确定]

[root@lvs01 ~]# chkconfig pulse on

[root@lvs02 ~]# /etc/init.d/pulse restart

Shutting down pulse: [失败]

Starting pulse: [确定]

[root@lvs02 ~]# chkconfig pulse on

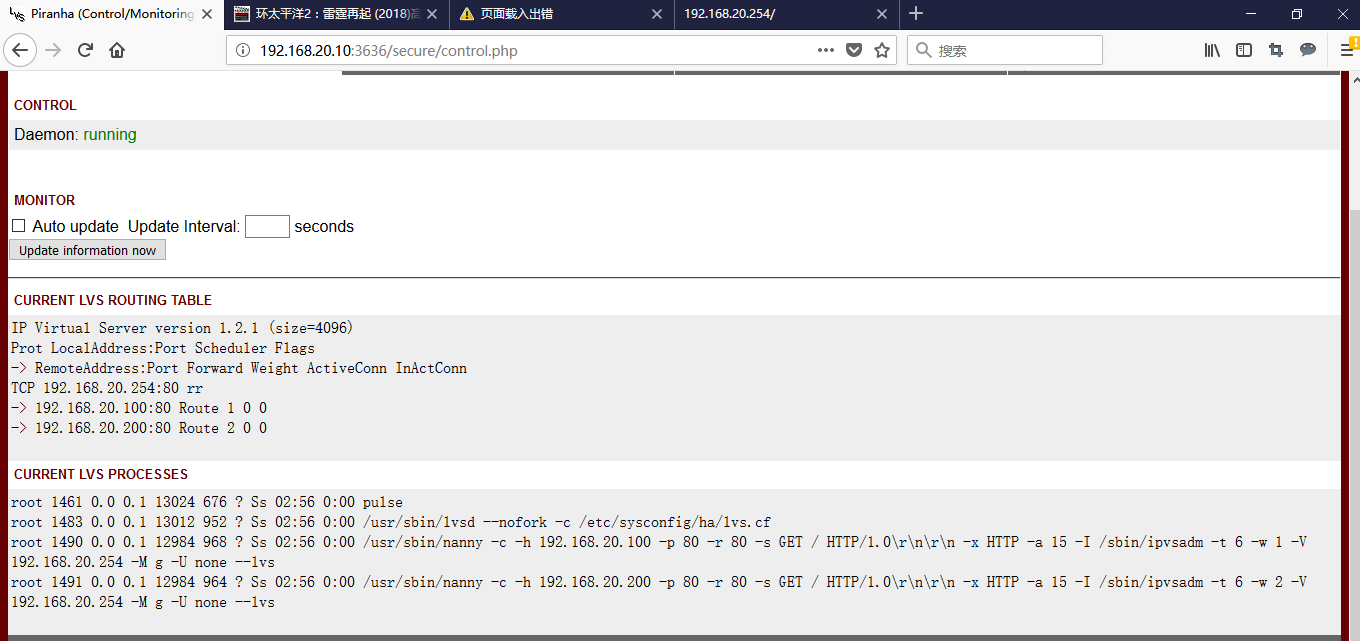

5.6 lvs 正常运行的状态

1、 测试

3.1 正常访问

3.2 lvs01 宕机了,可以正常访问

3.3 rs01 宕机了,也可正常访问

lvs-dr 模式-piranha的更多相关文章

- LVS DR模式 负载均衡服务搭建

LVS 负载均衡 最近在研究服务器负载均衡,阅读了网上的一些资料,发现主要的软件负载均衡方案有nginx(针对HTTP服务的负载均衡),LVS(针对IP层,MAC层的负载均衡).LVS模式工作在网络层 ...

- 一个公网地址部署LVS/DR模式

http://blog.chinaunix.net/uid-7411781-id-3436142.html 一个公网地址部署LVS/DR模式 网上看了很多关于LVS的文章,在选取2种模式LVS/D ...

- LVS DR模式搭建、keepalived+lvs

1.LVS DR模式搭建 条件: 即三台机器,在同一内网. 编辑脚本文件:/usr/local/sbin/lvs_dr.sh #! /bin/bashecho 1 > /proc/sys/net ...

- LVS DR模式搭建 keepalived lvs

LVS DR模式搭建• 三台机器 • 分发器,也叫调度器(简写为dir)172.16.161.130 • rs1 172.16.161.131 • rs2 172.16.161.132 • vip 1 ...

- lvs之 lvs+nginx+tomcat_1、tomcat_2+redis(lvs dr 模式)

前提:已经安装好 lvs+nginx+tomcat_1.tomcat_2+redis环境 ,可参考 (略有改动,比如tomcat_1.tomcat_2安装在两台机器上,而不是单机多实例 ,自行稍稍变动 ...

- CentOS下LVS DR模式负载均衡配置详解

一安装LVS准备: 1.准备4台Centos 6.2 x86_64 注:本实验关闭 SELinux和IPtables防火墙. 管理IP地址 角色 备注 192.168.1.101 LVS主调度器(Ma ...

- Keepalived+LVS DR模式高可用架构实践

Keepalived最初是为LVS设计,专门监控各服务器节点的状态(LVS不带健康检查功能,所以使用keepalived进行健康检查),后来加入了VRRP(虚拟路由热备协议(Virtual Route ...

- Linux centosVMware Linux集群架构LVS DR模式搭建、keepalived + LVS

一.LVS DR模式搭建 三台机器 分发器,也叫调度器(简写为dir) davery :1.101 rs1 davery01:1.106 rs2 davery02:11.107 vip 133.200 ...

- LVS DR模式实验

LVS DR模式实验 三台虚拟机,两个台节点机(Apache),一台DR实验调度机 一:关闭相关安全机制 systemctl stop firewalld iptables -F setenforce ...

- lvs dr 模式请求过程

一. lvs dr 模式请求过程 1.整个请求过程如下: client在发起请求之前,会发一个arp广播的包,在网络中找"谁是vip",由于所有的服务器,lvs和rs都有vip,为 ...

随机推荐

- 线性一致性与全序广播------《Designing Data-Intensive Applications》读书笔记12

上一篇聊了聊构建分布式系统所面临的困难,这篇将着重讨论构建容错分布式系统的算法与协议.构建容错系统的最佳方法是使用通用抽象,允许应用程序忽略分布式系统中的一些问题.本篇我们先聊一聊线性一致性,以及与线 ...

- ajax调用handler,使用HttpWebRequest访问WCF服务

引言 随着手机及移动设备的普及,移动端的应用也进入了热潮.以前PC端的门户网站,大多也均推出了适配移动设备的网站或者APP,再差的也注册了个公众号.在移动应用开发中,目前据我所了解到的解决方案有:1. ...

- [Python Study Notes]cpu信息

''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''''' ...

- CSS常用属性计算原理

absolute: left.right/top.bottom 的百分比值分别根据父元素的 wdith / height 计算 margin: top /right / bottom/ left 的百 ...

- Maven中避开测试环节

两种方法 修改pom文件 添加<skipTests>true</skipTests>标签 <plugin> <groupId>org.apache.ma ...

- 深入cocos2d-x中的touch事件

深入cocos2d-x中的touch事件 在文章cocos2d-x中处理touch事件中简单讨论过怎样处理touch事件, 那么今天来深入了解下cocos2d-x中是怎样分发touch事件的. 我们最 ...

- [bzoj4551][Tjoi2016&Heoi2016]树-树链剖分

Brief Description 给定一颗有根树(根为1),有以下 两种操作:1. 标记操作:对某个结点打上标记(在最开始,只有结点1有标记,其他结点均无标记,而且对于某个 结点,可以打多次标记.) ...

- easyui+ajax获取同表关联的数据

easyui是我们常用的前端框架之一,easyui的使用使得前端页面更加美观.为了能够使用combobox,ajax必须同步. 该小程序是使用ssm框架,对数据库的数据进行查询,所以url对应着map ...

- [翻译] 编写高性能 .NET 代码--第二章 GC -- 将长生命周期对象和大对象池化

将长生命周期对象和大对象池化 请记住最开始说的原则:对象要么立即回收要么一直存在.它们要么在0代被回收,要么在2代里一直存在.有些对象本质是静态的,生命周期从它们被创建开始,到程序停止才会结束.其它对 ...

- Maven常用命令及在Eclipse中的应用

1.常用命令 mvn archetype:generate--构建项目 mvn clean--项目清理 mvn test--项目单元测试的编译 mvn compile--项目源代码的编译 mvn pa ...