[Machine Learning] 单变量线性回归(Linear Regression with One Variable) - 线性回归-代价函数-梯度下降法-学习率

单变量线性回归(Linear Regression with One Variable)

什么是线性回归?线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法(取自 百度百科)。

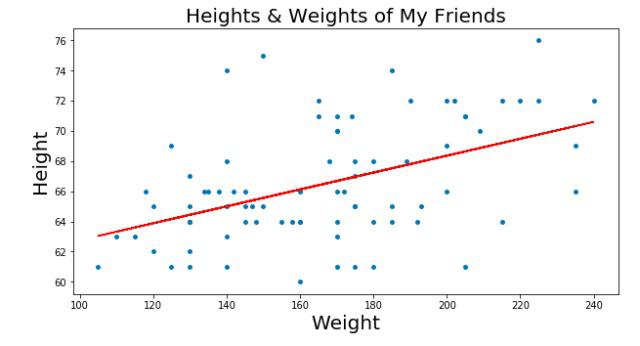

例如:现在有一堆散乱的点,想找出一个一元一次方程来让这些点的分布误差最小(就是找出一条最合适的直线来贯穿这些点)。

图中红色直线就是我们需要找的线。这条直线的表示为: y=ax+b。那么找出a、b这两个变量最合适的值就叫线性回归。

在图片中,蓝色的点用(xi,yi)来表示。m代表所有点的数量。我们的目的就是找出y=ax+b这个直线,实际上就是找出a、b这两个值。

那么如何判断a、b的值是我们需要的呢?我们先假设a、b的值为θ1、θ0,那么假设的直线就为h(x)=θ0+θ1x.我们可以计算所有点到直线的平方误差值来评判是否接近a、b的值。

(图中右式应该再除以 m.)

(图中右式应该再除以 m.)

J(θ) 就表示平方误差,同时J(θ) 也是代价函数。

我们可以不停的给θ1、θ0取值,找出代价函数在所有θ1、θ0情况下最小的值,那么此时的θ1、θ0 就是我们需要找的a、b.

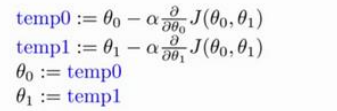

如何来调整θ1、θ0的取值来寻找a、b的值呢?这个时候就需要使用梯度下降法。

梯度下降是一个用来求函数最小值的算法。最直观的方法就是对代价函数求导,来找出J(θ) 的最小值。但是,我们需要的不是最小值,是最小值与之对应的θ1、θ0的值。所有我们对J(θ)求偏导,来获取θ1、θ0的值。

求θ的方法就是:新的θ = θ - θ的偏导*比例。

这里的比例表示的是减小值的缩放,如果没有这个值的话,假设偏导结果很大,那么执行减法的时候就有可能使得新的θ减了一个比正确值大很多的数,从而无法获取正确的值,所以即使减小的步骤多一些也要保证可以获取到正确的结果。

同时这里的比例也叫学习率,同时也是梯度下降法的梯度。

[Machine Learning] 单变量线性回归(Linear Regression with One Variable) - 线性回归-代价函数-梯度下降法-学习率的更多相关文章

- Machine Learning 学习笔记2 - linear regression with one variable(单变量线性回归)

一.Model representation(模型表示) 1.1 训练集 由训练样例(training example)组成的集合就是训练集(training set), 如下图所示, 其中(x,y) ...

- 机器学习-线性回归算法(单变量)Linear Regression with One Variable

1 线性回归算法 http://www.cnblogs.com/wangxin37/p/8297988.html 回归一词指的是,我们根据之前的数据预测出一个准确的输出值,对于这个例子就是价格,回归= ...

- 单变量线性回归(Linear Regression with One Variable)与代价函数

所谓的单变量线性回归问题就是监督学习的一部分. 通过构建数学模型给出一个相对准确的数值,也就是预测模型,通过将数据通过数学模型,衍生至回归问题 通过以下的几个例子,我们来研究单变量线性回归. 1.王阿 ...

- 机器学习 (一) 单变量线性回归 Linear Regression with One Variable

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang的个人笔 ...

- Ng第二课:单变量线性回归(Linear Regression with One Variable)

二.单变量线性回归(Linear Regression with One Variable) 2.1 模型表示 2.2 代价函数 2.3 代价函数的直观理解 2.4 梯度下降 2.5 梯度下 ...

- 斯坦福第二课:单变量线性回归(Linear Regression with One Variable)

二.单变量线性回归(Linear Regression with One Variable) 2.1 模型表示 2.2 代价函数 2.3 代价函数的直观理解 I 2.4 代价函数的直观理解 I ...

- machine learning(14) --Regularization:Regularized linear regression

machine learning(13) --Regularization:Regularized linear regression Gradient descent without regular ...

- Stanford机器学习---第二讲. 多变量线性回归 Linear Regression with multiple variable

原文:http://blog.csdn.net/abcjennifer/article/details/7700772 本栏目(Machine learning)包括单参数的线性回归.多参数的线性回归 ...

- Coursera《machine learning》--(2)单变量线性回归(Linear Regression with One Variable)

本笔记为Coursera在线课程<Machine Learning>中的单变量线性回归章节的笔记. 2.1 模型表示 参考视频: 2 - 1 - Model Representation ...

随机推荐

- Rest Framework:序列化组件

Django内置的serializers(把对象序列化成json字符串 from django.core import serializers def test(request): book_list ...

- 冲刺随笔——Day_Nine

这个作业属于哪个课程 软件工程 (福州大学至诚学院 - 计算机工程系) 这个作业要求在哪里 团队作业第五次--Alpha冲刺 这个作业的目标 团队进行Alpha冲刺 作业正文 正文 其他参考文献 无 ...

- 2020.11.30【NOIP提高A组】模拟赛反思

90,rk42 T1 考试的时候觉得可以贪心,就每次找到最大的,然后以它为根去遍历每个子树,求出其最大值,然后删去这个点.一直持续直到边删完,时间复杂度\(O(n^2)\),然后想了想链的情况,没有打 ...

- moviepy音视频剪辑:headblur的参数r_blur卷积核以及fx、fy、r_zone的功能作用及用途

☞ ░ 前往老猿Python博文目录 ░ 在moviepy1.03版本中,headblur的调用语法为:headblurbak(clip,fx,fy,r_zone,r_blur=None) 其中参数f ...

- 第十章、Qt Designer中的Spacers部件

老猿Python博文目录 专栏:使用PyQt开发图形界面Python应用 老猿Python博客地址 一. 引言 在Designer的部件栏中,有两种类型的Spacers部件,下图中上面布局中为一个水平 ...

- Shiro remeberMe反序列化漏洞复现(Shiro-550)

Apache Shiro是一个强大易用的Java安全框架,提供了认证.授权.加密和会话管理等功能.Shiro框架直观.易用,同时也能提供健壮的安全性.在Apache Shiro编号为550的 issu ...

- MySQL日期和时间函数汇总

本文基于MySQL8.0 本文介绍MySQL关于日期和时间操作的函数. 日期和时间函数 函数 描述 ADDDATE() 给日期值添加时间值 ADDTIME() 添加time CONVERT_TZ() ...

- 威联通(NAS)搭建个人音乐中心

我为什么要自己搭建音乐服务 曾记得早些年,音乐是可以随便在线听,随便下载的,没有付费这么一说的(背后是音乐平台提供的版权支持).我们听音乐也就可以很随意,但是这几年,音乐的版权开始管理的严禁,音乐没地 ...

- C++ 虚函数表与多态 —— 关键字 final 的用法

final 字面上最终.最后.不可改变的意思,final 这个关键字在 Jave PHP C++中都有用到,其作用也基本一致. C++中的 final 是C++11新增,他可以用来修饰类,让类无法被继 ...

- GaussDB(DWS)应用实践丨负载管理与作业排队处理方法

摘要:本文用来总结一些GaussDB(DWS)在实际应用过程中,可能出现的各种作业排队的情况,以及出现排队时,我们应该怎么去判断是否正常,调整一些参数,让资源分配与负载管理更符合当前的业务:或者在作业 ...