Spark环境搭建(四)-----------数据仓库Hive环境搭建

Hive产生背景

1)MapReduce的编程不便,需通过Java语言等编写程序

2) HDFS上的文缺失Schema(在数据库中的表名列名等),方便开发者通过SQL的方式处理结构化的数据,而不需要Java等编写程序

Hive是什么

1)facebook开源,最初为解决海量的结构化日志数据统计问题

2)构建中Hadoop上的数据仓库

3)Hive定义了一种SQL查询语言:HQL(类似SQl但又不完全相同)

4)通常进行离线处理(采用MapReduce)

5)多种不同的底层执行引擎(Hive on MapReduce/Tez/Spark)

6)支持多种不同的压缩格式,存储格式以及自定义函数

压缩格式:GZIP,LZO,Snappy,BZIP2..

存储格式:TextFile,SequenceFile,RCFile,ORC,PARquet

UDF:自定义函数

为什么使用Hive

1) 简单,容易上手(提供了类似SQL查询语言HQL)

2) 为超大数据集设计的计算、存储扩展能力(MR计算,HDFS存储)

3) 统一的元数据管理(可与Presto/Impala/SparkSQL等共享数据)

Hive环境搭建

1)使用版本:hive-1.1.0-cdh5.7.0.tar.gz

2) 下载:

wget http://archive.cloudera.com/cdh5/cdh/5/

3)解压:tar -zxvf hive-1.1.0-cdh5.7.0.tar.gz -C ~/app/

4)配置

(1) 系统环境变量(~/.bash_profile)

export HIVE_HOME=/root/app/hive-1.1.0-cdh5.7.0 export PATH=$HIVE_HOME/bin:$PATH

(2) 安装一个Mysql (可以参考我这篇博文)

命令 yum install ***

(3) 在conf下新建一个 hive-site.xml

插入以下内容

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/sparksql?createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property> <property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property> <property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>root</value>

</property

</configuration>

其中需要填写你的数据库用户名和密码以及连接数据库的驱动

(4) 拷贝数据库驱动(点击这里下载)到$HIVE_HOME/lib/下

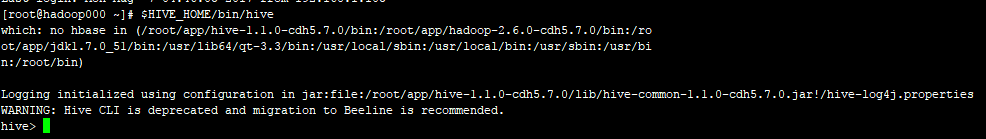

(5) 启动Hive

命令: $HIVE_HOME/bin/hive

没有报错,至此Hive环境搭建完毕

Spark环境搭建(四)-----------数据仓库Hive环境搭建的更多相关文章

- 《OD大数据实战》Hive环境搭建

一.搭建hadoop环境 <OD大数据实战>hadoop伪分布式环境搭建 二.Hive环境搭建 1. 准备安装文件 下载地址: http://archive.cloudera.com/cd ...

- Hadoop环境搭建|第四篇:hive环境搭建

一.环境搭建 注意:hive版本不能太高,否则会出现兼容性问题 1.1.上传hive安装包 创建文件夹用于存放hive文件命令:mkdir hive 1.2.解压hive安装包 命令:tar -zxv ...

- 数据仓库组件:Hive环境搭建和基础用法

本文源码:GitHub || GitEE 一.Hive基础简介 1.基础描述 Hive是基于Hadoop的一个数据仓库工具,用来进行数据提取.转化.加载,是一个可以对Hadoop中的大规模存储的数据进 ...

- Hadoop生态圈-Hive快速入门篇之Hive环境搭建

Hadoop生态圈-Hive快速入门篇之Hive环境搭建 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.数据仓库(理论性知识大多摘自百度百科) 1>.什么是数据仓库 数据 ...

- 基于【CentOS-7+ Ambari 2.7.0 + HDP 3.0】搭建HAWQ数据仓库01 —— 准备环境,搭建本地仓库,安装ambari

一.集群软硬件环境准备: 操作系统: centos 7 x86_64.1804 Ambari版本:2.7.0 HDP版本:3.0.0 HAWQ版本:2.3.05台PC作为工作站: ep-bd01 e ...

- ubantu上搭建hive环境

上次我们在ubantu上安装了hadoop,那我们现在再进一步,开始我们的学习之旅--hive板块吧! 第一步:准备! 软件: I.一个搭建好的hadoop环境 II.hive的bin文件(前往apa ...

- Hive环境搭建和SparkSql整合

一.搭建准备环境 在搭建Hive和SparkSql进行整合之前,首先需要搭建完成HDFS和Spark相关环境 这里使用Hive和Spark进行整合的目的主要是: 1.使用Hive对SparkSql中产 ...

- 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机)

引言 在大数据学习系列之一 ----- Hadoop环境搭建(单机) 成功的搭建了Hadoop的环境,在大数据学习系列之二 ----- HBase环境搭建(单机)成功搭建了HBase的环境以及相关使用 ...

- Hive环境搭建

hive 环境搭建需要hadoop的环境.hadoop环境的搭建不在这里赘述.参考:http://www.cnblogs.com/parkin/p/6952370.html 1.准备阶段 hive 官 ...

随机推荐

- macOS Mojave待机耗电大

这很有可能是待机时依然链接网络导致的.如果不需要待机时链接网络可以执行 sudo pmset -a tcpkeepalive 0 恢复则执行 sudo pmset -a tcpkeepalive 1

- deepin安装mysql记录

本文转载自http://www.linuxidc.com/Linux/2016-07/133128.htm sudo apt-get install mysql-server apt-get isnt ...

- pandas常用函数之diff

diff函数是用来将数据进行某种移动之后与原数据进行比较得出的差异数据,举个例子,现在有一个DataFrame类型的数据df,如下: index value1 A 0 B 1 C 2 D 3 如果执行 ...

- Pandas系列(三)-缺失值处理

内容目录 1. 什么是缺失值 2. 丢弃缺失值 3. 填充缺失值 4. 替换缺失值 5. 使用其他对象填充 数据准备 import pandas as pd import numpy as np in ...

- win7 远程连接服务器出现身份验证错误,又找不到加密Oracle修正

今天想用远程桌面连接登录服务器,结果,弹出一个错误的提示框:发生身份验证错误,要求的函数不受支持. 然后在网上找了相关的教程,基本上所有的方法都是如下所示: 策略路径:"计算机配置" ...

- 《11招玩转网络安全》之第一招:Docker For Docker

玩转黑客那些工具,缺少了虚拟机怎么行,除了用虚拟机虚拟整个系统,Docker也不能缺少,读者只需要知道,Docker只虚拟Linux系统中的某个程序就可以了.本节就来介绍Linux下安装设置Docke ...

- java8 list统计(求和、最大、最小、平均)

list.stream().mapToDouble(User::getHeight).sum()//和 list.stream().mapToDouble(User::getHeight).max() ...

- 设计模式七: 策略(Strategy)

简介 策略属于行为型模式的一种,策略模式允许对象的行为或算法在运行时改变,使用不同的算法达成相同的结果或目的. 实现层面上,定义一个抽象的算法接口, 然后根据具体算法的不同定义不同的类去实现该接口, ...

- Django 内置分页器

先导入Django内置的分页器 在商品列表页或者购物车列表页导入 在渲染list.html导入 然后在views后台渲染方法写入 打开list页面结果

- DCM、PLL、PMCD、MMCM相关

摘自网上 : http://xilinx.eetop.cn/viewnews-1482 The DCM is a Digital Clock Manager - at its heart it is ...