webmagic 增量爬取

webmagic 是一个很好并且很简单的爬虫框架,其教程网址:http://my.oschina.net/flashsword/blog/180623

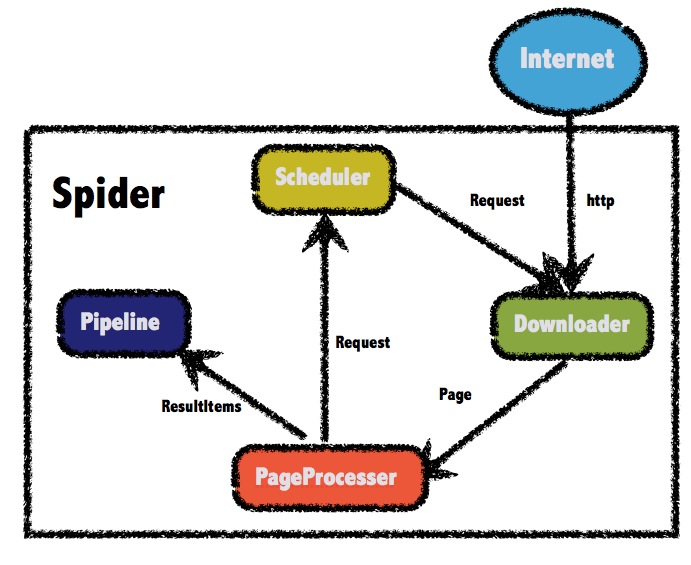

webmagic参考了scrapy的模块划分,分为Spider(整个爬虫的调度框架)、Downloader(页面下载)、PageProcessor(链接提取和页面分析)、Scheduler(URL管理)、Pipeline(离线分析和持久化)几部分。只不过scrapy通过middleware实现扩展,而webmagic则通过定义这几个接口,并将其不同的实现注入主框架类Spider来实现扩展。

关于Scheduler(URL管理) 最基本的功能是实现对已经爬取的URL进行标示。

目前scheduler有三种实现方式:

1)内存队列

2)文件队列

3)redis队列

文件队列保存URL,能实现中断后,继续爬取时,实现增量爬取。

如果我只有一个主页的URL,比如:http://www.cndzys.com/yundong/。如果直接引用webmagic的FileCacheQueueScheduler的话,你会发现第二次启动的时候,什么也爬不到。可以说第二次启动基本不爬取数据了。因为FileCacheQueueScheduler 把http://www.cndzys.com/yundong/ 记录了,然后不再进行新的爬取。虽然是第二次增量爬取,但还是需要保留某些URL重新爬取,以保证爬取结果是我们想要的。我们可以重写FileCacheQueueScheduler里的比较方法。

package com.fortunedr.crawler.expertadvice; import java.io.BufferedReader;

import java.io.Closeable;

import java.io.File;

import java.io.FileNotFoundException;

import java.io.FileReader;

import java.io.FileWriter;

import java.io.IOException;

import java.io.PrintWriter;

import java.util.LinkedHashSet;

import java.util.Set;

import java.util.concurrent.BlockingQueue;

import java.util.concurrent.Executors;

import java.util.concurrent.LinkedBlockingQueue;

import java.util.concurrent.ScheduledExecutorService;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.atomic.AtomicBoolean;

import java.util.concurrent.atomic.AtomicInteger; import org.apache.commons.io.IOUtils;

import org.apache.commons.lang3.math.NumberUtils; import us.codecraft.webmagic.Request;

import us.codecraft.webmagic.Task;

import us.codecraft.webmagic.scheduler.DuplicateRemovedScheduler;

import us.codecraft.webmagic.scheduler.MonitorableScheduler;

import us.codecraft.webmagic.scheduler.component.DuplicateRemover; /**

* Store urls and cursor in files so that a Spider can resume the status when shutdown.<br>

*增加去重的校验,对需要重复爬取的网址进行正则过滤

* @author code4crafter@gmail.com <br>

* @since 0.2.0

*/

public class SpikeFileCacheQueueScheduler extends DuplicateRemovedScheduler implements MonitorableScheduler,Closeable { private String filePath = System.getProperty("java.io.tmpdir"); private String fileUrlAllName = ".urls.txt"; private Task task; private String fileCursor = ".cursor.txt"; private PrintWriter fileUrlWriter; private PrintWriter fileCursorWriter; private AtomicInteger cursor = new AtomicInteger(); private AtomicBoolean inited = new AtomicBoolean(false); private BlockingQueue<Request> queue; private Set<String> urls; private ScheduledExecutorService flushThreadPool; private String regx; public SpikeFileCacheQueueScheduler(String filePath) {

if (!filePath.endsWith("/") && !filePath.endsWith("\\")) {

filePath += "/";

}

this.filePath = filePath;

initDuplicateRemover();

} private void flush() {

fileUrlWriter.flush();

fileCursorWriter.flush();

} private void init(Task task) {

this.task = task;

File file = new File(filePath);

if (!file.exists()) {

file.mkdirs();

}

readFile();

initWriter();

initFlushThread();

inited.set(true);

logger.info("init cache scheduler success");

} private void initDuplicateRemover() {

setDuplicateRemover(

new DuplicateRemover() {

@Override

public boolean isDuplicate(Request request, Task task) {

if (!inited.get()) {

init(task);

}

boolean temp=false;

String url=request.getUrl();

temp=!urls.add(url);//原来验证URL是否存在

//正则匹配

if(url.matches(regx)){//二次校验,如果符合我们需要重新爬取的,返回false。可以重新爬取

temp=false;

}

return temp;

} @Override

public void resetDuplicateCheck(Task task) {

urls.clear();

} @Override

public int getTotalRequestsCount(Task task) {

return urls.size();

}

});

} private void initFlushThread() {

flushThreadPool = Executors.newScheduledThreadPool(1);

flushThreadPool.scheduleAtFixedRate(new Runnable() {

@Override

public void run() {

flush();

}

}, 10, 10, TimeUnit.SECONDS);

} private void initWriter() {

try {

fileUrlWriter = new PrintWriter(new FileWriter(getFileName(fileUrlAllName), true));

fileCursorWriter = new PrintWriter(new FileWriter(getFileName(fileCursor), false));

} catch (IOException e) {

throw new RuntimeException("init cache scheduler error", e);

}

} private void readFile() {

try {

queue = new LinkedBlockingQueue<Request>();

urls = new LinkedHashSet<String>();

readCursorFile();

readUrlFile();

// initDuplicateRemover();

} catch (FileNotFoundException e) {

//init

logger.info("init cache file " + getFileName(fileUrlAllName));

} catch (IOException e) {

logger.error("init file error", e);

}

} private void readUrlFile() throws IOException {

String line;

BufferedReader fileUrlReader = null;

try {

fileUrlReader = new BufferedReader(new FileReader(getFileName(fileUrlAllName)));

int lineReaded = 0;

while ((line = fileUrlReader.readLine()) != null) {

urls.add(line.trim());

lineReaded++;

if (lineReaded > cursor.get()) {

queue.add(new Request(line));

}

}

} finally {

if (fileUrlReader != null) {

IOUtils.closeQuietly(fileUrlReader);

}

}

} private void readCursorFile() throws IOException {

BufferedReader fileCursorReader = null;

try {

fileCursorReader = new BufferedReader(new FileReader(getFileName(fileCursor)));

String line;

//read the last number

while ((line = fileCursorReader.readLine()) != null) {

cursor = new AtomicInteger(NumberUtils.toInt(line));

}

} finally {

if (fileCursorReader != null) {

IOUtils.closeQuietly(fileCursorReader);

}

}

} public void close() throws IOException {

flushThreadPool.shutdown();

fileUrlWriter.close();

fileCursorWriter.close();

} private String getFileName(String filename) {

return filePath + task.getUUID() + filename;

} @Override

protected void pushWhenNoDuplicate(Request request, Task task) {

queue.add(request);

fileUrlWriter.println(request.getUrl());

} @Override

public synchronized Request poll(Task task) {

if (!inited.get()) {

init(task);

}

fileCursorWriter.println(cursor.incrementAndGet());

return queue.poll();

} @Override

public int getLeftRequestsCount(Task task) {

return queue.size();

} @Override

public int getTotalRequestsCount(Task task) {

return getDuplicateRemover().getTotalRequestsCount(task);

} public String getRegx() {

return regx;

}

/**

* 设置保留需要重复爬取url的正则表达式

* @param regx

*/

public void setRegx(String regx) {

this.regx = regx;

} }

那么在爬虫时就引用自己特定的FileCacheQueueScheduler就可以

spider.addRequest(requests);

SpikeFileCacheQueueScheduler file=new SpikeFileCacheQueueScheduler(filePath);

file.setRegx(regx);//http://www.cndzys.com/yundong/(index)?[0-9]*(.html)?

spider.setScheduler(file );

这样就实现了增量爬取。

优化的想法:一般某个网站的内容列表都是首页是最新内容。上面的方式是可以实现增量爬取,但是还是需要爬取很多“无用的”列表页面。

能不能实现,当爬取到上次"最新"URL之后就不再爬取。就是不用爬取其他多余的leib

webmagic 增量爬取的更多相关文章

- scrapy增量爬取

开始接触爬虫的时候还是初学Python的那会,用的还是request.bs4.pandas,再后面接触scrapy做个一两个爬虫,觉得还是框架好,可惜都没有记录都忘记了,现在做推荐系统需要爬取一定的 ...

- scrapy过滤重复数据和增量爬取

原文链接 前言 这篇笔记基于上上篇笔记的---<scrapy电影天堂实战(二)创建爬虫项目>,而这篇又涉及redis,所以又先熟悉了下redis,记录了下<redis基础笔记> ...

- 使用scrapy实现去重,使用Redis实现增量爬取

面试场景: 要求对正在爬取的内容与mysql数据库中的数据进行比较去重 解决方式: 通过Redis来作为中间件,通过url来确保爬过的数据不会再爬,做到增量爬取. Redis数据库其实就是一个中间件, ...

- nutch的定时增量爬取

译文来着: http://wiki.apache.org/nutch/Crawl 介绍(Introduction) 注意:脚本中没有直接使用Nutch的爬去命令(bin/nutch crawl或者是& ...

- Java爬虫框架WebMagic入门——爬取列表类网站文章

初学爬虫,WebMagic作为一个Java开发的爬虫框架很容易上手,下面就通过一个简单的小例子来看一下. WebMagic框架简介 WebMagic框架包含四个组件,PageProcessor.Sch ...

- 爬虫——爬取Ajax动态加载网页

常见的反爬机制及处理方式 1.Headers反爬虫 :Cookie.Referer.User-Agent 解决方案: 通过F12获取headers,传给requests.get()方法 2.IP限制 ...

- python爬取智联招聘职位信息(单进程)

我们先通过百度搜索智联招聘,进入智联招聘官网,一看,傻眼了,需要登录才能查看招聘信息 没办法,用账号登录进去,登录后的网页如下: 输入职位名称点击搜索,显示如下网页: 把这个URL:https://s ...

- 基于webmagic的爬虫小应用--爬取知乎用户信息

听到“爬虫”,是不是第一时间想到Python/php ? 多少想玩爬虫的Java学习者就因为语言不通而止步.Java是真的不能做爬虫吗? 当然不是. 只不过python的3行代码能解决的问题,而Jav ...

- webmagic爬取渲染网站

最近突然得知之后的工作有很多数据采集的任务,有朋友推荐webmagic这个项目,就上手玩了下.发现这个爬虫项目还是挺好用,爬取静态网站几乎不用自己写什么代码(当然是小型爬虫了~~|). 好了,废话少说 ...

随机推荐

- 关于android的日志输出&LogCat

android提供了自己的log输出api-->位于android.util.Log这个类中. 这个类比较常用的打印日志的方法有5个,这5个方法都会把日志打印到LogCat中: Log.v(ta ...

- js鼠标滚轮事件

不多说,直接上代码. //非ie document.body.onmousewheel = function(event) { event = event || window.event; conso ...

- 使用好压(HaoZip)软件打包EverEdit制作安装程序

最近使用EverEdit,使用原始的安装程序安装后,需要重新安装插件,对配置文件进行了修改,定制了工具栏.将安装后的程序目录进行打包,制作新的安装包,便于携带. 以下为打包制作过程: 打包原料:Eve ...

- BI领导驾驶舱的功能特点

随着企业的信息化能力越来越强,商业智能(BI)对他们而言已不仅仅是数据展现的工具.商业智能必须能够与企业的业务流程相联系,做企业随需随用的“战略军师”.“BI领导驾驶舱”的出现无疑顺应了BI的发展趋势 ...

- AngularJS笔记---注册服务

在前面的笔记中,了解到AngularJS的后台控制可以在Controller里面实现. 可是如果所有的逻辑代码都写到Controller会显得该Controller过于臃肿. 不方便维护, Angul ...

- [excel玩转表格教程][1G][AVI]

[excel玩转表格教程][1G][AVI] 下载地址 :http://www.fu83.cn/thread-222-1-1.html

- CF219D. Choosing Capital for Treeland [树形DP]

D. Choosing Capital for Treeland time limit per test 3 seconds memory limit per test 256 megabytes i ...

- MAVEN构建Spring +Spring mvc + Mybatis 项目(Maven配置部分(workshop))

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/20 ...

- Spring事务管理----声明式:利用TransactionProxyFactoryBean生成事务代理

通常建议采用声明式事务管理.声明式事务管理的优势非常明显:代码中无需关于关注事务逻辑,让spring声明式事务管理负责事务逻辑,声明式事务管理无需与具体的事务逻辑耦合,可以方便地在不同事务逻辑之间切换 ...

- 概率dp学习

预备知识 一.期望的数学定义 如果X 是一个离散的随机变量,输出值为 x1, x2, ..., 和输出值相应的概率为p1, p2, ... (概率和为 1), 那么期望值为E(x)=x1p1+x2p2 ...