「Flink」使用Managed Keyed State实现计数窗口功能

先上代码:

public class WordCountKeyedState {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

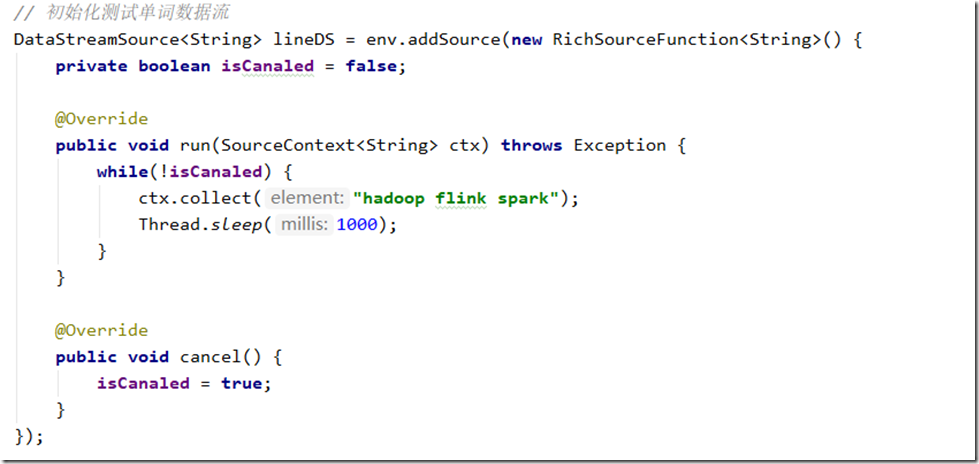

// 初始化测试单词数据流

DataStreamSource<String> lineDS = env.addSource(new RichSourceFunction<String>() {

private boolean isCanaled = false;

@Override

public void run(SourceContext<String> ctx) throws Exception {

while(!isCanaled) {

ctx.collect("hadoop flink spark");

Thread.sleep(1000);

}

}

@Override

public void cancel() {

isCanaled = true;

}

});

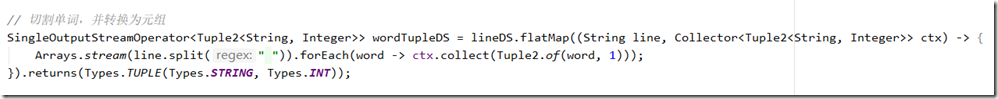

// 切割单词,并转换为元组

SingleOutputStreamOperator<Tuple2<String, Integer>> wordTupleDS = lineDS.flatMap((String line, Collector<Tuple2<String, Integer>> ctx) -> {

Arrays.stream(line.split(" ")).forEach(word -> ctx.collect(Tuple2.of(word, 1)));

}).returns(Types.TUPLE(Types.STRING, Types.INT));

// 按照单词进行分组

KeyedStream<Tuple2<String, Integer>, Integer> keyedWordTupleDS = wordTupleDS.keyBy(t -> t.f0);

// 对单词进行计数

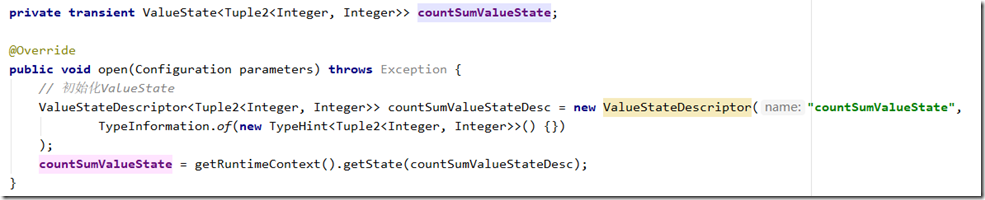

keyedWordTupleDS.flatMap(new RichFlatMapFunction<Tuple2<String, Integer>, Tuple2<String, Integer>>() {

private transient ValueState<Tuple2<Integer, Integer>> countSumValueState;

@Override

public void open(Configuration parameters) throws Exception {

// 初始化ValueState

ValueStateDescriptor<Tuple2<Integer, Integer>> countSumValueStateDesc = new ValueStateDescriptor("countSumValueState",

TypeInformation.of(new TypeHint<Tuple2<Integer, Integer>>() {})

);

countSumValueState = getRuntimeContext().getState(countSumValueStateDesc);

}

@Override

public void flatMap(Tuple2<String, Integer> value, Collector<Tuple2<String, Integer>> out) throws Exception {

if(countSumValueState.value() == null) {

countSumValueState.update(Tuple2.of(0, 0));

}

Integer count = countSumValueState.value().f0;

count++;

Integer valueSum = countSumValueState.value().f1;

valueSum += value.f1;

countSumValueState.update(Tuple2.of(count, valueSum));

// 每当达到3次,发送到下游

if(count > 3) {

out.collect(Tuple2.of(value.f0, valueSum));

// 清除计数

countSumValueState.update(Tuple2.of(0, valueSum));

}

}

}).print();

env.execute("KeyedState State");

}

}

代码说明:

1、构建测试数据源,每秒钟发送一次文本,为了测试方便,这里就发一个包含三个单词的文本行

2、对句子按照空格切分,并将单词转换为元组,每个单词初始出现的次数为1

3、按照单词进行分组

4、自定义FlatMap

初始化ValueState,注意:ValueState只能在KeyedStream中使用,而且每一个ValueState都对一个一个key。每当一个并发处理ValueState,都会从上下文获取到Key的取值,所以每个处理逻辑拿到的ValueStated都是对应指定key的ValueState,这个部分是由Flink自动完成的。

注意:

带默认初始值的ValueStateDescriptor已经过期了,官方推荐让我们手动在处理时检查是否为空

instead and manually manage the default value by checking whether the contents of the state is null.

”

/**

* Creates a new {@code ValueStateDescriptor} with the given name, default value, and the specific

* serializer.

*

* @deprecated Use {@link #ValueStateDescriptor(String, TypeSerializer)} instead and manually

* manage the default value by checking whether the contents of the state is {@code null}.

*

* @param name The (unique) name for the state.

* @param typeSerializer The type serializer of the values in the state.

* @param defaultValue The default value that will be set when requesting state without setting

* a value before.

*/

@Deprecated

public ValueStateDescriptor(String name, TypeSerializer<T> typeSerializer, T defaultValue) {

super(name, typeSerializer, defaultValue);

}

5、逻辑实现

在flatMap逻辑中判断ValueState是否已经初始化,如果没有手动给一个初始值。并进行累加后更新。每当count > 3发送计算结果到下游,并清空计数。

「Flink」使用Managed Keyed State实现计数窗口功能的更多相关文章

- Flink状态专题:keyed state和Operator state

众所周知,flink是有状态的计算.所以学习flink不可不知状态. 正好最近公司有个需求,要用到flink的状态计算,需求是这样的,收集数据库新增的数据. ...

- 「Flink」Flink的状态管理与容错

在Flink中的每个函数和运算符都是有状态的.在处理过程中可以用状态来存储数据,这样可以利用状态来构建复杂操作.为了让状态容错,Flink需要设置checkpoint状态.Flink程序是通过chec ...

- 「Flink」Flink 1.9 WebUI运行作业界面分析

运行作业界面 在以下界面中,可以查看到作业的名称.作业的启动时间.作业总计运行时长.作业一共有多少个任务.当前正在运行多少个任务.以及作业的当前状态. 这里的程序:一共有17个任务,当前正在运行的是1 ...

- 「Flink」事件时间与水印

我们先来以滚动时间窗口为例,来看一下窗口的几个时间参数与Flink流处理系统时间特性的关系. 获取窗口开始时间Flink源代码 获取窗口的开始时间为以下代码: org.apache.flink.str ...

- 「Flink」Flink中的时间类型

Flink中的时间类型和窗口是非常重要概念,是学习Flink必须要掌握的两个知识点. Flink中的时间类型 时间类型介绍 Flink流式处理中支持不同类型的时间.分为以下几种: 处理时间 Flink ...

- 「Flink」RocksDB介绍以及Flink对RocksDB的支持

RocksDB介绍 RocksDB简介 RocksDB是基于C++语言编写的嵌入式KV存储引擎,它不是一个分布式的DB,而是一个高效.高性能.单点的数据库引擎.它是由Facebook基于Google开 ...

- 「Flink」理解流式处理重要概念

什么是流式处理呢? 这个问题其实我们大部分时候是没有考虑过的,大多数,我们是把流式处理和实时计算放在一起来说的.我们先来了解下,什么是数据流. 数据流(事件流) 数据流是无边界数据集的抽象 我们之前接 ...

- 「Flink」配置使用Flink调试WebUI

很多时候,我们在IDE中编写Flink代码,我们希望能够查看到Web UI,从而来了解Flink程序的运行情况.按照以下步骤操作即可,亲测有效. 1.添加Maven依赖 <dependency& ...

- 「Flink」使用Java lambda表达式实现Flink WordCount

本篇我们将使用Java语言来实现Flink的单词统计. 代码开发 环境准备 导入Flink 1.9 pom依赖 <dependencies> <dependency> < ...

随机推荐

- HCNA网络技术学习指南

网络通信基础 网络与通信 OSI模型和TCP/IP模型 网络类型 传输介质及通信方式 2 VRP基础 VRP简介 VRP命令行 登录设备 基本配置 配置文件管理 通过Telnet登录设备 文件管理 基 ...

- 01--java--语言概述

啦啦啦~~~我又开始想学习了...第一次学Java... JAVA主要版本 1.Java SE(java Platform,Standard Edition) java SE以前称为J2SE.它允许开 ...

- 富文本编辑器、全文检索和django发送邮件

1.富文本编辑器 1.1快速了解 借助富文本编辑器,网站的编辑人员能够像使用offfice一样编写出漂亮的.所见即所得的页面.此处以tinymce为例,其它富文本编辑器的使用也是类似的. 在虚拟环境中 ...

- STM8 ADC 多个通道连续扫描缓冲区数据带中断模式的正确写法

近日调试了STM8S的ADC采集多通道数据的程序,按照之前的立即,将ADC1设置为:扫描模式,连续采集,数据缓存模式,中断使能后应该可以在中断后读取到数值了,可是无论怎样都只能读取到第一个缓冲器的数据 ...

- IDEA更换banner(娱乐专用)

1.佛祖保佑 永无bug _ooOoo_ o8888888o 88" . "88 (| -_- |) O\ = /O ____/`---'\____ .' \\| |// `. / ...

- Spring5.x源码分析 | 从踩坑到放弃之环境搭建

Spring5.x源码分析--从踩坑到放弃之环境搭建 前言 自从Spring发行4.x后,很久没去好好看过Spring源码了,加上最近半年工作都是偏管理和参与设计为主,在技术细节上或多或少有点疏忽,最 ...

- 2020 University Rankings US News(中国)

2020 University Rankings US News(中国)

- Java类加载器和双亲委派机制

前言 之前详细介绍了Java类的整个加载过程(类加载机制详解).虽然,篇幅较长,但是也不要被内容吓到了,其实每个阶段都可以用一句话来概括. 1)加载:查找并加载类的二进制字节流数据. 2)验证:保证被 ...

- React+wangeditor+node富文本处理带图片上传

最近有个需求出现在我的视野中,因为我的另外的博客需要上传文章,但是我不想每次都在我的数据库中慢慢的修改格式,所以我另做了一个后台去编辑文本后发送给服务器,那么这里就涉及到两点,一个是富文本,一个是需要 ...

- java13人机猜拳

public class Demo01 { public static void main(String[] args) { /* * 你同桌和你要玩游戏. * 1 剪刀,2 石头,3 布 */ // ...