urllib模块提供的urlretrieve()函数使用

urllib模块提供的urlretrieve()函数,urlretrieve()方法直接将远程的数据下载到本地

注意:若是网站有反爬虫的话这个函数会返回 403 Forbidden

参数url:传入的网址,网址必须得是个字符串

参数filename:指定了保存本地路径(如果参数未指定,urllib会生成一个临时文件保存数据。)

参数reporthook:是一个回调函数,当连接上服务器、以及相应的数据块传输完毕时会触发该回调,我们可以利用这个回调函数来显示当前的下载进度。

参数data:指 post 到服务器的数据,该方法返回一个包含两个元素的(filename, headers)元组,filename 表示保存到本地的路径,header 表示服务器的响应头。

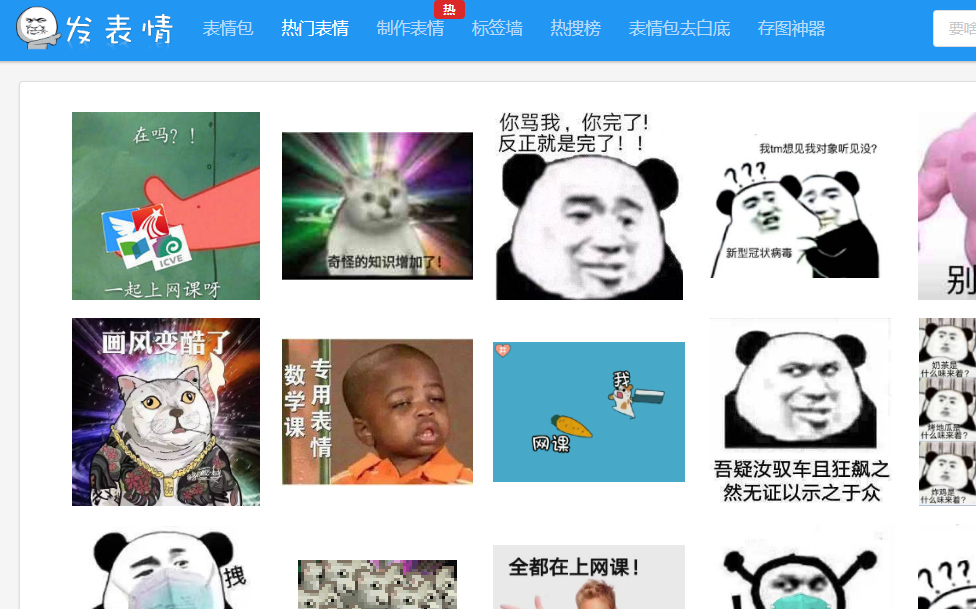

下面例子将表情包下载到本地

import requests

from lxml import etree

from urllib import request

import os

import re def page(url):

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.100 Safari/537.36'

}

res = requests.get(url,headers=headers)

text = res.text

html = etree.HTML(text)

imgs = html.xpath("//div[@class='tagbqppdiv']//img")

for img in imgs:

img_url = img.get('data-original')

alt =img.get('alt')

sufixx = os.path.splitext(img_url)[1]#切割文件后缀名

alt = re.sub(r'[\??\.。\!\!]',"",alt)

filename = alt + sufixx

request.urlretrieve(img_url,r"F:\pacong\hr class\xpath\images\\"+filename)

# print(etree.tostring(img))

# imgs = html.xpath("//div[@class='page-content text-center']//@href")#取出所有href里的链接

#print(text) def main():

for i in range(1,101):

url = 'https://www.fabiaoqing.com/biaoqing/lists/page/%d.html'%i

page(url)

break if __name__ == '__main__':

main()

运行结果:

urllib模块提供的urlretrieve()函数使用的更多相关文章

- Python基础之 urllib模块urlopen()与urlretrieve()的使用方法详解。

Python urllib模块urlopen()与urlretrieve()的使用方法详解 1.urlopen()方法urllib.urlopen(url[, data[, proxies]]) ...

- Python urllib模块urlopen()与urlretrieve()详解

1.urlopen()方法urllib.urlopen(url[, data[, proxies]]) :创建一个表示远程url的类文件对象,然后像本地文件一样操作这个类文件对象来获取远程数据.参数u ...

- Python urllib的urlretrieve()函数解析 (显示下载进度)

#!/usr/bin/python #encoding:utf-8 import urllib import os def Schedule(a,b,c): ''''' a:已经下载的数据块 b:数据 ...

- Python:urllib模块的urlretrieve方法

转于:https://blog.csdn.net/fengzhizi76506/article/details/59229846 博主:fengzhizi76506 1)功能: urllib模块提供的 ...

- Python爬虫之urllib模块1

Python爬虫之urllib模块1 本文来自网友投稿.作者PG,一个待毕业待就业二流大学生.玄魂工作室未对该文章内容做任何改变. 因为本人一直对推理悬疑比较感兴趣,所以这次爬取的网站也是平时看一些悬 ...

- Python urllib urlretrieve函数解析

Python urllib urlretrieve函数解析 利用urllib.request.urlretrieve函数下载文件 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考文献 Ur ...

- Python核心模块——urllib模块

现在Python基本入门了,现在开始要进军如何写爬虫了! 先把最基本的urllib模块弄懂吧. urllib模块中的方法 1.urllib.urlopen(url[,data[,proxies]]) ...

- python爬虫-urllib模块

urllib 模块是一个高级的 web 交流库,其核心功能就是模仿web浏览器等客户端,去请求相应的资源,并返回一个类文件对象.urllib 支持各种 web 协议,例如:HTTP.FTP.Gophe ...

- [转]Python核心模块——urllib模块

现在Python基本入门了,现在开始要进军如何写爬虫了! 先把最基本的urllib模块弄懂吧. urllib模块中的方法 1.urllib.urlopen(url[,data[,proxies]]) ...

随机推荐

- 阿里巴巴Java开发手册建议创建HashMap时设置初始化容量,但是多少合适呢?

集合是Java开发日常开发中经常会使用到的,而作为一种典型的K-V结构的数据结构,HashMap对于Java开发者一定不陌生. 关于HashMap,很多人都对他有一些基本的了解,比如他和hashtab ...

- Linux 工作机初始化操作

# apt 依赖包安装 sudo apt install build-essential zlib1g-dev libncurses5-dev libgdbm-dev libnss3-dev libs ...

- One Stage目标检测

在计算机视觉中,目标检测是一个难题.在大型项目中,首先需要先进行目标检测,得到对应类别和坐标后,才进行之后的各种分析.如人脸识别,通常是首先人脸检测,得到人脸的目标框,再对此目标框进行人脸识别.如果该 ...

- SpringBoot图文教程5—SpringBoot 中使用Aop

有天上飞的概念,就要有落地的实现 概念+代码实现是本文的特点,教程将涵盖完整的图文教程,代码案例 文章结尾配套自测面试题,学完技术自我测试更扎实 概念十遍不如代码一遍,朋友,希望你把文中所有的代码案例 ...

- 杭电-------2046骨牌铺方格(C语言写)

#include<stdio.h> ] = { }; long long recrusion(int n) { || a[n]>) { return a[n]; } ) + recr ...

- 常用传输层协议(tcp/ip+udp)与常用应用层协议简述(http)

一.计算机网络体系结构 二.TCP与UDP差异 1.TCP是面向连接的可靠传输,UDP是面向无连接的不可靠传输 面向连接表现在3次握手,4次挥手:可靠传输表现在未进行4次挥手时的差错重传,超时重传: ...

- C#代码实现-冒泡排序

冒泡排序原理:(升序)通过当前位置数和后一个位置数进行比较 如果当前数比后一个数大 则交换位置, 完成后 比较基数的位置变成下一个数.直到数组末尾,当程序运行完第一遍 最大的数已经排序到最后一个位置了 ...

- StackExchange.Redis 之 Set集合 类型示例

话不多说直接上代码: // set添加单个元素 stopwatch.Start(); "); stopwatch.Stop(); Console.WriteLine("set添加单 ...

- Happycorp:1 Vulnhub Walkthrough

靶机链接: https://www.vulnhub.com/entry/happycorp-1,296/ 网络主机扫描::: 主机端口扫描: NFS文件系统,尝试挂载试试 mount -t nfs 1 ...

- 小白的linux笔记1:CentOS 8 安装与设置

为了在服务器上跑爬虫,以及学SegNet,研究了一圈看来linux是必学品了.在自己电脑上安装了一个 1.官网下载iso,一个linux dvd是稳定版,选之,另一个stream版是更新更快的测试版, ...