论文复现丨基于ModelArts进行图像风格化绘画

摘要:这个 notebook 基于论文「Stylized Neural Painting, arXiv:2011.08114.」提供了最基本的「图片生成绘画」变换的可复现例子。

本文分享自华为云社区《基于ModelArts进行图像风格化绘画》,作者: HWCloudAI 。

ModelArts 项目地址:https://developer.huaweicloud.com/develop/aigallery/notebook/detail?id=b4e4c533-e0e7-4167-94d0-4d38b9bcfd63

下载代码和模型

import os

import moxing as mox

mox.file.copy('obs://obs-aigallery-zc/clf/code/stylized-neural-painting.zip','stylized-neural-painting.zip')

os.system('unzip stylized-neural-painting.zip')

cd stylized-neural-painting

import argparse import torch

torch.cuda.current_device()

import torch.optim as optim from painter import *

# 检测运行设备

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

# 配置

parser = argparse.ArgumentParser(description='STYLIZED NEURAL PAINTING')

args = parser.parse_args(args=[])

args.img_path = './test_images/sunflowers.jpg' # 输入图片路径

args.renderer = 'oilpaintbrush' # 渲染器(水彩、马克笔、油画笔刷、矩形) [watercolor, markerpen, oilpaintbrush, rectangle]

args.canvas_color = 'black' # 画布底色 [black, white]

args.canvas_size = 512 # 画布渲染尺寸,单位像素

args.max_m_strokes = 500 # 最大笔划数量

args.m_grid = 5 # 将图片分割为 m_grid x m_grid 的尺寸

args.beta_L1 = 1.0 # L1 loss 权重

args.with_ot_loss = False # 设为 True 以通过 optimal transportation loss 提高收敛。但会降低生成速度

args.beta_ot = 0.1 # optimal transportation loss 权重

args.net_G = 'zou-fusion-net' # 渲染器架构

args.renderer_checkpoint_dir = './checkpoints_G_oilpaintbrush' # 预训练模型路径

args.lr = 0.005 # 笔划搜寻的学习率

args.output_dir = './output' # 输出路径

Download pretrained neural renderer.

Define a helper funtion to check the drawing status.

def _drawing_step_states(pt):

acc = pt._compute_acc().item()

print('iteration step %d, G_loss: %.5f, step_psnr: %.5f, strokes: %d / %d'

% (pt.step_id, pt.G_loss.item(), acc,

(pt.anchor_id+1)*pt.m_grid*pt.m_grid,

pt.max_m_strokes))

vis2 = utils.patches2img(pt.G_final_pred_canvas, pt.m_grid).clip(min=0, max=1)

定义优化循环

def optimize_x(pt):

pt._load_checkpoint()

pt.net_G.eval()

pt.initialize_params()

pt.x_ctt.requires_grad = True

pt.x_color.requires_grad = True

pt.x_alpha.requires_grad = True

utils.set_requires_grad(pt.net_G, False)

pt.optimizer_x = optim.RMSprop([pt.x_ctt, pt.x_color, pt.x_alpha], lr=pt.lr)

print('begin to draw...')

pt.step_id = 0

for pt.anchor_id in range(0, pt.m_strokes_per_block):

pt.stroke_sampler(pt.anchor_id)

iters_per_stroke = 20

if pt.anchor_id == pt.m_strokes_per_block - 1:

iters_per_stroke = 40

for i in range(iters_per_stroke):

pt.optimizer_x.zero_grad()

pt.x_ctt.data = torch.clamp(pt.x_ctt.data, 0.1, 1 - 0.1)

pt.x_color.data = torch.clamp(pt.x_color.data, 0, 1)

pt.x_alpha.data = torch.clamp(pt.x_alpha.data, 0, 1)

if args.canvas_color == 'white':

pt.G_pred_canvas = torch.ones([args.m_grid ** 2, 3, 128, 128]).to(device)

else:

pt.G_pred_canvas = torch.zeros(args.m_grid ** 2, 3, 128, 128).to(device)

pt._forward_pass()

_drawing_step_states(pt)

pt._backward_x()

pt.optimizer_x.step()

pt.x_ctt.data = torch.clamp(pt.x_ctt.data, 0.1, 1 - 0.1)

pt.x_color.data = torch.clamp(pt.x_color.data, 0, 1)

pt.x_alpha.data = torch.clamp(pt.x_alpha.data, 0, 1)

pt.step_id += 1

v = pt.x.detach().cpu().numpy()

pt._save_stroke_params(v)

v_n = pt._normalize_strokes(pt.x)

pt.final_rendered_images = pt._render_on_grids(v_n)

pt._save_rendered_images()

处理图片,可能需要一些时间,建议使用 32 GB+ 显存

pt = Painter(args=args)

optimize_x(pt)

Check out your results at args.output_dir. Before you download that folder, let’s first have a look at what the generated painting looks like.

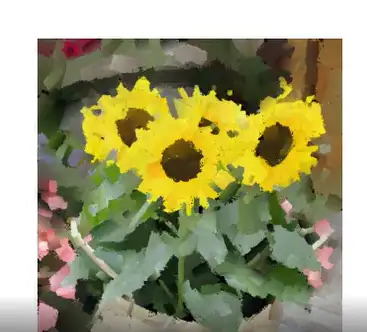

plt.subplot(1,2,1)

plt.imshow(pt.img_), plt.title('input')

plt.subplot(1,2,2)

plt.imshow(pt.final_rendered_images[-1]), plt.title('generated')

plt.show()

请下载 args.output_dir 目录到本地查看高分辨率的生成结果/

# 将渲染进度用动交互画形式展现 import matplotlib.animation as animation

from IPython.display import HTML fig = plt.figure(figsize=(4,4))

plt.axis('off')

ims = [[plt.imshow(img, animated=True)] for img in pt.final_rendered_images[::10]] ani = animation.ArtistAnimation(fig, ims, interval=50) # HTML(ani.to_jshtml())

HTML(ani.to_html5_video())

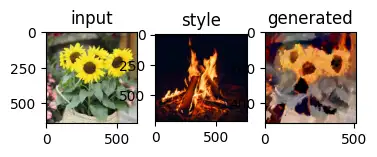

Next, let’s play style-transfer. Since we frame our stroke prediction under a parameter searching paradigm, our method naturally fits the neural style transfer framework.

接下来,让我们尝试风格迁移,由于我们是在参数搜索范式下构建的笔画预测,因此我们的方法自然的适用于神经风格迁移框架

# 配置

args.content_img_path = './test_images/sunflowers.jpg' # 输入图片的路径(原始的输入图片)

args.style_img_path = './style_images/fire.jpg' # 风格图片路径

args.vector_file = './output/sunflowers_strokes.npz' # 预生成笔划向量文件的路径

args.transfer_mode = 1 # 风格迁移模式,0:颜色迁移,1:迁移颜色和纹理

args.beta_L1 = 1.0 # L1 loss 权重

args.beta_sty = 0.5 # vgg style loss 权重

args.net_G = 'zou-fusion-net' # 渲染器架构

args.renderer_checkpoint_dir = './checkpoints_G_oilpaintbrush' # 预训练模型路径

args.lr = 0.005 # 笔划搜寻的学习率

args.output_dir = './output' # 输出路径

Again, Let’s define a helper funtion to check the style transfer status.

def _style_transfer_step_states(pt):

acc = pt._compute_acc().item()

print('running style transfer... iteration step %d, G_loss: %.5f, step_psnr: %.5f'

% (pt.step_id, pt.G_loss.item(), acc))

vis2 = utils.patches2img(pt.G_final_pred_canvas, pt.m_grid).clip(min=0, max=1)

定义优化循环

def optimize_x(pt):

pt._load_checkpoint()

pt.net_G.eval()

if args.transfer_mode == 0: # transfer color only

pt.x_ctt.requires_grad = False

pt.x_color.requires_grad = True

pt.x_alpha.requires_grad = False

else: # transfer both color and texture

pt.x_ctt.requires_grad = True

pt.x_color.requires_grad = True

pt.x_alpha.requires_grad = True

pt.optimizer_x_sty = optim.RMSprop([pt.x_ctt, pt.x_color, pt.x_alpha], lr=pt.lr)

iters_per_stroke = 100

for i in range(iters_per_stroke):

pt.optimizer_x_sty.zero_grad()

pt.x_ctt.data = torch.clamp(pt.x_ctt.data, 0.1, 1 - 0.1)

pt.x_color.data = torch.clamp(pt.x_color.data, 0, 1)

pt.x_alpha.data = torch.clamp(pt.x_alpha.data, 0, 1)

if args.canvas_color == 'white':

pt.G_pred_canvas = torch.ones([pt.m_grid*pt.m_grid, 3, 128, 128]).to(device)

else:

pt.G_pred_canvas = torch.zeros(pt.m_grid*pt.m_grid, 3, 128, 128).to(device)

pt._forward_pass()

_style_transfer_step_states(pt)

pt._backward_x_sty()

pt.optimizer_x_sty.step()

pt.x_ctt.data = torch.clamp(pt.x_ctt.data, 0.1, 1 - 0.1)

pt.x_color.data = torch.clamp(pt.x_color.data, 0, 1)

pt.x_alpha.data = torch.clamp(pt.x_alpha.data, 0, 1)

pt.step_id += 1

print('saving style transfer result...')

v_n = pt._normalize_strokes(pt.x)

pt.final_rendered_images = pt._render_on_grids(v_n)

file_dir = os.path.join(

args.output_dir, args.content_img_path.split('/')[-1][:-4])

plt.imsave(file_dir + '_style_img_' +

args.style_img_path.split('/')[-1][:-4] + '.png', pt.style_img_)

plt.imsave(file_dir + '_style_transfer_' +

args.style_img_path.split('/')[-1][:-4] + '.png', pt.final_rendered_images[-1])

运行风格迁移

pt = NeuralStyleTransfer(args=args)

optimize_x(pt)

高分辨率生成文件保存在 args.output_dir。

让我们预览一下输出结果:

plt.subplot(1,3,1)

plt.imshow(pt.img_), plt.title('input')

plt.subplot(1,3,2)

plt.imshow(pt.style_img_), plt.title('style')

plt.subplot(1,3,3)

plt.imshow(pt.final_rendered_images[-1]), plt.title('generated')

plt.show()

论文复现丨基于ModelArts进行图像风格化绘画的更多相关文章

- 实践案例丨基于ModelArts AI市场算法MobileNet_v2实现花卉分类

概述 MobileNetsV2是基于一个流线型的架构,它使用深度可分离的卷积来构建轻量级的深层神经网,此模型基于 MobileNetV2: Inverted Residuals and Linear ...

- 论文解读丨基于局部特征保留的图卷积神经网络架构(LPD-GCN)

摘要:本文提出一种基于局部特征保留的图卷积网络架构,与最新的对比算法相比,该方法在多个数据集上的图分类性能得到大幅度提升,泛化性能也得到了改善. 本文分享自华为云社区<论文解读:基于局部特征保留 ...

- Python图像处理丨基于OpenCV和像素处理的图像灰度化处理

摘要:本篇文章讲解图像灰度化处理的知识,结合OpenCV调用cv2.cvtColor()函数实现图像灰度操作,使用像素处理方法对图像进行灰度化处理. 本文分享自华为云社区<[Python图像处理 ...

- Visualizing and Understanding Convolutional Networks论文复现笔记

目录 Visualizing and Understanding Convolutional Networks 论文复现笔记 Abstract Introduction Approach Visual ...

- FCOS论文复现:通用物体检测算法

摘要:本案例代码是FCOS论文复现的体验案例,此模型为FCOS论文中所提出算法在ModelArts + PyTorch框架下的实现.本代码支持FCOS + ResNet-101在MS-COCO数据集上 ...

- 笔记:基于DCNN的图像语义分割综述

写在前面:一篇魏云超博士的综述论文,完整题目为<基于DCNN的图像语义分割综述>,在这里选择性摘抄和理解,以加深自己印象,同时达到对近年来图像语义分割历史学习和了解的目的,博古才能通今!感 ...

- Demo分享丨看ModelArts与HiLens是如何让车自己跑起来的

摘要:基于HiLens Kit已经基本开发完成,可部署到HiLens Kit,模型的选择为基于DarkNet53的YOLOv3模型,权重为基于COCO2014训练的数据集,而车道线的检测是基于Open ...

- 昇腾CANN论文上榜CVPR,全景图像生成算法交互性再增强!

摘要:近日,CVPR 2022放榜,基于CANN的AI论文<Interactive Image Synthesis with Panoptic Layout Generation>强势上榜 ...

- Split to Be Slim: 论文复现

摘要:在本论文中揭示了这样一种现象:一层内的许多特征图共享相似但不相同的模式. 本文分享自华为云社区<Split to Be Slim: 论文复现>,作者: 李长安 . Split to ...

- 基于clahe的图像去雾

基于clahe的图像去雾 通过阅读一些资料,我了解到clahe算法对图像去雾有所价值,正好opencv中有了实现,拿过来看一看. 但是现在实现的效果还是有所差异 #); clahe] ...

随机推荐

- 入手react的 第一坑

npm verb cli /usr/local/bin/node /usr/local/bin/npm npm info using npm@9.8.1 npm info using node@v18 ...

- 大一下c语言课程设计

// // main.c // 高级语言课程设计图书管理系统 // // Created by 蔡星旖 on 2022/8/1. // #include <iostream> #inclu ...

- Prime Distance 区间筛

给定 l, r,求出相差最小和相差最大的在l,r范围内相邻的质数 1 < l, r < 2,147,483,647, r - l < = le6 主要思路 : 埃氏筛 因为 r的最小 ...

- 【MISC】[MoeCTF 2022]cccrrc --crc32爆破

附件下载下来为压缩包,需要密码,查看该压缩包的内容 此处发现里面四个txt文件均已被加密,但是每个txt的内容都只有四个字节,符合crc32爆破条件,直接上脚本: import binascii im ...

- 邮差之死--python源代码

"""sth imported""" import time import os '''2 flags''' flag = 0 tmp = ...

- 代替gets()的新操作

1 scanf("%[^\n]", s); ^是"非" \n是换行 所以这就是一直读到\n才结束

- java读取照片Exif信息到实体类

前言 1.总共读出来了228个参数信息,但是我挑选了36个我认为比较有价值的参数,弄成了实体类 (其实是因为很多参数我看不明白是啥意思) 2.为了方便,所以实体类里我直接用中文字段了 效果图 导入依赖 ...

- SpringCore完整学习教程6,入门级别

本章从第7章开始: 7. Task Execution and Scheduling 在上下文中没有Executor bean的情况下,Spring Boot会自动配置一个ThreadPoolTask ...

- MyBatisPlus简介

MyBatisPlus特性 国内的一个网站 网站地址简介 | MyBatis-Plus (baomidou.com)

- yarn的常用命令

yarn 安装 npm install -g yarn 查看版本 yarn -v 开始一个新工程 yarn init 与 npm init 一样通过交互式会话创建一个 package.json yar ...