docker搭建kafka集群实践

前言

本文主要介绍了如何通过docker搭建一个可以用于生产环境的kafka集群。

kafka集群使用了3个节点,依赖zookeeper进行协调,所以会同时搭建一套3节点的zookeeper集群。

准备工作

本次实践准备了三台CentOS8服务器,ip地址如下:

192.168.1.34

192.168.1.36

192.168.1.73

实践目标

在每台机器上安装一个zookeeper和一个kafka组成整体的集群。

前提条件

三台机器上已经安装了docker和docker-compose。

docker的安装本文不会介绍,docker-compose的安装如下:

curl -L https://get.daocloud.io/docker/compose/releases/download/1.25.1/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

docker-compose --version

说明:不一定非要安装docker-compose,此处安装docker-compose是因为在本文的实践中使用了docker-compose,你完全可以把yml文件翻译成docker run命令,来完成整个集群的搭建工作。

开启防火墙端口

正常使用kafka集群需要开放一些端口,如果你的机器没有开启防火墙,可以忽略。

开启端口命令如下:

firewall-cmd --zone=public --add-port=2181/tcp --permanent

firewall-cmd --zone=public --add-port=2888/tcp --permanent

firewall-cmd --zone=public --add-port=3888/tcp --permanent

firewall-cmd --zone=public --add-port=9092/tcp --permanent

firewall-cmd --zone=public --add-port=9000/tcp --permanent

firewall-cmd --reload

firewall-cmd --list-all

搭建zookeeper集群

进入三台服务器,创建目录/home/zk,并创建zk.yml文件

mkdir /home/zk

cd /home/zk

touch zk.yml

zk.yml是docker-compose的编排文件,三台服务器的zk.yml文件内容分别如下:

192.168.1.34中的zk.yml

version: '3.1' services:

zk1:

image: 'zookeeper:3.7'

restart: always

hostname: zoo1

container_name: zk1

network_mode: host

ports:

- 2181:2181

- 2888:2888

- 3888:3888

environment:

ZOO_MY_ID: 1

ZOO_SERVERS: server.1=192.168.1.34:2888:3888;2181 server.2=192.168.1.36:2888:3888;2181 server.3=192.168.1.73:2888:3888;2181

192.168.1.36中的zk.yml

version: '3.1' services:

zk2:

image: 'zookeeper:3.7'

restart: always

hostname: zoo2

container_name: zk2

network_mode: host

ports:

- 2181:2181

- 2888:2888

- 3888:3888

environment:

ZOO_MY_ID: 2

ZOO_SERVERS: server.1=192.168.1.34:2888:3888;2181 server.2=192.168.1.36:2888:3888;2181 server.3=192.168.1.73:2888:3888;2181

192.168.1.73中的zk.yml

version: '3.1' services:

zk3:

image: 'zookeeper:3.7'

restart: always

hostname: zoo3

container_name: zk3

network_mode: host

ports:

- 2181:2181

- 2888:2888

- 3888:3888

environment:

ZOO_MY_ID: 3

ZOO_SERVERS: server.1=192.168.1.34:2888:3888;2181 server.2=192.168.1.36:2888:3888;2181 server.3=192.168.1.73:2888:3888;2181

分别在三台机器的/home/zk目录下执行以下命令,开启zk集群

docker-compose -f zk.yml up -d

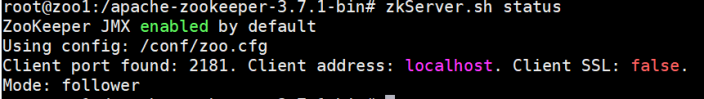

进入容器内部查看是否启动成功:

docker exec -it zk1 bash

zkServer.sh status docker exec -it zk2 bash

zkServer.sh status docker exec -it zk3 bash

zkServer.sh status

如果启动成功,可以看到如下内容:

至此,一个部署在三台服务器上的3节点zookeeper集群就搭建成功了。

搭建kafka集群

进入三台服务器,创建目录/home/kafka,并创建zk.yml文件

mkdir /home/kafka

cd /home/kafka

touch kafka.yml

kafka.yml是docker-compose的编排文件,三台服务器的kafka.yml文件内容分别如下:

192.168.1.34中的kafka.yml

version: '2' services:

k1:

image: 'bitnami/kafka:3.2.0'

restart: always

container_name: k1

network_mode: host

ports:

- 9092:9092

environment:

- KAFKA_CFG_ZOOKEEPER_CONNECT=192.168.1.34:2181,192.168.1.36:2181,192.168.1.73:2181

- ALLOW_PLAINTEXT_LISTENER=yes

- KAFKA_BROKER_ID=1

- KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.1.34:9092

- KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092

- KAFKA_CFG_NUM_PARTITIONS=3

- KAFKA_CFG_OFFSETS_TOPIC_REPLICATION_FACTOR=3

192.168.1.36中的kafka.yml

version: '2' services:

k2:

image: 'bitnami/kafka:3.2.0'

restart: always

container_name: k2

network_mode: host

ports:

- 9092:9092

environment:

- KAFKA_CFG_ZOOKEEPER_CONNECT=192.168.1.34:2181,192.168.1.36:2181,192.168.1.73:2181

- ALLOW_PLAINTEXT_LISTENER=yes

- KAFKA_BROKER_ID=2

- KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.1.36:9092

- KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092

- KAFKA_CFG_NUM_PARTITIONS=3

- KAFKA_CFG_OFFSETS_TOPIC_REPLICATION_FACTOR=3

192.168.1.73中的kafka.yml

version: '2' services:

k3:

image: 'bitnami/kafka:3.2.0'

restart: always

container_name: k3

network_mode: host

ports:

- 9092:9092

environment:

- KAFKA_CFG_ZOOKEEPER_CONNECT=192.168.1.34:2181,192.168.1.36:2181,192.168.1.73:2181

- ALLOW_PLAINTEXT_LISTENER=yes

- KAFKA_BROKER_ID=3

- KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.1.73:9092

- KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092

- KAFKA_CFG_NUM_PARTITIONS=3

- KAFKA_CFG_OFFSETS_TOPIC_REPLICATION_FACTOR=3

分别在三台机器的/home/kafka目录下执行以下命令,开启kafka集群

docker-compose -f kafka.yml up -d

创建topic并验证消费者和生产者

进入192.168.1.34的kafka容器内部

docker exec -it k1 bash

cd /opt/bitnami/kafka/bin

./kafka-topics.sh --create --bootstrap-server 192.168.1.34:9092 --replication-factor 1 --partitions 3 --topic chattest

进入其他机器的kafka容器内部,查看是否存在刚创建的topic,如果存在则说明Kafka集群搭建成功。

docker exec -it k2 bash

kafka-topics.sh --list --bootstrap-server 192.168.1.36:9092

docker exec -it k3 bash

kafka-topics.sh --list --bootstrap-server 192.168.1.73:9092

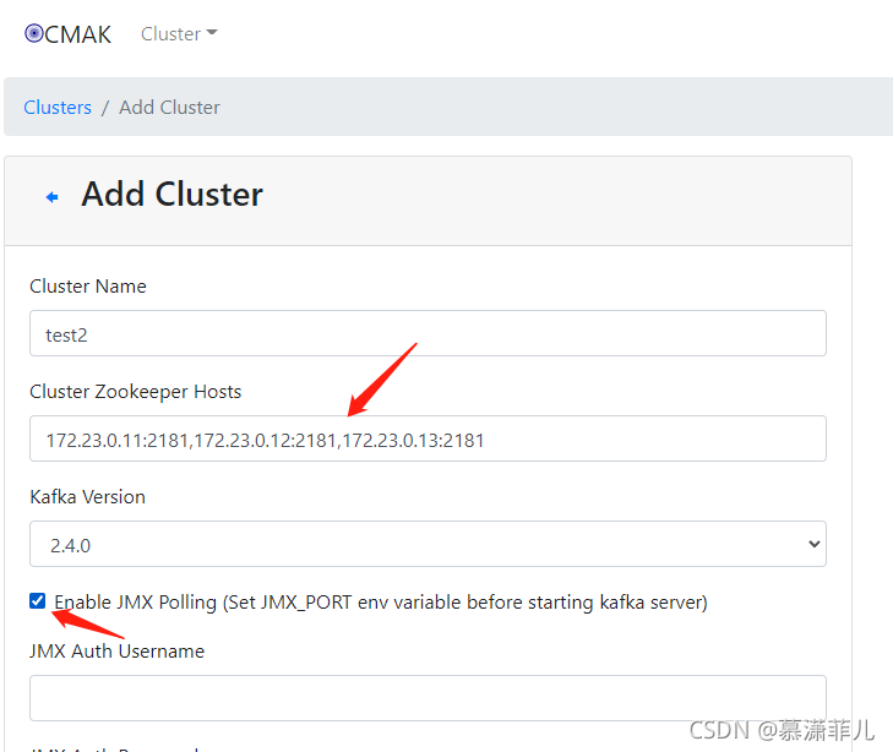

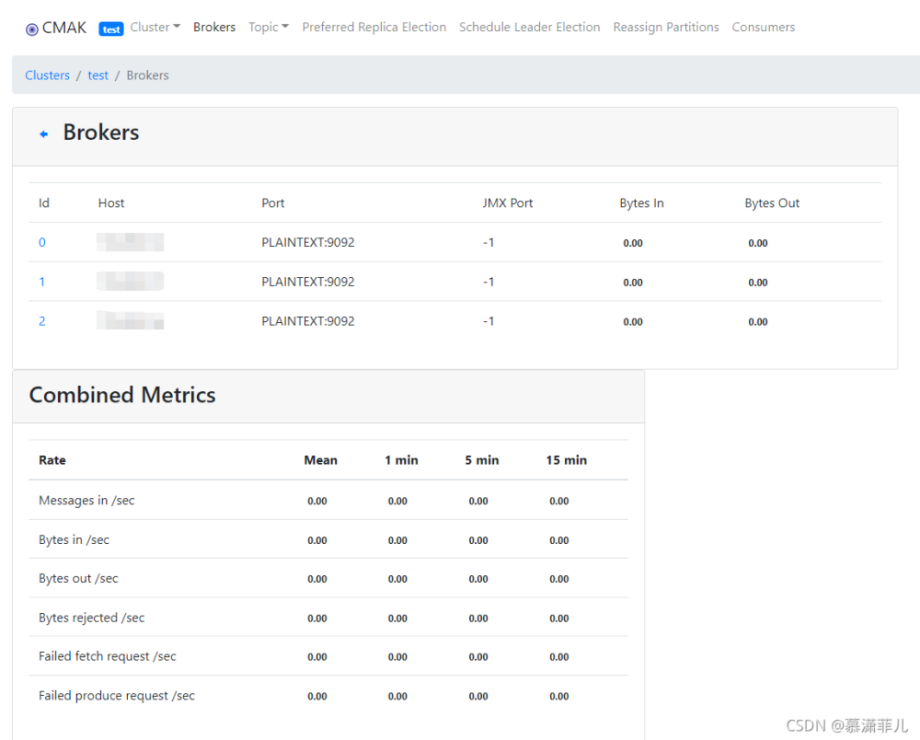

搭建kafka-manager

kafka-manager是一个kafka集群的可视化监控工具,在一台机器上安装即可,我们选择在192.168.1.36这台服务器上安装

进入目录/home/kafka,并创建manager.yml文件

cd /home/kafka

touch manager.yml

manager.yml是docker-compose的编排文件,内容如下:

version: '3.0' services:

kafka-manager:

image: hlebalbau/kafka-manager

restart: always

container_name: kafka-manager

hostname: kafka-manager

network_mode: host

ports:

- 9000:9000

environment:

ZK_HOSTS: 192.168.1.34:2181,192.168.1.36:2181,192.168.1.73:2181

KAFKA_BROKERS: 192.168.1.34:9092,192.168.1.36:9092,192.168.1.73:9092

APPLICATION_SECRET: letmein

KAFKA_MANAGER_AUTH_ENABLED: "true" # 开启验证

KAFKA_MANAGER_USERNAME: "admin" # 用户名

KAFKA_MANAGER_PASSWORD: "admin" # 密码

KM_ARGS: -Djava.net.preferIPv4Stack=true

在/home/kafka目录下执行以下命令,开启监控工具

docker-compose -f manager.yml up -d

浏览器访问192.168.1.36:9000,输入用户名密码即可进入监控页面。

按照下图操作增加对kafka集群的监控。

大功告成了!

docker搭建kafka集群实践的更多相关文章

- docker搭建kafka集群(高级版)

1. 环境docker, docker-compose 2.zookeeper集群 /data/zookeeper/zoo1/config/zoo.cfg # The number of millis ...

- docker 搭建kafka集群(入门版)

1.环境 docker, docker-compose 2.zk-kafka.yml version: '3' services: zoo1: image: zookeeper:3.4.14 rest ...

- docker 搭建zookeeper集群和kafka集群

docker 搭建zookeeper集群 安装docker-compose容器编排工具 Compose介绍 Docker Compose 是 Docker 官方编排(Orchestration)项目之 ...

- 使用Docker搭建Spark集群(用于实现网站流量实时分析模块)

上一篇使用Docker搭建了Hadoop的完全分布式:使用Docker搭建Hadoop集群(伪分布式与完全分布式),本次记录搭建spark集群,使用两者同时来实现之前一直未完成的项目:网站日志流量分析 ...

- docker部署kafka集群

利用docker可以很方便的在一台机子上搭建kafka集群并进行测试.为了简化配置流程,采用docker-compose进行进行搭建. kafka搭建过程如下: 编写docker-compose.ym ...

- docker-compose 搭建kafka集群

docker-compose搭建kafka集群 下载镜像 1.wurstmeister/zookeeper 2.wurstmeister/kafka 3.sheepkiller/kafka-manag ...

- 大数据平台搭建-kafka集群的搭建

本系列文章主要阐述大数据计算平台相关框架的搭建,包括如下内容: 基础环境安装 zookeeper集群的搭建 kafka集群的搭建 hadoop/hbase集群的搭建 spark集群的搭建 flink集 ...

- Docker 搭建 etcd 集群

阅读目录: 主机安装 集群搭建 API 操作 API 说明和 etcdctl 命令说明 etcd 是 CoreOS 团队发起的一个开源项目(Go 语言,其实很多这类项目都是 Go 语言实现的,只能说很 ...

- Docker搭建PXC集群

如何创建MySQL的PXC集群 下载PXC集群镜像文件 下载 docker pull percona/percona-xtradb-cluster 重命名 [root@hongshaorou ~]# ...

- centos7搭建kafka集群-第二篇

好了,本篇开始部署kafka集群 Zookeeper集群搭建 注:Kafka集群是把状态保存在Zookeeper中的,首先要搭建Zookeeper集群(也可以用kafka自带的ZK,但不推荐) 1.软 ...

随机推荐

- cglib FastClass机制

前言 关于动态代理的一些知识,以及cglib与jdk动态代理的区别,在这一篇已经介绍过,不熟悉的可以先看下. 本篇我们来学习一下cglib的FastClass机制,这是cglib与jdk动态代理的一个 ...

- .NET集成DeveloperSharp实现强大的AOP

(适用于.NET/.NET Core/.NET Framework)[目录]0.前言1.第一个AOP程序2.Aspect横切面编程3.一个横切面程序拦截多个主程序4.多个横切面程序拦截一个主程序5.优 ...

- 安装VMware——Unable to install all modules.See log /tmp/vmware-han/vmware-6098.log for detalls.(Exit code 1)的解决方法(模块加载失败)

这是编译失败的原因在VM社区有这样一种解决方案,亲测有效,帮助我自己解决的麻烦,所有在这分享,希望能够帮助到小伙伴:不要被接下来的代码吓倒因为这是github上项目,所以要先在ubuntu上安装git ...

- SpringMVC深入总结--Spring中的拦截器

Spring为我们提供了: org.springframework.web.servlet.HandlerInterceptor接口, org.springframework.web.servlet. ...

- ubuntu切换root到user

目前知道: 从root用户切回user用户有三种方法: 1.su user (user是你自己安装时候的用户名) 2.直接输入exit 3.ctrl+D组合键

- MyBatisPlus常用功能总结!(附项目示例)

这篇主要是总结一下MybatisPlus一些常用的场景,目前主要有以下几点: 完整的CURD操作示例 逻辑删除功能示例 自动填充功能示例 分页插件功能示例 有关一些其它重要的功能比如 条件生成器.主键 ...

- 求给定两个排序好的数组中第k大的数

这个问题比求两个长度相等的排序数组的上中位数难度要高一点,难就难在不是求中位数了,但是我们要学会举一反三,可以尝试通过分析将求第k大的数转化为求中位数.将数组中不可能的数排除,在剩下可能的数中求中位数 ...

- Spring Boot学习日记16

了解了MVC配置原理 Spring MVC Auto-configuration // Spring Boot为Spring MVC提供了自动配置,它可以很好地与大多数应用程序一起工作. Spring ...

- 提升团队协作效率:欧奥PicHome打造无缝资料共享平台

1. 引言 在快节奏的工作环境中,团队成员需要快速访问和共享信息.有效的资料共享不仅提高工作效率,还能促进团队协作和创新.然而,许多团队仍在使用传统的文件共享方法,这些方法往往效率低下,难以满足现代工 ...

- KingbaseES kdb_database_link客户端字符集导致的乱码问题

前言 关于我们经常见到的字符集乱码问题,很可能因为数据库服务器端的操作系统字符集和客户端字符集不一致导致的. 当我们通过kdb_database_link插件访问oracle数据库出现乱码,只需要调整 ...