大数据学习之HDFS的工作机制07

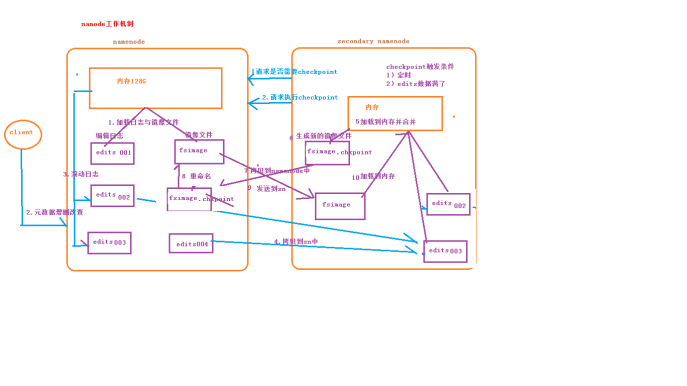

1:namenode+secondaryNameNode工作机制

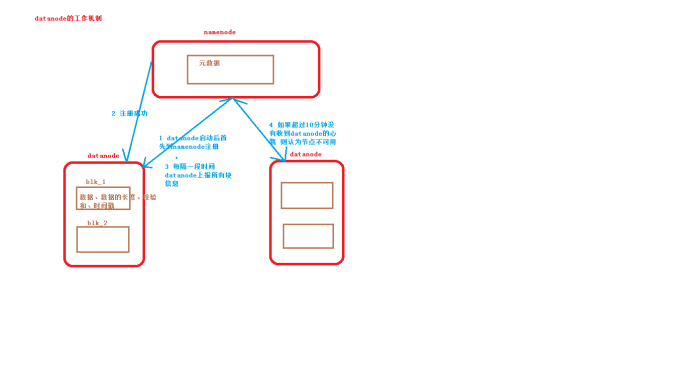

2:datanode工作机制

3:HDFS中的通信(代理对象RPC)

下面用代码来实现基本的原理

1:服务端代码

package it.dawn.HDFSPra.RPC.server; import java.io.IOException; import org.apache.hadoop.HadoopIllegalArgumentException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.ipc.RPC;

import org.apache.hadoop.ipc.RPC.Builder;

import org.apache.hadoop.ipc.RPC.Server; import it.dawn.HDFSPra.RPC.protocol.RpcProtocol; /**

* @version 1.0

* @author Dawn

* @date 2019年4月29日17:10:25

* @return 模拟了一个rpc通信。该类是服务端

*/

public class RpcServer {

public static void main(String[] args) throws HadoopIllegalArgumentException, IOException {

//1.构建rpc框架

Builder builder = new RPC.Builder(new Configuration()); //2.绑定地址

builder.setBindAddress("localhost"); //3.绑定端口号

builder.setPort(6666); //4.绑定协议

builder.setProtocol(RpcProtocol.class); //5.调用协议的实现类

builder.setInstance(new MyRpcProtocol()); //6.创建服务

Server servers= builder.build();

servers.start();

} }

2:代理对象接口

package it.dawn.HDFSPra.RPC.protocol;

public interface RpcProtocol {

//1.定义协议的id

public static final long versionID=1L;

//2.定义方法(拿到元数据的方式)

public String getMetaData(String path);

}

3:代理对象的实现

package it.dawn.HDFSPra.RPC.server;

import it.dawn.HDFSPra.RPC.protocol.RpcProtocol;

public class MyRpcProtocol implements RpcProtocol{

@Override

public String getMetaData(String path) {

return path+": 3 - {BLK_1,blk_2,BLK_3...}";

}

}

4:客服端

package it.dawn.HDFSPra.RPC.client; import java.io.IOException;

import java.net.InetSocketAddress; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.ipc.RPC; import it.dawn.HDFSPra.RPC.protocol.RpcProtocol; /**

* @version 1.0

* @author Dawn

* @date 2019年4月29日17:10:25

* @return 模拟了一个rpc通信。该类是客服端

*/

public class Client {

public static void main(String[] args) throws IOException {

//1.拿到协议

RpcProtocol protocol =RPC.getProxy(RpcProtocol.class, 1L, new InetSocketAddress("localhost", 6666), new Configuration()); //2.发送请求

String result=protocol.getMetaData("/dawnhahhaha"); //3.拿到元数据信息

System.out.println(result);

}

}

大数据学习之HDFS的工作机制07的更多相关文章

- 大数据学习day11------hbase_day01----1. zk的监控机制,2动态感知服务上下线案例 3.HDFS-HA的高可用基本的工作原理 4. HDFS-HA的配置详解 5. HBASE(简介,安装,shell客户端,java客户端)

1. ZK的监控机制 1.1 监听数据的变化 (1)监听一次 public class ChangeDataWacher { public static void main(String[] arg ...

- 大数据 --> 分布式文件系统HDFS的工作原理

分布式文件系统HDFS的工作原理 Hadoop分布式文件系统(HDFS)是一种被设计成适合运行在通用硬件上的分布式文件系统.HDFS是一个高度容错性的系统,适合部署在廉价的机器上.它能提供高吞吐量的数 ...

- 大数据学习笔记——HDFS写入过程源码分析(2)

HDFS写入过程注释解读 & 源码分析 此篇博客承接上一篇未讲完的内容,将会着重分析一下在Namenode获取到元数据后,具体是如何向datanode节点写入真实的数据的 1. 框架图展示 在 ...

- 大数据学习之HDFS基本API操作(上)06

package it.dawn.HDFSPra; import java.io.FileNotFoundException; import java.io.IOException; import ja ...

- 大数据学习之hdfs集群安装部署04

1-> 集群的准备工作 1)关闭防火墙(进行远程连接) systemctl stop firewalld systemctl -disable firewalld 2)永久修改设置主机名 vi ...

- 大数据学习笔记——HDFS写入过程源码分析(1)

HDFS写入过程方法调用逻辑 & 源码注释解读 前一篇介绍HDFS模块的博客中,我们重点从实践角度介绍了各种API如何使用以及IDEA的基本安装和配置步骤,而从这一篇开始,将会正式整理HDFS ...

- 大数据学习笔记——HDFS理论知识之编辑日志与镜像文件

HDFS文件系统——编辑日志和镜像文件详细介绍 我们知道,启动Hadoop之后,在主节点下会产生Namenode,即名称节点进程,该节点的目录下会保存一份元数据,用来记录文件的索引,而在从节点上即Da ...

- 大数据学习之HDFS基本API操作(下)06

hdfs文件流操作方法一: package it.dawn.HDFSPra; import java.io.BufferedReader; import java.io.FileInputStream ...

- 大数据学习之HDFS基本命令操作05

1)hdfs的客户端 1.网页形式->测试用 http://192.168.40.11:50070/dfshealth.html#tab-overview 2.命令行形式->测试用 3.企 ...

随机推荐

- 图解 CMS 垃圾回收机制,你值得拥有(转 强烈推荐)

首页 所有文章 资讯 Web 架构 基础技术 书籍 教程 Java小组 工具资源 - 导航条 - 首页 所有文章 资讯 Web 架构 基础技术 书籍 教程 Java小组 工具资源 ...

- js 控制选中文字

//脚本获取网页中选中文字 var word = document.selection.createRange().text; //获取选中文字所在的句子 var range = documen ...

- CF17E Palisection

题意 给定一个长度为n的小写字母串.问你有多少对相交的回文子串(包含也算相交) 相交的回文子串个数 \(mod\ 51123987\) Sol 求相交的回文子串不太好求 考虑用总数减去不相交的回文串个 ...

- 关于java赋值运算的一个小例子

直接贴代码,这个也是做题目中遇见的,觉得很好奇,查了一波,然后自己编写代码看了一下,果真如此,哈哈哈...... public class 关于Boolean的赋值运算 { public static ...

- MySQL与PHP的连接教程步骤(图文)

本篇文章我们介绍一下PHP与MySQL的整合,既然是与MySQL整合,那么我们首先肯定是要安装MySQL.下面我们就介绍下MySQL的安装方法. 第一步,下载MySQL.下载PHP可以去PHP中文网下 ...

- (C#) 多线程访问探讨,如果保证线程安全?

先抛出几点疑问: 1. 多个线程同时访问同一个“值类型变量“(value type, stored in stack), 如果保证安全访问? 2. 多个线程同时访问同一个“引用类型变量“(refere ...

- arcgis for js/flex/sl 该选哪一个?

arcgis server开发webgis 在客户端有3种选择:js.flex.sl 他们除了开发arcgis外,本身还有一些常用的领域 js:在传统网站中很常用 flex:游戏.视频播放.动画特效 ...

- 安卓app开发-04- app运行的运行和调试

app 运行的运行和调试 本篇介绍在 Android Studio 开发工具,运行调试设备:真机和虚拟机. 真机调试(USB 连接手机) 尽量使用真机进行调试,无论是调试效果和速度都比模拟器要好.使用 ...

- Raspberry install wine

sudo apt install wine winecfg出现问题 树莓派3B是卡片电脑,内存为1GB,一般运行Linux.Linux两种主流的内存分配方法2G/2G和3G/1G,树莓派系统后期优化性 ...

- java 简单工厂 工厂模式

<Head First 设计模式>学习中 分类 简单工厂模式(Simple Factory) 工厂方法模式(Factory Method) 抽象工厂模式(Abstract Factory) ...