HDFS - Shell命令

HDFS - Shell命令

最近学习比较忙,本来想做一个搭建集群笔记,今天先记录HDFS-shell命令,明天,最迟明天下午我一定会做一个搭建集群的笔记。。

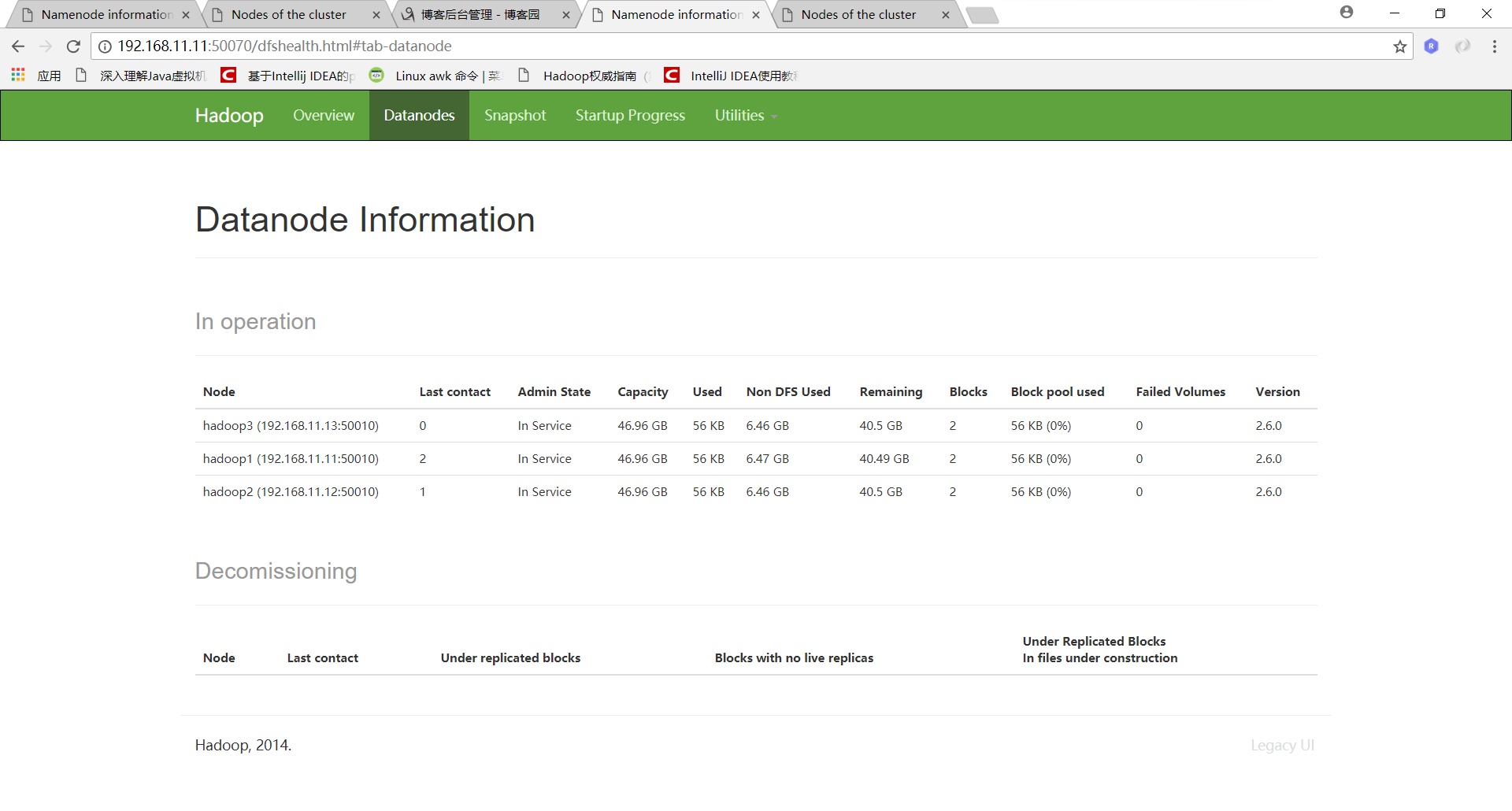

介绍一个我的集群搭建:一主三从

3个虚拟机:

1. hadoop1:主+从 namenode+datanode+resourceMarager

2.hadoop2:从+日志记录 datanode+secondarynamenode+datamanager

3.hadoop3:从 datanode+datamanager

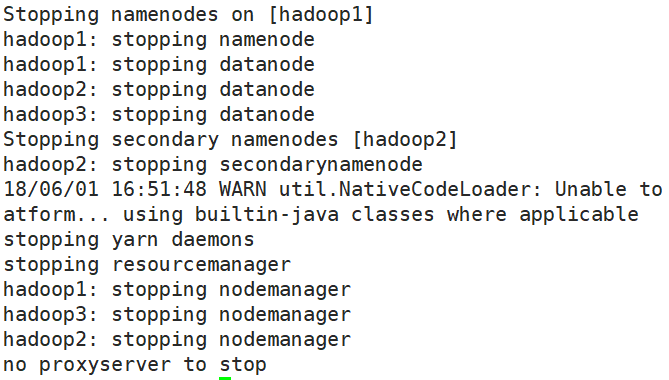

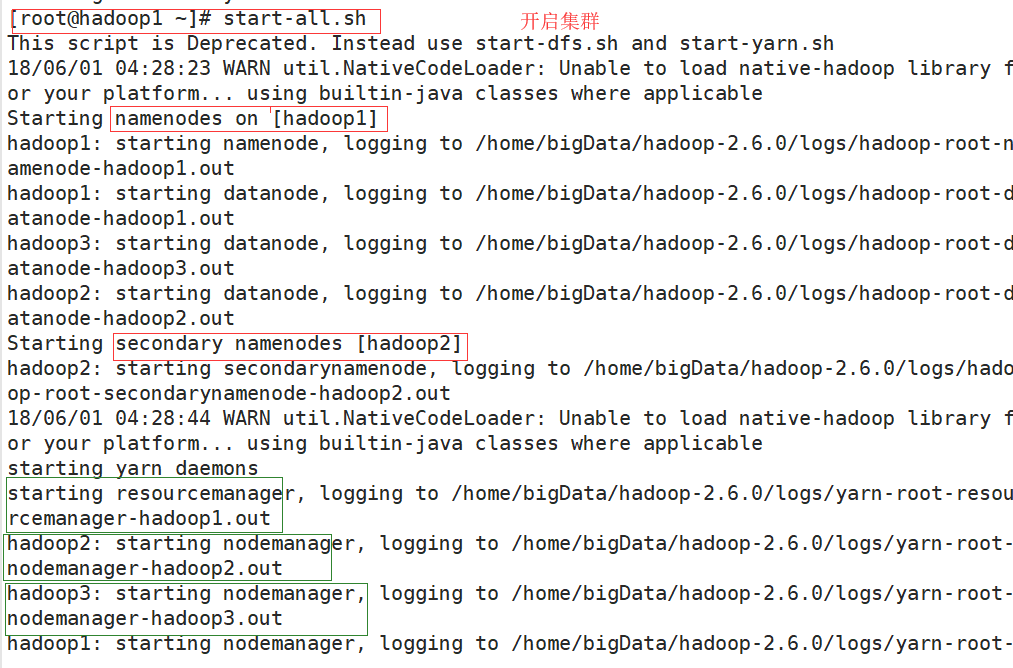

1.启动集群:

2.查看网页运行:

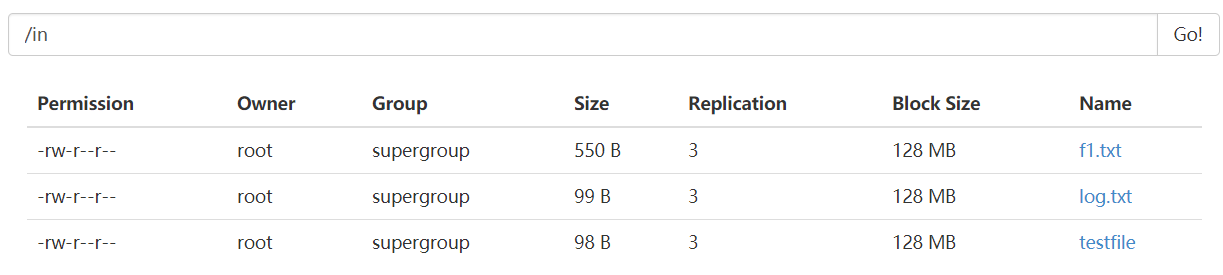

1)创建一个文件夹:

hadoop fs -mkdir /in 或者 hadoop fs -mkdir hdfs//hadoop1:8020/out

2) 上传一个文件或者多个

hadoop fs -put 3 /in 或者 hadoop fs -put * /in(大数据不能修改文件,多个文件上次递归上传)

3)删除文件

hadoop fs -rm -R /in/*(删除多个,递归删除)

4)多个文件上传

hadoop fs -put f1.txt log.txt testfiles /in或者hadoop fs- -put *.jpeg *.txt(该目录下所有以*.jpeg和.ext结尾的都上传)

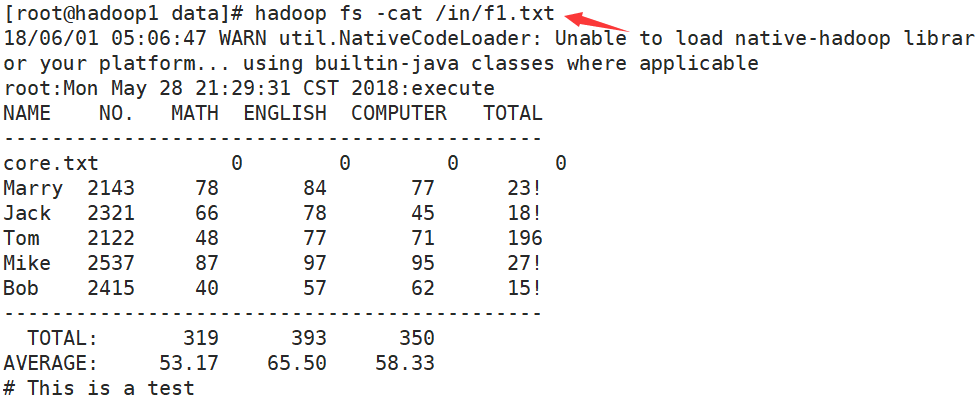

5)查看一个文本

hadoop fs -cat /in/文件名 或者hadoop fs -cat /in/文件名(文件大时,优先使用text)

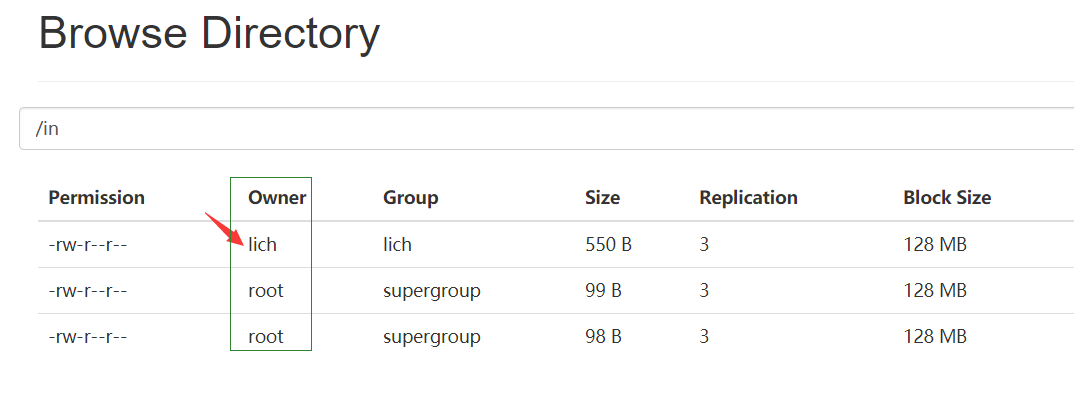

6)修改Group所属人

useradd lich --> passwd lich -->lich-->lich -->hadoop fs -chgrp lich /in/文件名

7)修改所属主Owner

hadoop fs -chown lich:lich /in/文件名

8)lich删除root所属组的文件:(阻止好人做坏事)

hadoop -rm /in/log.txt(如果dfs:permissions:true则删除失败)

9)更改属性

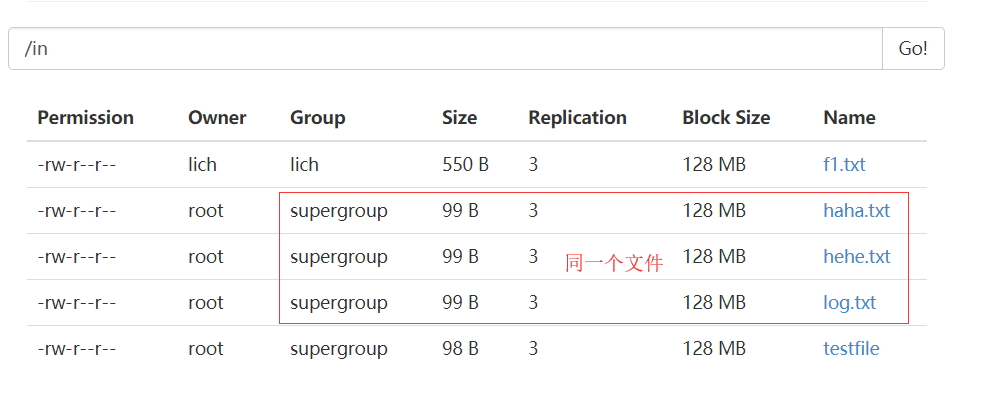

hadoop fs -put 文件名 /in/文件名(前文件名:要上传的文件的log.txt文件名,后者:如果里面已经有相同的文件名则改问后者,反之为前者)

10)上传并从命名:

hadoop fs -copyFromLocal ./log.txt /in/新的文件名

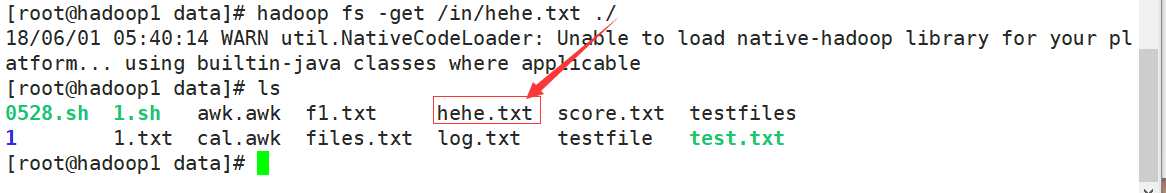

11)下载一个文件(下载到本地Linux上)

hadoop fs -get /in/hehe.txt ./或者hadoop fs -copyToLocal /in/hehe.txt ./(如果下载的名字相同则报错)

12)hadoop将目录/in下的hehe.txt复制到/out下

hadoop fs -cp /in/hehe.txt /out

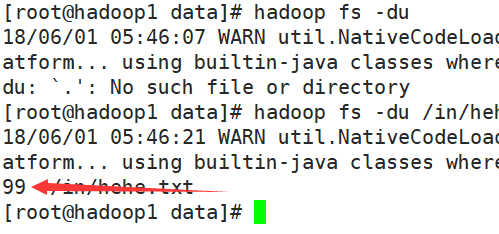

13)查看文件大小

hadoop fs -du

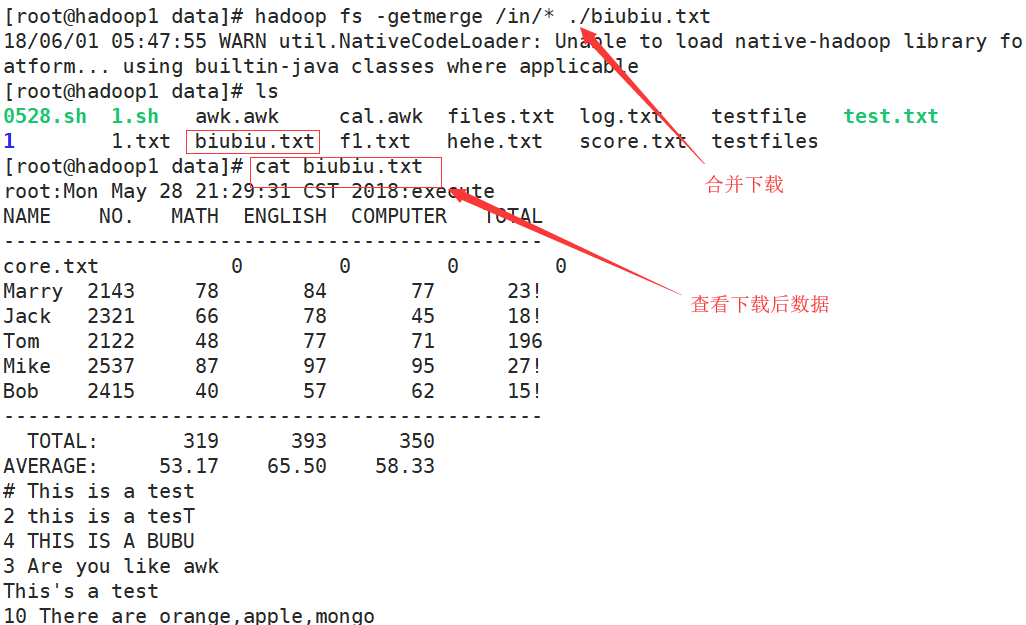

14)合并下载

hadoop fs -getmerge /in/* ./biubiu.txt

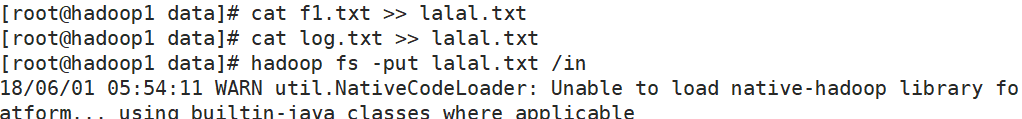

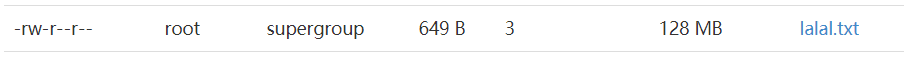

15)合并上传(hadoop不支持合并上传)

cat log.txt >> lalal.txt cat testfile >> lalal.txt cat f1.txt >>lalaltxt 合并文件

hadoop fs -put lalal.txt /in 上传

16)查看目录

hadoop fs -lsr/ 或者hadoop fs ls -R

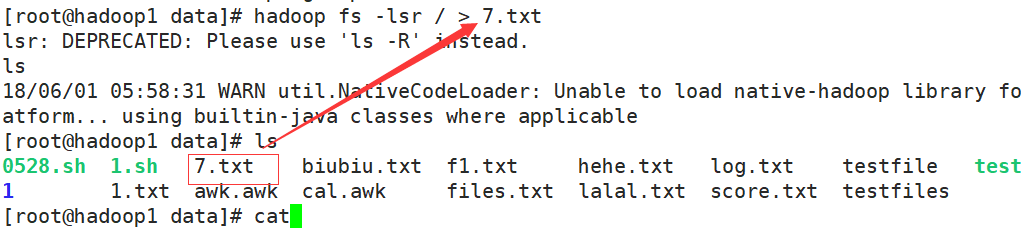

17)保存目录

hadoop fs -lsr / >7.txt(将目录保存到文件7.txt下)

18)将本地的文件移动到hadoop上

hadoop fs -moveFromLocal 文件名 /in

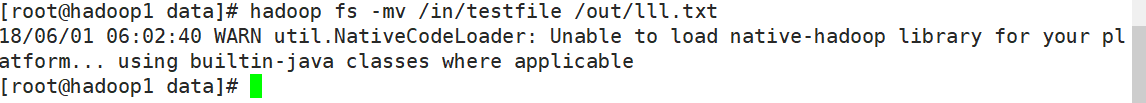

19)将Hadoop上的文件以到hadoop的其他文件下

hadoop fs -mv /in/文件名 /out/new文件名

20)递归删除文件

hadoop fs -rmr /in

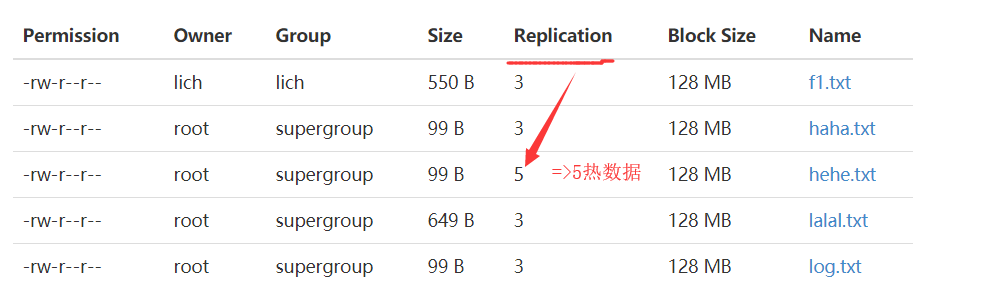

21)修改数据热度

hadoop fs -setrep 5 /in/文件名或者 hadoop fs -setrep 5 -R /in (递归in下所有文件都改为热度为5)

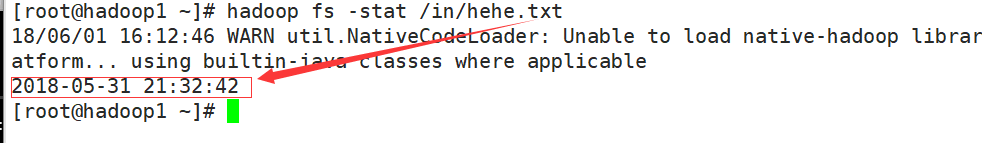

22)统计信息

hadoop fs -stat /in/hehe.txt

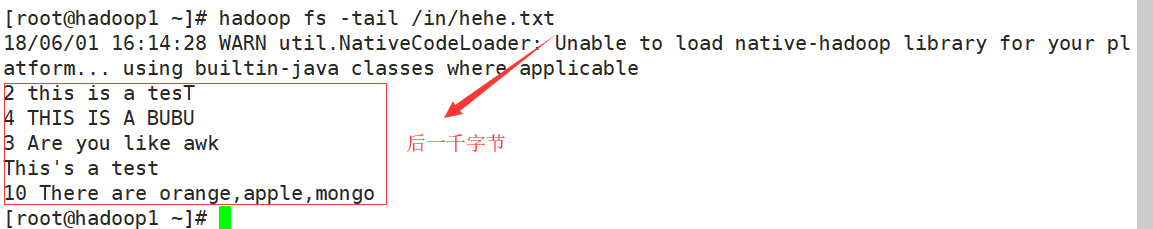

23)打开文件的尾部的1000字节

hadoop fs -tail /in/hehe.txt

24)测试文件

-e文件是否存在,是返回0

-z文件是否为空,是返回0

-d检查文件是否为目录 是返回1,反之0

hadoop fs -test -e /in/hehe.txt

25) 上传一个空的文件(用处不大)

hadoop fs -touchz /in/_SUCCESS(标识其他文件的结果)

26)删除后一天之内可以撤销(删除后的文件到了根目录下的user/root/.Trash/Current/你所删除的文件)

hadoop fs -rmr /out/*

27)将26删除的拿回来

hadoop fs -cp /user/root/.Transg/Cuttent/你要的文件

28)清空回收站

hadoop fs -expunge

注意:删除时要超过配置文件中的一天后才能删除,不能立即删除

huhu_k:所有的成功都不是一朝一夕的事情。

HDFS - Shell命令的更多相关文章

- HDFS shell命令行常见操作

hadoop学习及实践笔记—— HDFS shell命令行常见操作 附:HDFS shell guide文档地址 http://hadoop.apache.org/docs/r2.5.2/hadoop ...

- hdfs shell命令及java客户端编写

一. hdfs shell命令 可以通过hadoop fs 查看所有的shell命令及其用法. 传文件到hdfs: hadoop fs -put /home/koushengrui/Downloads ...

- Hadoop学习记录(2)|HDFS shell命令|体系结构

HDFS的shell 调用文件系统(FS)shell命令使用hadoop fs的形式 所有的FS shell命令使用URI路径作为参数. URI格式是scheme://authority/path.H ...

- hadoop2.5.2学习及实践笔记(五)—— HDFS shell命令行常见操作

附:HDFS shell guide文档地址 http://hadoop.apache.org/docs/r2.5.2/hadoop-project-dist/hadoop-common/FileSy ...

- HDFS Shell命令操作与java代码操作

(一)编程实现以下功能,并利用 Hadoop 提供的 Shell 命令完成相同任务: (1) 向 HDFS 中上传任意文本文件,如果指定的文件在 HDFS 中已经存在,则由用户来指定是追加到原 ...

- hadoop 学习(三)之hdfs shell命令

1.HDFS shell 1.0查看帮助 hadoop fs -help <cmd> 1.1上传 hadoop fs -put <linux上文件> <hdfs上的路 ...

- hadoop学习笔记(五):HDFS Shell命令

一.HDFS文件命令 以下是比较重要的一些命令: [root@master01 hadoop]# hadoop fs -ls / //查看根目录下的所有文件 [root@master01 hadoop ...

- hdfs shell 命令以及原理

shell 操作 dfs 上传[hadoop@namenode ~]$ /data/hadoop/bin/hadoop fs -put /opt/MegaRAID/MegaCli/MegaCli64 ...

- 【hadoop】 hdfs shell 命令交互

1.put 本地文件上传至hdfs中 2. cat 查看内容 3. 删除文件,文件夹 4. ls 5. copyFromLocal 复制本地文件到HDFS , copyToLocal hdfs 复制到 ...

随机推荐

- Android CPU耗电量测试

Android CPU耗电量测试 在测试Android app时,不仅仅要关注app的功能,也好关注app的性能指标,cpu.内存.流量.电量等.简单介绍下电量测试中的cpu耗电. 影响耗电的因素 C ...

- 【BZOJ】4542: [Hnoi2016]大数

题目链接:http://www.lydsy.com/JudgeOnline/problem.php?id=4542 给定一个由数字构成的字符串${S_{1,2,3,...,n}}$,一个正素数$P$, ...

- Java 通过get post 请求url

1️⃣.已获取小程序的access_token 为例,通过Get请求url import com.alibaba.fastjson.JSONObject; String wechatUrl = &qu ...

- python类的成员

一.实例变量:简单的来说就是给对象赋值 class Person: def __init__(self, name, card_no, height, weight, address, laopo): ...

- JSON parse error: Cannot deserialize instance of `int` out of START_OBJECT token; nested exception is com.fasterxml.jackson.databind.exc

代码程序: @PostMapping("selectById") @ResponseBody public Result selectById(@RequestBody int i ...

- R 的内部机制

在前面的章节中,我们已经学习了 R 语言的基础功能,并且了解了如何运用向量.矩阵.列表和数据框表示不同形式的数据,以及用内置函数解决简单的问题.但是仅仅了解这些功能并不能解决所有问题.现实中的数据分析 ...

- java 虹软ArcFace 2.0,java SDK使用-进行人脸检测

虹软产品地址:http://ai.arcsoft.com.cn/product/arcface.html虹软ArcFace功能简介 人脸检测人脸跟踪人脸属性检测(性别.年龄)人脸三维角度检测人脸对比 ...

- numpy函数

a=np.array([1,2,3,4,5,6]) a=a.reshape([2,-1]) # -1:表示3,此处将a数组设置为2行3列 a[1,2]=66 # 把a的6改成66 a=np ...

- 第 6 章 存储 - 039 - Data Volume 之 bind mount

Data Volume Data Volume 本质上是 Docker Host 文件系统中的目录或文件,能够直接被 mount 到容器的文件系统中. Data Volume 有以下特点: 1.Dat ...

- Mongodb 分享(一)

Mongodb使用基础知识: 一.简介 1.mongodb是什么? 1)MongoDB 是一个基于分布式文件存储的数据库.由 )mongodb 客户端:NoSQL Manager for MongoD ...