【强化学习】python 实现 saras lambda 例一

本文作者:hhh5460

本文地址:https://www.cnblogs.com/hhh5460/p/10147265.html

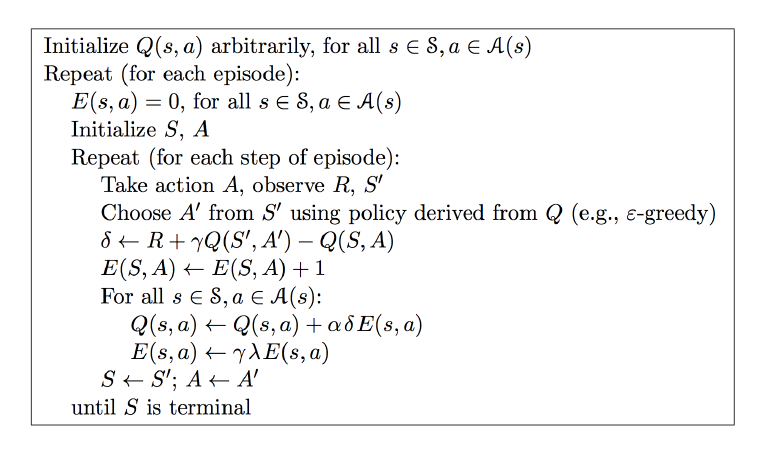

将例一用saras lambda算法重新撸了一遍,没有参照任何其他人的代码。仅仅根据伪代码,就撸出来了。感觉已真正理解了saras lambda算法。记录如下

0. saras lambda算法伪代码

图片来源:https://morvanzhou.github.io/static/results/reinforcement-learning/3-3-1.png(莫凡)

1. saras lambda算法真实代码

# e_table是q_table的拷贝

e_table = q_table.copy() # ... # saras(lambda)算法

# 参见:https://morvanzhou.github.io/static/results/reinforcement-learning/3-3-1.png

for i in range(13):

# 0. e_table清零

e_table *= 0

# 1.从状态0开始

current_state = 0

# 2.选择一个合法的动作

current_action = choose_action(current_state, epsilon)

# 3.进入循环,探索学习

while current_state != states[-1]:

# 4.取下一状态

next_state = get_next_state(current_state, current_action)

# 5.取下一奖励

next_reward = rewards[next_state]

# 6.取下一动作

next_action = choose_action(next_state, epsilon)

# 7.计算德塔

delta = next_reward + gamma * q_table.ix[next_state, next_action] - q_table.ix[current_state, current_action]

# 8.当前状态、动作对应的e_table的值加1

#e_table.ix[current_state, current_action] += 1 # 这是标准的操作,但是莫凡指出改成下面两句效果更好!

e_table.ix[current_state] *= 0

e_table.ix[current_state, current_action] = 1

# 9.遍历每一个状态的所有动作(不能仅合法动作)

for state in states:

for action in actions:

# 10.逐个更新q_talbe, e_table中对应的值

q_table.ix[state, action] += alpha * delta * e_table.ix[state, action]

e_table.ix[state, action] *= gamma * lambda_

# 11.进入下一状态、动作

current_state, current_action = next_state, next_action

第9步,刚开始我这么写:for action in get_valid_actions(state):,运行后发现没有这样写好:for action in actions:

2. 完整代码

'''

-o---T

# T 就是宝藏的位置, o 是探索者的位置

'''

# 作者: hhh5460

# 时间:20181220 '''saras(lambda)算法实现''' import pandas as pd

import random

import time epsilon = 0.9 # 贪婪度 greedy

alpha = 0.1 # 学习率

gamma = 0.8 # 奖励递减值

lambda_ = 0.9 # 衰减值 states = range(6) # 状态集。从0到5

actions = ['left', 'right'] # 动作集。也可添加动作'none',表示停留

rewards = [0,0,0,0,0,1] # 奖励集。只有最后的宝藏所在位置才有奖励1,其他皆为0 q_table = pd.DataFrame(data=[[0 for _ in actions] for _ in states],

index=states, columns=actions) e_table = q_table.copy() def update_env(state):

'''更新环境,并打印'''

env = list('-----T') # 环境 env[state] = 'o' # 更新环境

print('\r{}'.format(''.join(env)), end='')

time.sleep(0.1) def get_next_state(state, action):

'''对状态执行动作后,得到下一状态'''

global states

# l,r,n = -1,+1,0

if action == 'right' and state != states[-1]: # 除末状态(位置),向右+1

next_state = state + 1

elif action == 'left' and state != states[0]: # 除首状态(位置),向左-1

next_state = state -1

else:

next_state = state

return next_state def get_valid_actions(state):

'''取当前状态下的合法动作集合,与reward无关!'''

global actions # ['left', 'right']

valid_actions = set(actions)

if state == states[0]: # 首状态(位置),则 不能向左

valid_actions -= set(['left'])

if state == states[-1]: # 末状态(位置),则 不能向右

valid_actions -= set(['right'])

return list(valid_actions) def choose_action(state, epsilon_=0.9):

'''选择动作,根据状态'''

if random.uniform(0,1) > epsilon_: # 探索

action = random.choice(get_valid_actions(state))

else: # 利用(贪婪)

#current_action = q_table.ix[current_state].idxmax() # 这种写法是有问题的!

s = q_table.ix[state].filter(items=get_valid_actions(state))

action = random.choice(s[s==s.max()].index) # 可能多个最大值,当然,一个更好

return action # saras(lambda)算法

# 参见:https://morvanzhou.github.io/static/results/reinforcement-learning/3-3-1.png

for i in range(13):

e_table *= 0 # 清零 current_state = 0

current_action = choose_action(current_state, epsilon) update_env(current_state) # 环境相关

total_steps = 0 # 环境相关 while current_state != states[-1]:

next_state = get_next_state(current_state, current_action)

next_reward = rewards[next_state] next_action = choose_action(next_state, epsilon)

delta = next_reward + gamma * q_table.ix[next_state, next_action] - q_table.ix[current_state, current_action]

#e_table.ix[current_state, current_action] += 1 # 这是标准的操作,但是莫凡指出改成下面两句效果更好!

e_table.ix[current_state] *= 0

e_table.ix[current_state, current_action] = 1

for state in states:

for action in actions: #get_valid_actions(state):

q_table.ix[state, action] += alpha * delta * e_table.ix[state, action]

e_table.ix[state, action] *= gamma * lambda_

current_state, current_action = next_state, next_action update_env(current_state) # 环境相关

total_steps += 1 # 环境相关 print('\rEpisode {}: total_steps = {}'.format(i, total_steps), end='') # 环境相关

time.sleep(2) # 环境相关

print('\r ', end='') # 环境相关 print('\nq_table:')

print(q_table)

【强化学习】python 实现 saras lambda 例一的更多相关文章

- (待续)【转载】 DeepMind发Nature子刊:通过元强化学习重新理解多巴胺

原文地址: http://www.dataguru.cn/article-13548-1.html -------------------------------------------------- ...

- 【强化学习】用pandas 与 numpy 分别实现 q-learning, saras, saras(lambda)算法

本文作者:hhh5460 本文地址:https://www.cnblogs.com/hhh5460/p/10159331.html 特别感谢:本文的三幅图皆来自莫凡的教程 https://morvan ...

- 【强化学习】python 实现 q-learning 例一

本文作者:hhh5460 本文地址:https://www.cnblogs.com/hhh5460/p/10134018.html 问题情境 -o---T# T 就是宝藏的位置, o 是探索者的位置 ...

- 强化学习-时序差分算法(TD)和SARAS法

1. 前言 我们前面介绍了第一个Model Free的模型蒙特卡洛算法.蒙特卡罗法在估计价值时使用了完整序列的长期回报.而且蒙特卡洛法有较大的方差,模型不是很稳定.本节我们介绍时序差分法,时序差分法不 ...

- 以股票RSI指标为例,学习Python发送邮件功能(含RSI指标确定卖点策略)

本人之前写过若干“给程序员加财商”的系列文,目的是通过股票案例讲述Python知识点,让大家在学习Python的同时还能掌握相关的股票知识,所谓一举两得. 在之前的系列文里,大家能看到K线,均线,成交 ...

- python面向对象学习(七)单例

目录 1. 单例设计模式 单例设计模式的应用场景 2. __new__ 方法 3. Python 中的单例 只执行一次初始化工作 1. 单例设计模式 设计模式 设计模式 是 前人工作的总结和提炼,通常 ...

- 强化学习 平台 openAI 的 gym 安装 (Ubuntu环境下如何安装Python的gym模块)

openAI 公司给出了一个集成较多环境的强化学习平台 gym , 本篇博客主要是讲它怎么安装. openAI公司的主页: https://www.openai.com/systems/ 从主页上我 ...

- 零基础入门学习Python(21)--函数:lambda表达式

知识点 lambda 表达式 Python 允许使用lambda关键字创建匿名函数 lambda 函数怎么使用? 单个参数 >>> def add(x): return 2*x + ...

- 【转】强化学习(一)Deep Q-Network

原文地址:https://www.hhyz.me/2018/08/05/2018-08-05-RL/ 1. 前言 虽然将深度学习和增强学习结合的想法在几年前就有人尝试,但真正成功的开端就是DeepMi ...

随机推荐

- Android 动态渐变按钮

先上个图 看着特别炫酷吧 其实就是自定义颜色两秒轮播动画 AnimationDrawable animationDrawable = (AnimationDrawable) button.getBac ...

- 浅谈 Mysql 中的索引

文章归属:http://feiyan.info/16.html,我想自己去写了,但是发现此君总结的非常详细.直接搬过来了 关于MySQL索引的好处,如果正确合理设计并且使用索引的MySQL是一辆兰博基 ...

- Anaconda3 错误集合

1. An error ocurred while starting the kernel 答:个人猜测有可能是配置文件出现问题,于是采用如下解决方法: 在终端中输入spyder --reset,重置 ...

- office远程代码执行(CVE-2017-11882)

office远程代码执行(CVE-2017-11882) 影响版本: MicrosoftOffice 2000 MicrosoftOffice 2003 MicrosoftOffice 2007 Se ...

- Vlc支持IE 360 低版本的Google浏览器

VLC 插件代码: <object type='application/x-vlc-plugin' pluginspage="http://www.videolan.org/" ...

- Win10安装Redis

Redis安装 下载地址:https://github.com/MicrosoftArchive/redis/releases 下载对应的版本:这里下载Redis-x64-3.2.100 解压文件 进 ...

- Centos7下crontab+shell脚本定期自动删除文件

问题描述: 最近有个需求,就是rsync每次同步的数据量很多,但是需要保留的数据库bak文件 保留7天就够了,所以需要自动清理文件夹内的bak文件 解决方案: 利用shell脚本来定期删除文件夹内的任 ...

- 二: python基础数据类型(int,

一.什么是数据类型?2018-12-20 20:57:3õ # (3) num = 0 while num < 10: num += 1 if num == 7: num += 1 # 7执 ...

- Spring容器技术内幕之内部工作机制

引言 Spring容器就像一台构造精妙的机器,我们通过配置文件向机器传达控制信息,机器就能够按照设定的模式工作.如果将Spring容器比作一辆车,那么可以将BeanFactory看成汽车的发动机,而A ...

- lamp/lnmp下添加PHP扩展

在linux下安装好基本的PHP运行环境后有时候添加了新的功能,就得增加新的扩展,比如之前没有安装redis扩展,可以手动编译安装相关的扩展可以找下下载的php源码包中,ext目录下是否有相关的扩展源 ...