k8s全栈监控之metrics-server和prometheus

一、概述

- 使用metric-server收集数据给k8s集群内使用,如kubectl,hpa,scheduler等

- 使用prometheus-operator部署prometheus,存储监控数据

- 使用kube-state-metrics收集k8s集群内资源对象数据

- 使用node_exporter收集集群中各节点的数据

- 使用prometheus收集apiserver,scheduler,controller-manager,kubelet组件数据

- 使用alertmanager实现监控报警

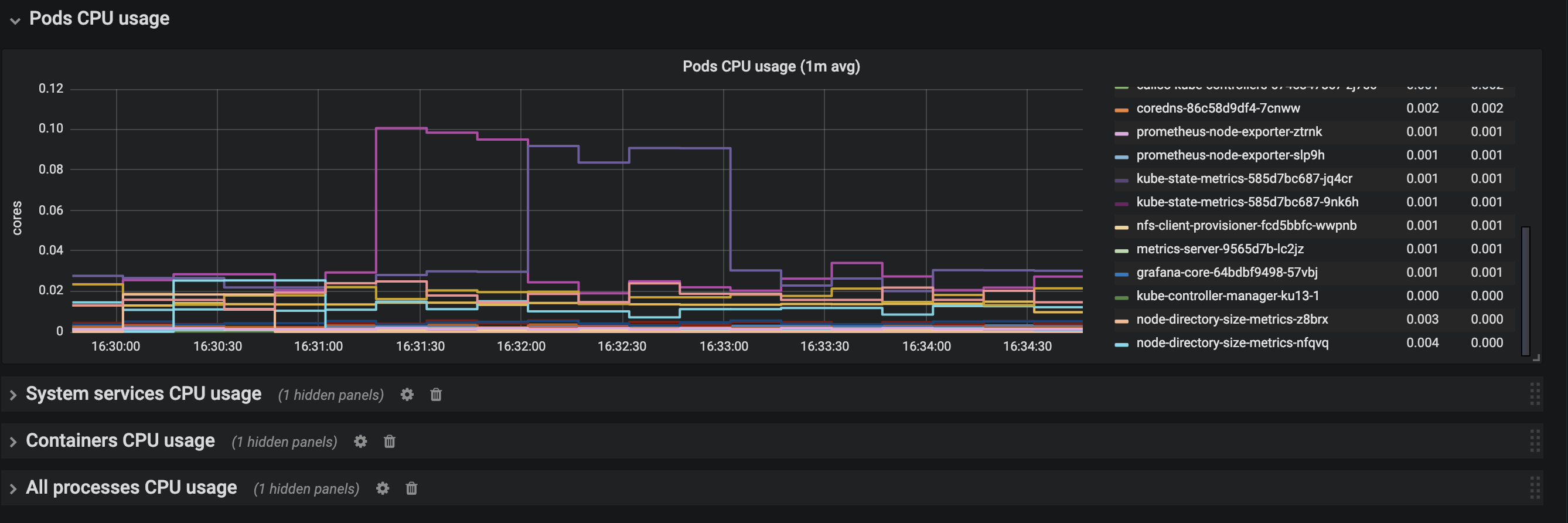

- 使用grafana实现数据可视化

1、部署metrics-server

git clone https://github.com/cuishuaigit/k8s-monitor.git cd k8s-monitor

我都是把这种服务部署在master节点上面,此时需要修改metrics-server-deployment.yaml

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: metrics-server

namespace: kube-system

---

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: metrics-server

namespace: kube-system

labels:

k8s-app: metrics-server

spec:

selector:

matchLabels:

k8s-app: metrics-server

template:

metadata:

name: metrics-server

labels:

k8s-app: metrics-server

spec:

serviceAccountName: metrics-server

tolerations:

- effect: NoSchedule

key: node.kubernetes.io/unschedulable

operator: Exists

- key: NoSchedule

operator: Exists

effect: NoSchedule

volumes:

# mount in tmp so we can safely use from-scratch images and/or read-only containers

- name: tmp-dir

emptyDir: {}

containers:

- name: metrics-server

image: k8s.gcr.io/metrics-server-amd64:v0.3.1

imagePullPolicy: Always

command:

- /metrics-server

- --kubelet-insecure-tls

- --kubelet-preferred-address-types=InternalIP,Hostname,InternalDNS,ExternalDNS,ExternalIP

volumeMounts:

- name: tmp-dir

mountPath: /tmp

nodeSelector:

metrics: "yes"

为master节点添加label

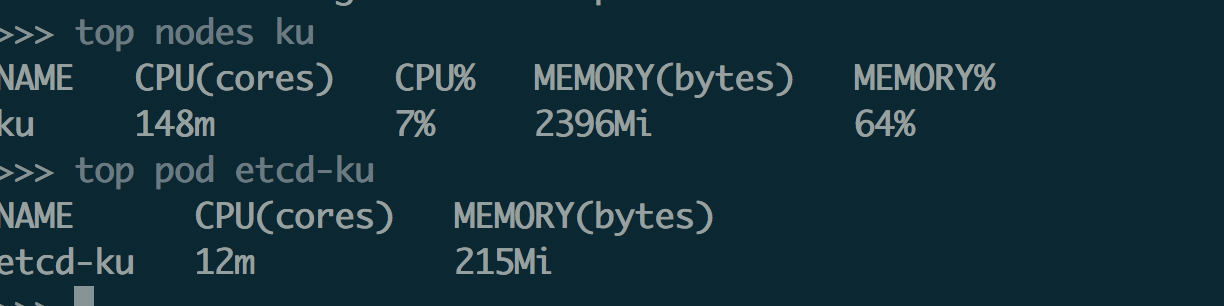

kubectl label nodes ku metrics=yes

部署

kubectl create -f metrics-server/deploy/1.8+/

验证:

it's cool

注:metrics-server默认使用node的主机名,但是coredns里面没有物理机主机名的解析,一种是部署的时候添加一个参数:

- --kubelet-preferred-address-types=InternalIP,Hostname,InternalDNS,ExternalDNS,ExternalIP

第二种是使用dnsmasq构建一个上游的dns服务,参照https://www.cnblogs.com/cuishuai/p/9856843.html。

2、部署prometheus

下载相关文件:

前面部署metrics-server已经把所有的文件pull到本地了,所以直接使用

cd k8s-monitor

1.搭建nfs服务动态提供持久化存储

1.安装nfs

sudo apt-get install -y nfs-kernel-server

sudo apt-get install -y nfs-common

sudo vi /etc/exports

/data/opv *(rw,sync,no_root_squash,no_subtree_check)

注意将*换成自己的ip段,纯内网的话也可以用*,代替任意

sudo /etc/init.d/rpcbind restart

sudo /etc/init.d/nfs-kernel-server restart

sudo systemctl enable rpcbind nfs-kernel-server

客户端挂在使用

sudo apt-get install -y nfs-common

mount -t nfs ku13-1:/data/opv /data/opv -o proto=tcp -o nolock

为了方便使用将上面的mount命令直接放到.bashrc里面

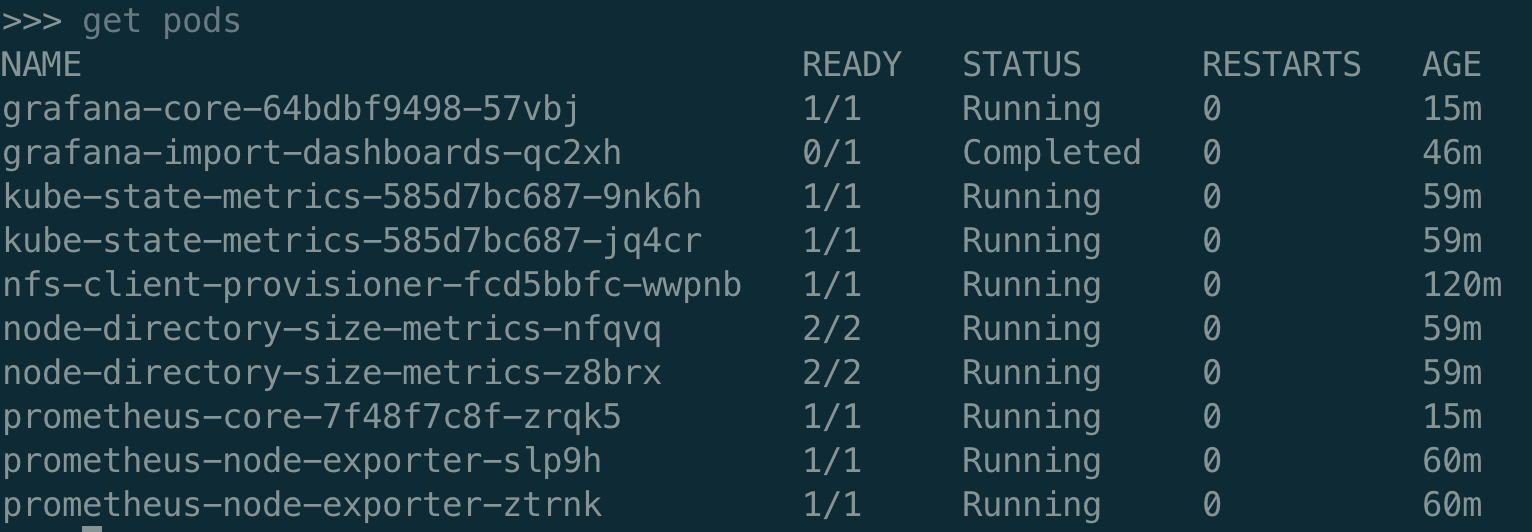

2.创建namesapce

kubectl creaet -f nfs/monitoring-namepsace.yaml

3.为nfs创建rbac

kubectl create -f nfs/rbac.yaml

4.创建deployment,将nfs的地址换成自己的

kubectl create -f nfs/nfs-deployment.yaml

5.创建storageclass

kubectl create -f nfs/storageClass.yaml

2.安装Prometheus

cd k8s-monitor/Promutheus/prometheus

1.创建权限

kubectl create -f rbac.yaml

2.创建 node-exporter

kubectl create -f prometheus-node-exporter-daemonset.yaml

kubectl create -f prometheus-node-exporter-service.yaml

3.创建 kube-state-metrics

kubectl create -f kube-state-metrics-deployment.yaml

kubectl create -f kube-state-metrics-service.yaml

4.创建 node-directory-size-metrics

kubectl create -f node-directory-size-metrics-daemonset.yaml

5.创建 prometheus

kubectl create -f prometheus-pvc.yaml

kubectl create -f prometheus-core-configmap.yaml

kubectl create -f prometheus-core-deployment.yaml

kubectl create -f prometheus-core-service.yaml

kubectl create -f prometheus-rules-configmap.yaml

6.修改core-configmap里的etcd地址

3.安装Grafana

cd k8s-monitor/Promutheus/grafana

1.安装grafana service

kubectl create -f grafana-svc.yaml

2.创建configmap

kubectl create -f grafana-configmap.yaml

3.创建pvc

kubectl create -f grafana-pvc.yaml

4.创建gragana deployment

kubectl create -f grafana-deployment.yaml

5.创建dashboard configmap

kubectl create configmap "grafana-import-dashboards" --from-file=dashboards/ --namespace=monitoring

6.创建job,导入dashboard等数据

kubectl create -f grafana-job.yaml查看部署:

prometheus和grafana都是采用的nodePort方式暴漏的服务,所以可以直接访问。

grafana默认的用户名密码:admin/admin

QA:

1、集群是使用kubeadm部署的,controller-manager和schedule都是监听的127.0.0.1,导致prometheus收集不到相关的数据?

可以在初始化之前修改其监听地址:

apiVersion: kubeadm.k8s.io/v1beta1

kind: ClusterConfiguration

controllerManager:

extraArgs:

address: 0.0.0.0

scheduler:

extraArgs:

address: 0.0.0.0

如果集群已经构建好了:

sed -e "s/- --address=127.0.0.1/- --address=0.0.0.0/" -i /etc/kubernetes/manifests/kube-controller-manager.yaml

sed -e "s/- --address=127.0.0.1/- --address=0.0.0.0/" -i /etc/kubernetes/manifests/kube-scheduler.yaml

2、metrics-server不能使用,报错不能解析node节点的主机名?

需要修改deployment文件,

- --kubelet-preferred-address-types=InternalIP,Hostname,InternalDNS,ExternalDNS,ExternalIP

3、metrics-server报错,x509,证书是非信任的?

command:

- /metrics-server

- --kubelet-insecure-tls

4、完整的配置文件

containers:

- name: metrics-server

image: k8s.gcr.io/metrics-server-amd64:v0.3.1

command:

- /metrics-server

- --metric-resolution=30s

- --kubelet-insecure-tls

- --kubelet-preferred-address-types=InternalIP,Hostname,InternalDNS,ExternalDNS,ExternalIP

k8s全栈监控之metrics-server和prometheus的更多相关文章

- 使用 Elastic 技术栈构建 K8S 全栈监控 -2: 用 Metricbeat 对 Kubernetes 集群进行监控

文章转载自:https://www.qikqiak.com/post/k8s-monitor-use-elastic-stack-2/ 操作步骤 git clone https://github.co ...

- 使用 Elastic 技术栈构建 K8S 全栈监控 -4: 使用 Elastic APM 实时监控应用性能

文章转载自:https://www.qikqiak.com/post/k8s-monitor-use-elastic-stack-4/ 操作步骤 apm-servver连接es使用上一步创建的secr ...

- 使用 Elastic 技术栈构建 K8S 全栈监控 -3: 使用 Filebeat 采集 Kubernetes 集群日志

文章转载自:https://www.qikqiak.com/post/k8s-monitor-use-elastic-stack-3/ 操作步骤 filebeat连接es使用上一步创建的secret: ...

- 使用 Elastic 技术栈构建 K8S 全栈监控 -1:搭建 ElasticSearch 集群环境

文章转载自:https://www.qikqiak.com/post/k8s-monitor-use-elastic-stack-1/ 操作步骤 kubectl create ns elastic k ...

- 使用 Elastic 技术栈构建 Kubernetes全栈监控

以下我们描述如何使用 Elastic 技术栈来为 Kubernetes 构建监控环境.可观测性的目标是为生产环境提供运维工具来检测服务不可用的情况(比如服务宕机.错误或者响应变慢等),并且保留一些可以 ...

- K8S全栈容器服务如何助力企业云化创新?

容器编排管理平台Kubernetes在实践两年多后,市场主导地位被正式确定,随着首批认证服务商的宣布,围绕着容器的应用编排部署服务已然成熟,Kubernetes开始在商业场景为企业创造价值.华为云在K ...

- kubernetes集群全栈监控报警方案kube-prometheus

参考文档 http://www.servicemesher.com/blog/prometheus-operator-manual/ https://github.com/coreos/prometh ...

- HBase 监控 | HBase Metrics 初探(一)

前言:对于任意一个系统而言,做好监控都是非常重要的,HBase也不例外.经常,我们会从JMX中获取相关指标来做展示.对HBase进行监控,那这些指标是怎么生成的呢?如果你想自定义自己的监控指标又该怎么 ...

- kubernetes之配置Metrics Server

Kubernetes 1.8 关于资源使用情况的 metrics,可以通过 Metrics API 获取到, Kubernetes 1.11 已经废弃 heapster.这里我们基于 Kubernet ...

随机推荐

- jsp相关笔记(三)

在往数据库的表中写入数据时,一定要与表中的每一项对应,比如表中有三项,则写入的值也应该是三类: String getTitle=request.getParameter("title&quo ...

- ORM常用操作

一般操作 专业官网文档 必会13条查询 <> all(): 查询所有结果 <> filter(**kwargs): 它包含了与所给筛选条件相匹配的对象 <> get ...

- python 2与python3 区别

源码区别 python3:python2 a) py3 优美简单清晰. b) py2:源码重复,混乱,不规范,冗(rong)余(不需要特多,啰嗦). test a) py3:可以中文也可以英文( ...

- Vue中出现Do not use built-in or reserved HTML elements as component id:footer等等vue warn问题

错误示图: 原因:是因为在本地项目对应文件的<script>中,属性name出现了错误的命名方式,导致浏览器控制台报错! 诸如: name: header . . name: menu ...

- JavaScript:void(0)使用介绍

1.点击链接后不做任何事情(为防止点击链接后跳转到页首,onclick事件return false即可) <a href="javascript:void(0);" > ...

- CPU寻址

CPU组成和寄存器 1)CPU由运算器.控制器.寄存器等器件组成,这些器件靠内部总线相连 2)寄存器是CPU的组成部分,用来暂存指令.数据和地址,CPU对其读写速度是最快的,不需要IO传输 存储单元 ...

- Codeforces Round #486 (Div. 3) A. Diverse Team

Codeforces Round #486 (Div. 3) A. Diverse Team 题目连接: http://codeforces.com/contest/988/problem/A Des ...

- Papers | 超分辨 + 深度学习(未完待续)

目录 1. SRCNN 1.1. Contribution 1.2. Inspiration 1.3. Network 1.3.1. Pre-processing 1.3.2. Patch extra ...

- 实战C++对象模型之成员函数调用

先说结论:C++的类成员函数和C函数实质是一样的,只是C++类成员函数多了隐藏参数this. 通过本文的演示,可以看见这背后的一切,完全可C函数方式调用C++类普通成员函数和C++类虚拟成员函数. 为 ...

- 基于UML的毕业选题系统建模研究

一.基本信息 标题:基于UML的毕业选题系统建模研究 时间:2018 出版源:电脑迷 领域分类:UML建模技术 二.研究背景 问题定义:为了加强学生设计分析开发软件的相关能力,有效避免结构化模型存在的 ...