Python网络爬虫——BeautifulSoup4库的使用

使用requests库获取html页面并将其转换成字符串之后,需要进一步解析html页面格式,提取有用信息。

BeautifulSoup4库,也被成为bs4库(后皆采用简写)用于解析和处理html和xml。

1.调用

bs4库中最主要的便是bs类了,每个实例化的对象都相当于一个html页面

需要采用from-import导入bs类,同时通过BeautifulSoup()创建一个bs对象

代码如下:

import requests

from bs4 import BeautifulSoup

r=requests.get("https://www.baidu.com/")

r.encoding="utf-8"

soup=BeautifulSoup(r.text)

print(type(soup))

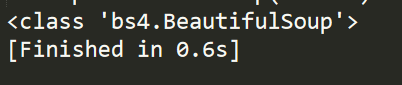

运行结果:

2.常用属性

创建的BeautifulSoup对象是一个树形结构,它包含html页面中的每一个Tag(标签)元素,可以通过<a>.<b>的形式获得

常见的属性如下:

head:

html页面<head>内容

title:

html页面标题,在<head>之中,由<title>标记

body:

html页面<body>内容

p:

html页面第一个<p>内容

strings:

html页面所有呈现在web上的字符串,即标签的内容

stripped_string:

html页面所有呈现在web上的非空字符串

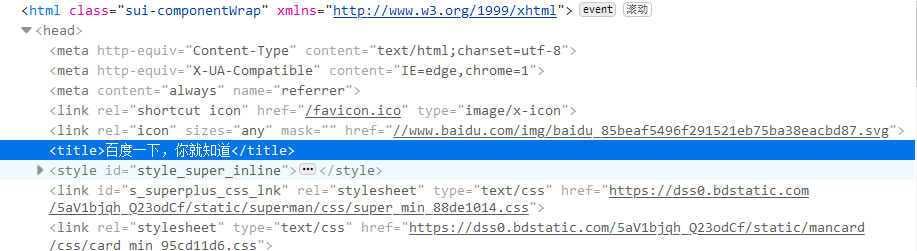

接下来尝试爬取百度的标语“百度一下,你就知道”

首先我们通过requests来建立请求,可以通过查看源代码找到对应部分

如下所示:

所以直接通过调用<title>标签即可

代码如下:

import requests

from bs4 import BeautifulSoup

r=requests.get("https://www.baidu.com/")

r.encoding="utf-8"

soup=BeautifulSoup(r.text)

title=soup.title

print(title)

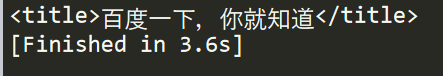

结果如图所示:

3.标签常用属性

每一个标签在bs4中也是一个对象,被称为tag对象,以糯米为例,常见结构如下:

<a class=“mnav” href="http://www.nuomi.com">糯米</a>

其中尖括号(<>)中标签的名字为 name,其他项为attrs,尖括号之间的内容为string

所以常见的标签属性分为4种

name:

字符串、标签的名字

attrs:

字典、包含了原来页面tag的所有属性,比如href

contrnts:

列表、tag下所有子tag的内容

string:

字符串、tag所包含的文本,网页中的真实文字

由于html可以在标签中嵌套其他的标签,所以string返回遵循以下原则

①如果标签内没有其他标签,string属性返回其中的内容

②如果标签内部还有标签,但只有一个标签,string返回最里面的标签内容

③如果内部超过1层嵌套标签,则返回为none

依然以百度为例,我们需要找到第一个<a>标签的string代码应当如下:

import requests

from bs4 import BeautifulSoup

r=requests.get("https://www.baidu.com/")

r.encoding="utf-8"

soup=BeautifulSoup(r.text)

print(soup.a.string)

结果如图所示:

4.调用find()与find_all()

html中,同一个特标签会有很多内容,比如百度首页<a>一共有13处,但值返回第一处

所以这时候需要通过find与find_all来寻找,这两个方法都会遍历html文档按照条件返回内容

使用方法如下:

BeautifulSoup.find_all(name,attrs,recursive,string,limit)

name:以标签名字进行搜索,名字用字符串类型表示

attrs:按照标签的属性来搜索,需要列出属性的名字和值,用json方法表示

recursive:设置查找层次,只查找当前标签的西一层时使用recursiv=false

string:按照关键字查找string属性内容,采用string=开始

limit:返回结果个数,默认全部

至于find()使用方法如find_all()相同,

BeautifulSoup.find_all(name,attrs,recursive,string)

区别在于find()只搜索第一个结果,find_all()返回所有结果。

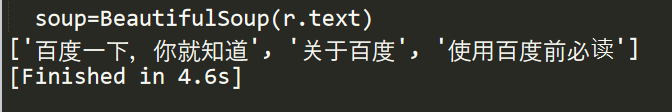

我们尝试来通过find_all()来获取所有含有“百度”这一关键词的标签

首先需要调用re库,re是python的标准库可以采用compile()对字符串的检索

所以代码如下:

import requests

import re

from bs4 import BeautifulSoup

r=requests.get("https://www.baidu.com/")

r.encoding="utf-8"

soup=BeautifulSoup(r.text)

w=soup.find_all(string=re.compile("百度"))

print(w)

结果如下:

Python网络爬虫——BeautifulSoup4库的使用的更多相关文章

- Python网络爬虫:空姐网、糗百、xxx结果图与源码

如前面所述,我们上手写了空姐网爬虫,糗百爬虫,先放一下传送门: Python网络爬虫requests.bs4爬取空姐网图片Python爬虫框架Scrapy之爬取糗事百科大量段子数据Python爬虫框架 ...

- Python网络爬虫学习总结

1.检查robots.txt 让爬虫了解爬取该网站时存在哪些限制. 最小化爬虫被封禁的可能,而且还能发现和网站结构相关的线索. 2.检查网站地图(robots.txt文件中发现的Sitemap文件) ...

- Python网络爬虫与信息提取

1.Requests库入门 Requests安装 用管理员身份打开命令提示符: pip install requests 测试:打开IDLE: >>> import requests ...

- Python网络爬虫与信息提取笔记

直接复制粘贴笔记发现有问题 文档下载地址//download.csdn.net/download/hide_on_rush/12266493 掌握定向网络数据爬取和网页解析的基本能力常用的 Pytho ...

- python 网络爬虫全流程教学,从入门到实战(requests+bs4+存储文件)

python 网络爬虫全流程教学,从入门到实战(requests+bs4+存储文件) requests是一个Python第三方库,用于向URL地址发起请求 bs4 全名 BeautifulSoup4, ...

- 关于Python网络爬虫实战笔记①

python网络爬虫项目实战笔记①如何下载韩寒的博客文章 python网络爬虫项目实战笔记①如何下载韩寒的博客文章 1. 打开韩寒博客列表页面 http://blog.sina.com.cn/s/ar ...

- python网络爬虫学习笔记

python网络爬虫学习笔记 By 钟桓 9月 4 2014 更新日期:9月 4 2014 文章文件夹 1. 介绍: 2. 从简单语句中開始: 3. 传送数据给server 4. HTTP头-描写叙述 ...

- Python网络爬虫

http://blog.csdn.net/pi9nc/article/details/9734437 一.网络爬虫的定义 网络爬虫,即Web Spider,是一个很形象的名字. 把互联网比喻成一个蜘蛛 ...

- 【python网络爬虫】之requests相关模块

python网络爬虫的学习第一步 [python网络爬虫]之0 爬虫与反扒 [python网络爬虫]之一 简单介绍 [python网络爬虫]之二 python uillib库 [python网络爬虫] ...

随机推荐

- Kruskal算法求最小生成树 笔记与思路整理

整理一下前一段时间的最小生成树的算法.(其实是刚弄明白 Kruskal其实算是一种贪心算法.先将边按权值排序,每次选一条没选过的权值最小边加入树,若加入后成环就跳过. 先贴张图做个示例. (可视化均来 ...

- MIT线性代数:7.主变量,特解,求解AX=0

- 题解 【洛谷】AT654

题解 AT654 [役人[错题已隐藏]] 此题题面没搬过来, 会日语的dalao可以自行去ATCoder查看. 给出此题的JavaAC代码: public class Main { public st ...

- CSPS模拟 93

恰饭的时候lsc说我颓颓废废是要ak的前兆 所以我rp掉光了=.= T1 思维一片混乱 T2 只会n^3 发现决策单调性,但没想全 只知道$determin(l,r)>=determin(l,r ...

- 【ObjectC—浅copy和深copy】

一.OC设计copy的目的 为了能够从源对象copy一个新的对象副本,改变新对象(副本)的时候,不会影响到原来的对象. 二.实现copy协议 OC提供了两种copy方法:copy和mutableCop ...

- Python实现自动化监控远程服务器

最近发现Python课器做很多事情,在监控服务器有其独特的优势,耗费资源少,开发周期短. 首先我们做一个定时或者实时脚本timedtask.py,让其定时监控目标服务器,两种方式: 第一种: #!/u ...

- 说一说,“NetWork Wall”所用到技术

2010年1月17日,Google在其官方网站上发布了一篇名为<A new approach to China>的博文,在博文中,Google官方透露,将停止过滤搜索结果.在国内市场上停止 ...

- Hbase简介以及简单的入门操作

Hbase是一个分布式的.面向列的开源数据库,可实时的读写.随机访问超大规模的数据集. Hbase主要分为两种模型: 逻辑模型和物理模型 1. 逻辑模型 Hbase的名字的来源是Hadoop data ...

- 你能说说Java中Comparable和Comparator的区别吗

之前面试中被问到这个问题,当时不屑(会)回答,下来特意查了查,整理如下. Java 中为我们提供了两种比较机制:Comparable 和 Comparator,二者都是用来实现对象的比较.排序. 下面 ...

- 第一篇:jdk8下载和idea导入,java源码结构

一.下载和导入 下载和导入到idea,完全参考文章:https://blog.csdn.net/zhanglong_4444/article/details/88967300 照做即可,详解简单到位. ...