Bilateral Multi-Perspective Matching for Natural Language Sentences---读书笔记

- 自然语言句子的双向、多角度匹配,是来自IBM 2017 年的一篇文章。代码github地址:https://github.com/zhiguowang/BiMPM

- 摘要

- 自然语言句子匹配(Natural language sentence matching ,NLSM)是比较两个句子并且识别它们的关系的任务。

- NLSM 一般有两种架构来解决:

- BiMPM 属于 匹配聚合框架。

- 之前的 匹配聚合框架的局限性:

- BiMPM 对以上的两个局限性进行了改进。

- 任务的定义:

- BiMPM 架构图

- word representstion layer(词表达层):

- context representation layer(上下文表达层):

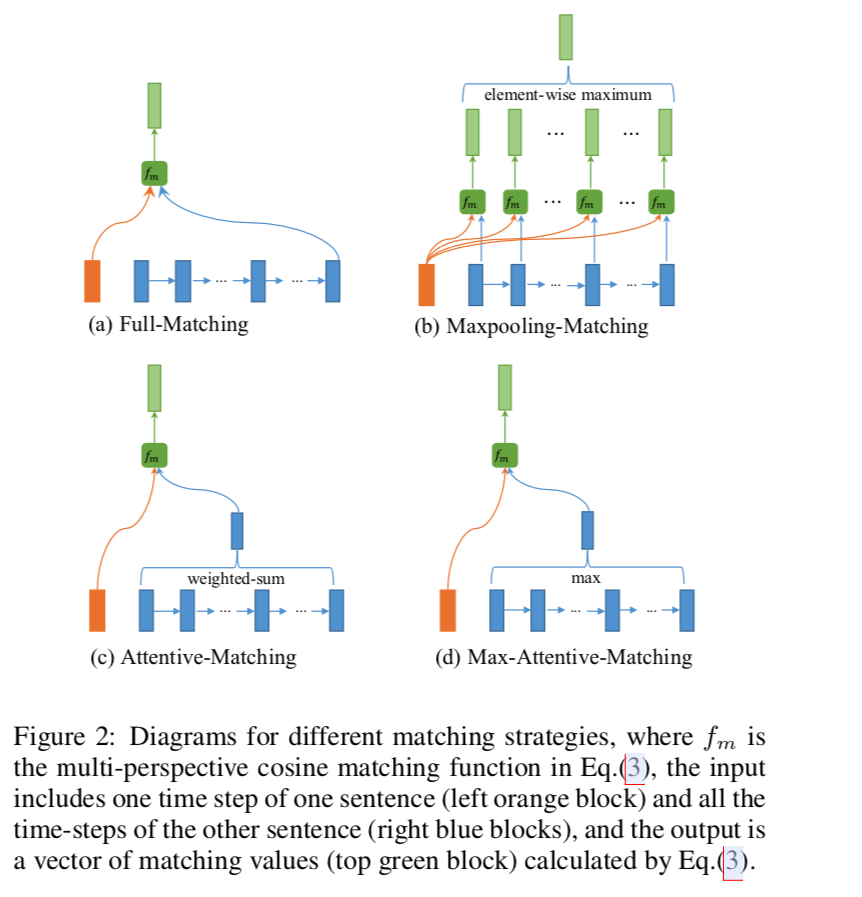

- matching layer(匹配层)

- aggregation layer(聚合层):

- prediction layer(预测层):

- Multi-perspective Matching Operation(多角度匹配操作):

- 实验参数设置:

- Quora Question Pairs(https://www.kaggle.com/quora/question-pairs-dataset)

- quora dataset 训练/验证/测试集的选取

Bilateral Multi-Perspective Matching for Natural Language Sentences---读书笔记的更多相关文章

- 《Bilateral Multi-Perspective Matching for Natural Language Sentences》(句子匹配)

问题: Natural language sentence matching (NLSM),自然语言句子匹配,是指比较两个句子并判断句子间关系,是许多任务的一项基本技术.针对NLSM任务,目前有两种流 ...

- BiMPM:Bilateral Multi-Perspctive Matching for Natural Language Sentences

导言 本论文的工作主要是在 'matching-aggregation'的sentence matching的框架下,通过增加模型的特征(实现P与Q的双向匹配和多视角匹配),来增加NLSM(Natur ...

- Convolutional Neural Network Architectures for Matching Natural Language Sentences

interaction n. 互动;一起活动;合作;互相影响 capture vt.俘获;夺取;夺得;引起(注意.想像.兴趣)n.捕获;占领;捕获物;[计算机]捕捉 hence adv. 从此;因 ...

- 《Convolutional Neural Network Architectures for Matching Natural Language Sentences》句子匹配

模型结构与原理 1. 基于CNN的句子建模 这篇论文主要针对的是句子匹配(Sentence Matching)的问题,但是基础问题仍然是句子建模.首先,文中提出了一种基于CNN的句子建模网络,如下图: ...

- 《The C Programming Language》读书笔记(一)

1. 对这本书的印象 2011年进入大学本科,C语言入门书籍如果我没记错的话应该是谭浩强的<C程序设计>,而用现在的眼光来看,这本书只能算是一本可用的教材,并不能说是一本好书.在自学操作系 ...

- 《PC Assembly Language》读书笔记

本书下载地址:pcasm-book. 前言 8086处理器只支持实模式(real mode),不能满足安全.多任务等需求. Q:为什么实模式不安全.不支持多任务?为什么虚模式能解决这些问题? A: 以 ...

- Parsing Natural Scenes and Natural Language with Recursive Neural Networks-paper

Parsing Natural Scenes and Natural Language with Recursive Neural Networks作者信息: Richard Socher richa ...

- <Natural Language Processing with Python>学习笔记一

Spoken input (top left) is analyzed, words are recognized, sentences are parsed and interpreted in c ...

- (zhuan) Speech and Natural Language Processing

Speech and Natural Language Processing obtain from this link: https://github.com/edobashira/speech-l ...

随机推荐

- canvas制图学习

<!DOCTYPE html> <html lang="zh-en"> <head> <meta charset="UTF-8& ...

- python2和python3编程差异杂谈(-)

python2 默认编码ascii 在使用中文时要显示的声明 #-*-encoding:utf-8-*- python3 默认编码utf-8,良好的支持了中文输入 python2: print函数 ...

- [2019HDU多校第四场][HDU 6617][D. Enveloping Convex]

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=6617 题目大意:给出一凸包\(P\),求最小的与\(P\)相似且对应边平行的多边形,使得题目给出的\( ...

- delegate:动态绑定js事件

$('.videomodule').delegate("span", "click", function() { var i = $(this).index() ...

- ActiveMQ C#实例

重点参考:NMS Documentation 一.ActiveMQ Queue 在ActiveMQ中Queue是一种点对点的消息分发方式,生产者在队列中添加一条消息,然后消费者消费一条消息,这条消息保 ...

- date/clock/hwclock/cal

date 显示日期与时间 date +%Y/%m/%d/%H:%M 2018/10/08/17:35 格式化输出 时间的设置 查看时区 date -R 时间戳转化 time1=$(date +%s - ...

- leetcode解题报告(10):Merge Two Sorted Lists

描述 Merge two sorted linked lists and return it as a new list. > The new list should be made by sp ...

- elasticsearch中文分词器(ik)配置

elasticsearch默认的分词:http://localhost:9200/userinfo/_analyze?analyzer=standard&pretty=true&tex ...

- Mysql 原理以及常见mysql 索引等

## 主键 超键 候选键 外键 (mysql数据库常见面试题) 数据库之互联网常用架构方案 数据库之互联网常用分库分表方案 分布式事务一致性解决方案 MySQL Explain详解 ## 数据库事务的 ...

- Java的Lambda表达式

Java的Lambda表达式 1. 什么是Lambda表达式 简单的说,Lambda表达式就是匿名方法.Lambda表达式让程序员能够使用更加简洁的代码,但是同样也使代码的可读性比较差. Lambda ...